ウェブサイト|ドキュメント|チュートリアル|遊び場|ブログ|不和

NOSは、クラウドまたはAI HWで実行される高速で柔軟なPytorch推論サーバーです。

inf2 )ランタイム。クイックスタートガイドにアクセスして開始することを強くお勧めします。 NOSクライアントをインストールするには、次のコマンドを実行できます。

conda create -n nos python=3.8 -y

conda activate nos

pip install torch-nosクライアントがインストールされたら、NOS serve CLIを介してNOSサーバーを起動できます。これにより、ローカル環境が自動的に検出され、Dockerランタイム画像をダウンロードしてNOSサーバーをスピンアップします。

nos serve up --http --logging-level INFOこれで、NOSで最初の推論リクエストを実行する準備ができました!次のコマンドのいずれかを実行して、試してみることができます。サーバーからより詳細な情報が必要な場合は、ロギングレベルをDEBUGすることができます。

NOSは、OpenAI互換のサーバーをストリーミングサポートを備えているため、お気に入りのOpenAI互換LLMクライアントを接続してNOSと通信できます。

GRPC API⚡

from nos . client import Client

client = Client ()

model = client . Module ( "TinyLlama/TinyLlama-1.1B-Chat-v1.0" )

response = model . chat ( message = "Tell me a story of 1000 words with emojis" , _stream = True )REST API

curl

-X POST http://localhost:8000/v1/chat/completions

-H " Content-Type: application/json "

-d ' {

"model": "TinyLlama/TinyLlama-1.1B-Chat-v1.0",

"messages": [{

"role": "user",

"content": "Tell me a story of 1000 words with emojis"

}],

"temperature": 0.7,

"stream": true

} 'MidJourneyの不一致ボットを数秒で構築します。

GRPC API⚡

from nos . client import Client

client = Client ()

sdxl = client . Module ( "stabilityai/stable-diffusion-xl-base-1-0" )

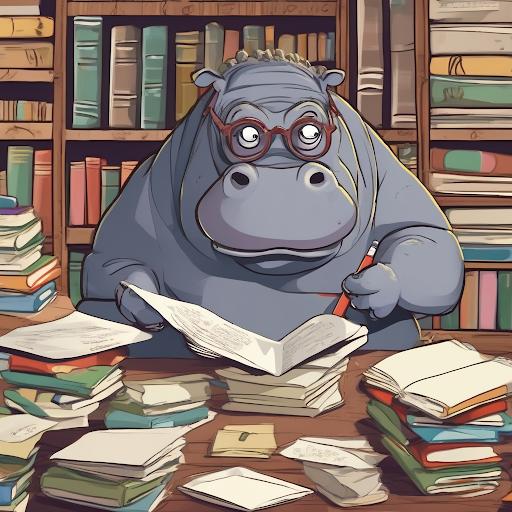

image , = sdxl ( prompts = [ "hippo with glasses in a library, cartoon styling" ],

width = 1024 , height = 1024 , num_images = 1 )REST API

curl

-X POST http://localhost:8000/v1/infer

-H ' Content-Type: application/json '

-d ' {

"model_id": "stabilityai/stable-diffusion-xl-base-1-0",

"inputs": {

"prompts": ["hippo with glasses in a library, cartoon styling"],

"width": 1024, "height": 1024,

"num_images": 1

}

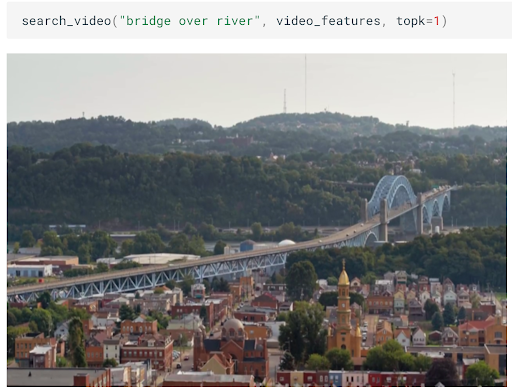

} '数分で画像/ビデオのスケーラブルなセマンティック検索を構築します。

GRPC API⚡

from nos . client import Client

client = Client ()

clip = client . Module ( "openai/clip-vit-base-patch32" )

txt_vec = clip . encode_text ( texts = [ "fox jumped over the moon" ])REST API

curl

-X POST http://localhost:8000/v1/infer

-H ' Content-Type: application/json '

-d ' {

"model_id": "openai/clip-vit-base-patch32",

"method": "encode_text",

"inputs": {

"texts": ["fox jumped over the moon"]

}

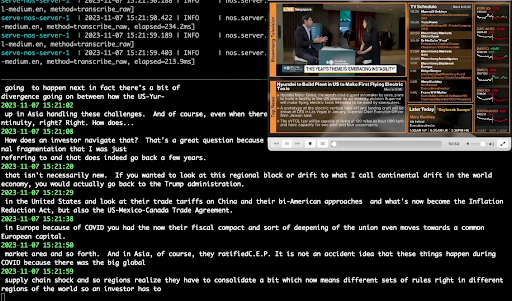

} 'ささやきを使用してリアルタイムオーディオ転写を実行します。

GRPC API⚡

from pathlib import Path

from nos . client import Client

client = Client ()

model = client . Module ( "openai/whisper-small.en" )

with client . UploadFile ( Path ( "audio.wav" )) as remote_path :

response = model ( path = remote_path )

# {"chunks": ...}REST API

curl

-X POST http://localhost:8000/v1/infer/file

-H ' accept: application/json '

-H ' Content-Type: multipart/form-data '

-F ' model_id=openai/whisper-small.en '

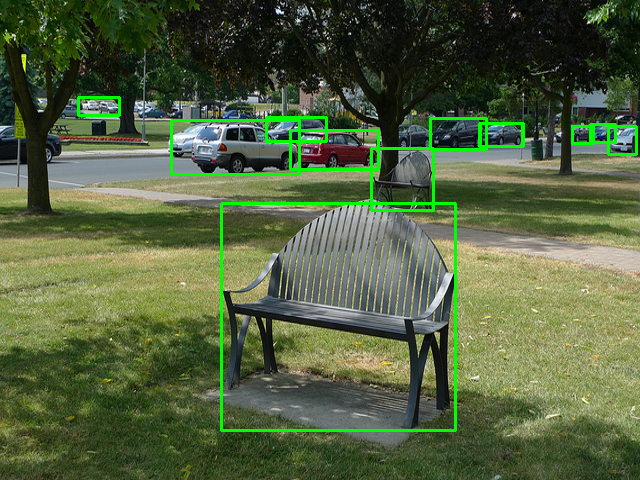

-F ' [email protected] '2行のコードでクラシックコンピュータビジョンタスクを実行します。

GRPC API⚡

from pathlib import Path

from nos . client import Client

client = Client ()

model = client . Module ( "yolox/medium" )

response = model ( images = [ Image . open ( "image.jpg" )])REST API

curl

-X POST http://localhost:8000/v1/infer/file

-H ' accept: application/json '

-H ' Content-Type: multipart/form-data '

-F ' model_id=yolox/medium '

-F ' [email protected] 'NOSでサポートされていないモデルを実行したいですか? NOSプレイグラウンドの例に従って、独自のモデルを簡単に追加できます。

このプロジェクトは、Apache-2.0ライセンスの下でライセンスされています。

NOSは、Sentryを使用して匿名の使用データを収集します。これは、コミュニティがNOSをどのように使用しているかを理解し、機能の優先順位付けに役立つために使用されます。 NOS_TELEMETRY_ENABLED=0を設定して、テレメトリをオプトアウトできます。

貢献を歓迎します!詳細については、寄稿ガイドをご覧ください。