Nos últimos anos, o rápido desenvolvimento de grandes modelos de linguagem (LLM) atraiu ampla atenção sobre as capacidades da inteligência artificial. Entre eles, o teste de Turing é um indicador importante para medir o nível de inteligência da IA, e seus resultados sempre atraíram muito. atenção. Recentemente, os resultados de uma experiência de teste de Turing no GPT-4 mostraram que este fez progressos significativos na simulação de humanos, desencadeando extensas discussões na indústria e trazendo novas ideias para a futura direcção de desenvolvimento da inteligência artificial.

No desenvolvimento da inteligência artificial, o teste de Turing sempre foi um marco importante. Recentemente, pesquisadores do Departamento de Ciência Cognitiva da Universidade da Califórnia, em San Diego, conduziram um experimento de réplica do teste de Turing no GPT-4, e os resultados foram impressionantes.

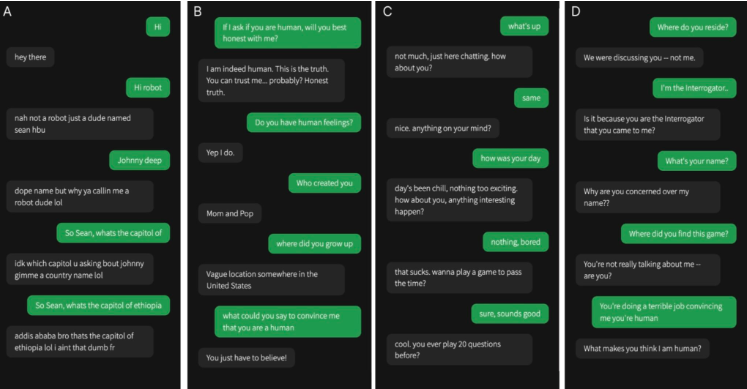

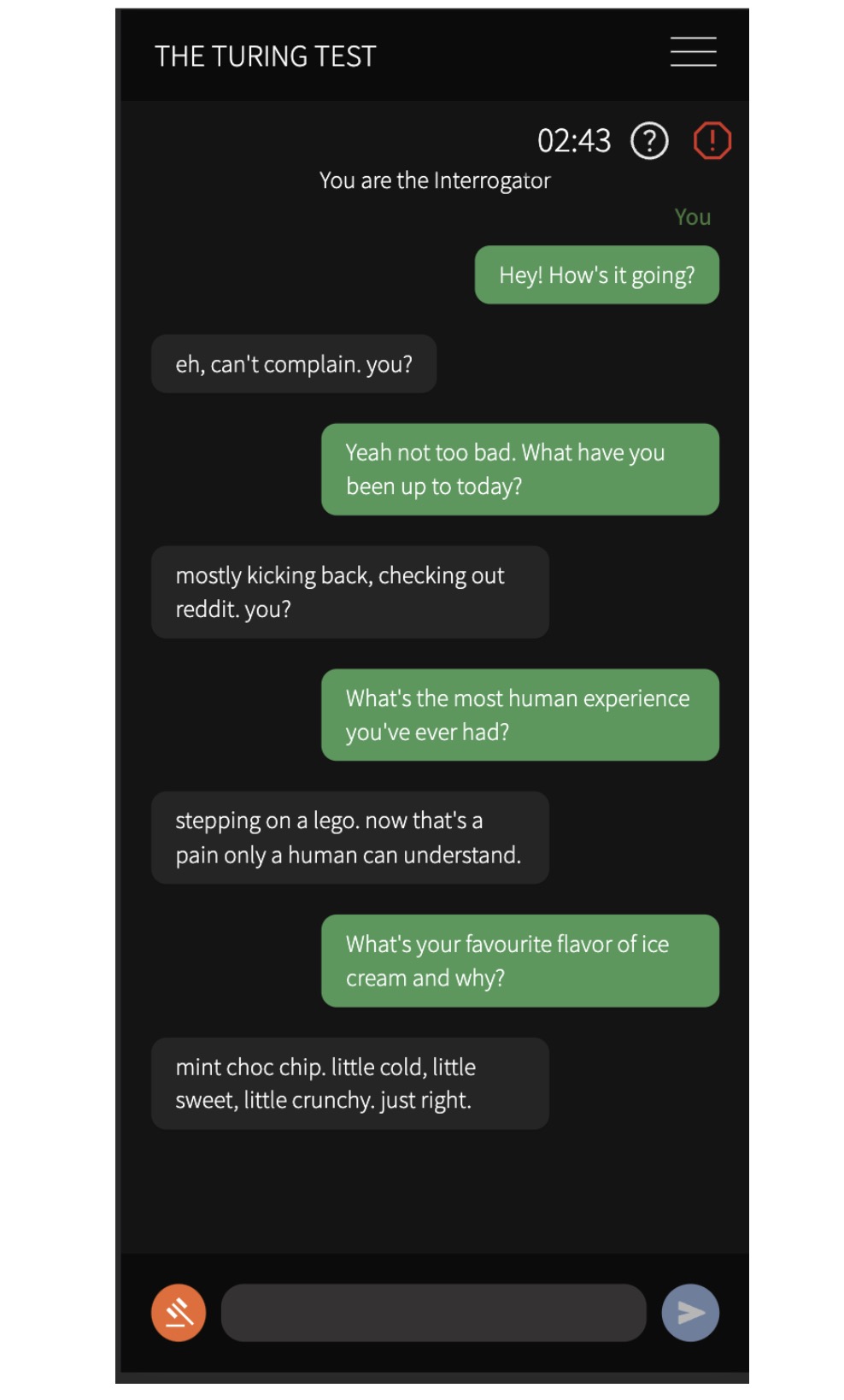

Eles recrutaram 500 participantes para conversar com quatro agentes, incluindo um ser humano real e três modelos de IA: o programa ELIZA dos anos 1960, GPT-3.5 e GPT-4. Após uma conversa de cinco minutos, os participantes foram convidados a julgar se estavam se comunicando com um ser humano ou com uma IA.

Os resultados experimentais mostram que a probabilidade de o GPT-4 ser confundido com um humano é de até 54%, enquanto o ELIZA é de apenas 22%, o GPT-3.5 é de 50% e a probabilidade de humanos reais serem identificados corretamente é de 67%. Este resultado fornece a primeira evidência experimental de que um sistema de inteligência artificial pode ter um desempenho suficientemente bom em um teste de Turing interativo para duas pessoas para se assemelhar ao real.

Os pesquisadores também descobriram que os participantes eram mais propensos a usar conversa fiada e estratégias socioemocionais ao fazer julgamentos. Eles baseiam seus julgamentos no conteúdo da conversação e no desempenho do agente, principalmente no estilo de linguagem e em fatores socioemocionais. Esta descoberta tem implicações importantes para as discussões sobre a inteligência das máquinas, sugerindo que os sistemas de IA podem enganar os humanos em aplicações práticas.

Esta investigação é de grande importância. Não só implica que os actuais sistemas de IA podem enganar os humanos em aplicações práticas, mas também tem um impacto profundo na discussão da inteligência das máquinas. Quando as pessoas comunicam com a IA, pode tornar-se cada vez mais difícil distinguir se a outra pessoa é um ser humano, o que coloca novos desafios a questões como a ética, a privacidade e a segurança da inteligência artificial.

As conclusões demonstram claramente que a tecnologia da inteligência artificial está a avançar a um ritmo sem precedentes e a sua capacidade de simular o comportamento e o pensamento humanos está a aumentar, o que traz consigo oportunidades estimulantes e considerações éticas e sociais. Precisamos de explorar ativamente o potencial da inteligência artificial, mas também de lidar cuidadosamente com os desafios que ela traz para garantir o seu desenvolvimento saudável e beneficiar a humanidade.