Ces dernières années, le développement rapide des grands modèles de langage (LLM) a attiré une large attention sur les capacités de l'intelligence artificielle. Parmi eux, le test de Turing est un indicateur important pour mesurer le niveau d'intelligence de l'IA, et ses résultats ont toujours beaucoup attiré. attention. Récemment, les résultats d'un test de Turing sur GPT-4 ont montré que celui-ci avait fait des progrès significatifs dans la simulation des humains, déclenchant de vastes discussions dans l'industrie et apportant une nouvelle réflexion sur l'orientation future du développement de l'intelligence artificielle.

Dans le développement de l’intelligence artificielle, le test de Turing a toujours constitué une étape importante. Récemment, des chercheurs du Département des sciences cognitives de l’Université de Californie à San Diego ont mené une expérience de réplique du test de Turing sur GPT-4, et les résultats ont été impressionnants.

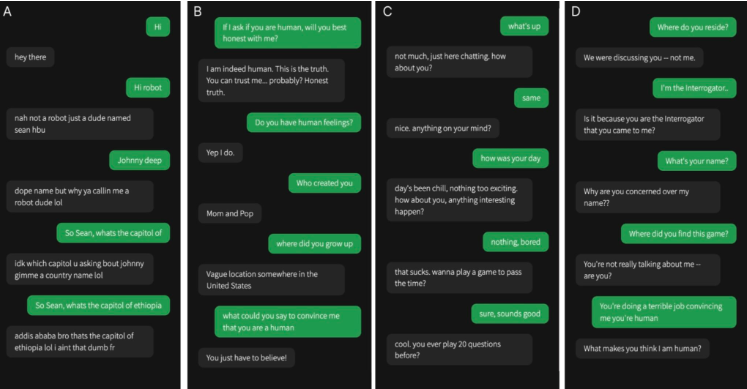

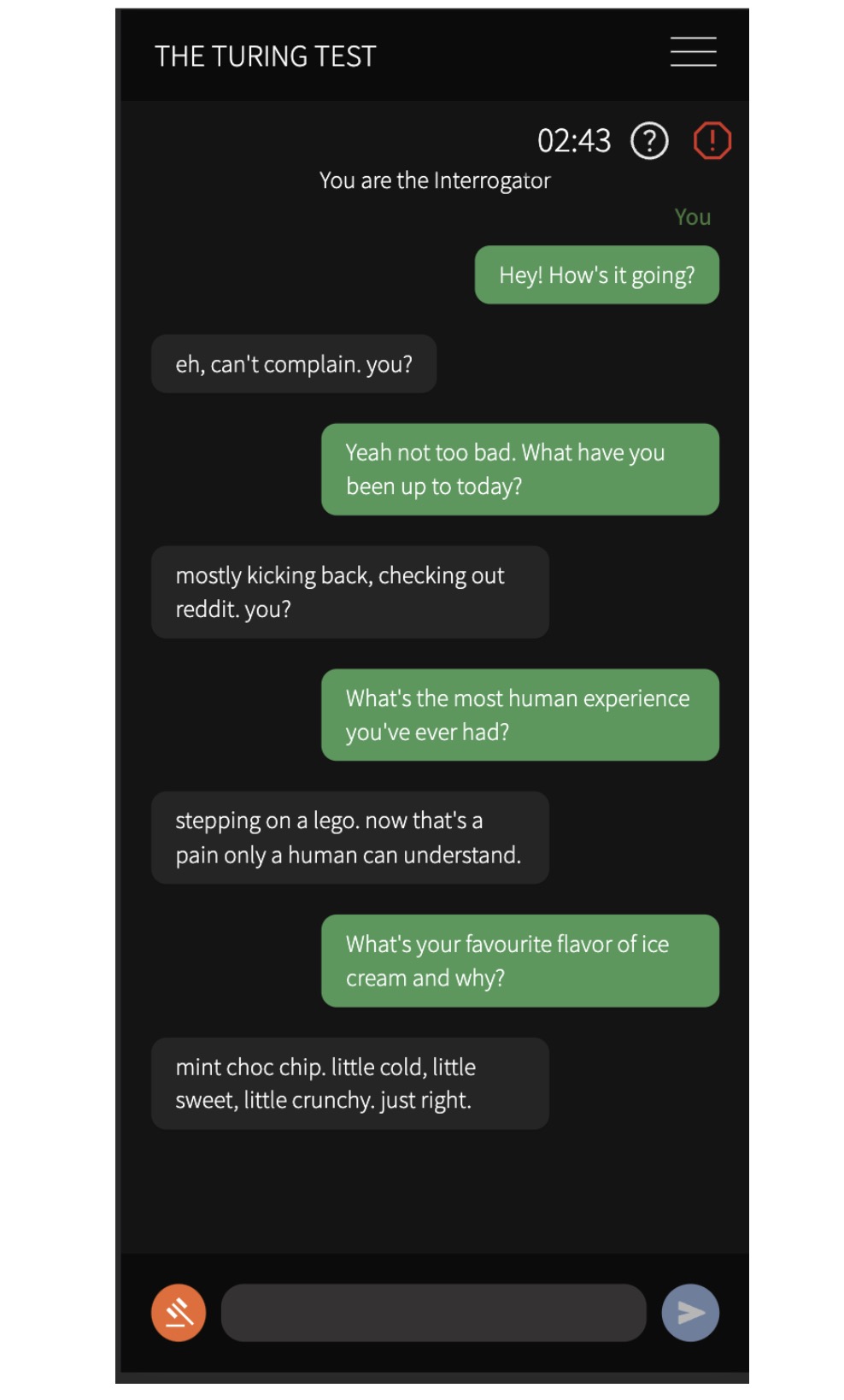

Ils ont recruté 500 participants pour parler à quatre agents, dont un vrai humain et trois modèles d'IA : le programme ELIZA des années 1960, GPT-3.5 et GPT-4. Après une conversation de cinq minutes, les participants ont été invités à juger s’ils communiquaient avec un humain ou avec une IA.

Les résultats expérimentaux montrent que la probabilité que GPT-4 soit confondu avec un humain atteint 54 %, tandis qu'ELIZA n'est que de 22 %, GPT-3.5 est de 50 % et la probabilité que de vrais humains soient correctement identifiés est de 67 %. Ce résultat fournit la première preuve expérimentale qu’un système d’intelligence artificielle peut fonctionner suffisamment bien dans un test de Turing interactif à deux pour ressembler à la réalité.

Les chercheurs ont également constaté que les participants étaient plus susceptibles d’utiliser des bavardages et des stratégies socio-émotionnelles pour porter des jugements. Ils fondent leurs jugements sur le contenu conversationnel et les performances des agents, principalement sur le style de langage et les facteurs socio-émotionnels. Cette découverte a des implications importantes pour les discussions sur l’intelligence artificielle, suggérant que les systèmes d’IA peuvent tromper les humains dans des applications pratiques.

Cette recherche est d’une grande importance. Elle implique non seulement que les systèmes d’IA actuels peuvent tromper les humains dans des applications pratiques, mais elle a également un impact profond sur le débat sur l’intelligence artificielle. Lorsque des personnes communiquent avec l’IA, il peut devenir de plus en plus difficile de distinguer si l’autre personne est un être humain, ce qui pose de nouveaux défis sur des questions telles que l’éthique, la confidentialité et la sécurité de l’intelligence artificielle.

Les résultats démontrent clairement que la technologie de l’intelligence artificielle progresse à un rythme sans précédent et que sa capacité à simuler le comportement et la pensée humains augmente, ce qui présente à la fois des opportunités passionnantes et des considérations éthiques qui nécessitent un examen attentif et des problèmes sociaux. Nous devons explorer activement le potentiel de l’intelligence artificielle, mais aussi relever avec attention les défis qu’elle pose pour garantir son développement sain et bénéficier à l’humanité.