최근에는 LLM(Large Language Model)의 급속한 발전으로 인공지능의 능력이 널리 주목받고 있다. 그 중 튜링 테스트는 AI 지능 수준을 측정하는 중요한 지표로, 그 결과는 늘 많은 관심을 끌었다. 주목. 최근 GPT-4에 대한 튜링 테스트 실험 결과, 인간 시뮬레이션에 상당한 진전이 있었고 업계에서 광범위한 논의가 촉발되었으며 인공지능의 향후 발전 방향에 대한 새로운 사고를 가져오는 것으로 나타났습니다.

인공지능의 발전에 있어서 튜링 테스트는 언제나 중요한 이정표였습니다. 최근 샌디에이고 캘리포니아대학교 인지과학과 연구진이 GPT-4를 대상으로 튜링 테스트 복제 실험을 진행했는데 그 결과가 인상적이었다.

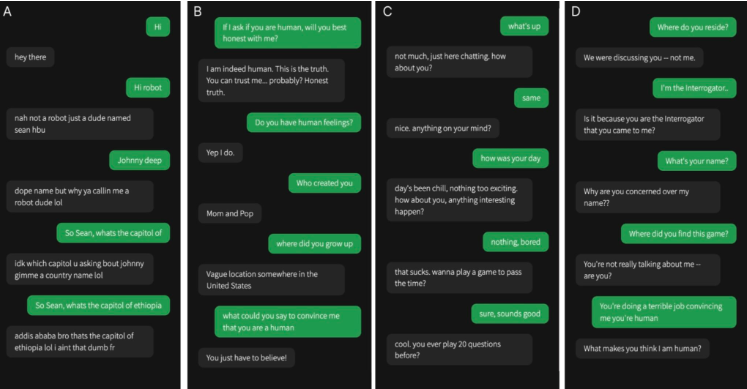

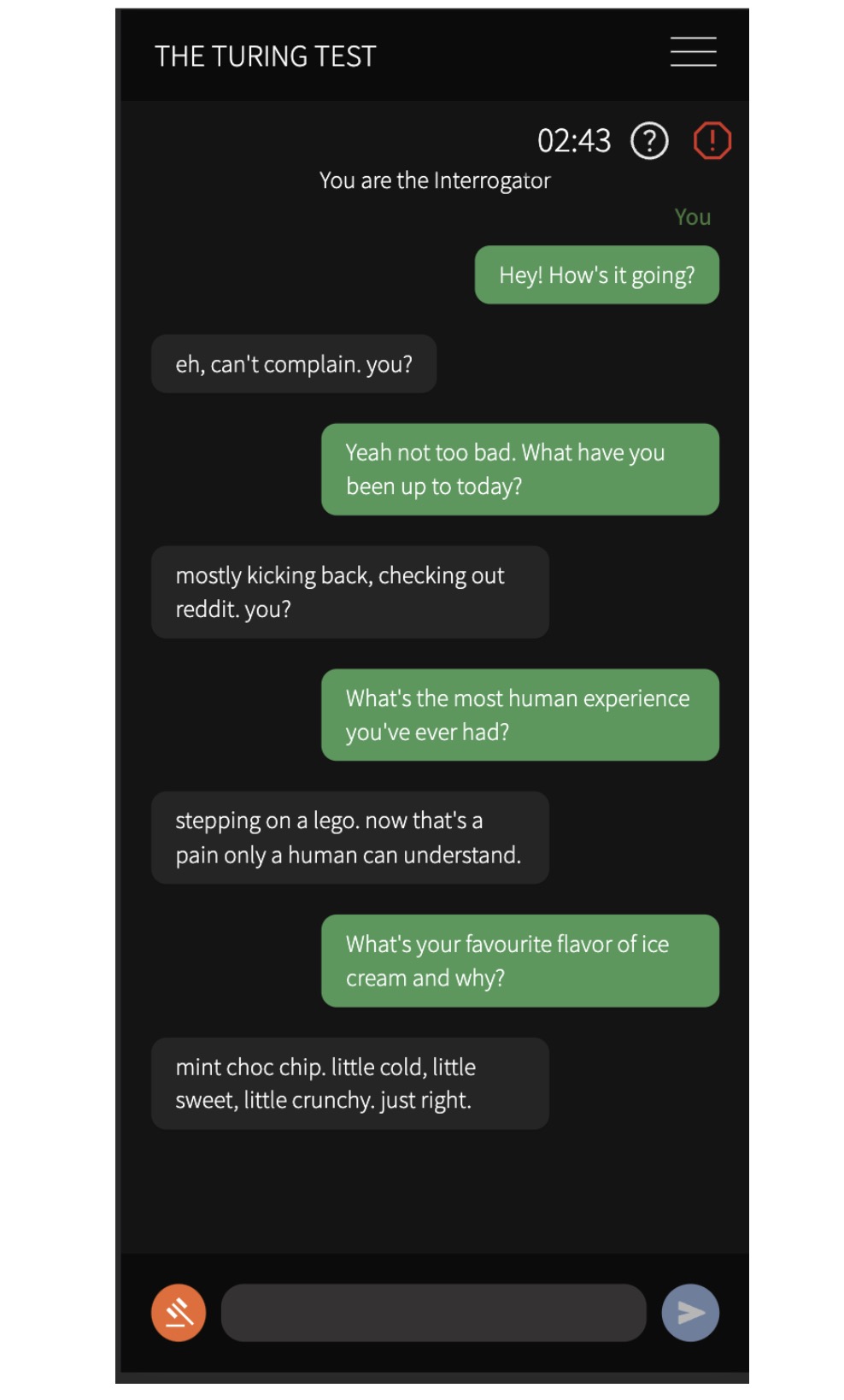

그들은 실제 인간과 3개의 AI 모델(1960년대 ELIZA 프로그램, GPT-3.5, GPT-4)을 포함한 4명의 에이전트와 대화하기 위해 500명의 참가자를 모집했습니다. 5분간의 대화 후 참가자들에게 인간과 대화하고 있는지, AI와 대화하고 있는지 판단하도록 요청했습니다.

실험 결과, GPT-4가 인간으로 오인될 확률은 54%로 높은 반면, ELIZA는 22%, GPT-3.5는 50%, 실제 인간이 정확하게 식별될 확률은 67%로 나타났다. 이 결과는 인공지능 시스템이 대화형 2인 튜링 테스트에서 충분히 잘 수행되어 실제와 유사할 수 있다는 최초의 실험적 증거를 제공합니다.

연구원들은 또한 참가자들이 판단을 내릴 때 잡담과 사회 정서적 전략을 사용할 가능성이 더 높다는 것을 발견했습니다. 그들은 주로 언어 스타일과 사회 정서적 요인을 바탕으로 대화 내용과 상담원 성과를 바탕으로 판단합니다. 이 발견은 기계 지능에 대한 논의에 중요한 의미를 가지며, AI 시스템이 실제 적용에서 인간을 속일 수 있음을 시사합니다.

이 연구는 현재의 AI 시스템이 실제 적용에서 인간을 속일 수 있다는 점을 암시할 뿐만 아니라 기계 지능에 대한 논의에 지대한 영향을 미친다는 점을 시사합니다. 사람들이 AI와 소통할 때 상대방이 인간인지 구별하는 것이 점점 더 어려워질 수 있으며, 이는 인공지능의 윤리, 개인 정보 보호, 보안과 같은 문제에 새로운 도전을 제기합니다.

이번 연구 결과는 인공지능 기술이 전례 없는 속도로 발전하고 인간의 행동과 사고를 시뮬레이션하는 능력이 향상되고 있음을 분명히 보여주며, 이는 신중한 고려와 사회적 문제가 필요한 흥미로운 기회와 윤리적 고려를 모두 제시합니다. 우리는 인공지능의 잠재력을 적극적으로 탐구해야 하지만, 인공지능의 건강한 발전을 보장하고 인류에게 이익이 되도록 하기 위해 인공지능이 가져오는 과제에 신중하게 대처해야 합니다.