En los últimos años, el rápido desarrollo de grandes modelos de lenguaje (LLM) ha atraído una gran atención sobre las capacidades de la inteligencia artificial. Entre ellos, la prueba de Turing es un indicador importante para medir el nivel de inteligencia de la IA, y sus resultados siempre han atraído mucho. atención. Recientemente, los resultados de un experimento de prueba de Turing en GPT-4 mostraron que ha logrado avances significativos en la simulación de humanos, lo que generó extensos debates en la industria y aportó nuevas ideas sobre la futura dirección del desarrollo de la inteligencia artificial.

En el desarrollo de la inteligencia artificial, la prueba de Turing siempre ha sido un hito importante. Recientemente, investigadores del Departamento de Ciencias Cognitivas de la Universidad de California en San Diego realizaron un experimento de réplica de la prueba de Turing en GPT-4 y los resultados fueron impresionantes.

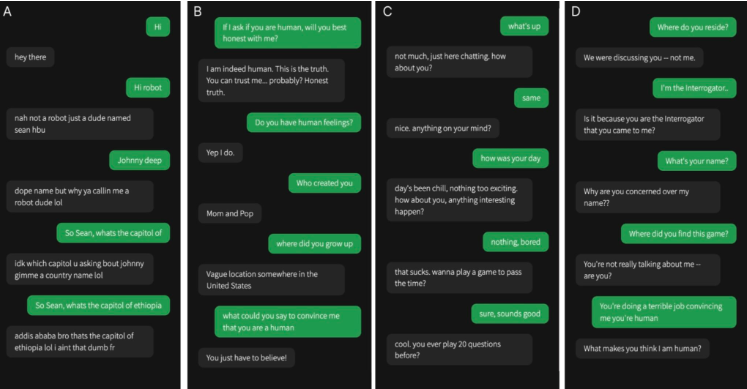

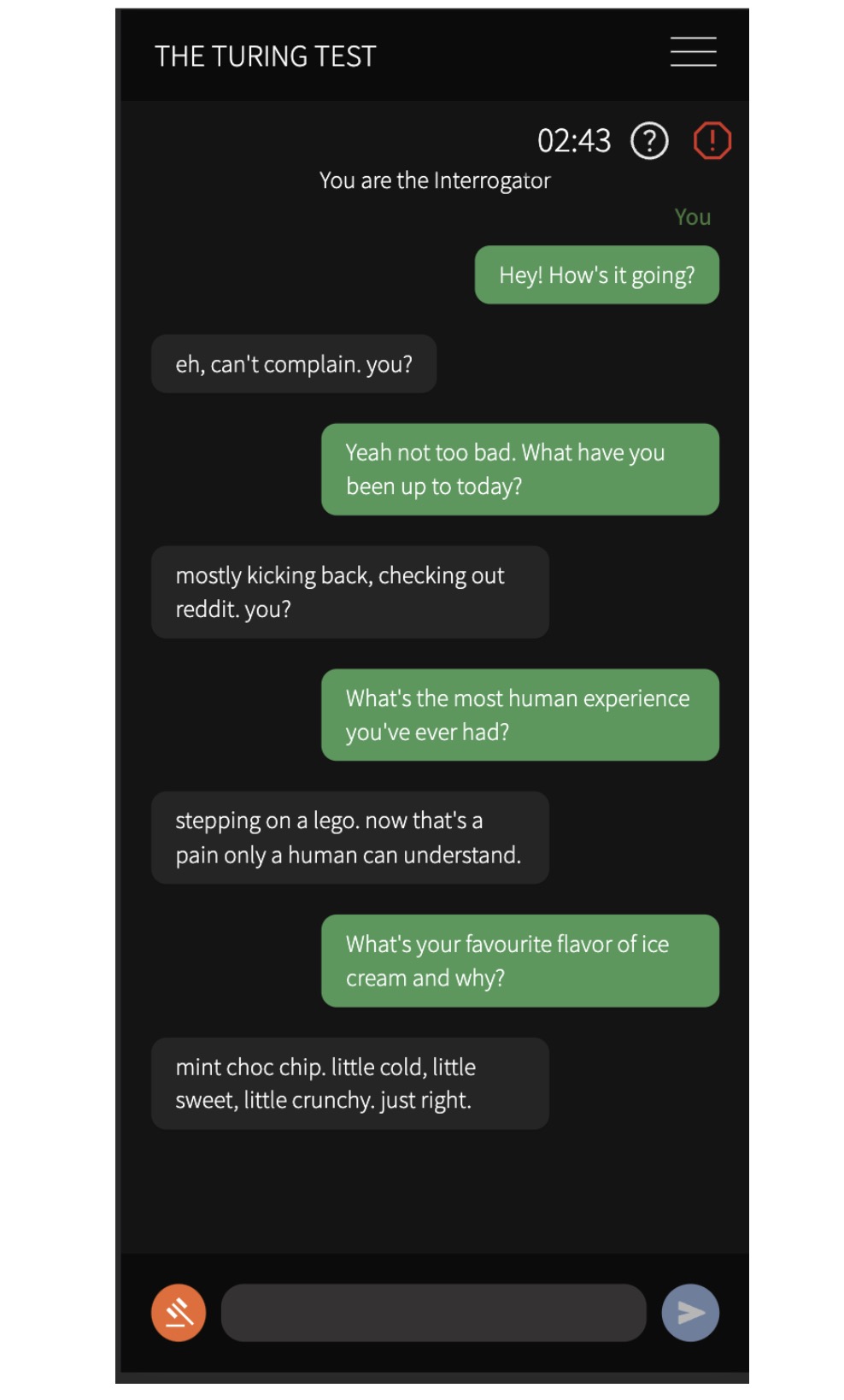

Reclutaron a 500 participantes para hablar con cuatro agentes, incluido un humano real y tres modelos de IA: el programa ELIZA de la década de 1960, GPT-3.5 y GPT-4. Después de una conversación de cinco minutos, se pidió a los participantes que juzgaran si se estaban comunicando con un humano o con una IA.

Los resultados experimentales muestran que la probabilidad de que GPT-4 sea confundido con un humano es tan alta como el 54%, mientras que ELIZA es solo del 22%, GPT-3.5 es del 50% y la probabilidad de que humanos reales sean identificados correctamente es del 67%. Este resultado proporciona la primera evidencia experimental de que un sistema de inteligencia artificial puede funcionar lo suficientemente bien en una prueba de Turing interactiva entre dos personas como para parecerse a algo real.

Los investigadores también encontraron que los participantes eran más propensos a utilizar conversaciones triviales y estrategias socioemocionales al emitir juicios. Basan sus juicios en el contenido de la conversación y el desempeño del agente, principalmente en el estilo del lenguaje y los factores socioemocionales. Este hallazgo tiene implicaciones importantes para los debates sobre la inteligencia artificial, ya que sugiere que los sistemas de IA pueden engañar a los humanos en aplicaciones prácticas.

Esta investigación es de gran importancia, no sólo implica que los sistemas de IA actuales pueden engañar a los humanos en aplicaciones prácticas, sino que también tiene un profundo impacto en el debate sobre la inteligencia artificial. Cuando las personas se comunican con IA, puede resultar cada vez más difícil distinguir si la otra persona es un ser humano, lo que plantea nuevos desafíos en cuestiones como la ética, la privacidad y la seguridad de la inteligencia artificial.

Los hallazgos demuestran claramente que la tecnología de inteligencia artificial está avanzando a un ritmo sin precedentes y su capacidad para simular el comportamiento y el pensamiento humanos está aumentando, lo que trae consigo interesantes oportunidades y consideraciones éticas y sociales. Necesitamos explorar activamente el potencial de la inteligencia artificial, pero también abordar cuidadosamente los desafíos que plantea para garantizar su desarrollo saludable y beneficiar a la humanidad.