近年、大規模言語モデル(LLM)の急速な発展により人工知能の能力が広く注目されており、その中でもチューリングテストはAIの知能レベルを測る重要な指標であり、その結果は常に注目を集めています。注意。最近、GPT-4 のチューリング テスト実験の結果は、GPT-4 が人間のシミュレーションにおいて大きな進歩を遂げたことを示し、業界で広範な議論を引き起こし、人工知能の将来の開発方向に新たな考え方をもたらしました。

人工知能の開発において、チューリング テストは常に重要なマイルストーンでした。最近、カリフォルニア大学サンディエゴ校認知科学学部の研究者らが GPT-4 でチューリング テスト レプリカ実験を実施し、その結果は印象的でした。

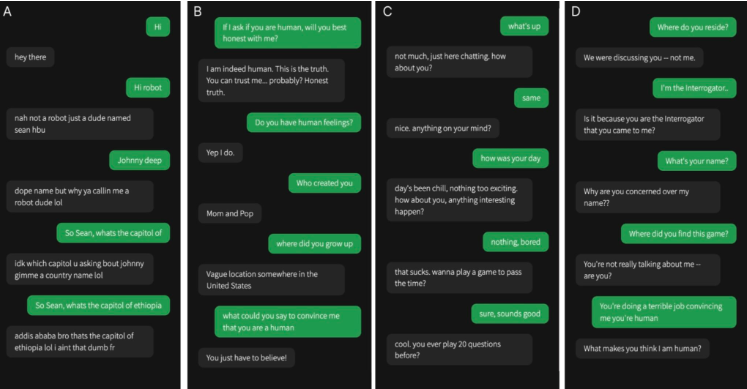

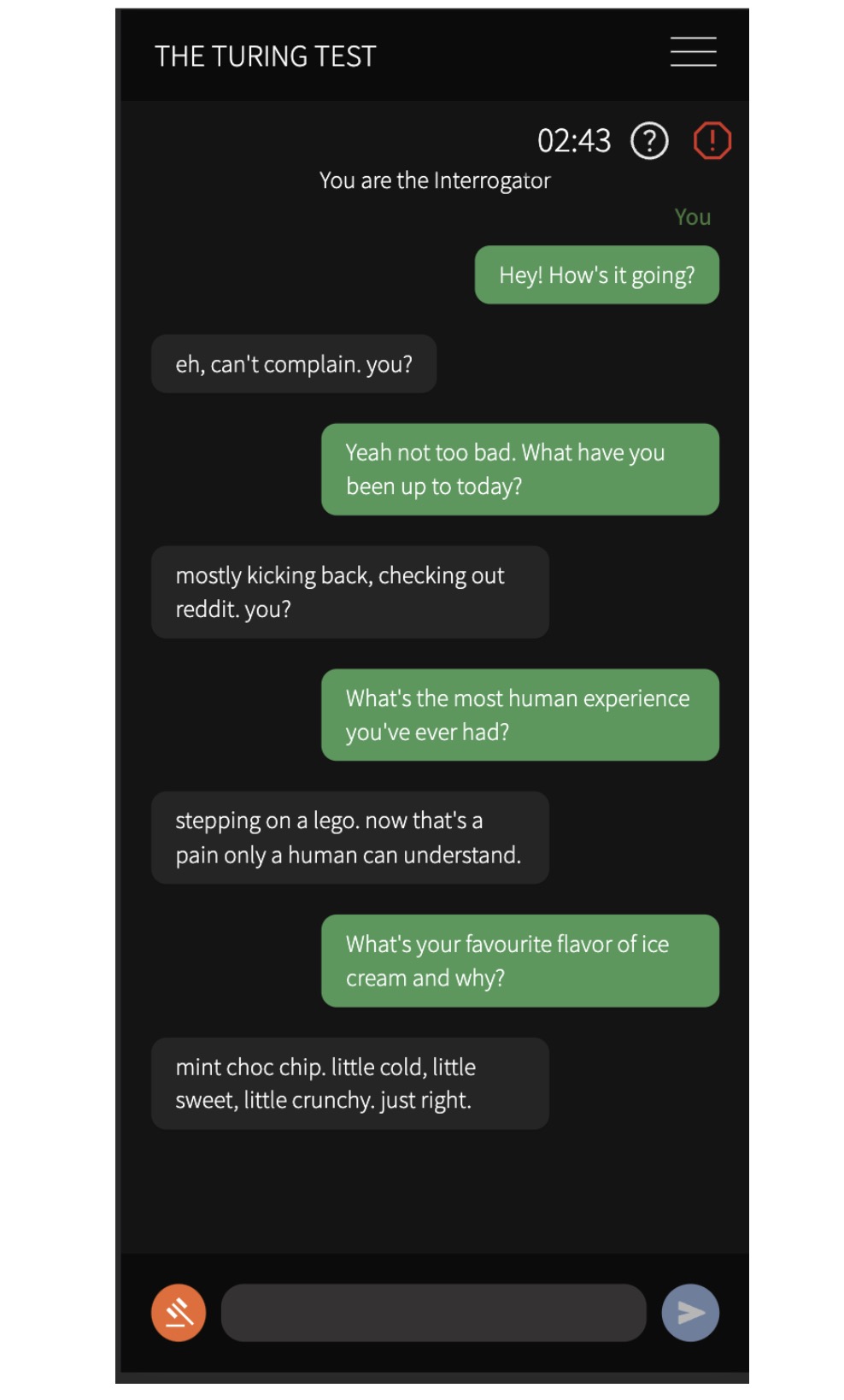

彼らは 500 人の参加者を募集し、本物の人間と 1960 年代の ELIZA プログラム、GPT-3.5、GPT-4 の 3 つの AI モデルを含む 4 つのエージェントと会話しました。 5分間の会話の後、参加者は人間と通信しているのかAIと通信しているのかを判断するよう求められた。

実験結果によると、GPT-4 が人間と間違われる確率は 54% に達するのに対し、ELIZA はわずか 22%、GPT-3.5 は 50%、本物の人間が正しく識別される確率は 67% です。この結果は、人工知能システムが対話型の 2 人用チューリング テストにおいて本物と同等の性能を十分に発揮できることを示す最初の実験的証拠を提供します。

研究者らはまた、参加者が判断を下す際に雑談や社会感情的戦略を使用する可能性が高いことも発見した。彼らは、会話の内容とエージェントのパフォーマンス、主に言語スタイルと社会感情的要因に基づいて判断します。この発見は機械知能の議論に重要な意味を持ち、AI システムが実際の応用において人間を欺く可能性があることを示唆しています。

この研究は非常に重要であり、現在の AI システムが実用化において人間を欺く可能性があることを示唆するだけでなく、機械知能の議論にも大きな影響を与えます。人間が AI とコミュニケーションをとる場合、相手が人間であるかどうかを区別することがますます困難になる可能性があり、これにより倫理、プライバシー、人工知能のセキュリティなどの問題に新たな課題が生じます。

この調査結果は、人工知能技術が前例のない速度で進歩しており、人間の行動や思考をシミュレートする能力が向上しており、それが刺激的な機会と倫理的配慮や社会問題の両方をもたらしていることを明確に示しています。私たちは人工知能の可能性を積極的に探究する必要がありますが、人工知能の健全な発展を確実にし、人類に利益をもたらすためには、人工知能がもたらす課題にも慎重に対処する必要があります。