Com o rápido desenvolvimento da tecnologia de vídeo gerada por IA, a sua fidelidade atingiu um ponto em que é difícil distinguir a autenticidade da falsificação. Para enfrentar esse desafio, pesquisadores da Universidade de Columbia desenvolveram uma nova ferramenta chamada DIVID para detectar vídeos gerados por IA. DIVID é uma extensão da ferramenta Raidar que foi usada anteriormente para detectar texto gerado por IA. Ele identifica efetivamente vídeos gerados por modelos de difusão, como Sora e Runway da OpenAI, analisando as características do próprio vídeo, em vez de confiar no funcionamento interno. mecanismo do modelo AI. Gen-2 e Pika et al. O resultado desta pesquisa é de grande importância para o combate a vídeos falsos e para a manutenção da segurança das informações da rede.

Os vídeos gerados por IA estão se tornando cada vez mais realistas, tornando difícil para os humanos (e para os sistemas de detecção existentes) distinguir vídeos reais de falsos. Para resolver esse problema, pesquisadores da Escola de Engenharia da Universidade de Columbia, liderados pelo professor de ciência da computação Junfeng Yang, desenvolveram uma nova ferramenta chamada DIVID para detectar vídeos gerados por IA, que significa DIffusion-generated VIdeo Detector. DIVID é uma extensão do Raidar, lançada pela equipe no início deste ano, que detecta texto gerado por IA analisando o próprio texto sem acessar o funcionamento interno de um grande modelo de linguagem.

DIVID aprimora métodos anteriores para detectar vídeos gerados, identificando efetivamente vídeos gerados por modelos de IA mais antigos, como Redes Adversariais Generativas (GANs). Um GAN é um sistema de IA com duas redes neurais: uma usada para criar dados falsos e outra usada para avaliar e distinguir entre dados reais e falsos. Através de feedback contínuo, ambas as redes melhoram continuamente, resultando em vídeos sintéticos altamente realistas. As ferramentas atuais de detecção de IA procuram sinais reveladores, como arranjos incomuns de pixels, movimentos não naturais ou inconsistências entre quadros, que normalmente não aparecem em vídeos reais.

Uma nova geração de ferramentas generativas de vídeo de IA, como Sora, Runway Gen-2 e Pika da OpenAI, usa modelos de difusão para criar vídeos. A modelagem de difusão é uma tecnologia de IA que cria imagens e vídeos convertendo gradualmente ruídos aleatórios em imagens nítidas e realistas. Para vídeos, ele otimiza cada quadro individualmente, garantindo transições suaves, resultando em resultados realistas e de alta qualidade. O desenvolvimento deste vídeo gerado por IA cada vez mais complexo representa um desafio significativo para a detecção da sua autenticidade.

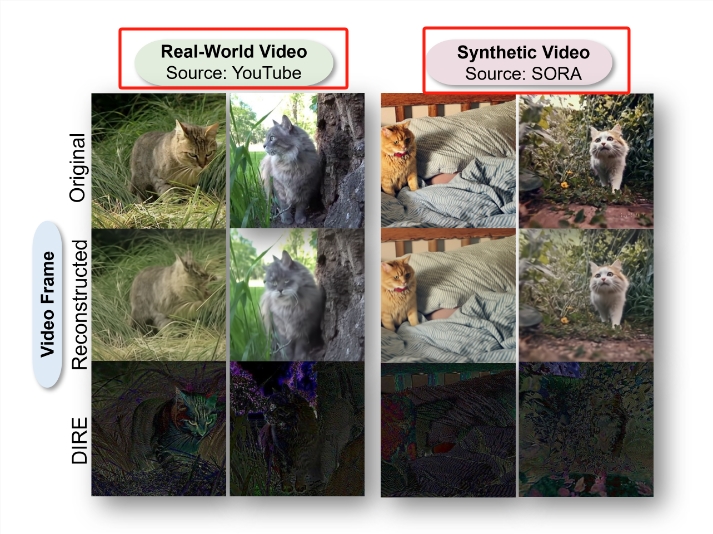

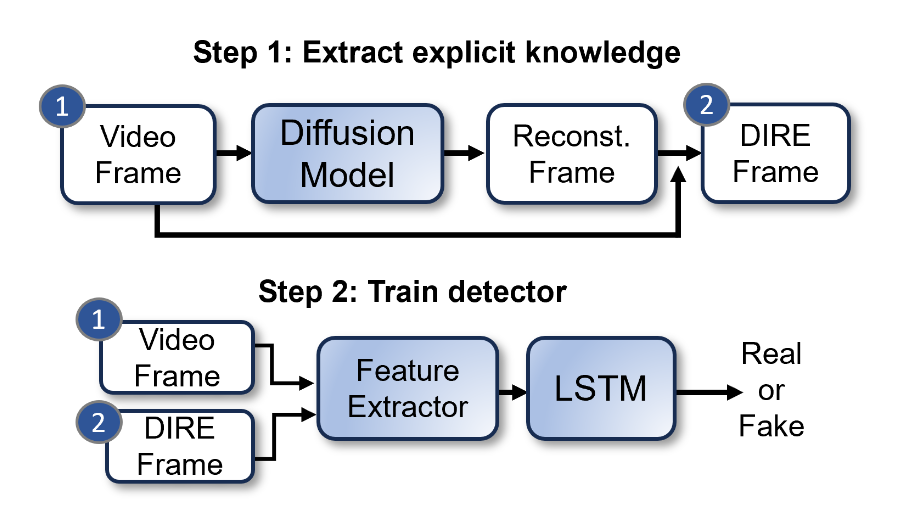

A equipe de Bernadette Young usou uma técnica chamada DIRE (DIffusion Reconstruction Error) para detectar imagens geradas por difusão. DIRE é um método que mede a diferença entre uma imagem de entrada e a imagem de saída correspondente reconstruída por um modelo de difusão pré-treinado.

Junfeng Yang, codiretor do Laboratório de Sistemas de Software, tem explorado como detectar texto e vídeo gerados por IA. Com o lançamento do Raidar no início deste ano, Junfeng Yang e colaboradores implementaram um método para detectar texto gerado por IA analisando o próprio texto, sem acessar o funcionamento interno de grandes modelos de linguagem, como chatGPT-4, Gemini ou Llama. O Raidar usa um modelo de linguagem para reformular ou modificar um determinado texto e então mede o número de edições que o sistema faz nesse texto. Um número alto de edições significa que o texto provavelmente foi escrito por um ser humano, enquanto um número baixo de edições significa que o texto provavelmente foi gerado por máquina.

“A heurística do Raidar – que outra IA geralmente percebe a saída de outra IA como de alta qualidade, por isso faz menos edições – é um insight muito poderoso, não limitado apenas ao texto”, disse Junfeng Yang. os vídeos estão se tornando cada vez mais realistas, queríamos usar os insights do Raidar para criar uma ferramenta que pudesse detectar com precisão vídeos gerados por IA.”

Os pesquisadores desenvolveram o DIVID usando o mesmo conceito. Este novo método generativo de detecção de vídeo pode identificar vídeos gerados por modelos de difusão. O artigo de pesquisa foi publicado na Computer Vision and Pattern Recognition Conference (CVPR) em Seattle em 18 de junho de 2024, e o código-fonte aberto e o conjunto de dados foram lançados ao mesmo tempo.

Endereço do artigo: https://arxiv.org/abs/2406.09601

Destaque:

- Em resposta aos vídeos gerados por IA cada vez mais realistas, pesquisadores da Escola de Engenharia da Universidade de Columbia desenvolveram uma nova ferramenta, DIVID, que pode detectar vídeos gerados por IA com 93,7% de precisão.

- DIVID é uma melhoria nos métodos anteriores para detectar uma nova geração de vídeos gerados por IA, que pode identificar vídeos gerados por um modelo de difusão que transforma gradualmente ruído aleatório em imagens de vídeo realistas e de alta qualidade.

- Os pesquisadores ampliam os insights do texto gerado pela IA do Raidar para o vídeo, usando modelos de linguagem para reformular ou modificar o texto ou vídeo e, em seguida, medem o número de edições que o sistema faz no texto ou vídeo para determinar sua autenticidade.

Em suma, o surgimento do DIVID fornece uma nova arma para combater informações falsas em vídeos gerados por IA. A divulgação do seu código-fonte aberto e conjuntos de dados também promoverá pesquisas e desenvolvimento futuros neste campo e contribuirá para a construção de um mundo mais seguro e confiável. ambiente de rede.