Con el rápido desarrollo de la tecnología de vídeo generada por IA, su fidelidad ha llegado al punto en que es difícil distinguir la autenticidad de la falsificación. Para abordar este desafío, investigadores de la Universidad de Columbia han desarrollado una nueva herramienta llamada DIVID para detectar videos generados por IA. DIVID es una extensión de la herramienta Raidar que se utilizaba anteriormente para detectar texto generado por IA. Identifica eficazmente vídeos generados por modelos de difusión, como Sora y Runway de OpenAI, analizando las características del vídeo en sí en lugar de depender del funcionamiento interno. Mecanismo del modelo AI Gen-2 y Pika et al. El resultado de esta investigación es de gran importancia para combatir los vídeos ultrafalsos y mantener la seguridad de la información de la red.

Los videos generados por IA son cada vez más realistas, lo que dificulta que los humanos (y los sistemas de detección existentes) puedan distinguir los videos reales de los falsos. Para resolver este problema, investigadores de la Facultad de Ingeniería de la Universidad de Columbia, dirigidos por el profesor de informática Junfeng Yang, desarrollaron una nueva herramienta llamada DIVID para detectar vídeos generados por IA, que significa DIffusion-generated VIdeo Detector. DIVID es una extensión de Raidar, que el equipo lanzó a principios de este año, que detecta texto generado por IA analizando el texto mismo sin acceder al funcionamiento interno de un modelo de lenguaje grande.

DIVID mejora los métodos anteriores para detectar videos generados, identificando efectivamente videos generados por modelos de IA más antiguos, como las Redes Generativas Adversarias (GAN). Una GAN es un sistema de inteligencia artificial con dos redes neuronales: una que se usa para crear datos falsos y otra que se usa para evaluar y distinguir entre datos reales y falsos. A través de retroalimentación continua, ambas redes mejoran continuamente, dando como resultado videos sintéticos altamente realistas. Las herramientas actuales de detección de IA buscan signos reveladores como disposiciones inusuales de píxeles, movimientos antinaturales o inconsistencias entre fotogramas, que normalmente no aparecen en un vídeo real.

Una nueva generación de herramientas de vídeo de IA generativa, como Sora, Runway Gen-2 y Pika de OpenAI, utilizan modelos de difusión para crear vídeos. El modelado de difusión es una tecnología de inteligencia artificial que crea imágenes y videos convirtiendo gradualmente ruido aleatorio en imágenes claras y realistas. Para videos, optimiza cada fotograma individualmente al tiempo que garantiza transiciones suaves, lo que da como resultado resultados realistas y de alta calidad. El desarrollo de este vídeo cada vez más complejo generado por IA plantea un desafío importante para la detección de su autenticidad.

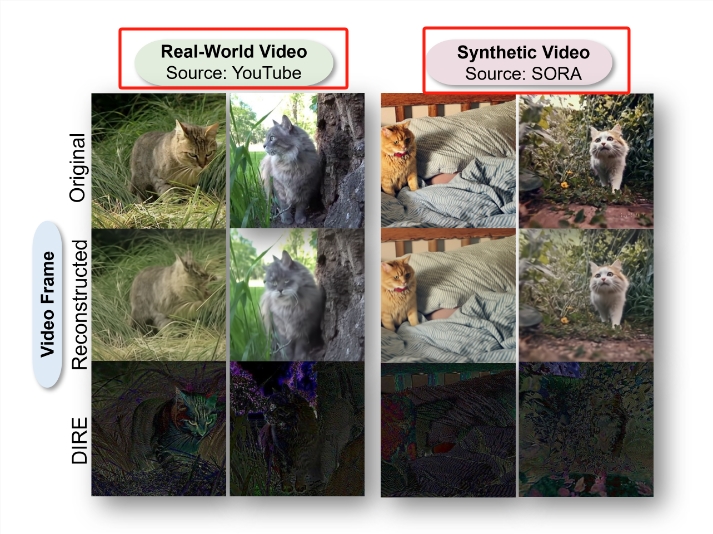

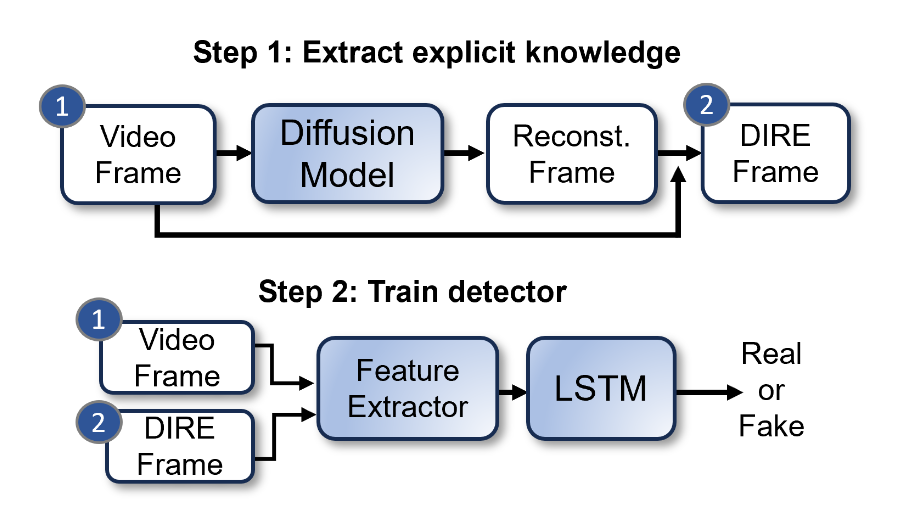

El equipo de Bernadette Young utilizó una técnica llamada DIRE (Error de reconstrucción de difusión) para detectar imágenes generadas por difusión. DIRE es un método que mide la diferencia entre una imagen de entrada y la imagen de salida correspondiente reconstruida mediante un modelo de difusión previamente entrenado.

Junfeng Yang, codirector del Laboratorio de Sistemas de Software, ha estado explorando cómo detectar texto y vídeo generados por IA. Con el lanzamiento de Raidar a principios de este año, Junfeng Yang y sus colaboradores implementaron un método para detectar texto generado por IA analizando el texto mismo, sin acceder al funcionamiento interno de grandes modelos de lenguaje como chatGPT-4, Gemini o Llama. Raidar utiliza un modelo de lenguaje para reformular o modificar un texto determinado y luego mide la cantidad de ediciones que el sistema realiza en el texto determinado. Una gran cantidad de ediciones significa que el texto probablemente fue escrito por un humano, mientras que una cantidad baja de ediciones significa que el texto probablemente fue generado por una máquina.

“La heurística de Raidar (que otra IA generalmente percibe que la producción de otra IA es de alta calidad, por lo que realiza menos ediciones) es una idea muy poderosa, que no se limita solo al texto”, dijo Junfeng Yang. Dijo: “Dado que es generado por IA. Los videos son cada vez más realistas, queríamos utilizar los conocimientos de Raidar para crear una herramienta que pueda detectar con precisión videos generados por IA”.

Los investigadores desarrollaron DIVID utilizando el mismo concepto. Este nuevo método de detección de video generativo puede identificar videos generados por modelos de difusión. El artículo de investigación se publicó en la Conferencia de Reconocimiento de Patrones y Visión por Computadora (CVPR) en Seattle el 18 de junio de 2024, y el código fuente abierto y el conjunto de datos se publicaron al mismo tiempo.

Dirección del artículo: https://arxiv.org/abs/2406.09601

Destacar:

- En respuesta a los vídeos cada vez más realistas generados por IA, investigadores de la Escuela de Ingeniería de la Universidad de Columbia han desarrollado una nueva herramienta, DIVID, que puede detectar vídeos generados por IA con una precisión del 93,7%.

- DIVID es una mejora de los métodos anteriores para detectar una nueva generación de videos generados por IA, que puede identificar videos generados por un modelo de difusión que transforma gradualmente el ruido aleatorio en imágenes de video realistas y de alta calidad.

- Los investigadores amplían los conocimientos del texto generado por IA de Raidar al video, utilizando modelos de lenguaje para reformular o modificar el texto o el video, y luego miden la cantidad de ediciones que el sistema realiza en el texto o el video para determinar su autenticidad.

En resumen, la aparición de DIVID proporciona una nueva arma para combatir la información falsa en los videos generados por IA. La publicación de su código fuente abierto y sus conjuntos de datos también promoverá la investigación y el desarrollo futuros en este campo y contribuirá a construir una plataforma más segura y confiable. entorno de red.