Mit der rasanten Entwicklung der KI-generierten Videotechnologie hat ihre Wiedergabetreue einen Punkt erreicht, an dem es schwierig ist, Authentizität von Fälschung zu unterscheiden. Um dieser Herausforderung zu begegnen, haben Forscher der Columbia University ein neues Tool namens DIVID zur Erkennung von KI-generierten Videos entwickelt. DIVID ist eine Erweiterung des Raidar-Tools, das zuvor zur Erkennung von KI-generiertem Text verwendet wurde. Es identifiziert effektiv Videos, die von Diffusionsmodellen wie Sora und Runway von OpenAI generiert wurden, indem es die Eigenschaften des Videos selbst analysiert, anstatt sich auf die interne Funktionsweise zu verlassen Mechanismus des KI-Modells Gen-2 und Pika et al. Dieses Forschungsergebnis ist von großer Bedeutung für die Bekämpfung von Deep-Fake-Videos und die Aufrechterhaltung der Netzwerkinformationssicherheit.

KI-generierte Videos werden immer realistischer, was es für Menschen (und bestehende Erkennungssysteme) schwierig macht, echte Videos von gefälschten zu unterscheiden. Um dieses Problem zu lösen, haben Forscher der Columbia University School of Engineering unter der Leitung von Informatikprofessor Junfeng Yang ein neues Tool namens DIVID zur Erkennung von KI-generierten Videos entwickelt, das für DIffusion-generated VIdeo Detector steht. DIVID ist eine Erweiterung von Raidar, die das Team Anfang des Jahres veröffentlicht hat und die KI-generierten Text erkennt, indem sie den Text selbst analysiert, ohne auf das Innenleben eines großen Sprachmodells zuzugreifen.

DIVID verbessert frühere Methoden zur Erkennung generierter Videos und identifiziert effektiv Videos, die von älteren KI-Modellen wie Generative Adversarial Networks (GANs) generiert wurden. Ein GAN ist ein KI-System mit zwei neuronalen Netzen: eines zur Erstellung gefälschter Daten und ein anderes zur Auswertung, um zwischen echten und gefälschten Daten zu unterscheiden. Durch kontinuierliches Feedback verbessern sich beide Netzwerke kontinuierlich, was zu äußerst realistischen synthetischen Videos führt. Aktuelle KI-Erkennungstools suchen nach verräterischen Anzeichen wie ungewöhnlichen Pixelanordnungen, unnatürlichen Bewegungen oder Inkonsistenzen zwischen Bildern, die in echten Videos normalerweise nicht auftauchen.

Eine neue Generation generativer KI-Videotools wie Sora, Runway Gen-2 und Pika von OpenAI verwenden Diffusionsmodelle zum Erstellen von Videos. Diffusionsmodellierung ist eine KI-Technologie, die Bilder und Videos erstellt, indem zufälliges Rauschen schrittweise in klare, realistische Bilder umgewandelt wird. Bei Videos optimiert es jedes Bild einzeln und sorgt gleichzeitig für reibungslose Übergänge, was zu hochwertigen, realistischen Ergebnissen führt. Die Entwicklung dieses immer komplexer werdenden KI-generierten Videos stellt eine erhebliche Herausforderung für die Erkennung seiner Authentizität dar.

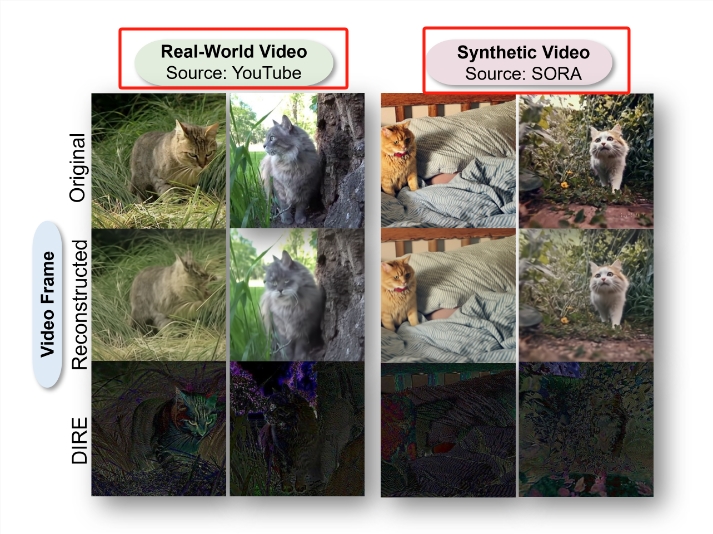

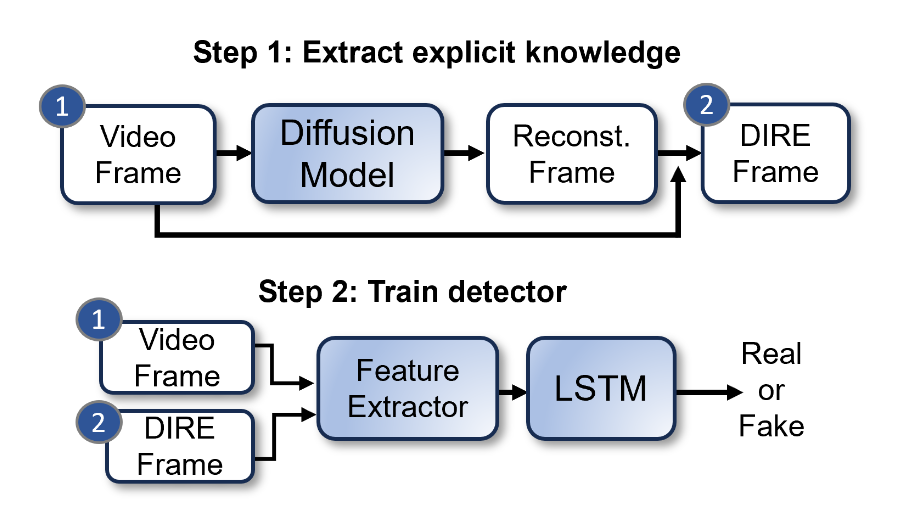

Das Team von Bernadette Young verwendete eine Technik namens DIRE (DIffusion Reconstruction Error), um durch Diffusion erzeugte Bilder zu erkennen. DIRE ist eine Methode, die den Unterschied zwischen einem Eingabebild und dem entsprechenden Ausgabebild misst, das durch ein vorab trainiertes Diffusionsmodell rekonstruiert wurde.

Junfeng Yang, Co-Direktor des Software Systems Lab, hat untersucht, wie KI-generierte Texte und Videos erkannt werden können. Mit der Veröffentlichung von Raidar Anfang dieses Jahres implementierten Junfeng Yang und seine Mitarbeiter eine Methode zur Erkennung von KI-generiertem Text durch Analyse des Textes selbst, ohne auf das Innenleben großer Sprachmodelle wie chatGPT-4, Gemini oder Llama zuzugreifen. Raidar verwendet ein Sprachmodell, um einen bestimmten Text neu zu formulieren oder zu ändern, und misst dann die Anzahl der Änderungen, die das System an dem bestimmten Text vornimmt. Eine hohe Anzahl an Änderungen bedeutet, dass der Text wahrscheinlich von einem Menschen verfasst wurde, während eine niedrige Anzahl an Änderungen bedeutet, dass der Text wahrscheinlich maschinell erstellt wurde.

„Raidars Heuristik – dass eine andere KI die Ausgabe einer anderen KI im Allgemeinen als hochwertig wahrnimmt und daher weniger Änderungen vornimmt – ist eine sehr aussagekräftige Erkenntnis, die sich nicht nur auf Text beschränkt“, sagte Junfeng Yang Da Videos immer realistischer werden, wollten wir die Erkenntnisse von Raidar nutzen, um ein Tool zu entwickeln, das KI-generierte Videos genau erkennen kann.“

Forscher entwickelten DIVID nach dem gleichen Konzept. Diese neue generative Videoerkennungsmethode kann von Diffusionsmodellen generierte Videos identifizieren. Das Forschungspapier wurde am 18. Juni 2024 auf der Computer Vision and Pattern Recognition Conference (CVPR) in Seattle veröffentlicht und gleichzeitig der Open-Source-Code und der Datensatz veröffentlicht.

Papieradresse: https://arxiv.org/abs/2406.09601

Höhepunkte:

– Als Reaktion auf immer realistischere KI-generierte Videos haben Forscher der Columbia University School of Engineering ein neues Tool namens DIVID entwickelt, das KI-generierte Videos mit einer Genauigkeit von 93,7 % erkennen kann.

- DIVID ist eine Verbesserung gegenüber früheren Methoden zur Erkennung einer neuen Generation generierter KI-Videos, die Videos identifizieren kann, die von einem Diffusionsmodell generiert wurden, das zufälliges Rauschen schrittweise in hochwertige, realistische Videobilder umwandelt.

- Forscher erweitern Erkenntnisse aus Raidars KI-generiertem Text auf Videos, indem sie Sprachmodelle verwenden, um den Text oder das Video neu zu formulieren oder zu modifizieren, und messen dann die Anzahl der Bearbeitungen, die das System am Text oder Video vornimmt, um seine Authentizität zu bestimmen.

Kurz gesagt, das Aufkommen von DIVID bietet eine neue Waffe zur Bekämpfung falscher Informationen in KI-generierten Videos. Die Veröffentlichung seines Open-Source-Codes und seiner Datensätze wird auch die zukünftige Forschung und Entwicklung in diesem Bereich fördern und zum Aufbau eines sichereren und zuverlässigeren Systems beitragen Netzwerkumgebung.