인공지능(AI) 영상 기술의 급속한 발전으로 그 충실도는 진위와 가짜를 구별하기 어려운 수준에 이르렀다. 이러한 문제를 해결하기 위해 Columbia University의 연구원들은 AI 생성 비디오를 감지하기 위한 DIVID라는 새로운 도구를 개발했습니다. DIVID는 이전에 AI 생성 텍스트를 감지하는 데 사용되었던 Raidar 도구의 확장으로 OpenAI의 Sora 및 Runway와 같은 확산 모델에서 생성된 비디오를 내부 작업에 의존하기보다는 비디오 자체의 특성을 분석하여 효과적으로 식별합니다. AI 모델의 메커니즘 Gen-2 및 Pika et al. 이번 연구 결과는 딥 페이크 영상 퇴치 및 네트워크 정보 보안 유지에 큰 의미가 있다.

AI가 생성한 영상은 점점 더 사실적으로 변해 인간(및 기존 탐지 시스템)이 실제 영상과 가짜 영상을 구별하기가 어려워지고 있습니다. 이 문제를 해결하기 위해 컴퓨터 과학 교수 Junfeng Yang이 이끄는 Columbia University School of Engineering의 연구원들은 DIffusion-generated VIdeo Detector의 약어인 AI 생성 비디오를 감지하기 위한 DIVID라는 새로운 도구를 개발했습니다. DIVID는 팀이 올해 초 출시한 Raidar의 확장으로, 대규모 언어 모델의 내부 작업에 액세스하지 않고 텍스트 자체를 분석하여 AI 생성 텍스트를 감지합니다.

DIVID는 생성된 비디오를 감지하는 이전 방법을 개선하여 GAN(Generative Adversarial Networks)과 같은 이전 AI 모델에서 생성된 비디오를 효과적으로 식별합니다. GAN은 두 개의 신경망을 갖춘 AI 시스템입니다. 하나는 가짜 데이터를 생성하는 데 사용되고 다른 하나는 실제 데이터와 가짜 데이터를 구별하는 데 사용됩니다. 지속적인 피드백을 통해 두 네트워크 모두 지속적으로 개선되어 매우 사실적인 합성 비디오가 생성됩니다. 현재 AI 감지 도구는 일반적으로 실제 비디오에서는 나타나지 않는 비정상적인 픽셀 배열, 부자연스러운 움직임 또는 프레임 간의 불일치와 같은 숨길 수 없는 징후를 찾습니다.

OpenAI의 Sora, Runway Gen-2, Pika와 같은 차세대 생성 AI 비디오 도구는 확산 모델을 사용하여 비디오를 만듭니다. 확산모델링(Diffusion Modeling)은 랜덤한 노이즈를 점진적으로 선명하고 사실적인 그림으로 변환하여 이미지와 영상을 생성하는 AI 기술입니다. 비디오의 경우 원활한 전환을 보장하면서 각 프레임을 개별적으로 최적화하여 고품질의 사실적인 결과를 얻습니다. 점점 더 복잡해지는 AI 생성 비디오의 개발은 그 진위 여부를 탐지하는 데 중요한 과제를 제기합니다.

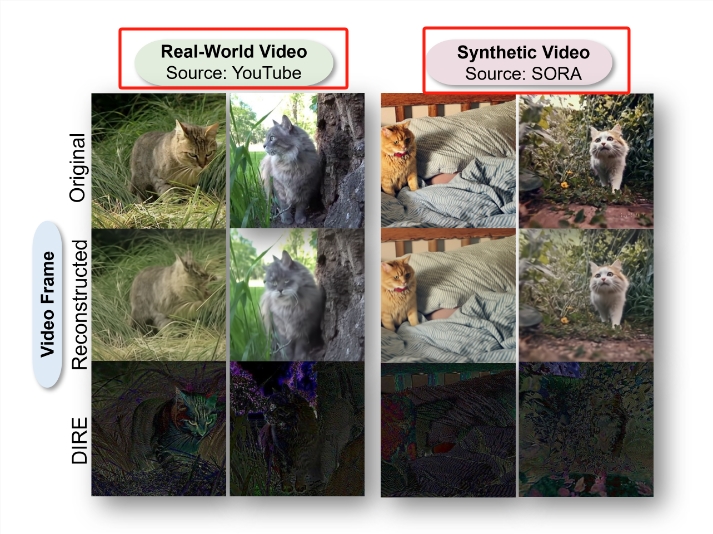

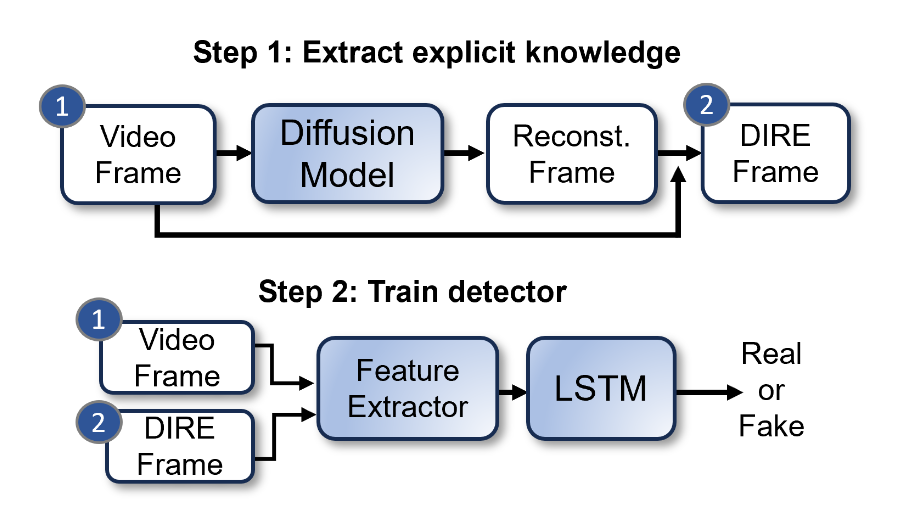

Bernadette Young 팀은 DIRE(DIffusion Reconstruction Error)라는 기술을 사용하여 확산으로 생성된 이미지를 감지했습니다. DIRE는 입력 이미지와 사전 학습된 확산 모델을 통해 재구성된 해당 출력 이미지 간의 차이를 측정하는 방법입니다.

소프트웨어 시스템 연구소의 공동 책임자인 Junfeng Yang은 AI가 생성한 텍스트와 비디오를 감지하는 방법을 탐구해 왔습니다. 올해 초 Raidar가 출시되면서 Junfeng Yang과 공동 작업자는 chatGPT-4, Gemini 또는 Llama와 같은 대규모 언어 모델의 내부 작업에 액세스하지 않고 텍스트 자체를 분석하여 AI 생성 텍스트를 감지하는 방법을 구현했습니다. Raidar는 언어 모델을 사용하여 주어진 텍스트를 재구성하거나 수정한 다음 시스템이 주어진 텍스트를 편집한 횟수를 측정합니다. 편집 횟수가 많다는 것은 텍스트가 사람이 작성한 것일 가능성이 높음을 의미하고, 편집 횟수가 적다는 것은 해당 텍스트가 기계에서 생성되었을 가능성이 있음을 의미합니다.

Junfeng Yang은 "다른 AI가 일반적으로 다른 AI의 출력을 고품질로 인식하므로 편집 횟수가 줄어든다는 Raidar의 경험적 방법은 텍스트에만 국한된 것이 아니라 매우 강력한 통찰력입니다."라고 말했습니다. 비디오가 점점 더 현실적으로 변하고 있기 때문에 우리는 Raidar의 통찰력을 사용하여 AI 생성 비디오를 정확하게 감지할 수 있는 도구를 만들고 싶었습니다.”

연구원들은 동일한 개념을 사용하여 DIVID를 개발했습니다. 이 새로운 생성적 비디오 감지 방법은 확산 모델에 의해 생성된 비디오를 식별할 수 있습니다. 해당 연구 논문은 2024년 6월 18일 시애틀에서 열린 컴퓨터 비전 및 패턴 인식 컨퍼런스(CVPR)에서 발표되었으며, 오픈 소스 코드와 데이터 세트가 동시에 공개되었습니다.

논문 주소: https://arxiv.org/abs/2406.09601

가장 밝은 부분:

- 점점 더 사실적인 AI 생성 비디오에 대응하여 컬럼비아 대학 공과대학의 연구원들은 93.7% 정확도로 AI 생성 비디오를 감지할 수 있는 새로운 도구 DIVID를 개발했습니다.

- DIVID는 생성된 차세대 AI 비디오를 감지하는 이전 방법을 개선한 것으로, 무작위 노이즈를 점진적으로 고품질의 사실적인 비디오 이미지로 변환하는 확산 모델에 의해 생성된 비디오를 식별할 수 있습니다.

- 연구원들은 Raidar의 AI 생성 텍스트에서 비디오로 통찰력을 확장하여 언어 모델을 사용하여 텍스트 또는 비디오를 재구성하거나 수정한 다음 시스템이 텍스트 또는 비디오에 수행한 편집 횟수를 측정하여 진위 여부를 결정합니다.

즉, DIVID의 출현은 AI 생성 비디오의 허위 정보에 맞서 싸울 수 있는 새로운 무기를 제공합니다. 오픈 소스 코드 및 데이터 세트의 공개는 이 분야의 향후 연구 개발을 촉진하고 보다 안전하고 신뢰할 수 있는 비디오를 구축하는 데 기여할 것입니다. 네트워크 환경.