Documentação | Documentação chinesa

Chinês simplificado | Inglês

Tengine

Introdução

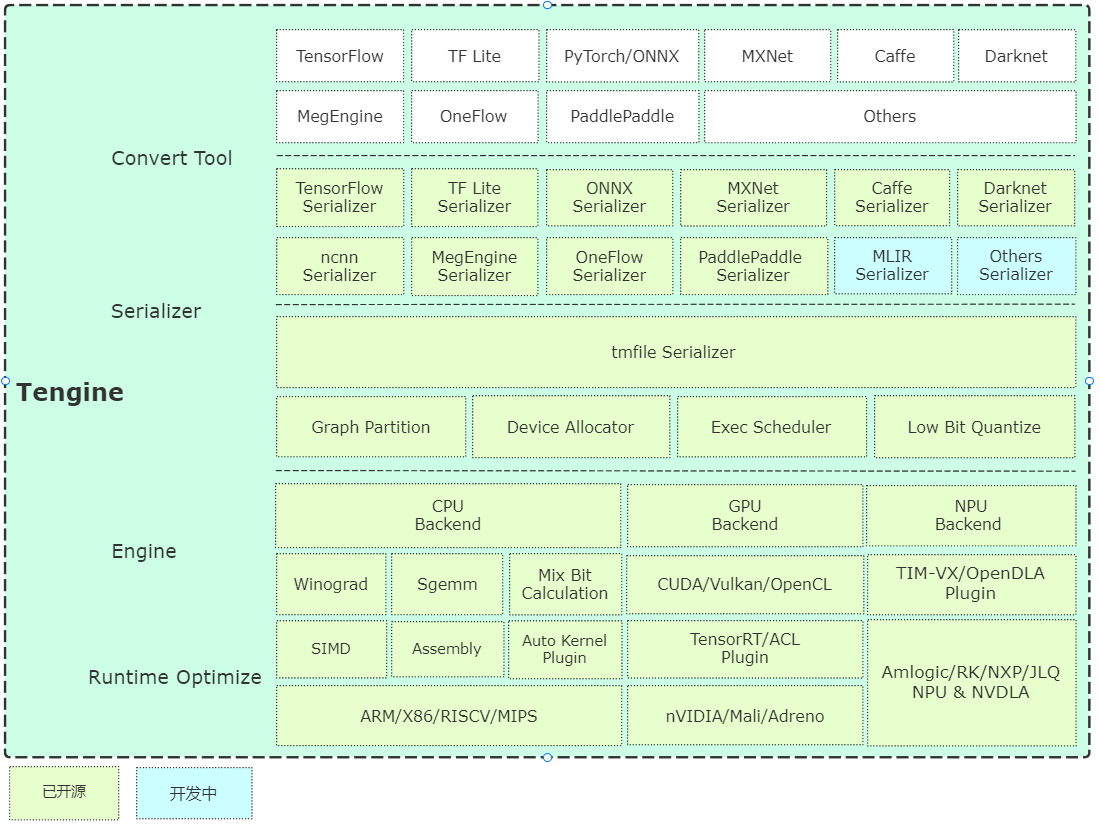

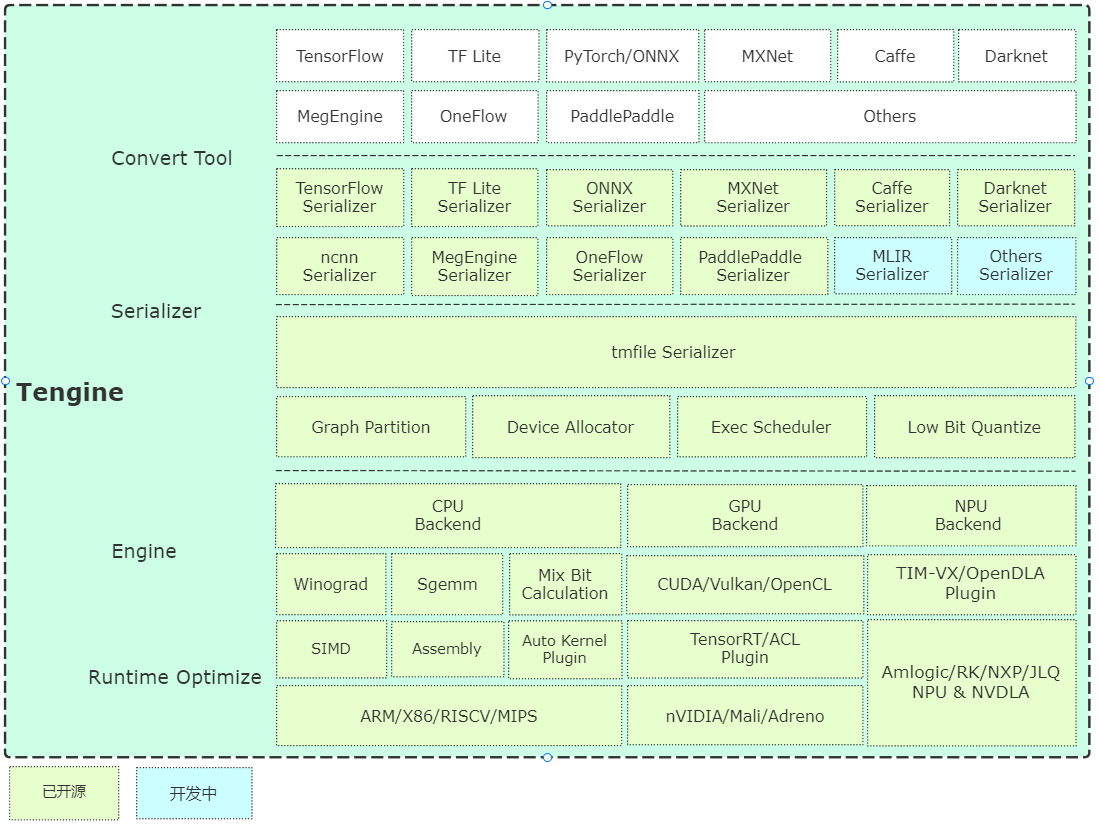

O Tengine é liderado pelo Open AI Lab , e o projeto percebe a necessidade de implantação rápida e eficiente de modelos de rede neural de aprendizado profundo em dispositivos incorporados. Para realizar a implantação de plataformas cruzadas em muitos aplicativos AIOT , este projeto usa o idioma C para o desenvolvimento do módulo principal e realiza um corte de estrutura aprofundado com base nos recursos limitados dos dispositivos incorporados. Ao mesmo tempo, é adotado um design de front-end completamente separado, que é propício à porte rápida e implantação de unidades de computação heterogênea, como CPU, GPU e NPU, reduzindo o custo de avaliação e migração.

O código central do tengine consiste em 4 módulos:

- Dispositivo : são fornecidos códigos de referência de back -end, CPU, GPU e NPU;

- Agendador : os componentes principais da estrutura, incluindo NNIR, gráfico de computação, recursos de hardware e o módulo de agendamento e execução do analisador modelo;

- Operador : Operadores NN Módulo front-end, implementa o registro e a inicialização dos operadores NN;

- Serializer : analisador de modelos, implementa a análise de parâmetros do modelo de rede no formato TMFile.

Breve análise da arquitetura

Comece rapidamente

Compilação

- Compilação rápida com base no CMake, a compilação simples de plataforma cruzada é implementada.

Exemplo

- Os exemplos fornecem casos de uso básico de uso de algoritmo de classificação e detecção e atualizam continuamente de acordo com os requisitos de emissão.

- A instalação da fonte fornece a instalação da linha de comando apt-get e a avaliação do sistema Ubuntu, e atualmente suporta hardware x86/a311d.

Model Warehouse

Ferramenta de conversão

- Versão pré -compilada: fornece ferramentas de conversão de modelo pré -compiladas no sistema Ubuntu 18.04;

- Versão de conversão on -line: com base na implementação do WebAssembly (conversão local do navegador, o modelo não será carregado;

- Compilação de código -fonte: é recomendável compilar no servidor ou no PC, as instruções são as seguintes:

mkdir build && cd build

cmake -DTENGINE_BUILD_CONVERT_TOOL=ON ..

make -j`nproc`

Ferramentas quantitativas

- Compilação do código -fonte: O código -fonte da ferramenta quantitativa foi aberto e suporta uint8/int8.

Avaliação de velocidade

- Ferramenta de avaliação de velocidade básica da Benchmark, bem -vinda para atualizá -la.

Plugin NPU

- Guia do usuário do Tim-VX Verisilicon NPU.

Plug -in de autoconfiança

- O AutoKernel é uma ferramenta de otimização automática de otimização de operador automático simples e fácil de usar. O plug-in do AutoKernel implementa a implantação de um clique dos operadores de otimização automática no Tengine.

Recipiente

- A SuperEdge fornece uma solução de gerenciamento de negócios mais conveniente, com a ajuda do sistema de gerenciamento de contêineres de código aberto de computação SuperEdge;

- Como usar o Tengine com Guia de Uso do Contêiner de Superedes;

- Guia de geração de arquivos de dependência da demonstração do usuário de captura de vídeo.

Roteiro

Agradecimentos

Tengine Lite Referências e se baseia nos seguintes itens:

- Caffe

- Tensorflow

- Megengine

- ONNX

- ncnn

- Feathercnn

- Mnn

- Paddle Lite

- ACL

- stb

- convertmodel

- Tim-VX

- SuperEdge

Licença

Nota de esclarecimento

- [Função de relatórios on -line] O principal objetivo da função de relatório on -line é entender as informações de uso do Tengine. As informações são usadas para otimizar e iterar o Tengine e não afetarão nenhuma função normal. Esta função está ligada por padrão. Se você precisar desativá -lo, poderá modificar a opção de configuração seguinte para desativá -lo: (Cmakelists.txt) (Tengine_online_report "Relatório Online" OFF)

Perguntas frequentes

Discussão técnica