Documentation | Documentation chinoise

Chinois simplifié | Anglais

Tenance

Introduction

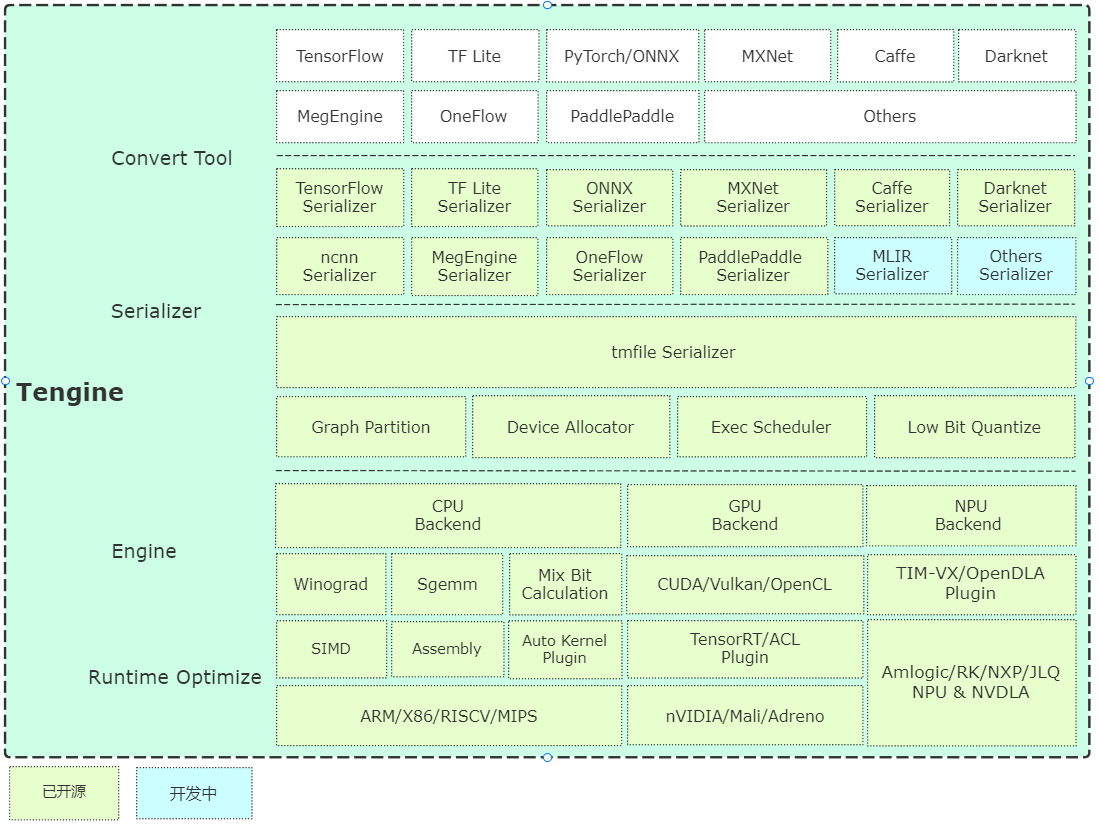

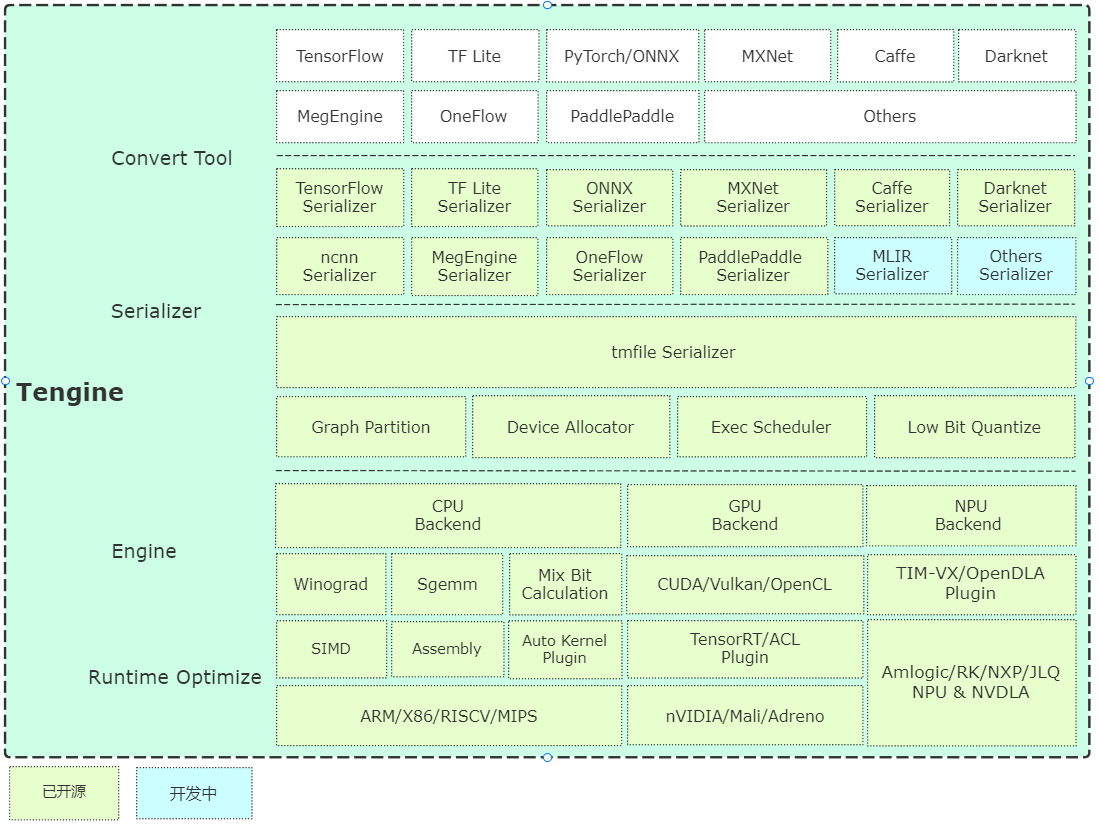

Tenne est dirigé par Open AI Lab , et le projet réalise la nécessité d'un déploiement rapide et efficace de modèles de réseau neuronal d'apprentissage en profondeur sur des appareils intégrés. Afin de réaliser un déploiement multiplateforme dans de nombreuses applications AIOT , ce projet utilise le langage C pour le développement de modules de base et effectue une coupe de cadre approfondie en fonction des ressources limitées des appareils intégrés. Dans le même temps, une conception frontale complètement distincte est adoptée, ce qui est propice au portage rapide et au déploiement d'unités informatiques hétérogènes telles que le CPU, le GPU et le NPU, réduisant le coût de l'évaluation et de la migration.

Le code de base de Tenine se compose de 4 modules:

- Dispositif : Module backend des opérateurs NN, CPU, GPU, codes de référence NPU sont fournis;

- Planificateur : les composants principaux du cadre, y compris le NNIR, le graphique informatique, les ressources matérielles et le module de planification et d'exécution de l'analyseur du modèle;

- Opérateur : Module frontal des opérateurs NN, implémente l'enregistrement et l'initialisation des opérateurs NN;

- Sérialiseur : analyseur modèle, implémente l'analyse des paramètres du modèle de réseau au format TMFile.

Brève analyse de l'architecture

Commencez rapidement

Compilation

- Une compilation rapide basée sur CMake, une compilation multiplateforme simple est implémentée.

Exemple

- Les exemples fournissent des cas d'utilisation de classification et de détection de base et de mettre à jour en permanence en fonction des exigences du problème.

- L'installation source fournit une installation de ligne de commande APT-GET et un essai du système Ubuntu et prend actuellement en charge le matériel X86 / A311D.

Modèle d'entrepôt

Outil de conversion

- Version précompilée: fournit des outils de conversion de modèle précompilé sur le système Ubuntu 18.04;

- Version de conversion en ligne: Basé sur l'implémentation WebAssembly (conversion locale du navigateur, le modèle ne sera pas téléchargé;

- Compilation de code source: il est recommandé de compiler sur le serveur ou le PC, les instructions sont les suivantes:

mkdir build && cd build

cmake -DTENGINE_BUILD_CONVERT_TOOL=ON ..

make -j`nproc`

Outils quantitatifs

- Compilation de code source: le code source de l'outil quantitatif a été ouvert et prend en charge Uint8 / int8.

Évaluation de la vitesse

- L'outil d'évaluation de la vitesse du réseau de Benchmark, bienvenue pour le mettre à jour.

Plugin NPU

- Guide de l'utilisateur NPU Tim-Vx VeriSilicon.

Plugin Autokernel

- Autokernel est un outil d'optimisation automatique de l'opérateur automatique simple et facile à utiliser. Le plugin Autokernel implémente le déploiement en un clic d'opérateurs d'optimisation automatique dans Tenine.

Récipient

- SuperEdge fournit une solution de gestion d'entreprise plus pratique à l'aide du système de gestion des conteneurs Open Source Superedge Edge;

- Comment utiliser Tenine avec un guide d'utilisation des conteneurs SuperEdge;

- Guide de génération de génération de fichiers de dépendance de la débondité des utilisateurs de capture vidéo.

Feuille de route

Remerciements

Tengine Lite fait référence et s'appuie sur les éléments suivants:

- Caffe

- Tensorflow

- Mégenine

- Onnx

- ncnn

- Feathercnn

- MNN

- Pagayer

- ACL

- STB

- convertmodel

- Tim-vx

- Super-pavillon

Licence

Note de clarification

- [Fonction de rapports en ligne] L'objectif principal de la fonction de rapport en ligne est de comprendre les informations d'utilisation de Tenine. Les informations sont utilisées pour optimiser et itérer le tenance et n'affecteront aucune fonction normale. Cette fonction est allumée par défaut. Si vous devez le désactiver, vous pouvez modifier la configuration suivante pour la désactiver: (Home Directory CMakelists.txt) Option (Tenne_online_Report "Rapport en ligne".

FAQ

Discussion technique