Dokumentation | Chinesische Dokumentation

Vereinfachtes Chinesisch | Englisch

Tengine

Einführung

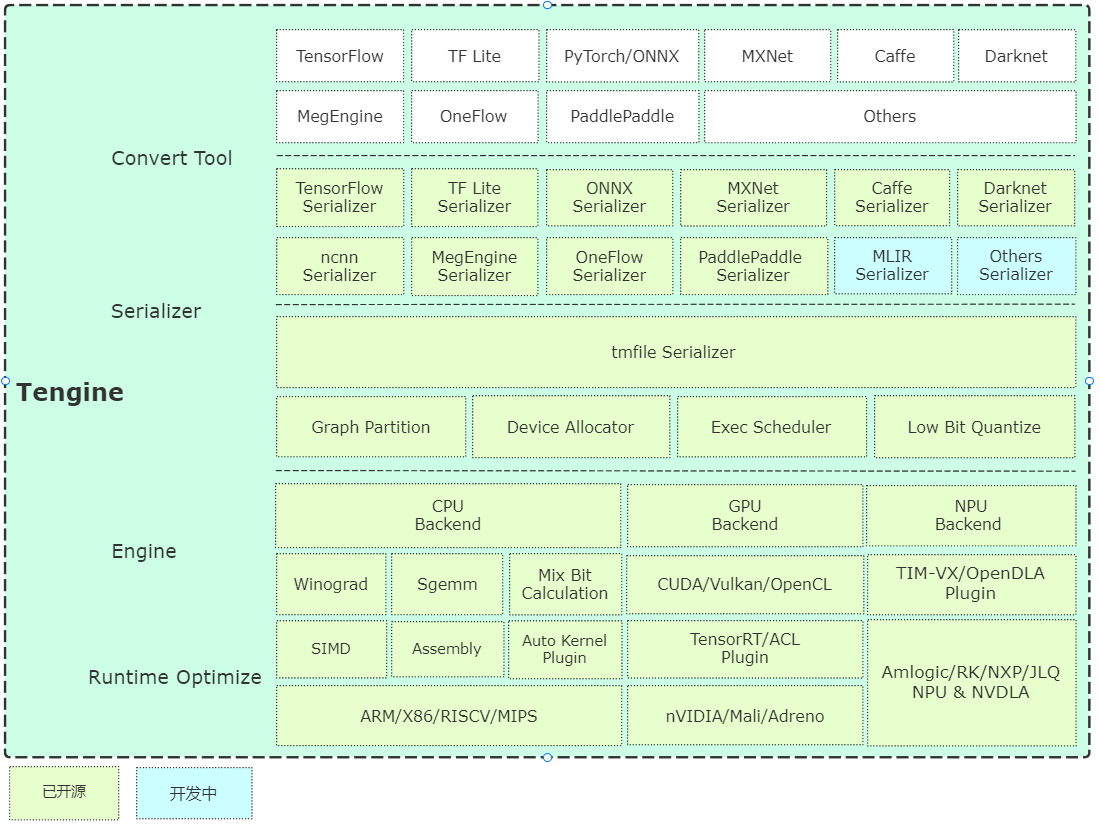

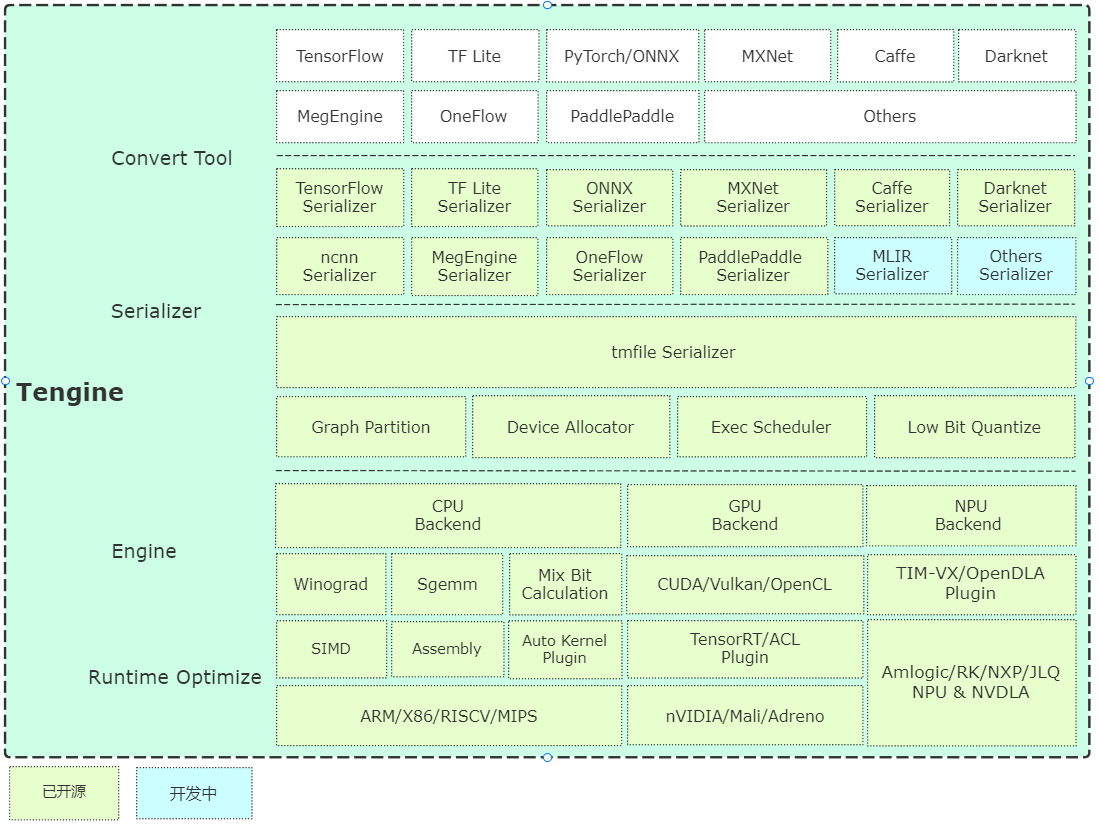

Tengine wird vom Open AI Lab geleitet, und das Projekt erkennt, dass eine schnelle und effiziente Bereitstellung von Deep -Learning -Modellen für neuronale Netzwerke auf eingebetteten Geräten erforderlich ist. Um die plattformübergreifende Bereitstellung in vielen AIOT- Anwendungen zu realisieren, verwendet dieses Projekt eine C-Sprache für die Entwicklung des Kernmoduls und führt ein detailliertes Rahmenabschneiden durch, basierend auf den begrenzten Ressourcen der eingebetteten Geräte. Gleichzeitig wird ein völlig separates Front-End-Design eingesetzt, das für die schnelle Portierung und Bereitstellung heterogener Computereinheiten wie CPU, GPU und NPU förderlich ist, wodurch die Kosten für die Bewertung und Migration gesenkt werden.

Der Tengine -Kerncode besteht aus 4 Modulen:

- Gerät : NN -Operatoren Backend -Modul, CPU, GPU, NPU -Referenzcodes werden bereitgestellt.

- Scheduler : Die Kernkomponenten des Frameworks, einschließlich NNIR, Computergrafik, Hardware -Ressourcen sowie das Planungs- und Ausführungsmodul des Modellparsers;

- Operator : NN-Operatoren Front-End-Modul, implementiert die Registrierung und Initialisierung der NN-Bediener;

- Serializer : Modellparser, implementiert die Analyse der Netzwerkmodellparameteranalyse im TMFile -Format.

Kurze Analyse der Architektur

Fangen Sie schnell an

Zusammenstellung

- Eine schnelle Zusammenstellung basierend auf CMake, einfache plattformübergreifende Zusammenstellung wird implementiert.

Beispiel

- Beispiele bieten grundlegende Klassifizierungs- und Erkennungsalgorithmus -Anwendungsfälle sowie kontinuierliche Aktualisierung gemäß den Problemanforderungen.

- Die Quellinstallation bietet eine APT-GET-Befehlszeileninstallation und die Versuch des Ubuntu-Systems und unterstützt derzeit X86/A311D-Hardware.

Modelllager

Conversion -Tool

- Vorkompilierte Version: Bietet vorkompilierte Modellkonvertierungstools auf Ubuntu 18.04 -System;

- Online -Conversion -Version: Basierend auf der Implementierung von WebAssembly (Browser Local Conversion, Modell wird nicht hochgeladen.

- Quellcode -Kompilierung: Es wird empfohlen, auf dem Server oder dem PC zu kompilieren. Die Anweisungen lauten wie folgt:

mkdir build && cd build

cmake -DTENGINE_BUILD_CONVERT_TOOL=ON ..

make -j`nproc`

Quantitative Werkzeuge

- Quellcode -Kompilierung: Der Quellcode des quantitativen Tools wurde geöffnet und unterstützt UINT8/INT8.

Geschwindigkeitsbewertung

- Benchmarks grundlegendes Tool für Netzwerkgeschwindigkeitsbewertung, willkommen, um es zu aktualisieren.

NPU -Plugin

- Tim-VX Verisilicon NPU-Benutzerhandbuch.

Autokernel -Plugin

- Autokernel ist ein einfaches und benutzerfreundliches automatisches Optimierungsinstrument mit geringem Schwellenwert. Das Autokernel-Plugin implementiert die Ein-Klick-Bereitstellung automatischer Optimierungsoperatoren in Tengine.

Container

- Superge bietet eine bequemere Geschäftsmanagementlösung mit Hilfe des Open -Source -Container -Managementsystems für Superge -Rande.

- So verwenden Sie Tengine mit Superge -Behälter -Verwendungshandbuch;

- Video -Capture -Benutzerhandbuch der Demo -Abhängigkeitsdateigenerierung.

Roadmap

Anerkennung

Tengine lite verweist und stützt sich auf die folgenden Elemente:

- Kaffe

- Tensorflow

- Megengine

- Onnx

- ncnn

- Feathercnn

- Mnn

- Paddel lite

- ACL

- stb

- CONVERTMODEL

- Tim-vx

- Superge

Lizenz

Klarstellungsnotiz

- [Online -Berichtsfunktion] Der Hauptzweck der Online -Berichtsfunktion besteht darin, die Nutzungsinformationen von Tengine zu verstehen. Die Informationen werden verwendet, um Tengine zu optimieren und zu iterieren, und wirkt sich nicht auf normale Funktionen aus. Diese Funktion ist standardmäßig eingeschaltet. Wenn Sie es ausschalten müssen, können Sie die folgende Konfiguration ändern, um sie auszuschalten: (Home -Verzeichnis cmakelists.txt) Option (Tengine_online_report "Online -Bericht" aus)

FAQ

Technische Diskussion