ドキュメント|中国のドキュメント

単純化された中国人|英語

Tengine

導入

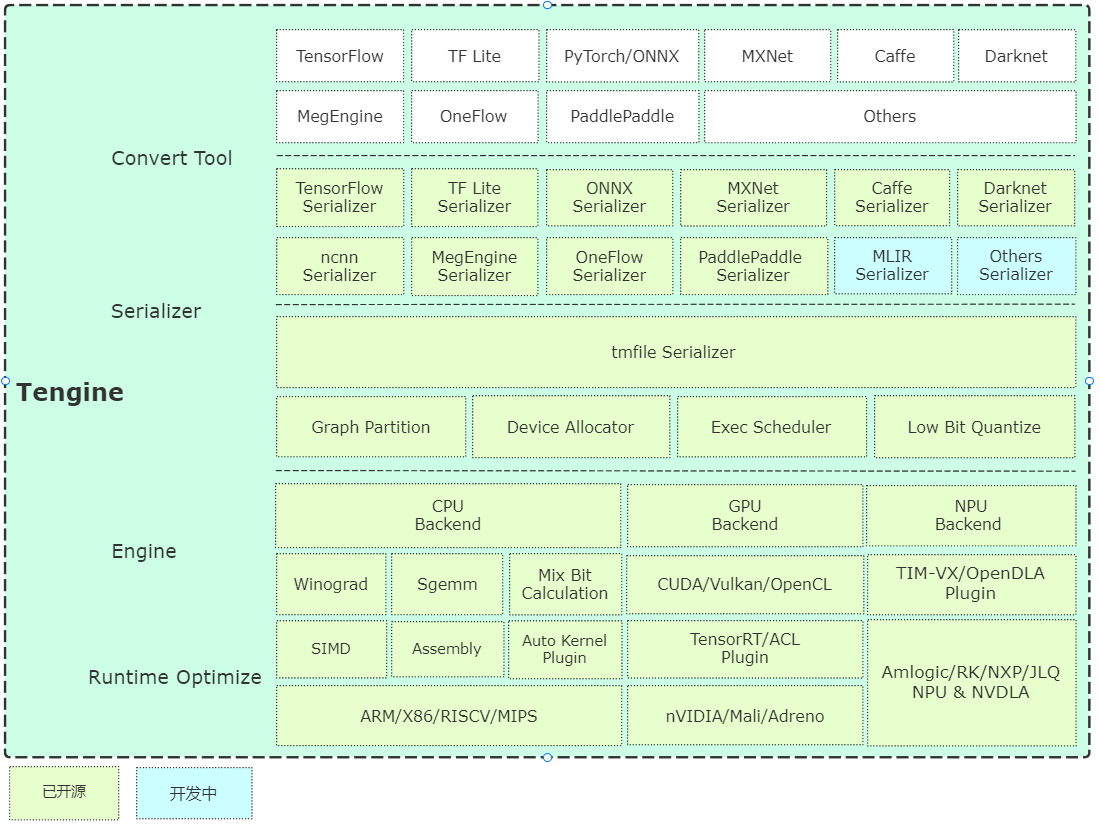

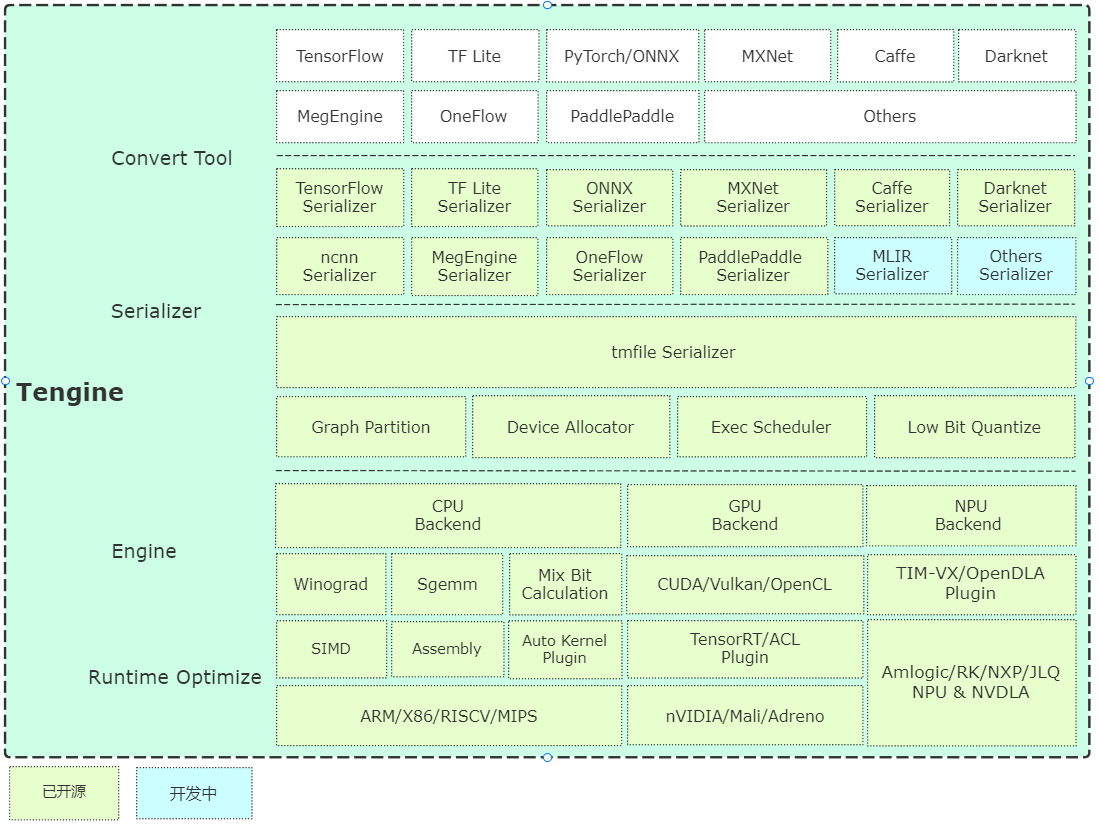

TengineはOpen AI Labが率いており、このプロジェクトは、組み込みデバイス上の深い学習ニューラルネットワークモデルの迅速かつ効率的な展開の必要性を認識しています。多くのAIOTアプリケーションでのクロスプラットフォームの展開を実現するために、このプロジェクトはコアモジュール開発にC言語を使用し、組み込みデバイスの限られたリソースに基づいて詳細なフレームワークカットを実施します。同時に、CPU、GPU、NPUなどの異種コンピューティングユニットの迅速な移植と展開を助長する完全に独立したフロントエンド設計が採用され、評価と移行のコストが削減されます。

Tengineコアコードは、4つのモジュールで構成されています。

- デバイス:NNオペレーターバックエンドモジュール、CPU、GPU、NPUリファレンスコードが提供されます。

- スケジューラ:NNIR、コンピューティンググラフ、ハードウェアリソース、モデルパーサーのスケジューリングおよび実行モジュールなど、フレームワークのコアコンポーネント。

- オペレーター:NNオペレーターのフロントエンドモジュール、NNオペレーターの登録と初期化を実装します。

- シリアイザー:モデルパーサー、TMFile形式のネットワークモデルパラメーター分析を実装します。

アーキテクチャの簡単な分析

すぐに始めましょう

編集

- Cmakeに基づくクイックコンパイル、シンプルなクロスプラットフォームコンパイルが実装されています。

例

- 例は、基本的な分類および検出アルゴリズムの使用ケースを提供し、問題の要件に従って継続的に更新されます。

- ソースインストールは、UbuntuシステムのAPT-Getコマンドラインのインストールと試行を提供し、現在X86/A311Dハードウェアをサポートしています。

モデルウェアハウス

変換ツール

- プリコンパイル済みバージョン:Ubuntu 18.04システムで事前コンパイルされたモデル変換ツールを提供します。

- オンライン変換バージョン:WebAssemblyの実装に基づいて(ブラウザローカル変換、モデルはアップロードされません。

- ソースコードコンパイル:サーバーまたはPCにコンパイルすることをお勧めします。指示は次のとおりです。

mkdir build && cd build

cmake -DTENGINE_BUILD_CONVERT_TOOL=ON ..

make -j`nproc`

定量的ツール

- ソースコードコンパイル:定量ツールのソースコードが開かれ、UINT8/INT8をサポートしています。

速度評価

- ベンチマークの基本的なネットワーク速度評価ツール、それを更新してください。

NPUプラグイン

- TIM-VX Verisilicon NPUユーザーガイド。

Autokernelプラグイン

- Autokernelは、シンプルで使いやすく、低閾値の自動演算子最適化ツールです。 AutoKernelプラグインは、自動最適化演算子のワンクリック展開をテンガインに実装します。

容器

- SuperEdgeは、SuperEdge Edge Computingのオープンソースコンテナ管理システムを使用して、より便利なビジネス管理ソリューションを提供します。

- スーパーエッジコンテナ使用ガイドでTengineを使用する方法。

- ビデオキャプチャユーザーマニュアルデモ依存関係ファイル生成ガイド。

ロードマップ

謝辞

Tengine Liteの参照と次の項目に描画します。

- カフェ

- Tensorflow

- メゲンギン

- onnx

- ncnn

- feathercnn

- MNN

- パドルライト

- ACL

- STB

- ConvertModel

- Tim-Vx

- スーパーエッジ

ライセンス

明確なメモ

- [オンライン報告機能]オンラインレポート機能の主な目的は、Tengineの使用情報を理解することです。この情報は、テンガインを最適化および反復するために使用され、通常の機能には影響しません。この関数はデフォルトでオンになっています。オフにする必要がある場合は、次の構成を変更してオフにすることができます。

よくある質問

技術的な議論