문서 | 중국어 문서

단순화 된 중국어 | 영어

Tengine

소개

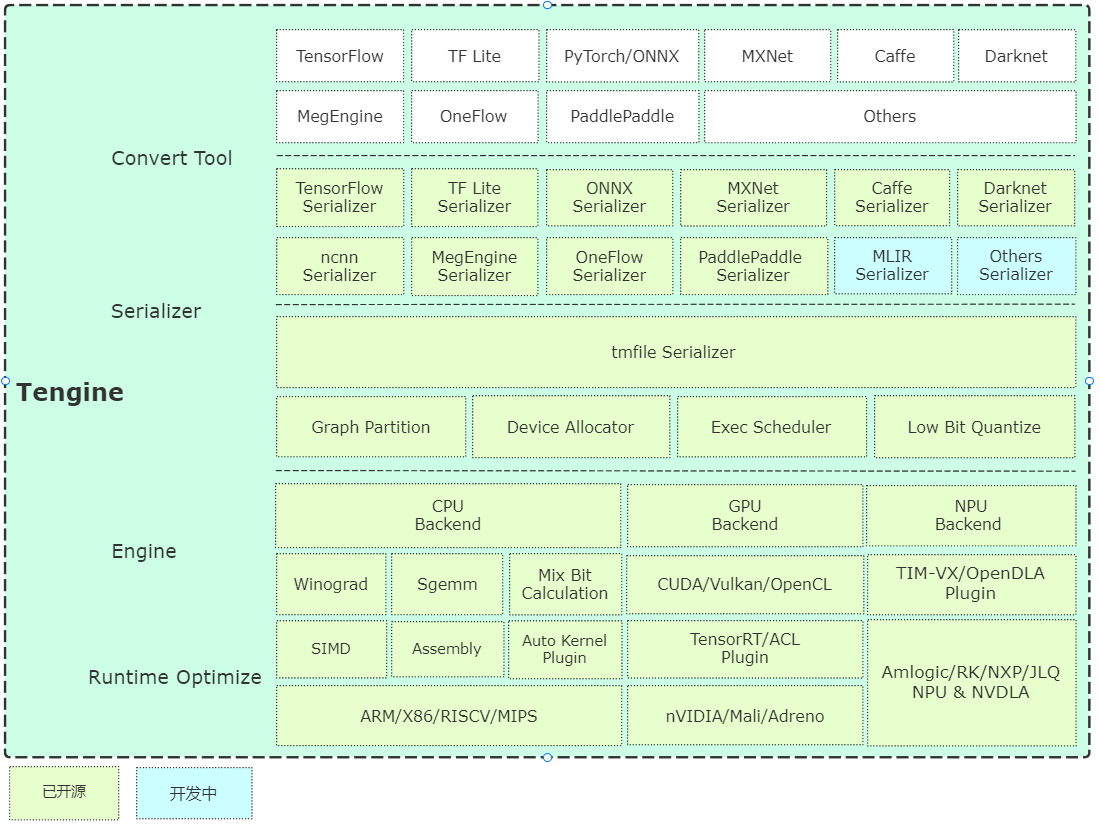

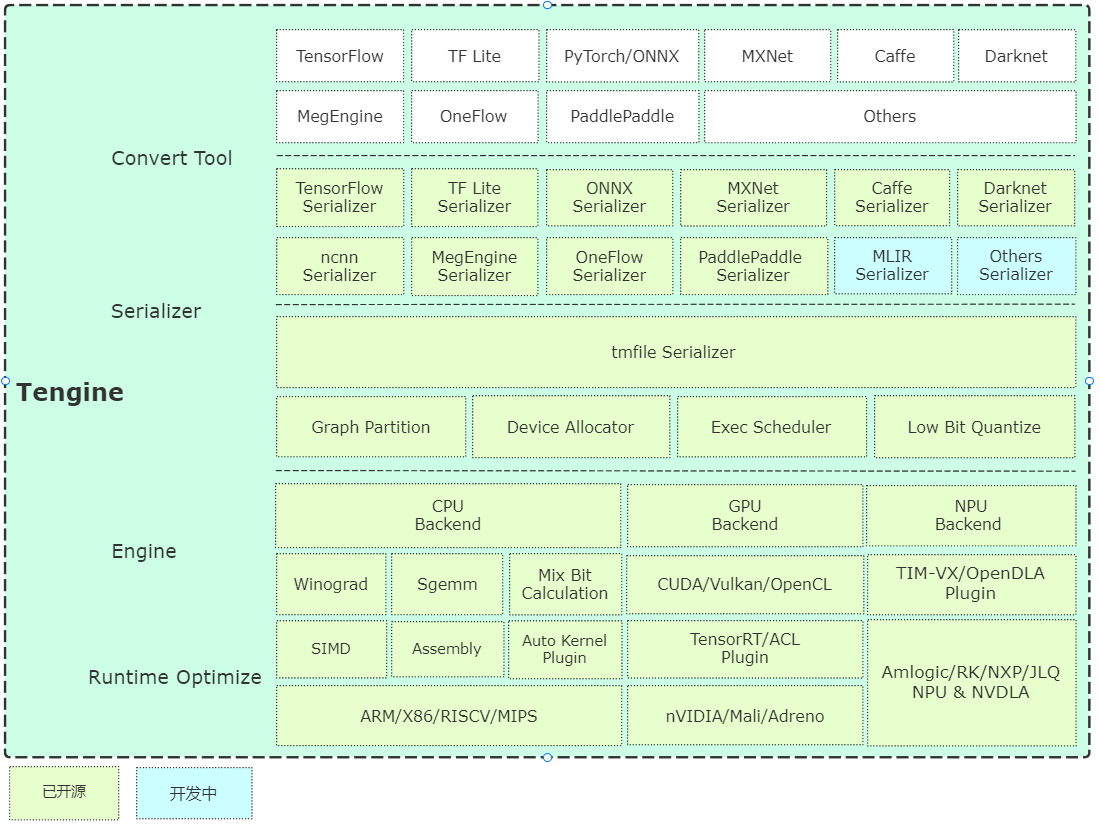

Tengine은 Open AI Lab 이 주도하며 프로젝트는 임베디드 장치에 딥 러닝 신경망 모델을 빠르고 효율적으로 배포해야 할 필요성을 인식합니다. 많은 AIOT 애플리케이션에서 크로스 플랫폼 배포를 실현하기 위해이 프로젝트는 핵심 모듈 개발에 C 언어를 사용하고 임베디드 장치의 제한된 리소스를 기반으로 심층적 인 프레임 워크 절단을 수행합니다. 동시에, 완전히 별도의 프론트 엔드 설계가 채택되며, 이는 CPU, GPU 및 NPU와 같은 이기종 컴퓨팅 장치의 빠른 포팅 및 배포에 도움이되어 평가 및 마이그레이션 비용을 줄입니다.

Tengine 핵심 코드는 4 개의 모듈로 구성됩니다.

- 장치 : NN 연산자 백엔드 모듈, CPU, GPU, NPU 참조 코드가 제공됩니다.

- 스케줄러 : NNIR, 컴퓨팅 그래프, 하드웨어 리소스 및 모델 파서의 스케줄링 및 실행 모듈을 포함한 프레임 워크의 핵심 구성 요소;

- 연산자 : NN 운영자 프론트 엔드 모듈, NN 운영자 등록 및 초기화를 구현합니다.

- SERIALIZER : 모델 파서, TMFILE 형식의 네트워크 모델 매개 변수 분석을 구현합니다.

건축에 대한 간단한 분석

빨리 시작하십시오

편집

- CMAKE를 기반으로 한 빠른 컴파일, 간단한 크로스 플랫폼 컴파일이 구현됩니다.

예

- 예제는 기본 분류 및 탐지 알고리즘 사용 사례를 제공하고 이슈 요구 사항에 따라 지속적으로 업데이트됩니다.

- 소스 설치는 Ubuntu 시스템의 APT-GET 명령 줄 설치 및 시험을 제공하며 현재 X86/A311D 하드웨어를 지원합니다.

모델 창고

변환 도구

- 사전 컴파일 버전 : Ubuntu 18.04 시스템에서 사전 컴파일 된 모델 변환 도구를 제공합니다.

- 온라인 변환 버전 : WebAssembly 구현을 기반으로 (브라우저 로컬 변환, 모델이 업로드되지 않습니다.

- 소스 코드 컴파일 : 서버 또는 PC에서 컴파일하는 것이 좋습니다. 지침은 다음과 같습니다.

mkdir build && cd build

cmake -DTENGINE_BUILD_CONVERT_TOOL=ON ..

make -j`nproc`

정량적 도구

- 소스 코드 컴파일 : 정량적 도구의 소스 코드가 열리고 UINT8/int8을 지원합니다.

속도 평가

- Benchmark의 기본 네트워크 속도 평가 도구, 업데이트에 오신 것을 환영합니다.

NPU 플러그인

- TIM-VX Verisilicon NPU 사용자 안내서.

오토킹 플러그인

- AutoKernel은 간단하고 사용하기 쉬운 저격 해지 자동 운영자 최적화 도구입니다. AutoKernel 플러그인은 자동 최적화 연산자를 Tengine에 클릭 한 번 클릭하는 것을 구현합니다.

컨테이너

- Superedge는 SuperEdge Edge 컴퓨팅 오픈 소스 컨테이너 관리 시스템의 도움으로보다 편리한 비즈니스 관리 솔루션을 제공합니다.

- Superedge 컨테이너 사용 안내서와 함께 Tengine 사용 방법;

- 비디오 캡처 사용자 설명서 데모 종속성 파일 생성 안내서.

로드맵

감사의 말

Tengine Lite 참조 및 다음 항목에 대한 참조 및 그려옵니다.

- 카페

- 텐서 플로

- 메가 겐 (Megengine)

- onx

- NCNN

- 깃털이

- MNN

- 패들 라이트

- ACL

- STB

- 변환 모델

- Tim-VX

- 슈퍼 지

특허

설명 참고

- [온라인보고 기능] 온라인보고 기능의 주요 목적은 Tengine의 사용 정보를 이해하는 것입니다. 이 정보는 Tengine을 최적화하고 반복하는 데 사용되며 일반적인 기능에는 영향을 미치지 않습니다. 이 기능은 기본적으로 켜져 있습니다. 전원을 끄려면 다음 구성을 수정하여 다음 구성을 끄십시오.

FAQ

기술 토론