Documentación | Documentación china

Chino simplificado | Inglés

Moneda

Introducción

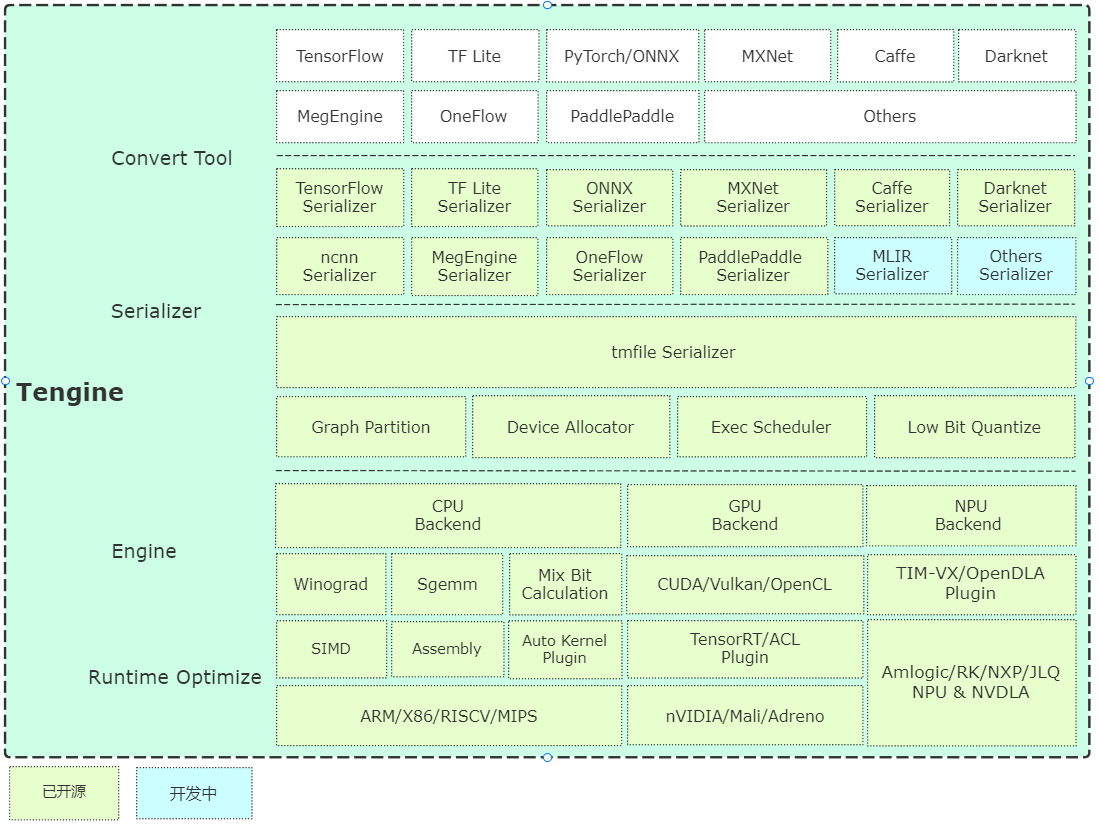

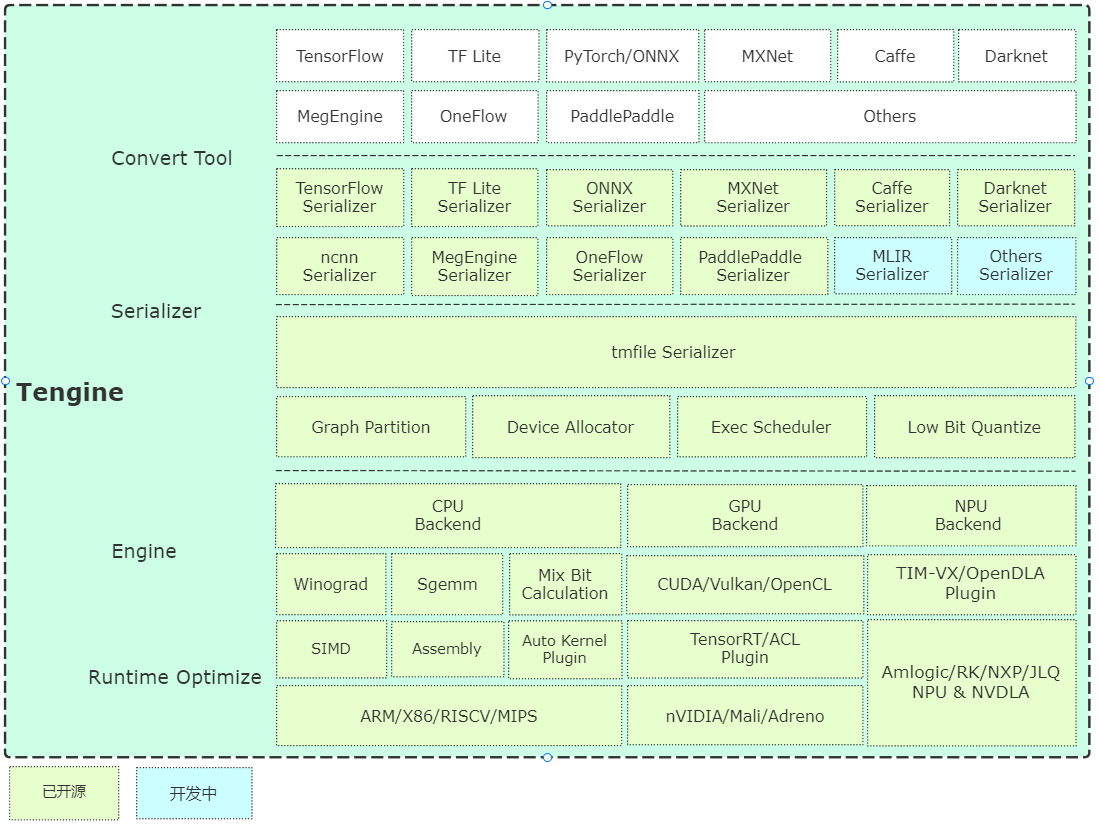

Tengine está dirigido por Open AI Lab , y el proyecto se da cuenta de la necesidad de una implementación rápida y eficiente de modelos de redes neuronales de aprendizaje profundo en dispositivos integrados. Para realizar la implementación multiplataforma en muchas aplicaciones AIOT , este proyecto utiliza el lenguaje C para el desarrollo del módulo central y realiza un corte marco en profundidad en función de los recursos limitados de los dispositivos integrados. Al mismo tiempo, se adopta un diseño frontal completamente separado, que conduce a la rápida portada y el despliegue de unidades informáticas heterogéneas como CPU, GPU y NPU, lo que reduce el costo de la evaluación y la migración.

El código de núcleo de Tengine consta de 4 módulos:

- Dispositivo : se proporcionan los códigos de referencia de los operadores NN, CPU, GPU, NPU;

- Programador : los componentes centrales del marco, incluidos NNIR, el gráfico de computación, los recursos de hardware y el módulo de programación y ejecución del analizador modelo;

- Operador : Módulo frontal de operadores NN, implementa el registro e inicialización de los operadores NN;

- Serializador : analizador modelo, implementa el análisis de parámetros del modelo de red en formato TMFILE.

Breve análisis de la arquitectura

Empiece a comenzar rápidamente

Compilación

- Se implementa una compilación rápida basada en CMake, se implementa una compilación simple de multiplataforma.

Ejemplo

- Los ejemplos proporcionan casos básicos de uso de algoritmo de clasificación y detección, y actualizan continuamente de acuerdo con los requisitos de los problemas.

- La instalación de origen proporciona instalación de línea de comandos apt-get y prueba del sistema Ubuntu, y actualmente admite hardware X86/A311D.

Modelo de almacén

Herramienta de conversión

- Versión precompilada: proporciona herramientas de conversión de modelo precompiladas en el sistema Ubuntu 18.04;

- Versión de conversión en línea: según la implementación de WebAssembly (la conversión local del navegador, el modelo no se cargará;

- Compilación del código fuente: se recomienda compilar en el servidor o la PC, las instrucciones son las siguientes:

mkdir build && cd build

cmake -DTENGINE_BUILD_CONVERT_TOOL=ON ..

make -j`nproc`

Herramientas cuantitativas

- Compilación del código fuente: el código fuente de la herramienta cuantitativa se ha abierto y admite UINT8/INT8.

Evaluación de velocidad

- La herramienta de evaluación de velocidad de red básica de Benchmark, bienvenido a actualizarla.

Complemento NPU

- Guía del usuario de TIM-VX VeriSilicon NPU.

Complemento de autokernel

- AutoKernel es una herramienta de optimización automática de operadores automático simple y fácil de usar. El complemento AutoKernel implementa la implementación de un solo clic de operadores de optimización automática en Tengine.

Recipiente

- SuperEdge proporciona una solución de gestión empresarial más conveniente con la ayuda del sistema de gestión de contenedores de código abierto de SuperEdge Edge Computing;

- Cómo usar la guía de uso de contenedores de tengine con superedge;

- Guía de generación de archivos de dependencia de la dependencia del usuario de captura del usuario de video.

Hoja de ruta

Expresiones de gratitud

Tengine Lite References y dibuja los siguientes elementos:

- Cafetería

- Flujo tensor

- Meggine

- ONNX

- ncnn

- Pluma

- MNN

- Paddle Lite

- LCA

- stb

- convertirmodelo

- Tim-VX

- Superengo

Licencia

Nota de aclaración

- [Función de informes en línea] El objetivo principal de la función de informes en línea es comprender la información de uso de Tengine. La información se utiliza para optimizar e iterar el tengine y no afectará ninguna función normal. Esta función está activada por defecto. Si necesita apagarlo, puede modificar la siguiente configuración para apagarla: (Directorio de inicio CMAKELISTS.TXT) Opción (tengine_online_report "Informe en línea" apagado)

Preguntas frecuentes

- Preguntas frecuentes para preguntas frecuentes

Discusión técnica