ビッグモデルデータアシスタント

?プロジェクトの紹介

軽量でフルリンクで、二次開発が簡単な大規模アプリケーションプロジェクト

Vue3、TypeScript、およびVite 5を使用して最新のUIを作成するDify、Ollama&Vllm、Sanic、Text2SQLなどのテクノロジーに基づいたワンストップのビッグモデルアプリケーション開発プロジェクト。 Echartsを介した大規模なモデルに基づいたグラフィカルデータの回答をサポートし、CSVファイルのテーブルの質問と回答を処理する機能を備えています。同時に、幅広い一般的な知識の質問と回答をサポートするために、サードパーティのオープンソースRAGシステム検索システムなどに接続するのが便利です。

Sanic-Webは、軽量のビッグモデルアプリケーション開発プロジェクトとして、迅速な反復と拡張をサポートし、大きなモデルプロジェクトが迅速に実装できるようにします。

?ライブデモ

オンラインエクスペリエンスが発売されようとしているので、お楽しみに!

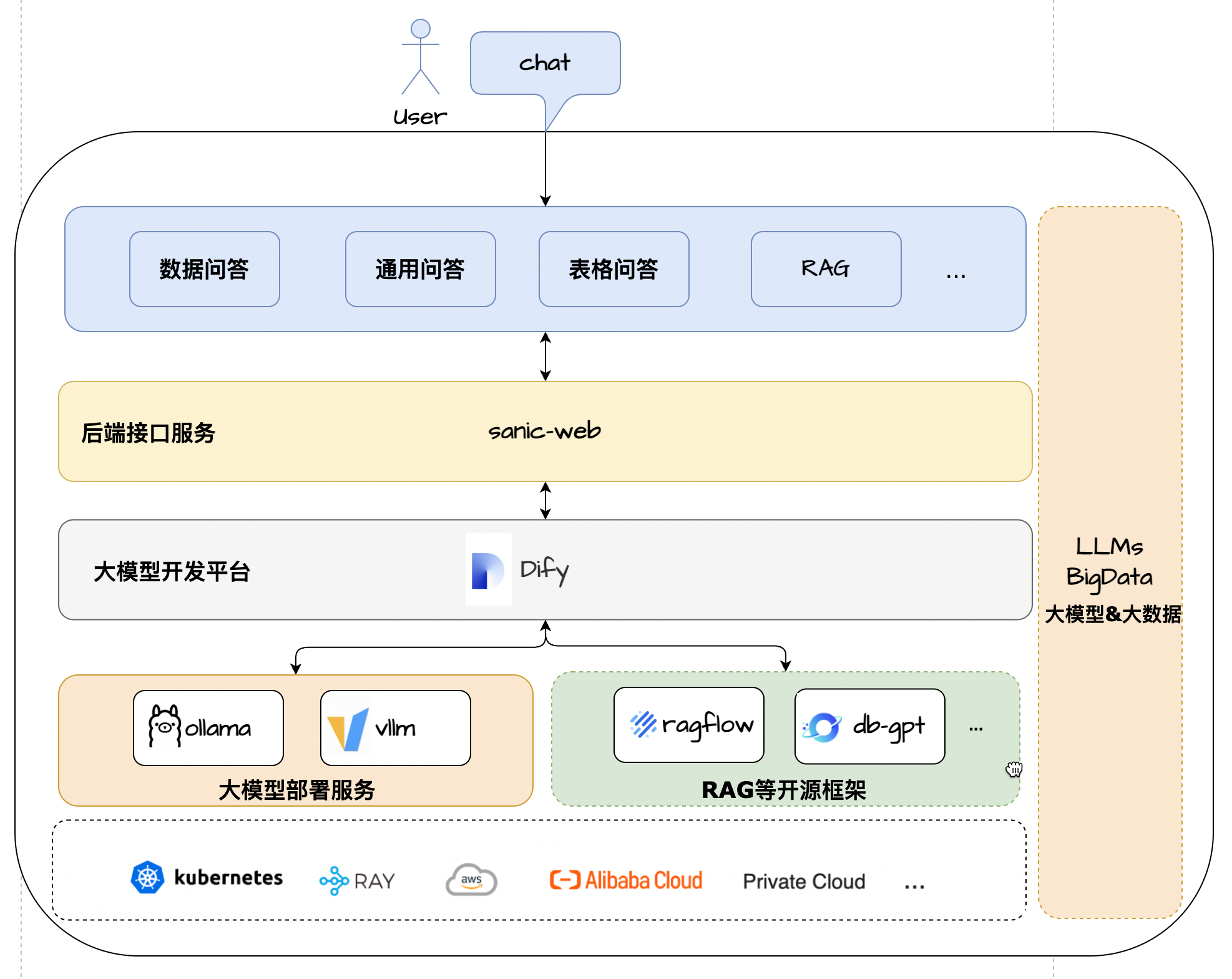

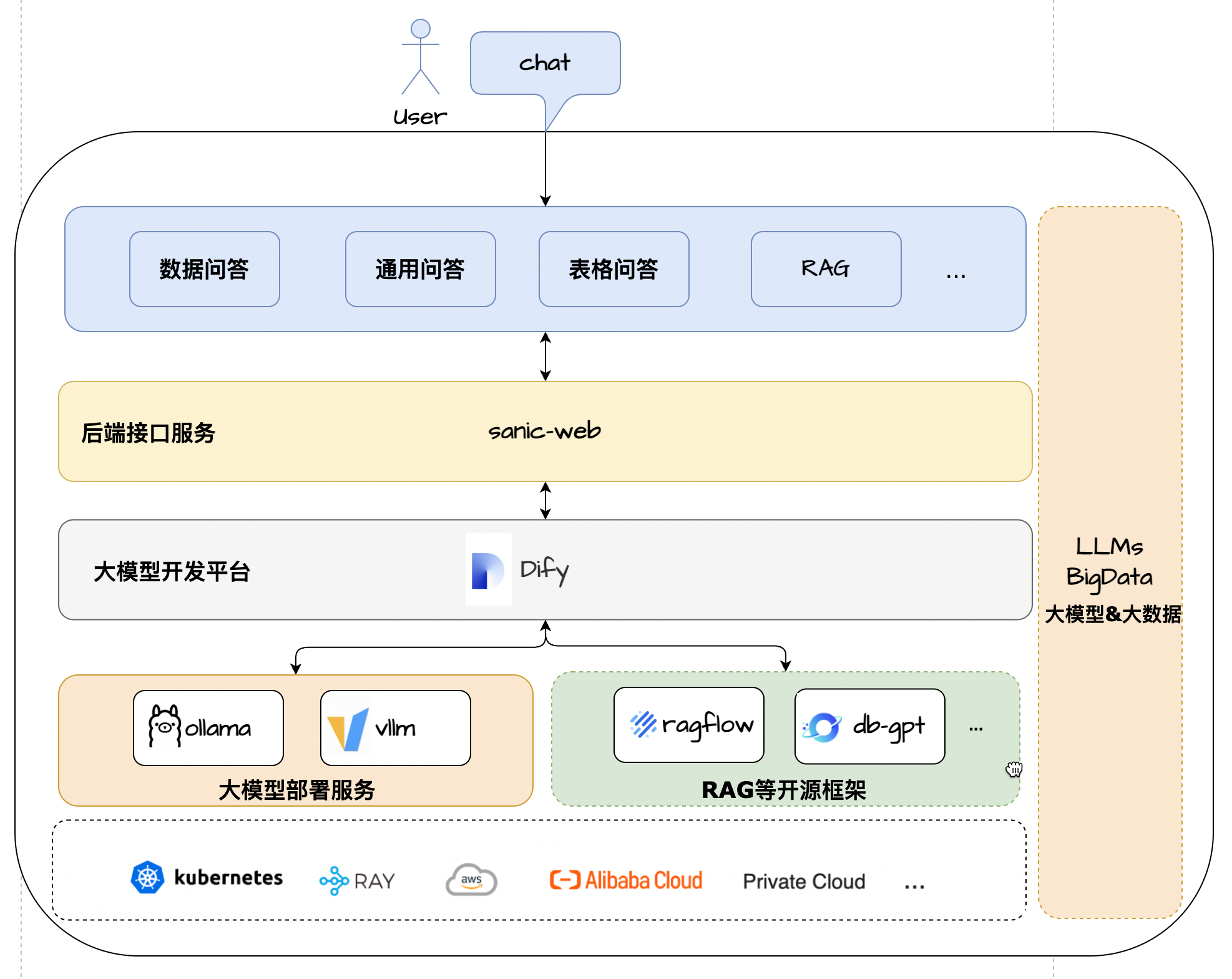

アーキテクチャソリューション

?特性

- コアテクノロジースタック:dify + ollama + rag + llm + text2sql

- UIフレームワーク:Vue 3 + TypeScript + Vite 5

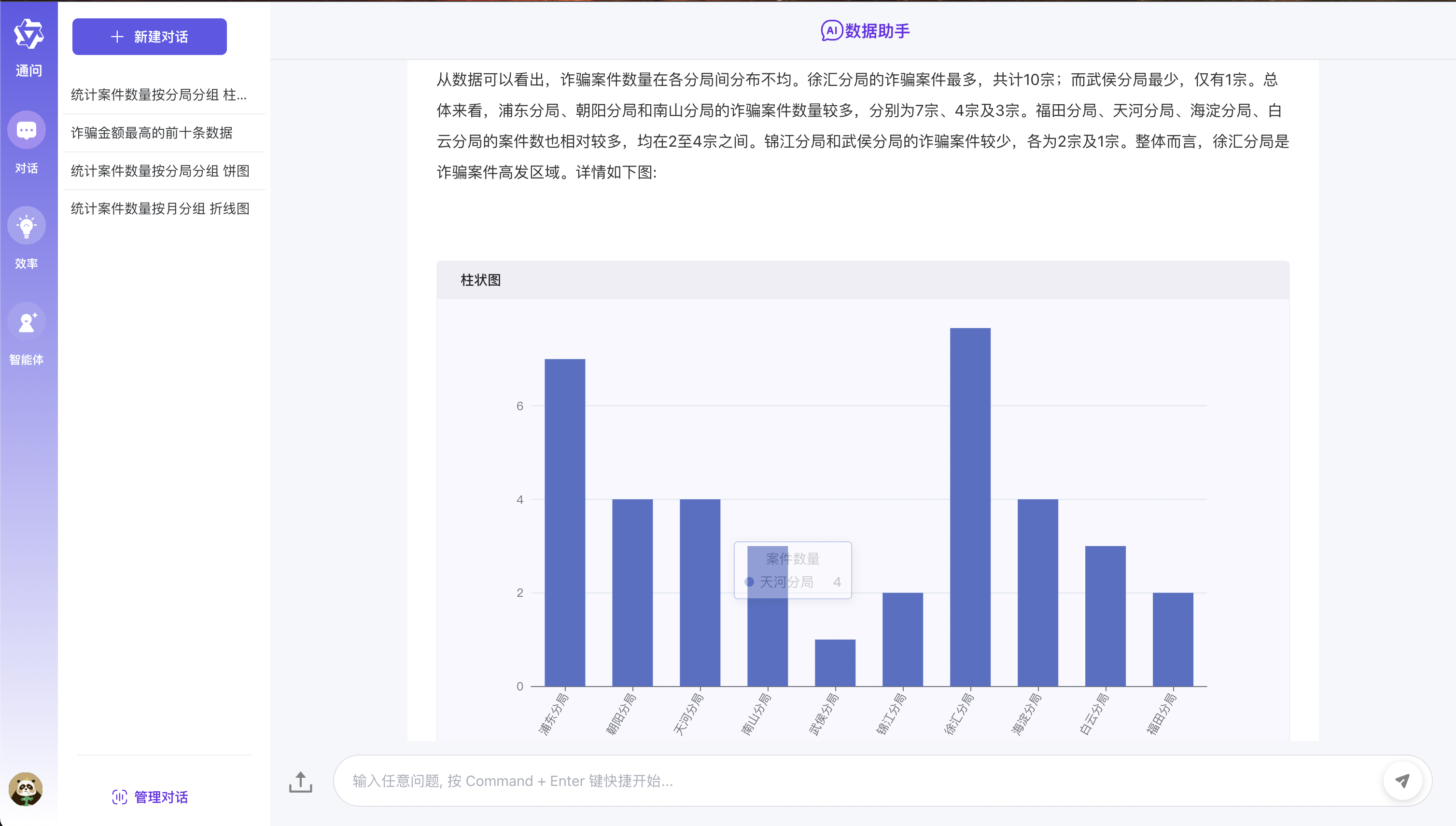

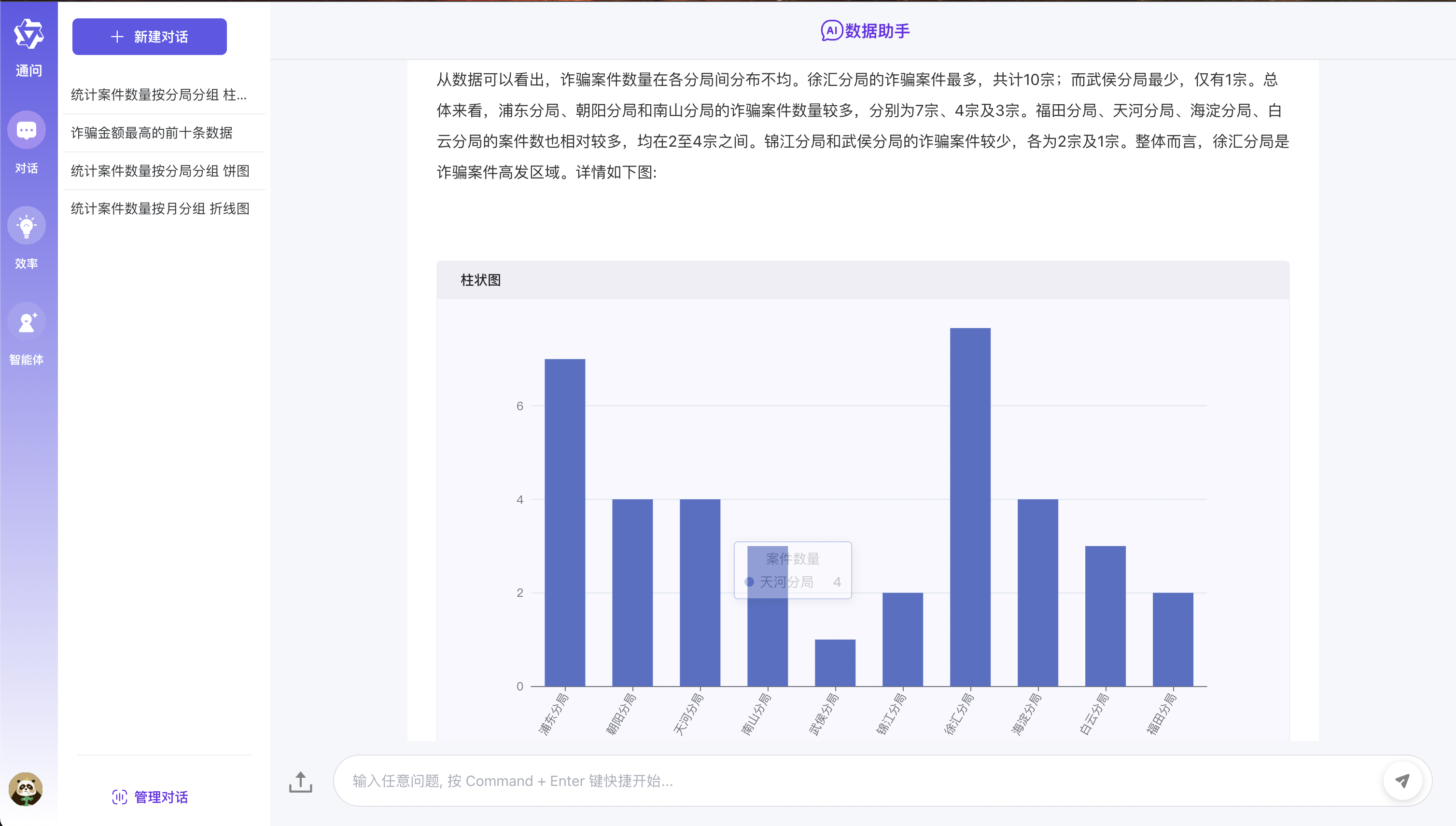

- データQ&A :統合されたeChartsモデルテキスト2SQL軽量グラフィカルデータQ&Aディスプレイを実現

- 表Q&A :CSV形式ファイルのアップロードと、大きなモデルの概要とText2SQLテーブルデータQ&Aに基づく前処理をサポートしています

- 一般Q&A :3つのパーティRAGシステム +パブリックネットワーク検索モードのドッキングに基づいて、一般的なデータフォームQ&Aをサポートします

- アプリケーションアーキテクチャ:軽量のフルリンクとして、ワンススケールモデルアプリケーション開発フレームワーク、便利な拡張と実装として

- 柔軟な展開:さまざまなコンポーネントの大規模なアプリケーション開発依存関係をサポートしますDocker-Composeをワンクリックしてゼロ構成をすばやく展開する

ランニング効果

環境構成要件

開始する前に、開発環境が次の最小構成要件を満たしていることを確認してください。

- オペレーティングシステム:Windows 10/11、Macos Mシリーズ、Centos/Ubuntu

- GPU :Ollamaを使用してローカルに展開すると、NVIDIAグラフィックスカードまたはCPUモードを使用することをお勧めします。

- メモリ:8GB+

?事前条件

- Python 3.8+

- 詩1.8.3+

- dify 0.7.1+

- mysql 8.0+

- node.js 18.12.x+

- PNPM 9.x

大規模なモデル展開

- Ollamaの展開を参照してください

- モデル:QWEN2.5

Dify環境構成

プロジェクトスクリプトを使用して、デフォルトでDifyをインストールします

- 初めて大きなモデルアプリケーションにさらされた学生を考慮に入れるために、このプロジェクトはワンクリックDifyサービスゼロ構成を提供し、また誰もが迅速に体験できるように促進するサービス方法を開始します。

- DIFYローカルアクセスアドレス:http:// localhostアカウント:[email protected]パスワード:admin123

# 拉起内置的dify服务

cd docker/dify/docker

docker-compose up -d

Dify環境がインストールされている場合

- 既にdify環境がある場合は、この場合のソースコードをローカルに変更して、サービスを開始することができます!!!

- 最初のステップは、プロジェクトのルートディレクトリにDocker/Dify/Data Q&Aを直接インポートすることです。

- 2番目のステップは、ソースコードDifyAppenum enumのデータベース_QAキーを変更することです(キーはDiifyプロセスキャンバスから取得されます)

- 3番目のステップは、プロジェクトルートディレクトリの.ENVファイルを変更し、環境に応じて実際のDify Rest Serviceインターフェイスアドレスを変更することです。

- ステップ4 difyキャンバスのhttprequest構成を変更し、URLアドレスを特定のSANIC-WEBサービスアドレスに変更します

Difyの最新バージョンをインストールします

- Difyの最新バージョンをインストールする必要がある場合は、公式ドキュメントDify公式ドキュメントを参照できます。

簡単な体験

- 特定の手順は次のとおりです。

- 最初のステップは、コードをローカルエリアにクローンすることです

- 2番目のステップは、上記の大きなモデルの展開を参照することです。最初にOllamaをインストールして、QWEN2.5モデルを展開します。

- 3番目のステップは、上記のDify環境構成のDify環境構成を直接参照することです。最初のケースでは、[デフォルトでDifyをインストールするためにプロジェクトスクリプトを使用して]非常に重要です!!!

- 4番目のステップでサービスを開始するための特定のステップは次のとおりです。

- リポジトリのクローニング

git clone https://github.com/apconw/sanic-web.git

- サービスを開始します

# 拉起前后端服务和中间件

cd docker

docker compose up -d

- データの初期化

cd docker

./init.sh

或执行

cd docker

python3 ../common/initialize_mysql.py

- アクセスサービス

- フロントエンドサービス:http:// localhost:8081

ローカル開発

- 最初のステップは、コードをローカルエリアにクローンすることです

- 2番目のステップは、上記の大きなモデルの展開を参照することです。最初にOllamaをインストールして、QWEN2.5モデルを展開します。

- 3番目のステップは、ローカル開発環境Dify環境を構成することです。上記のdify環境構成を参照してください。自分で最初または2番目の状況を選択できます。

- ステップ4:プロジェクトルートディレクトリで.ENVファイルを編集し、 env = dev、およびデータベース構成情報を変更します。

- ステップ5:フロントエンドとバックエンドのプロジェクトの依存関係をインストールし、フロントエンドおよびバックエンドサービスを開始します。特定の手順は次のとおりです。

- バックエンド依存関係のインストール

# 安装poetry

pip install poetry

# 安装依赖根目录执行

# 设置国内仓库

poetry source add --priority=default mirrors https://pypi.tuna.tsinghua.edu.cn/simple/

poetry install

- データベースをインストールします

docker run --name mysql-local

-p 13006:3306

-v /Users/lihuan/docker-mount/mysql:/var/lib/mysql

-e MYSQL_ROOT_PASSWORD=1

-d mysql:latest

- データベースを初期化します

- ローカル環境MYSQLを使用する場合、データを初期化するときにソースコードinitialize_mysqlを変更し、データベース接続情報を変更する必要があります。

cd docker

./init.sh

或执行

cd docker

python3 ../common/initialize_mysql.py

フロントエンドの依存関係のインストール

- フロントエンドは、オープンソースプロジェクトに基づいています。 ChatGpt-Vue3-Light-MVPを参照して、2番目のオープニングをインストールできます。

# 安装前端依赖&启动服务

cd web

#安装依赖

npm install -g pnpm

pnpm i

#启动服务

pnpm dev

バックエンドサービスを開始します

アクセスサービス

- フロントエンドサービス:http:// localhost:2048

?ミラーを構築します

- Project Root Directoryで.ENVファイルを編集し、 Env =テストを変更し、保存します。

- ビルドコマンドを実行します。

# 构建前端镜像

make web-build

# 构建后端镜像

make server-build

?サポート

このプロジェクトが気に入ったり、便利なプロジェクトを見つけた場合は、右上隅のStarをクリックしてサポートできます。あなたのサポートは継続的な改善の原動力です、ありがとう! ^_^

このプロジェクトが役立つ場合、または私たちがしていることが気に入った場合は、右上隅の[€]ボタンをクリックして私たちをサポートしてください!あなたのすべてのスターは私たちにとって大きな励ましであり、私たちの継続的な改善と開発の原動力でもあります。ご支援ありがとうございます! ^_^

さらに、提案がある場合、またはプロジェクトの開発に参加したい場合は、次の方法でお問い合わせください。

- 問題を送信- 問題を見つけたり、改善のための提案がある場合は、問題で提出できます。

- ディスカッションに参加してください- ディスカッショングループに追加してコミュニケーションとディスカッションを行うことができます。ディスカッションに参加します。

- 貢献コード- コードの貢献に興味がある場合は、貢献ガイドを参照できます。

あなたのサポートをありがとう!

QA通信グループ

- Big Model Application Exchange Groupへようこそ、グループに参加して経験について話し合い、共有することを歓迎します

- 以下の公式アカウントに従って、 WeChatグループメニューをクリックしてWeChatを追加してグループに参加します

| WeChat Group |

|---|

|

ライセンス

MITライセンス| Copyright©2024-Present aiadventurer