Assistant de données Big Model

? Introduction du projet

Un projet d'application à grande échelle léger, complet et facile à développer le développement secondaire

Un projet de développement d'applications à guichet unique à guichet unique construit sur des technologies telles que Dify, Olllama & Vllm, Sanic et Text2SQL, en utilisant Vue3, TypeScript et Vite 5 pour créer une interface utilisateur moderne. Il prend en charge les réponses des données graphiques basées sur de grands modèles via Echarts ?, et a la capacité de traiter les questions et réponses de la table de fichiers CSV. Dans le même temps, il peut être pratique de se connecter à des systèmes de récupération de chiffres de chiffon en open source tiers, etc. pour soutenir un large éventail de questions et réponses générales de connaissances.

En tant que projet de développement d'applications de gros modèles légers, Sanic-Web prend en charge l'itération et l'expansion rapides, aidant les grands projets de modèle à les mettre en œuvre rapidement.

? Démo en direct

L'expérience en ligne est sur le point d'être lancée, alors restez à l'écoute!

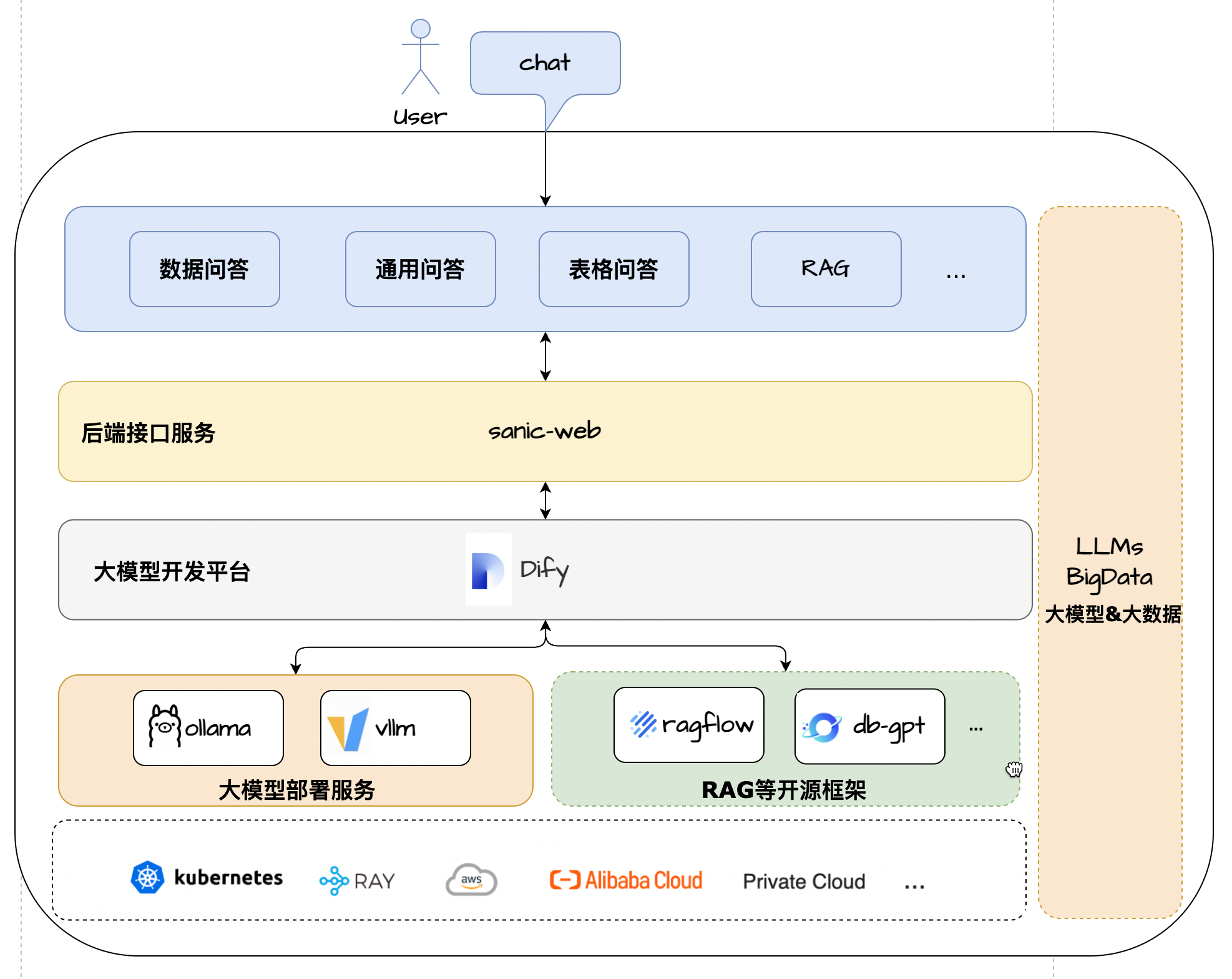

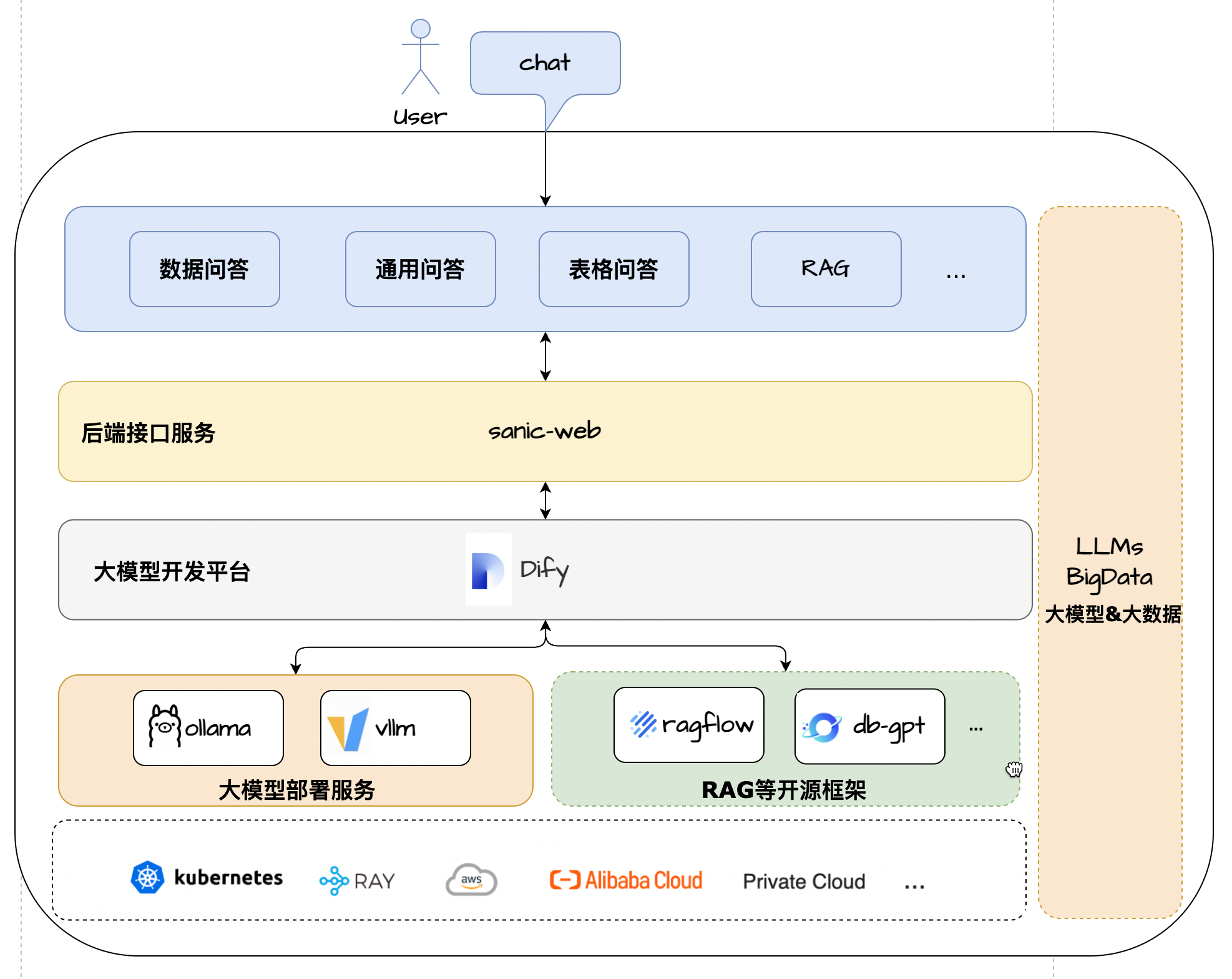

Solution d'architecture

? caractéristiques

- Core Technology Stack : Dify + Olllama + Rag + LLM + Text2SQL

- Cadre d'interface utilisateur : Vue 3 + TypeScript + Vite 5

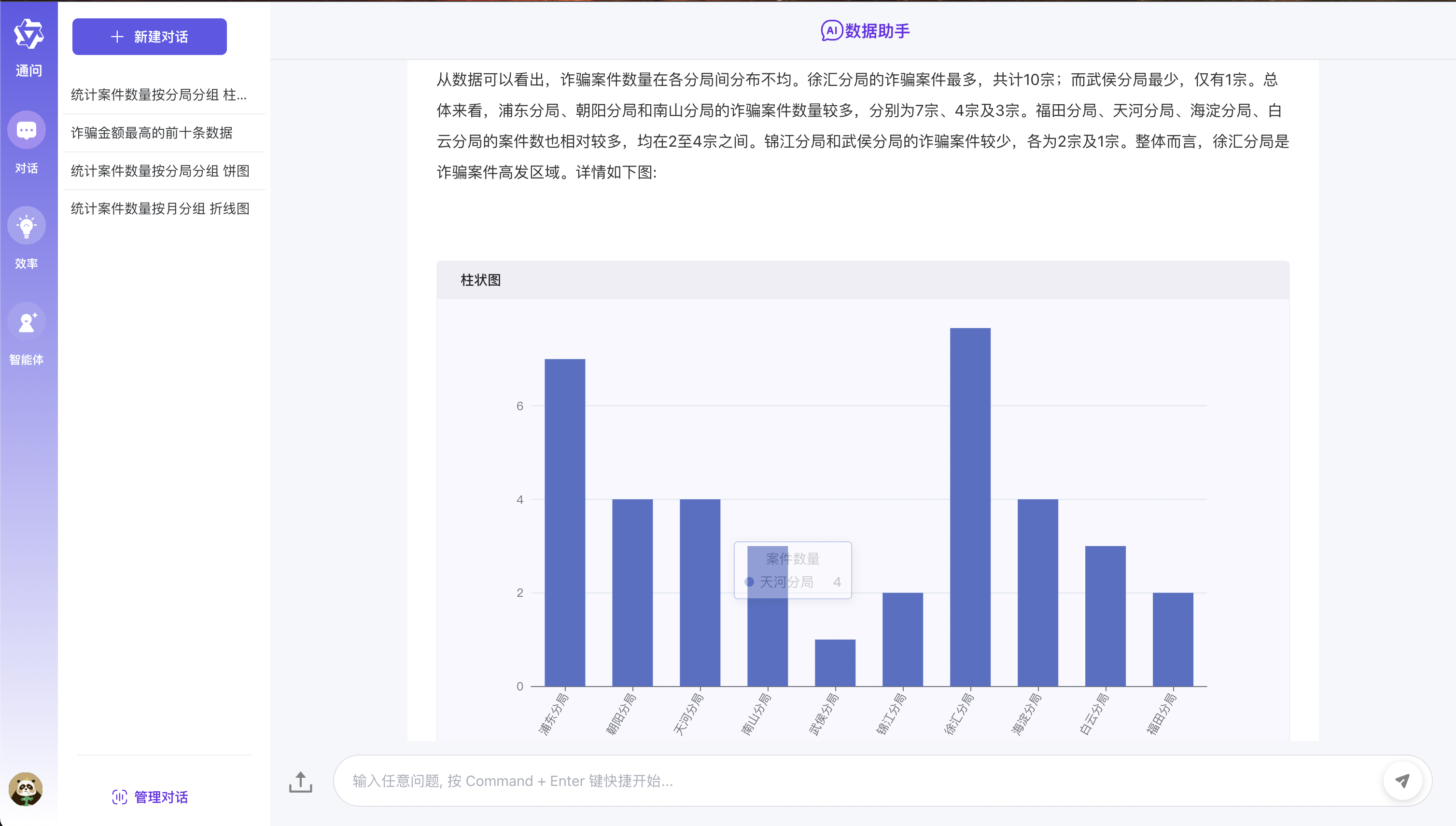

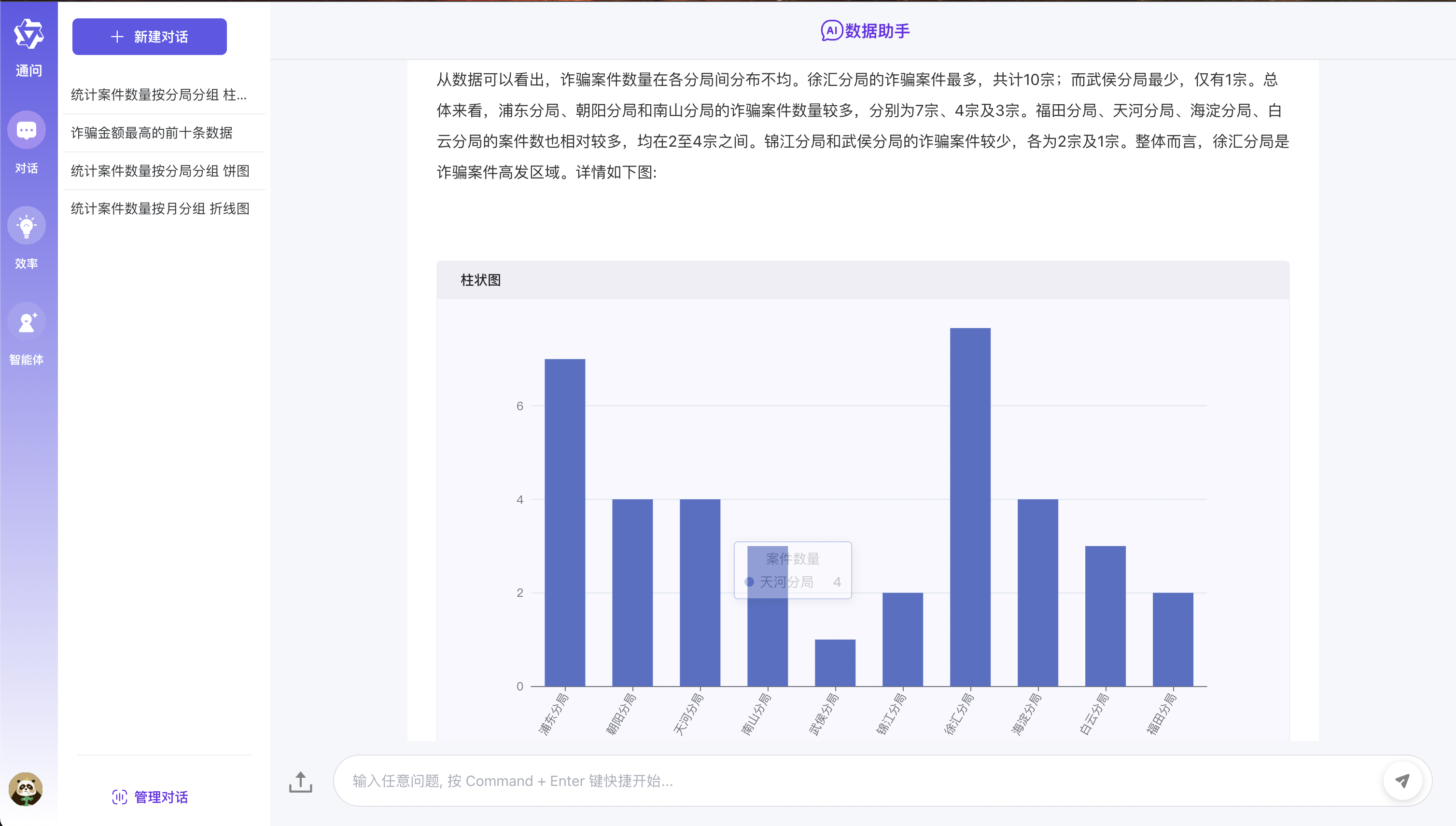

- Données Q&R : Modèle Echarts intégré pour réaliser l'écran de données graphiques légères Text2SQL Affichage

- Tableau Q&R : prend en charge le téléchargement des fichiers de format CSV et le prétraitement basé sur le résumé du grand modèle et les données de données de table text2sql

- Q&R Général : prend en charge le formulaire de données générales Q&R Basé sur l'amarrage du système de chiffon à trois partis + mode de récupération de réseau public

- Architecture des applications : En tant que cadre d'application de modèle à grande échelle à guichet à guichet à guichet à guichet à guichet à guichet léger, une expansion et une implémentation pratiques

- Déploiement flexible : prend en charge les dépendances de développement d'applications à grande échelle de divers composants Docker-Compose en un seul clic pour déployer rapidement la configuration zéro

Effet de course

Exigences de configuration de l'environnement

Avant de commencer, assurez-vous que votre environnement de développement répond aux exigences de configuration minimale suivantes:

- Système d'exploitation : Windows 10/11, MacOS M Series, CentOS / Ubuntu

- GPU : utilisez Olllama pour se déployer localement, et il est recommandé d'utiliser la carte graphique NVIDIA ou le mode CPU.

- Mémoire : 8 Go +

? Préconditionne

- Python 3.8+

- Poésie 1.8.3+

- Dify 0.7.1+

- Mysql 8.0+

- Node.js 18.12.x +

- Pnpm 9.x

Déploiement grand modèle

- Reportez-vous au déploiement d'Ollama

- Modèle: Qwen2.5

Configuration de l'environnement Dify

Utilisez des scripts de projet pour installer Dify par défaut

- Afin de prendre en compte les étudiants qui sont exposés à des applications de gros modèles pour la première fois, ce projet fournit une configuration de service de service en un clic et de démarrer la méthode de service pour faciliter tout le monde pour en faire l'expérience rapidement.

- Dify Adresse d'accès local: http: // Compte localhost: [email protected] Mot de passe: admin123

# 拉起内置的dify服务

cd docker/dify/docker

docker-compose up -d

Si l'environnement difficile a été installé

- Si vous avez déjà un environnement différent, vous ne pouvez modifier le code source localement dans ce cas pour démarrer le service !!!

- La première étape consiste à importer directement le Docker / Dify / Data Q&R dans le répertoire racine du canevas Project.yml à Dify

- La deuxième étape consiste à modifier la touche de base de données_qa dans le code source difyappenum enum ( la clé est obtenue à partir de la canevas de processus Diify )

- La troisième étape consiste à modifier le fichier .env dans le répertoire racine du projet et à modifier l'adresse d'interface de service Dify REST Selon l'environnement.

- Étape 4 Modifiez la configuration HTTPRequest dans Dify Canvas et modifiez l'adresse URL à l'adresse de service SanIC-Web spécifique

Installez la dernière version de Dify

- Si vous devez installer la dernière version de Dify, vous pouvez vous référer au document officiel officiel officiel.

Expérience rapide

- Les étapes spécifiques sont les suivantes:

- La première étape consiste à cloner le code à la région

- La deuxième étape consiste à se référer au déploiement du grand modèle ci-dessus. Installez d'abord Olllama pour déployer le modèle QWEN2.5.

- La troisième étape consiste à se référer directement à la configuration de l'environnement Dify dans la configuration d'environnement Dify ci-dessus. Dans le premier cas, [l'utilisation de scripts de projet pour installer Dify par défaut] est très important !!!

- Les étapes spécifiques pour démarrer le service à la quatrième étape sont les suivantes:

- Cloner le référentiel

git clone https://github.com/apconw/sanic-web.git

- Démarrer le service

# 拉起前后端服务和中间件

cd docker

docker compose up -d

- Initialisation des données

cd docker

./init.sh

或执行

cd docker

python3 ../common/initialize_mysql.py

- Services d'accès

- Service frontal: http: // localhost: 8081

Développement local

- La première étape consiste à cloner le code à la région

- La deuxième étape consiste à se référer au déploiement du grand modèle ci-dessus. Installez d'abord Olllama pour déployer le modèle QWEN2.5.

- La troisième étape consiste à configurer l'environnement de développement local Dify Environment. Veuillez vous référer à la configuration d'environnement Dify ci-dessus. Vous pouvez choisir vous-même les première ou deuxième situations.

- Étape 4: Modifiez le fichier .env dans le répertoire racine du projet, modifiez des informations de configuration de la base de données.

- Étape 5: Installez les dépendances du projet avant et arrière et démarrez les services frontaux et back-end. Les étapes spécifiques sont les suivantes:

- Installation de dépendance backend

- Installation de poésie Référence Poésie Documentation officielle

# 安装poetry

pip install poetry

# 安装依赖根目录执行

# 设置国内仓库

poetry source add --priority=default mirrors https://pypi.tuna.tsinghua.edu.cn/simple/

poetry install

- Installez la base de données

docker run --name mysql-local

-p 13006:3306

-v /Users/lihuan/docker-mount/mysql:/var/lib/mysql

-e MYSQL_ROOT_PASSWORD=1

-d mysql:latest

- Initialiser la base de données

- Si vous utilisez l'environnement local MySQL, vous devez modifier le code source initialize_mysql lors de l'initialisation des données et de la modification des informations de connexion de la base de données.

cd docker

./init.sh

或执行

cd docker

python3 ../common/initialize_mysql.py

Installation de dépendance frontale

- Le front-end est basé sur des projets open source. Vous pouvez vous référer à ChatGpt-Vue3-Light-MVP pour installer la deuxième ouverture.

# 安装前端依赖&启动服务

cd web

#安装依赖

npm install -g pnpm

pnpm i

#启动服务

pnpm dev

Démarrer le service backend

Services d'accès

- Service frontal: http: // localhost: 2048

? Construire un miroir

- Modifiez le fichier .env dans le répertoire root du projet, modifiez Env = test et enregistrez.

- Exécuter la commande build:

# 构建前端镜像

make web-build

# 构建后端镜像

make server-build

? soutien

Si vous aimez ce projet ou que vous le trouvez utile, vous pouvez cliquer sur Star dans le coin supérieur droit pour le soutenir. Votre soutien est notre moteur de l'amélioration continue, merci! ^ _ ^

Si vous trouvez ce projet utile ou si vous aimez ce que nous faisons, veuillez cliquer sur le bouton [ourd Star] dans le coin supérieur droit pour nous soutenir! Chaque star de la vôtre est un grand encouragement pour nous et est également la force motrice de notre amélioration et du développement continu. Merci pour votre soutien! ^ _ ^

De plus, si vous avez des suggestions ou si vous souhaitez participer au développement du projet, vous êtes également invités à nous contacter via les méthodes suivantes:

- Soumettre le problème - Si vous trouvez des problèmes ou avez des suggestions d'amélioration, vous pouvez le soumettre en problèmes.

- Rejoignez la discussion - vous pouvez ajouter à notre groupe de discussion pour communiquer et discuter. Participer à la discussion.

- Code de contribution - Si vous êtes intéressé à contribuer au code, vous pouvez vous référer au guide de contribution.

Merci encore pour votre soutien!

Groupe de communication QA

- Bienvenue dans le groupe d'échange d'applications de Big Model, bienvenue pour rejoindre le groupe pour discuter et partager l'expérience

- Suivez le compte officiel ci-dessous et cliquez sur le menu du groupe WeChat pour ajouter WeChat pour vous amener dans le groupe

| Groupe de WeChat |

|---|

|

Licence

Licence MIT | Copyright © 2024 présent