Asisten Data Model Besar

? Pendahuluan Proyek

Proyek aplikasi skala besar yang ringan, penuh dan mudah untuk pengembangan sekunder

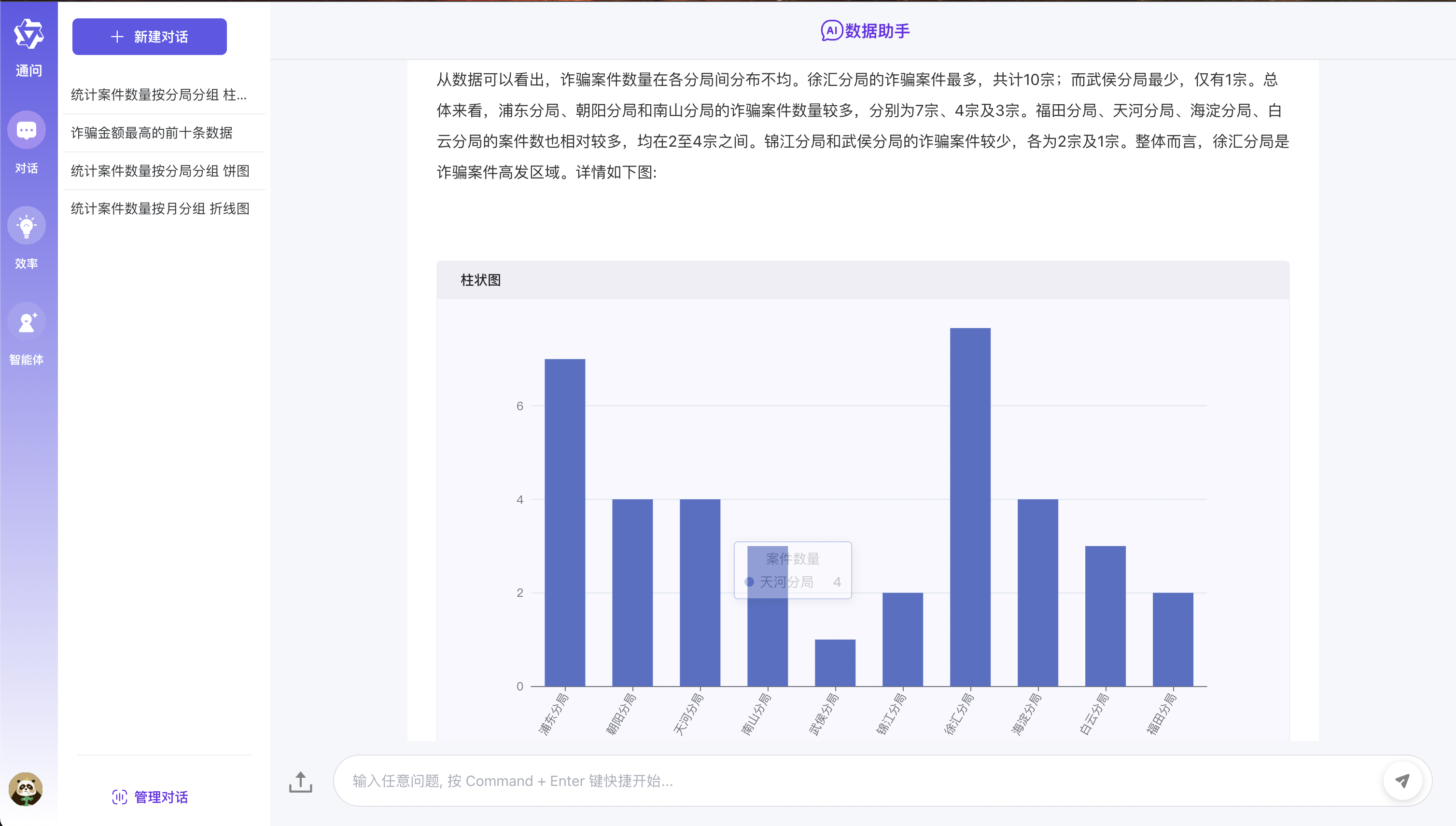

Proyek pengembangan aplikasi model besar satu atap yang dibangun di atas teknologi seperti Diy, Ollama & VLLM, Sanic dan Text2SQL, menggunakan VUE3, TypeScript dan Vite 5 untuk membuat UI modern. Ini mendukung jawaban data grafis berdasarkan model besar melalui echarts?, Dan memiliki kemampuan untuk memproses pertanyaan dan jawaban tabel file CSV. Pada saat yang sama, dapat lebih mudah terhubung ke sistem pengambilan sistem rag open source pihak ketiga, dll. Untuk mendukung berbagai pertanyaan dan jawaban pengetahuan umum.

Sebagai proyek pengembangan aplikasi model besar yang ringan, Sanic-WEB mendukung iterasi dan ekspansi yang cepat, membantu proyek-proyek model besar untuk dengan cepat mengimplementasikannya.

? Demo langsung

Pengalaman online akan akan diluncurkan, jadi tetaplah disini!

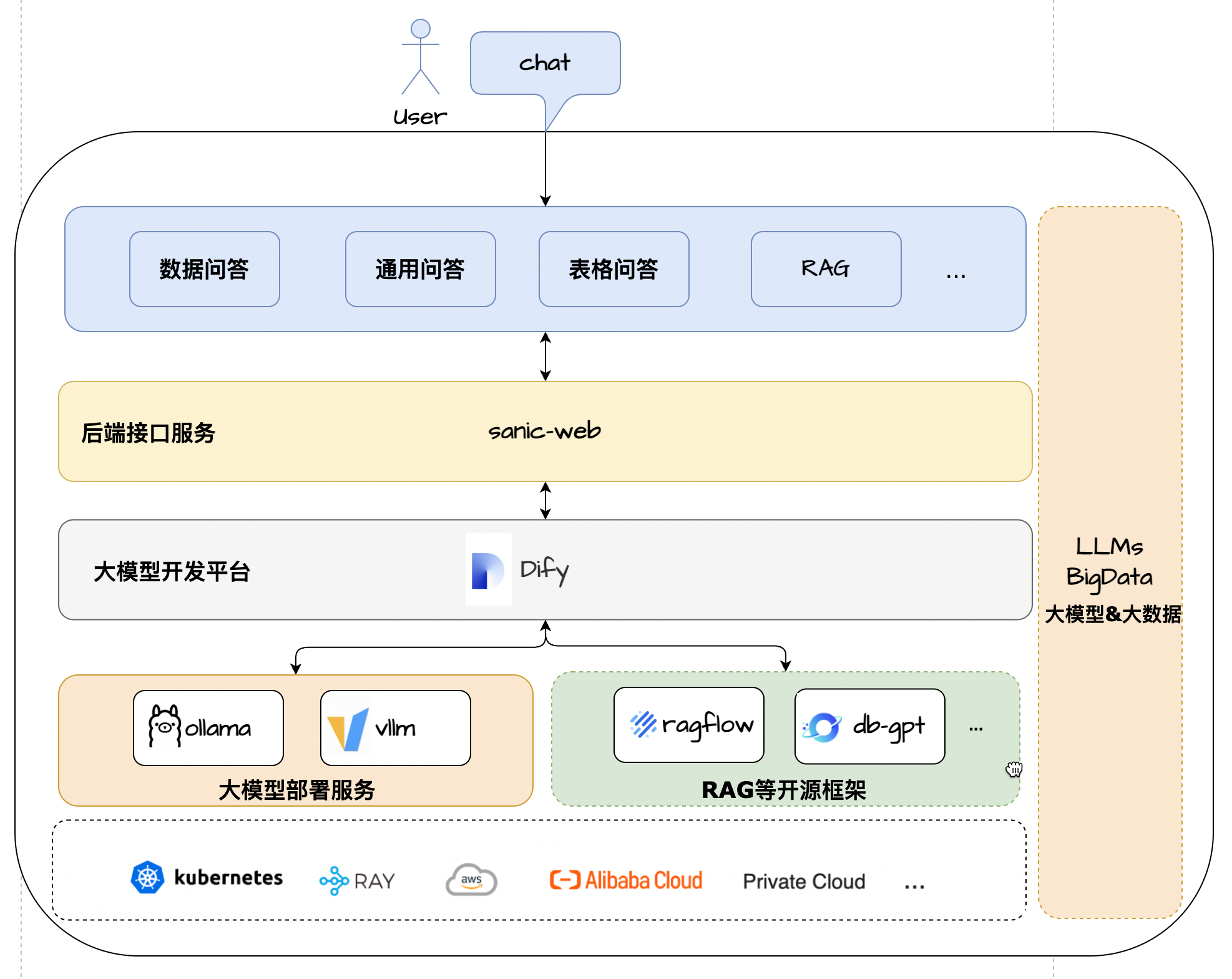

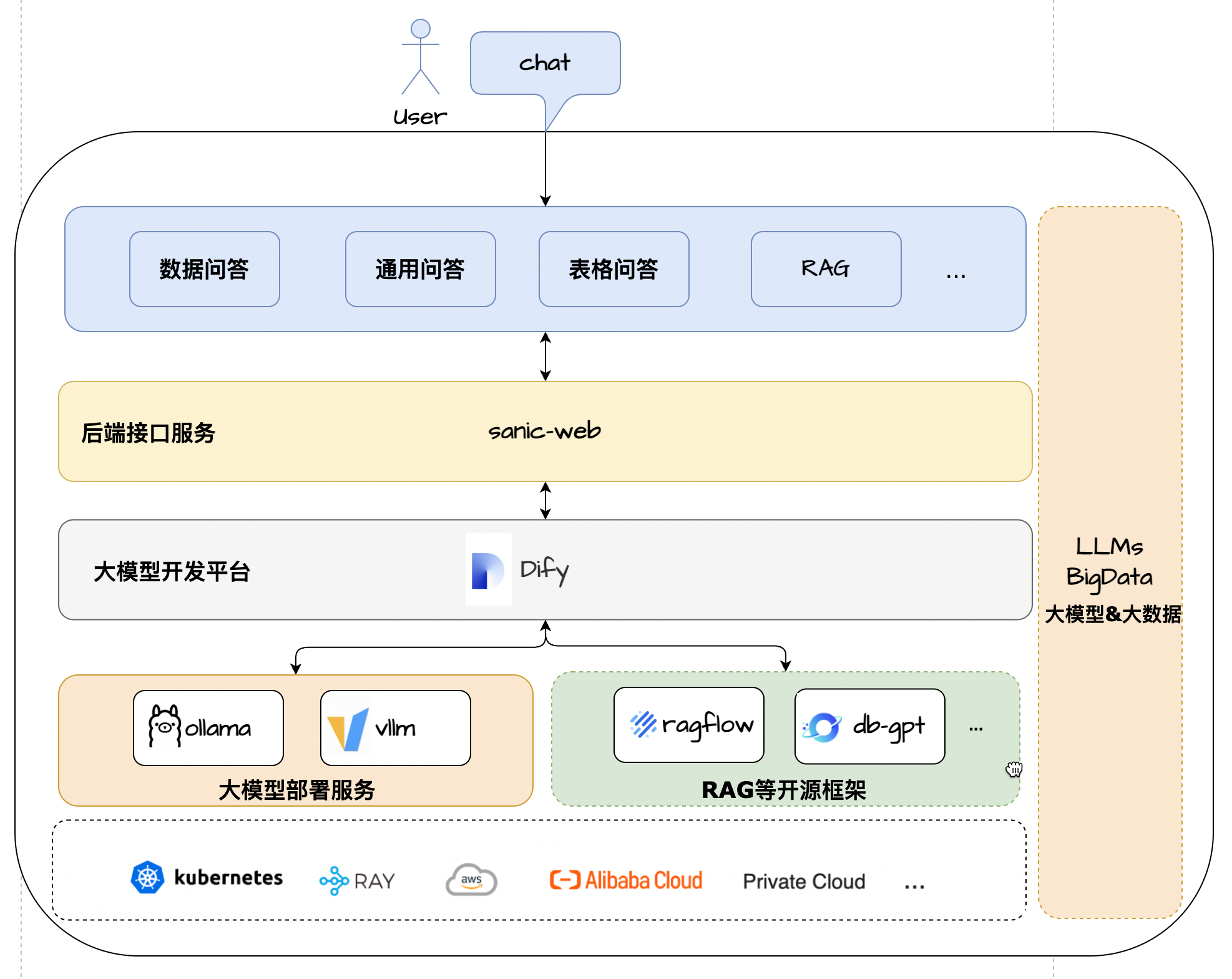

Solusi arsitektur

? ciri

- Tumpukan Teknologi Inti : Diy + Ollama + Rag + LLM + Text2SQL

- UI Framework : Vue 3 + TypeScript + Vite 5

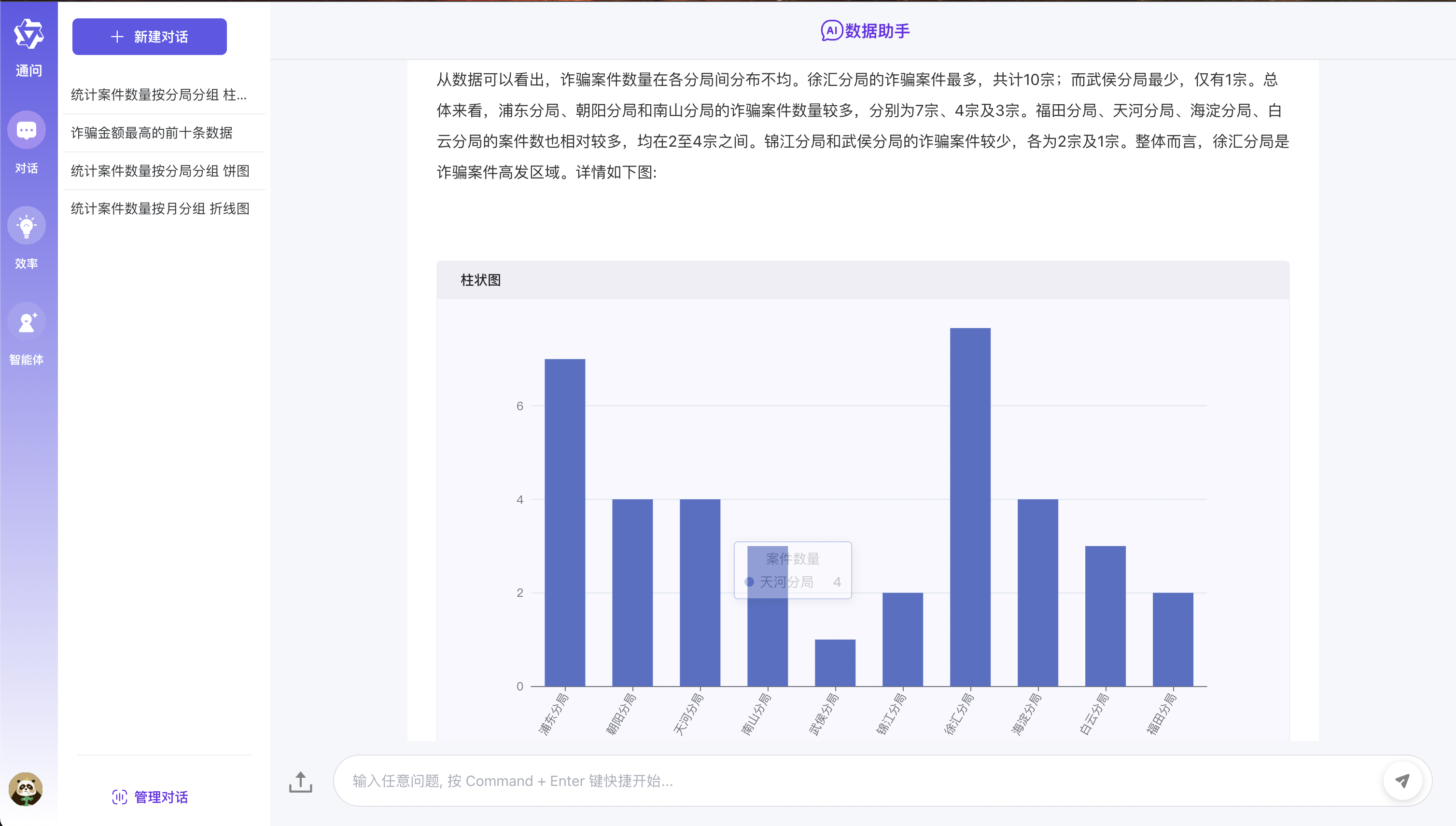

- Data T&J : Model Echarts Terpadu untuk mewujudkan Teks2SQL Data Grafis Lightweight Data Q&A Display

- Tabel Tanya Jawab : Mendukung pengunggahan file format CSV dan preprocessing berdasarkan ringkasan model besar dan data tabel tabel text2sql

- Tanya Jawab Umum : Mendukung Formulir Data Umum Tanya Jawab Berdasarkan Sistem Rag Tiga Pihak Docking + Mode Pengambilan Jaringan Publik

- Arsitektur Aplikasi : Sebagai kerangka pengembangan aplikasi model skala besar yang ringan, ekspansi dan implementasi yang nyaman dan implementasi

- Penyebaran Fleksibel : Mendukung Ketergantungan Pengembangan Aplikasi Skala Besar dari berbagai komponen Komposisi Docker dengan satu klik untuk dengan cepat menggunakan konfigurasi nol

Efek berjalan

Persyaratan Konfigurasi Lingkungan

Sebelum Anda mulai, pastikan lingkungan pengembangan Anda memenuhi persyaratan konfigurasi minimum berikut:

- Sistem Operasi : Windows 10/11, MacOS M Series, Centos/Ubuntu

- GPU : Gunakan Ollama untuk menggunakan secara lokal, dan disarankan untuk menggunakan kartu grafis NVIDIA atau mode CPU.

- Memori : 8GB+

? Pra-kondisi

- Python 3.8+

- Puisi 1.8.3+

- Dify 0.7.1+

- MySQL 8.0+

- Node.js 18.12.x+

- PNPM 9.x

Penyebaran model besar

- Lihat penyebaran Ollama

- Model: Qwen2.5

Dify Configuration Environment

Gunakan skrip proyek untuk menginstal diy secara default

- Untuk memperhitungkan siswa yang terpapar pada aplikasi model besar untuk pertama kalinya, proyek ini menyediakan konfigurasi nol layanan difigurasi satu klik dan juga memulai metode layanan untuk memfasilitasi semua orang untuk mengalaminya dengan cepat.

- Dify Alamat Akses Lokal: http: // akun localhost: [email protected] Kata sandi: admin123

# 拉起内置的dify服务

cd docker/dify/docker

docker-compose up -d

Jika lingkungan yang berbeda telah dipasang

- Jika Anda sudah memiliki lingkungan yang berbeda, Anda hanya dapat memodifikasi kode sumber secara lokal dalam kasus ini untuk memulai layanan !!!

- Langkah pertama adalah secara langsung mengimpor Docker/Dify/Data Q&A di direktori root proyek.yml Canvas untuk membedakan

- Langkah kedua adalah memodifikasi tombol database_QA dalam kode sumber difiPenum enum ( kunci diperoleh dari kanvas proses diify )

- Langkah ketiga adalah memodifikasi file .env di direktori root proyek dan memodifikasi alamat antarmuka layanan DIFY Actual difule sesuai dengan lingkungan.

- Langkah 4 Ubah Konfigurasi HTTPREQUEST di Diffas Canvas dan Ubah Alamat URL ke Alamat Layanan SANIC-WEB spesifik

Instal versi terbaru dari Dify

- Jika Anda perlu menginstal versi terbaru Dify, Anda dapat merujuk ke dokumen resmi Dokumen Resmi.

Pengalaman cepat

- Langkah -langkah spesifiknya adalah sebagai berikut:

- Langkah pertama adalah mengkloning kode ke area lokal

- Langkah kedua adalah merujuk pada penyebaran model besar di atas. Pertama instal ollama untuk menggunakan model QWEN2.5.

- Langkah ketiga adalah secara langsung merujuk ke konfigurasi lingkungan Dify dalam konfigurasi lingkungan yang berbeda . Dalam kasus pertama, [menggunakan skrip proyek untuk menginstal Dife secara default] sangat penting !!!

- Langkah -langkah spesifik untuk memulai layanan di langkah keempat adalah sebagai berikut:

- Mengkloning repositori

git clone https://github.com/apconw/sanic-web.git

- Mulailah layanan

# 拉起前后端服务和中间件

cd docker

docker compose up -d

- Inisialisasi Data

cd docker

./init.sh

或执行

cd docker

python3 ../common/initialize_mysql.py

- Layanan Akses

- Layanan front-end: http: // localhost: 8081

Pengembangan Lokal

- Langkah pertama adalah mengkloning kode ke area lokal

- Langkah kedua adalah merujuk pada penyebaran model besar di atas. Pertama instal ollama untuk menggunakan model QWEN2.5.

- Langkah ketiga adalah mengonfigurasi lingkungan pengembangan lokal yang meredakan lingkungan. Silakan merujuk ke konfigurasi lingkungan dify di atas. Anda dapat memilih situasi pertama atau kedua sendiri.

- Langkah 4: Edit file .env di direktori root proyek, ubah env = dev , dan informasi konfigurasi basis data.

- Langkah 5: Pasang dependensi proyek depan dan back-end dan mulai layanan depan dan back-end. Langkah -langkah spesifiknya adalah sebagai berikut:

- Instalasi Ketergantungan Backend

- Dokumentasi Resmi Referensi Instalasi Puisi

# 安装poetry

pip install poetry

# 安装依赖根目录执行

# 设置国内仓库

poetry source add --priority=default mirrors https://pypi.tuna.tsinghua.edu.cn/simple/

poetry install

- Instal database

docker run --name mysql-local

-p 13006:3306

-v /Users/lihuan/docker-mount/mysql:/var/lib/mysql

-e MYSQL_ROOT_PASSWORD=1

-d mysql:latest

- Inisialisasi database

- Jika Anda menggunakan lingkungan lokal MySQL, Anda perlu memodifikasi kode sumber Initialize_MysQL saat menginisialisasi data dan memodifikasi informasi koneksi database.

cd docker

./init.sh

或执行

cd docker

python3 ../common/initialize_mysql.py

Instalasi ketergantungan front-end

- Front-end didasarkan pada proyek sumber terbuka. Anda dapat merujuk ke chatgpt-vue3-light-MVP untuk menginstal pembukaan kedua.

# 安装前端依赖&启动服务

cd web

#安装依赖

npm install -g pnpm

pnpm i

#启动服务

pnpm dev

Mulai layanan backend

Layanan Akses

- Layanan front-end: http: // localhost: 2048

? Bangun cermin

- Edit file .env di direktori root proyek, ubah env = tes , dan simpan.

- Jalankan perintah build:

# 构建前端镜像

make web-build

# 构建后端镜像

make server-build

? mendukung

Jika Anda menyukai proyek ini atau merasa berguna, Anda dapat mengklik Star di sudut kanan atas untuk mendukungnya. Dukungan Anda adalah kekuatan pendorong kami untuk perbaikan berkelanjutan, terima kasih! ^_^

Jika Anda menemukan proyek ini bermanfaat bagi Anda, atau Anda menyukai apa yang kami lakukan, silakan klik tombol [️ Star] di sudut kanan atas untuk mendukung kami! Setiap bintang Anda adalah dorongan besar bagi kami dan juga kekuatan pendorong untuk peningkatan dan pengembangan kami yang berkelanjutan. Terima kasih atas dukungan Anda! ^_^

Selain itu, jika Anda memiliki saran atau ingin berpartisipasi dalam pengembangan proyek, Anda juga dipersilakan untuk menghubungi kami melalui metode berikut:

- Kirim Masalah - Jika Anda menemukan masalah atau memiliki saran untuk perbaikan, Anda dapat mengirimkannya dalam masalah.

- Bergabunglah dengan diskusi - Anda dapat menambah grup diskusi kami untuk berkomunikasi dan berdiskusi. Berpartisipasi dalam diskusi.

- Kode Kontribusi - Jika Anda tertarik untuk berkontribusi kode, Anda dapat merujuk pada Panduan Kontribusi.

Sekali lagi terima kasih atas dukungan Anda!

Grup Komunikasi QA

- Selamat datang di Grup Pertukaran Aplikasi Model Besar, selamat datang untuk bergabung dengan grup untuk membahas dan berbagi pengalaman

- Ikuti akun resmi di bawah ini dan klik menu WeChat Group untuk menambahkan WeChat untuk membawa Anda ke dalam grup

| Grup WeChat |

|---|

|

Lisensi

Lisensi MIT | Hak Cipta © 2024-sekarang aiadventurer