Big Model Data Assistent

? Projekteinführung

Ein leichtes, ganzgewichtiges und leicht zu sekundärer Entwicklung groß angelegter Anwendungsprojekt

Ein One-Stop-Projekt für die Entwicklung von Big Model Application, das auf Technologien wie Dify, Ollama & Vllm, Sanic und Text2SQL basiert, unter Verwendung von VUE3, TypeScript und Vite 5, um eine moderne Benutzeroberfläche zu erstellen. Es unterstützt grafische Datenantworten auf der Grundlage großer Modelle über Echarts? Gleichzeitig kann es bequem sein, eine Verbindung zu Open-Source-Rag-System-Abrufsystemen usw. herzustellen, um eine breite Palette von allgemeinen Fragen und Antworten zu unterstützen.

Sanic-Web unterstützt als leichte Big Model Application Development Project und unterstützt die schnelle Iteration und Expansion und hilft Big Model-Projekten, sie schnell zu implementieren.

? Live -Demo

Die Online -Erlebnis ist kurz vor dem Start, also bleiben Sie dran!

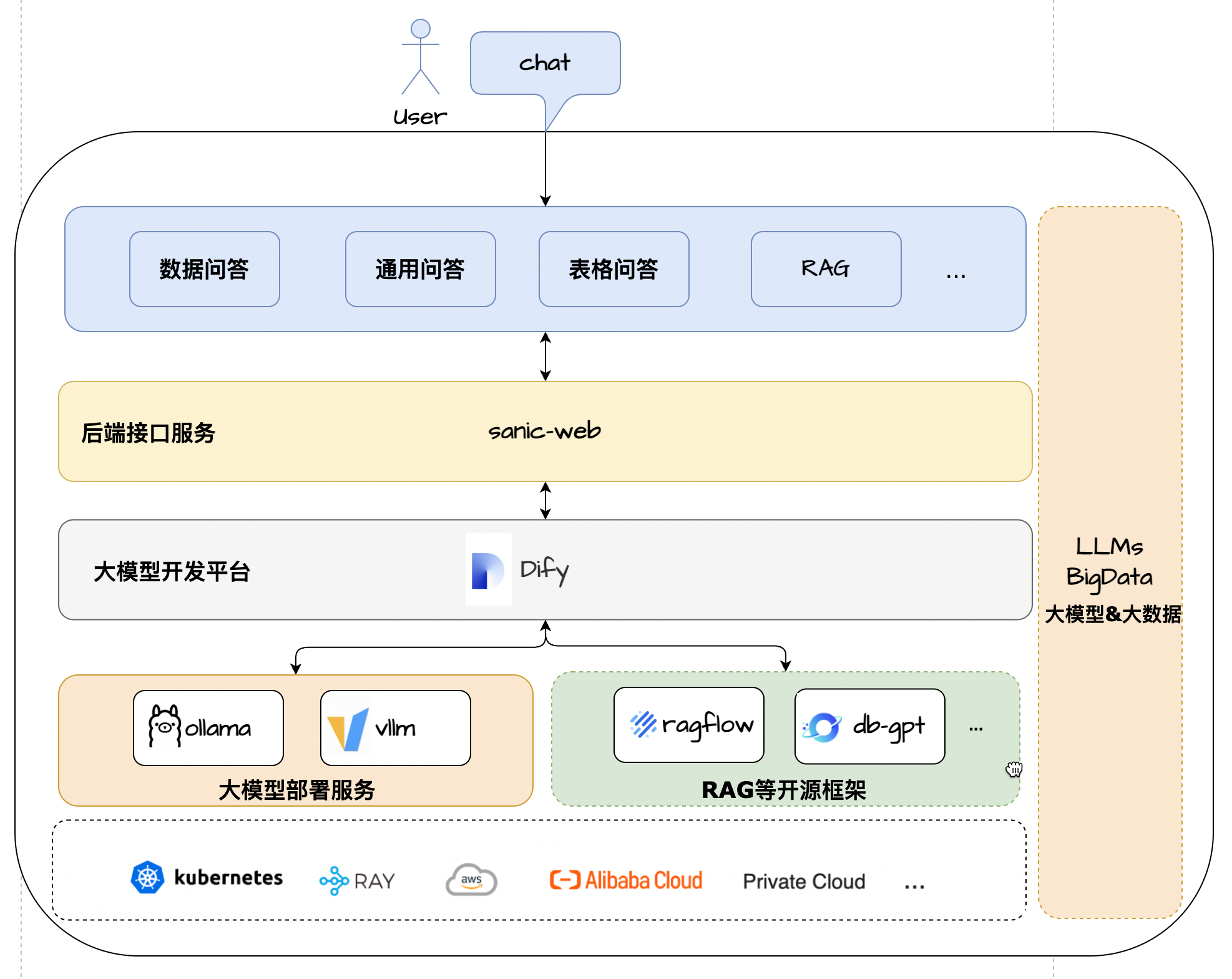

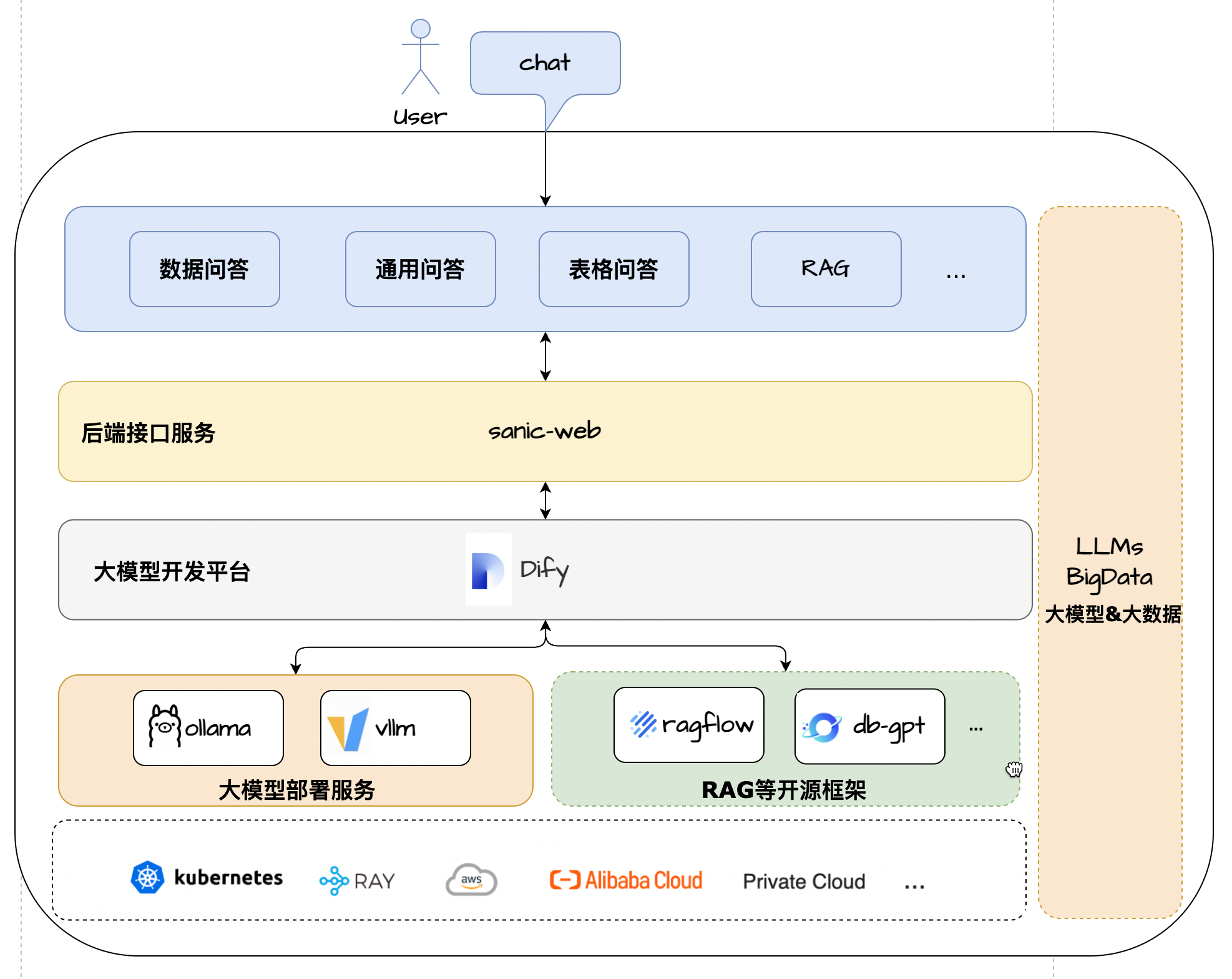

Architekturlösung

? Merkmal

- Core Technology Stack : Dify + Ollama + Rag + LLM + Text2SQL

- UI -Framework : Vue 3 + TypeScript + Vite 5

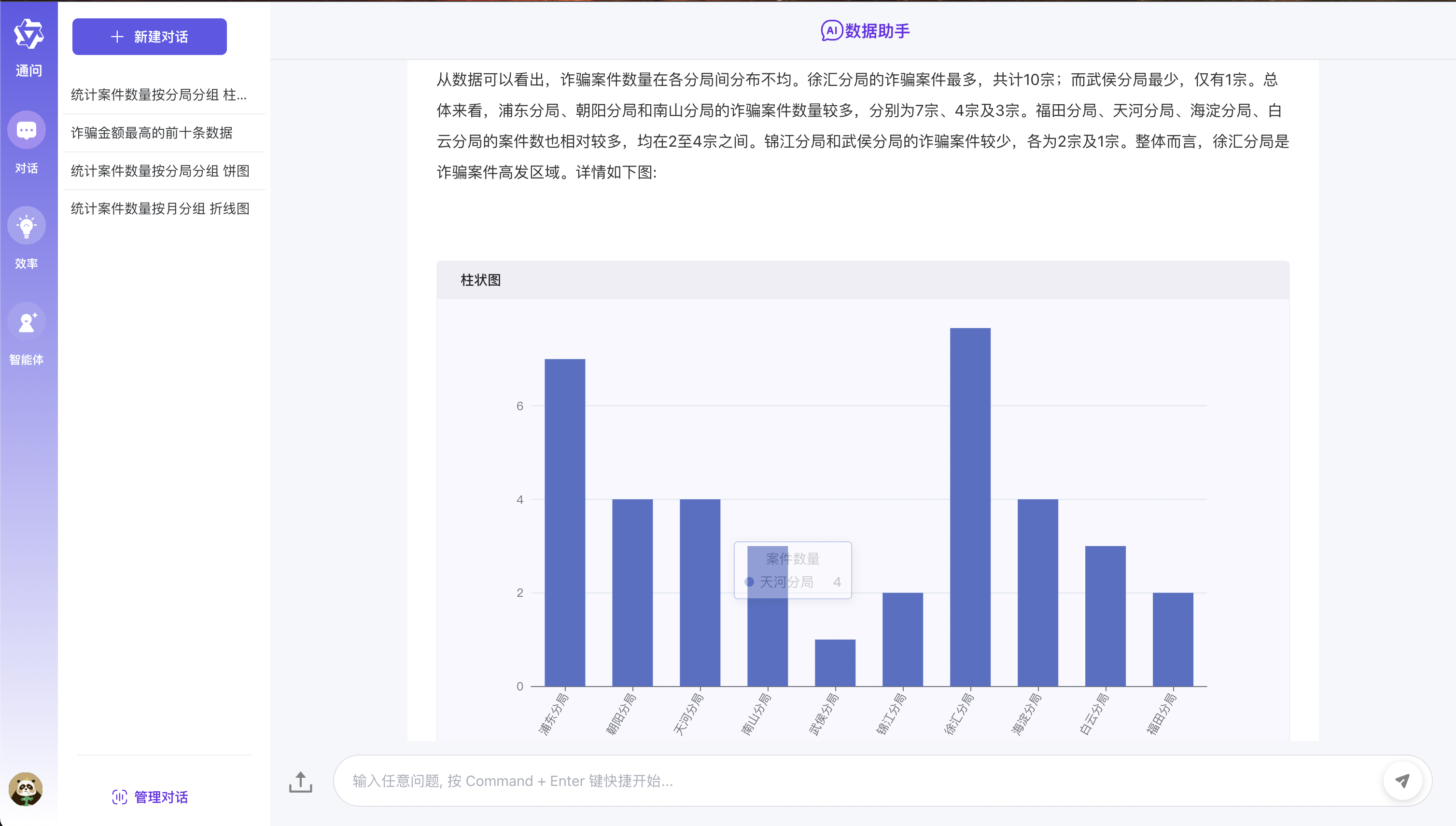

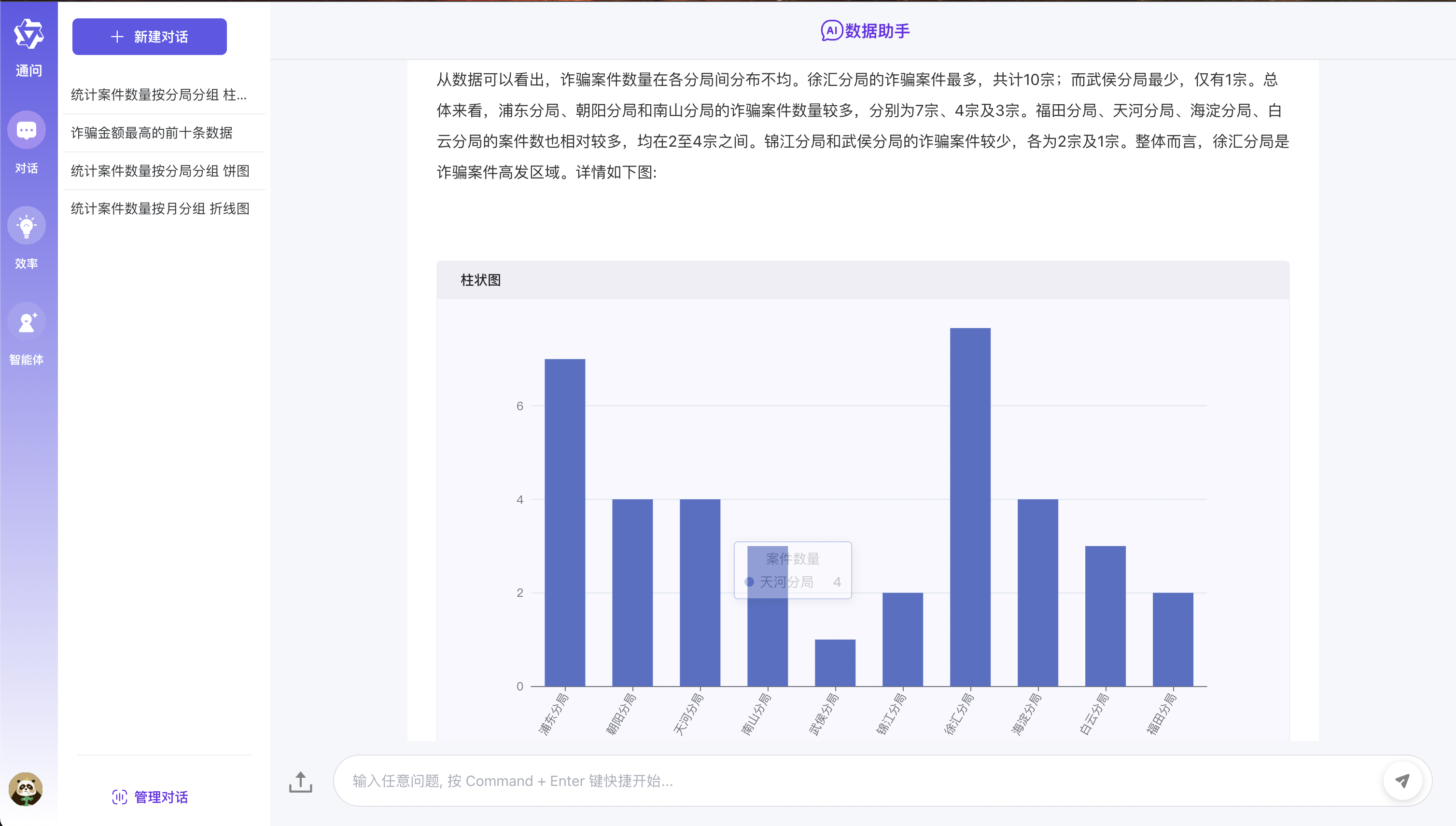

- Daten Q & A : Integrated Echarts -Modell zur Realisierung von Text2SQL Leichtes grafische Daten Q & A -Anzeige

- TABELLE Q & A : Unterstützt das Hochladen von CSV -Formatdateien und die Vorverarbeitung auf der Grundlage der Zusammenfassung der großen Modell und der text2SQL -Tabelle Daten und Antworten Daten und Antworten

- Allgemeine Q & A : Unterstützt die Fragen und Antworten des allgemeinen Datenformulars auf dem Docking von Drei-Parteien-Rag-System + öffentlicher Netzwerkabrufmodus

- Anwendungsarchitektur : Als leichter Vollkorn-One-Stop-Modell-Anwendungsentwicklungsrahmen, bequeme Expansion und Implementierung

- Flexible Bereitstellung : Unterstützt große Abhängigkeiten der Anwendungsentwicklung verschiedener Komponenten mit einem Klick mit einem Klick, um die Konfiguration von Null schnell bereitzustellen

Laufeffekt

Umgebungskonfigurationsanforderungen

Stellen Sie vor Beginn sicher, dass Ihre Entwicklungsumgebung die folgenden Mindestkonfigurationsanforderungen entspricht:

- Betriebssystem : Windows 10/11, MacOS M -Serie, CentOS/Ubuntu

- GPU : Verwenden Sie OLLAMA, um lokal bereitzustellen, und es wird empfohlen, die NVIDIA -Grafikkarte oder den CPU -Modus zu verwenden.

- Speicher : 8 GB+

? Vorkonditionen

- Python 3.8+

- Poesie 1.8.3+

- Diffy 0,7.1+

- MySQL 8.0+

- Node.js 18.12.x+

- Pnpm 9.x

Große Modellbereitstellung

- Siehe den Einsatz von Ollama

- Modell: Qwen2.5

DIFY -Umgebungskonfiguration

Verwenden Sie Projektskripte, um DIFY standardmäßig zu installieren

- Um Studierende zu berücksichtigen, die erstmals großen Modellanwendungen ausgesetzt sind, bietet dieses Projekt eine Ein-Klick-DIFY-Service-Null-Konfiguration und starten Sie auch die Servicemethode, um alle dazu zu erleichtern, sie schnell zu erleben.

- DIFY LOCAL Access Adresse: http: // localhost -Konto: [email protected] Passwort: admin123

# 拉起内置的dify服务

cd docker/dify/docker

docker-compose up -d

Wenn die DIFY -Umgebung installiert wurde

- Wenn Sie bereits über eine DIFY -Umgebung verfügen, können Sie den Quellcode in diesem Fall nur lokal ändern, um den Dienst zu starten !!!

- Der erste Schritt besteht darin , die Q & A in Docker/DIFY/Data im Stammverzeichnis des Projekts von Project.yml in Diffy direkt zu importieren

- Der zweite Schritt besteht darin, den Taste Database_QA im Quellcode Difyappenum Enum zu ändern ( der Schlüssel wird aus der DIIFY -Prozess -Canvas erhalten )

- Der dritte Schritt besteht darin, die .Env -Datei im Projektroot -Verzeichnis zu ändern und die tatsächliche Adresse der DIFY REST -Service -Schnittstelle gemäß der Umgebung zu ändern.

- Schritt 4 Ändern Sie die HTTPrequest-Konfiguration in DIFY-Canvas und ändern Sie die URL

Installieren Sie die neueste Version von Dify

- Wenn Sie die neueste Version von DIFY installieren müssen, können Sie sich auf das offizielle Dokument DIFY Official -Dokument verweisen.

Schnelle Erfahrung

- Die spezifischen Schritte sind wie folgt:

- Der erste Schritt besteht darin, den Code in die Region zu klonen

- Der zweite Schritt besteht darin, sich auf die oben genannte große Modellbereitstellung zu beziehen. Installieren Sie zuerst OLLAMA, um das QWEN2.5 -Modell bereitzustellen.

- Der dritte Schritt besteht darin, direkt auf die Konfiguration der DIFY -Umgebung in der obigen DIFY -Umgebungskonfiguration zu verweisen. Im ersten Fall ist es sehr wichtig !!!

- Die spezifischen Schritte zum Starten des Dienstes im vierten Schritt sind wie folgt:

- Klonen des Repositorys

git clone https://github.com/apconw/sanic-web.git

- Starten Sie den Service

# 拉起前后端服务和中间件

cd docker

docker compose up -d

- Dateninitialisierung

cd docker

./init.sh

或执行

cd docker

python3 ../common/initialize_mysql.py

- Zugangsdienste

- Front-End-Service: http: // localhost: 8081

Lokale Entwicklung

- Der erste Schritt besteht darin, den Code in die Region zu klonen

- Der zweite Schritt besteht darin, sich auf die oben genannte große Modellbereitstellung zu beziehen. Installieren Sie zuerst OLLAMA, um das QWEN2.5 -Modell bereitzustellen.

- Der dritte Schritt besteht darin, die lokale Entwicklungsumgebung DIFY -Umgebung zu konfigurieren. Weitere Informationen finden Sie in der oben genannten DIFY -Umgebungskonfiguration . Sie können die ersten oder zweiten Situationen selbst auswählen.

- Schritt 4: Bearbeiten Sie die .Env -Datei im Projektroot -Verzeichnis, ändern Sie die Informationen zur Konfiguration von Env = und Datenbank.

- Schritt 5: Installieren Sie die Projektabhängigkeiten vor Ort und Back-End-Projekt und starten Sie die Front- und Back-End-Dienste. Die spezifischen Schritte sind wie folgt:

- Backend -Abhängigkeitsinstallation

- Poesie -Installation Referenzpoesie Offizielle Dokumentation

# 安装poetry

pip install poetry

# 安装依赖根目录执行

# 设置国内仓库

poetry source add --priority=default mirrors https://pypi.tuna.tsinghua.edu.cn/simple/

poetry install

- Installieren Sie die Datenbank

docker run --name mysql-local

-p 13006:3306

-v /Users/lihuan/docker-mount/mysql:/var/lib/mysql

-e MYSQL_ROOT_PASSWORD=1

-d mysql:latest

- Initialisieren Sie die Datenbank

- Wenn Sie die lokale Umgebung MySQL verwenden, müssen Sie den Quellcode initialize_mysql bei der Initialisierung der Daten ändern und die Datenbankverbindungsinformationen ändern.

cd docker

./init.sh

或执行

cd docker

python3 ../common/initialize_mysql.py

Front-End-Abhängigkeitsinstallation

- Das Front-End basiert auf Open-Source-Projekten. Sie können sich auf Chatgpt-VUE3-Light-MVP beziehen, um die zweite Öffnung zu installieren.

# 安装前端依赖&启动服务

cd web

#安装依赖

npm install -g pnpm

pnpm i

#启动服务

pnpm dev

Backend -Service starten

Zugangsdienste

- Front-End-Service: http: // localhost: 2048

? Bauen Sie einen Spiegel

- Bearbeiten Sie die .Env -Datei im Projektroot -Verzeichnis, ändern Sie Env = Test und speichern Sie.

- Führen Sie den Befehl Build aus:

# 构建前端镜像

make web-build

# 构建后端镜像

make server-build

? Unterstützung

Wenn Ihnen dieses Projekt gefällt oder es nützlich finden, können Sie in der oberen rechten Ecke auf Star klicken, um es zu unterstützen. Ihre Unterstützung ist unsere treibende Kraft für kontinuierliche Verbesserungen, danke! ^_^

Wenn Sie dieses Projekt für Sie hilfreich finden oder Sie mögen, was wir tun, klicken Sie bitte auf die Schaltfläche [️ stern] in der oberen rechten Ecke, um uns zu unterstützen! Jeder von Ihnen ist eine große Ermutigung für uns und auch die treibende Kraft für unsere kontinuierliche Verbesserung und Entwicklung. Vielen Dank für Ihre Unterstützung! ^_^

Wenn Sie Vorschläge haben oder an der Entwicklung des Projekts teilnehmen möchten, können Sie uns gerne mit den folgenden Methoden kontaktieren:

- Problem einreichen - Wenn Sie Probleme finden oder Verbesserungsvorschläge haben, können Sie diese in Fragen einreichen.

- Treten Sie der Diskussion bei - Sie können unsere Diskussionsgruppe hinzufügen, um zu kommunizieren und zu diskutieren. An der Diskussion teilnehmen.

- Beitragscode - Wenn Sie an Code beitragen möchten, können Sie sich auf den Beitragshandbuch beziehen.

Nochmals vielen Dank für Ihre Unterstützung!

QA -Kommunikationsgruppe

- Willkommen bei der Big Model Application Exchange Group, Willkommen, sich der Gruppe anzuschließen, um Erfahrungen zu diskutieren und zu teilen

- Folgen Sie dem offiziellen Konto unten und klicken Sie auf das Menü der WeChat -Gruppe , um WeChat hinzuzufügen, um Sie in die Gruppe zu bringen

| Wechat -Gruppe |

|---|

|

Lizenz

MIT -Lizenz | Copyright © 2024-Präsententen Aiadventurer