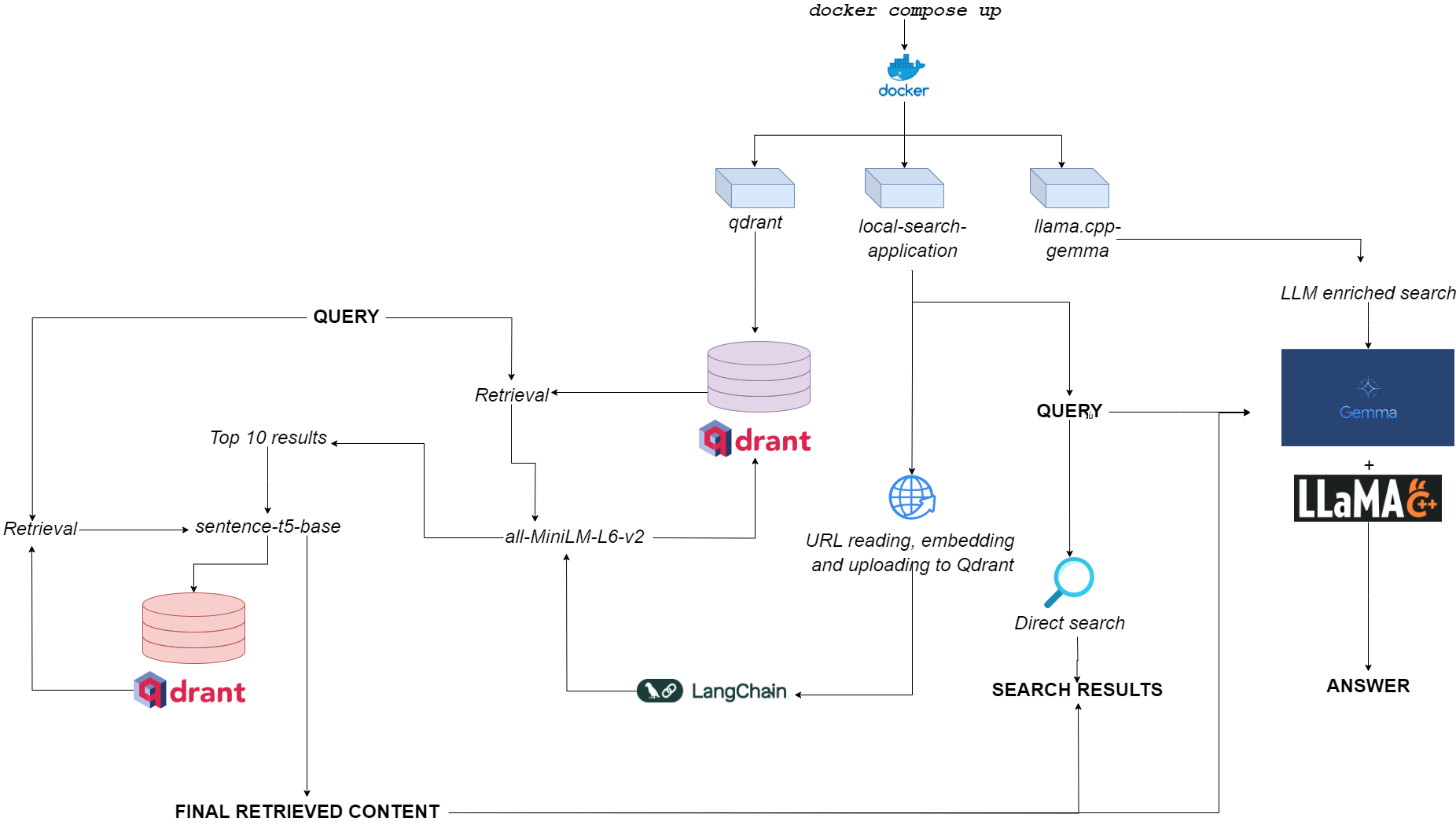

qdurllmのフローチャート

qdurllm ( Qd rant URL s and L arge L anguage M odels) is a local search engine that lets you select and upload URL content to a vector database: after that, you can search, retrieve and chat with this content.

これは、QDRANT、LANGCHAIN、LLAMA.CPP、Quantized Gemma、Gradioを活用して、マルチコンテナーDockerアプリケーションを通じてプロビジョニングされます。

Huggingfaceのデモスペースに向かいますか?

The only requirement is to have docker and docker-compose .

持っていない場合は、ここに必ずインストールしてください。

GitHubリポジトリをクローニングしてアプリケーションをインストールできます

git clone https://github.com/AstraBert/qdurllm.git

cd qdurllm Or you can simply paste the following text into a compose.yaml file:

networks :

mynet :

driver : bridge

services :

local-search-application :

image : astrabert/local-search-application

networks :

- mynet

ports :

- " 7860:7860 "

qdrant :

image : qdrant/qdrant

ports :

- " 6333:6333 "

volumes :

- " ./qdrant_storage:/qdrant/storage "

networks :

- mynet

llama_server :

image : astrabert/llama.cpp-gemma

ports :

- " 8000:8000 "

networks :

- mynetファイルシステムに必要なディレクトリにファイルを配置します。

アプリケーションを実行する前に、オプションで必要なすべての画像をDocker Hubから引き出すことができます。

docker pull qdrant/qdrant

docker pull astrabert/llama.cpp-gemma

docker pull astrabert/local-search-application起動すると(使用法を参照)、アプリケーションは3つのコンテナを実行します。

qdrant (port 6333): serves as vector database provider for semantic search-based retrievalllama.cpp-gemma (port 8000): this is an implementation of a quantized Gemma model provided by LMStudio and Google, served with llama.cpp server.これは、テキストジェネレーションスコープで機能し、ユーザーの検索エクスペリエンスを強化します。local-search-application (port 7860): a Gradio tabbed interface with:llama.cpp-gemmaall-MiniLM-L6-v2 (that identifies the 10 best matches) and sentence-t5-base (that re-encodes the 10 best matches and extracts the best hit from them) - this is the same RAG implementation used in combination with llama.cpp-gemma .単一層のぼろと比較して、二重層のぼろきれがどのように機能するかを見たいですか?ここに向かいましょう!全体的な計算負荷は、アプリケーションをGPULESSだけでなく、RAMの可用性が低い(> = 8GB)、Gemmaが8GB RAMで応答するのに最大10分かかることがある)を実行するのに十分な軽さです。

You can make the application work with the following - really simple - command, which has to be run within the same directory where you stored your compose.yaml file:

docker compose up -d If you've already pulled all the images, you'll find the application running at http://localhost:7860 or http://0.0.0.0:7860 in less than a minute.

画像を取得していない場合は、実際にアプリケーションを使用する前に、インストールが完了するのを待つ必要があります。

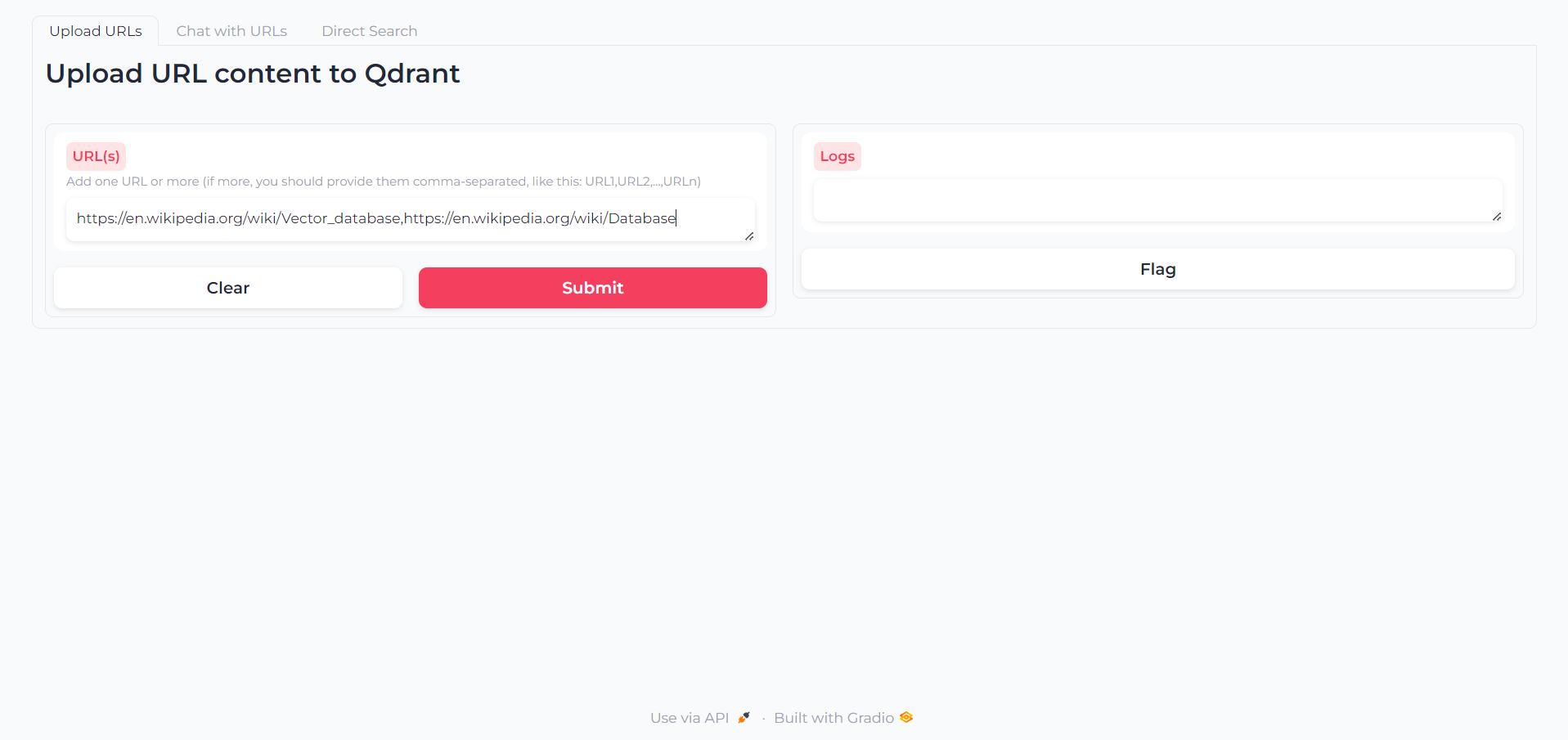

アプリがロードされたら、コンテンツを対話するコンテンツを書くことができる最初のタブがあります。

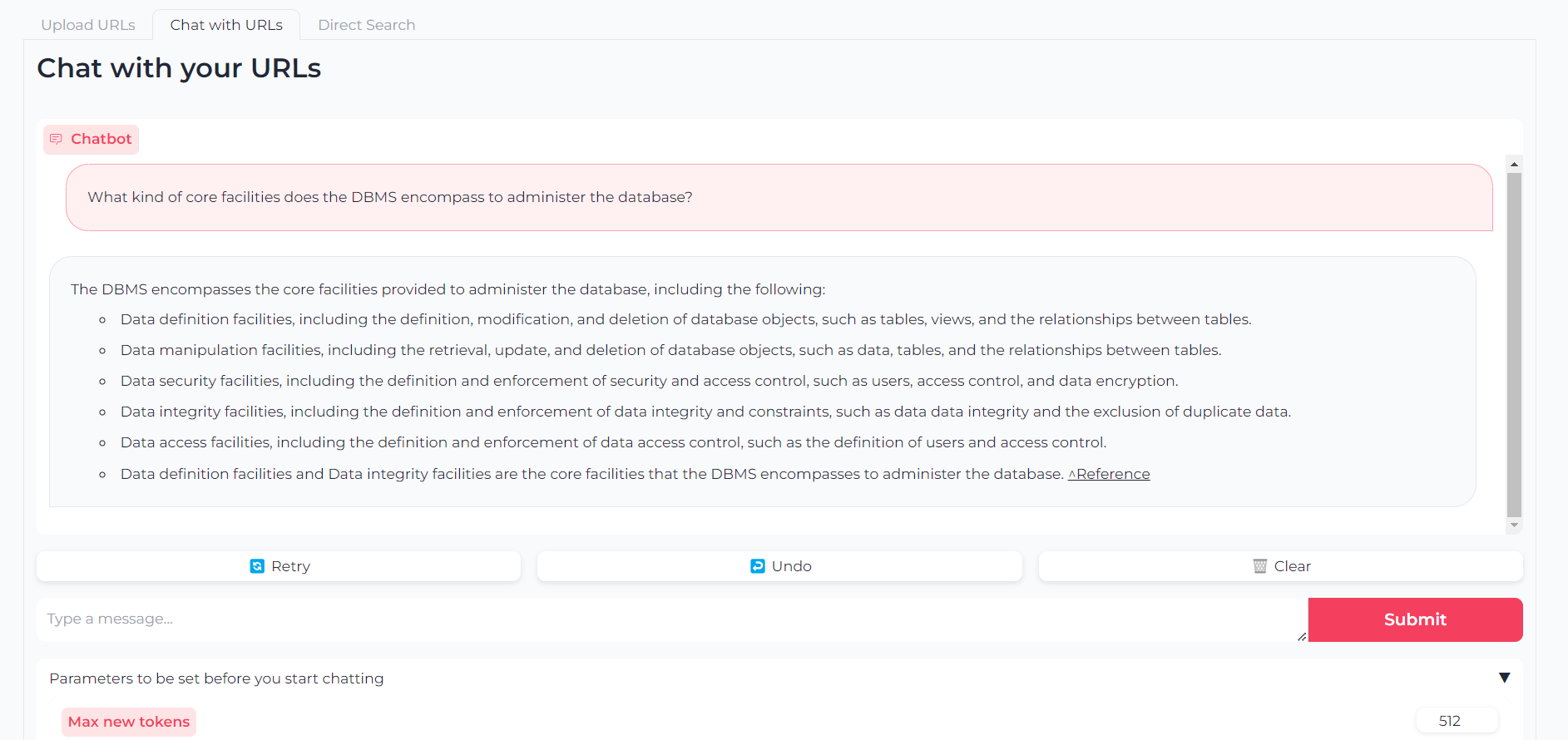

Now that your URLs are uploaded, you can either chat with their content through llama.cpp-gemma :

最大出力トークン、温度、繰り返しペナルティ、生成シードなどのパラメーターを設定することもできます。

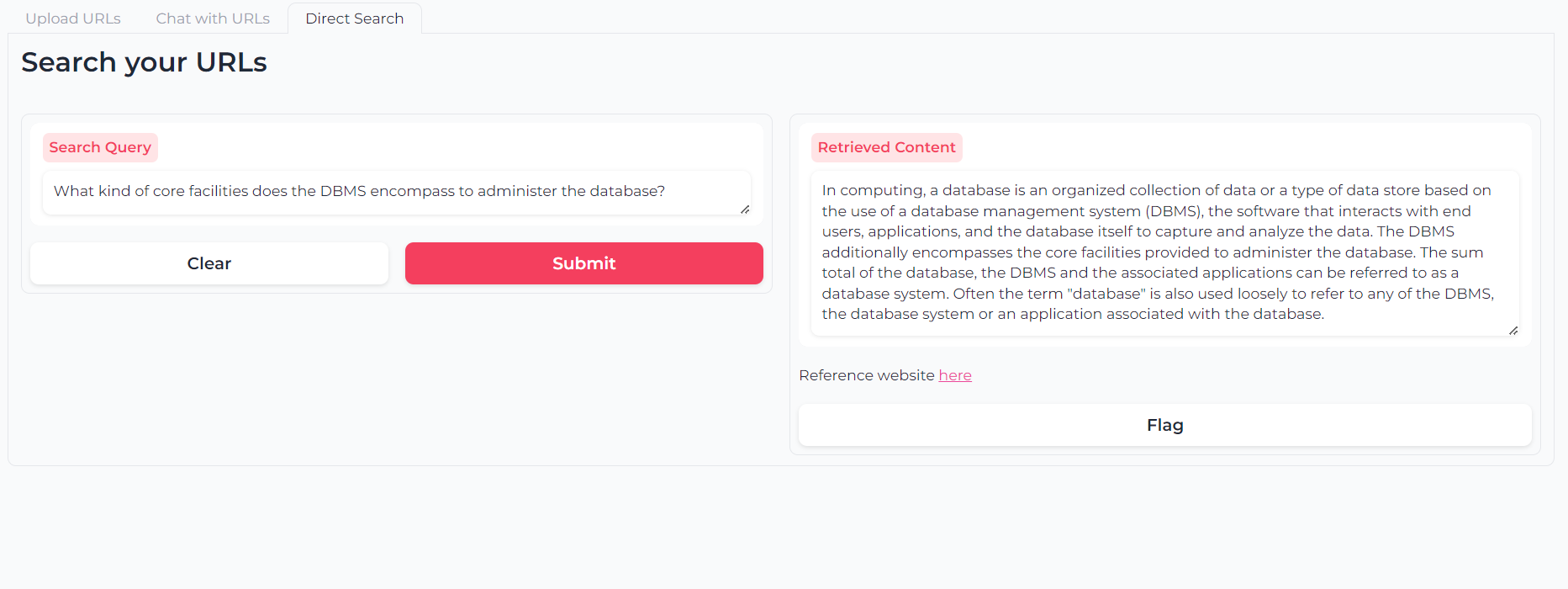

または、Double-Layered-Retrievalセマンティック検索を使用して、URLコンテンツを直接照会することもできます。

ソフトウェアは、MITライセンスの下で提供されるオープンソースです(常に)。

著者であるアストラ・クレリア・バテリが引用されている限り、誰でもその一部を使用、変更、再配布できます。

貢献は常に大歓迎です!問題にフラグを立てたり、PRを開いたり、著者に連絡して、変更を提案したり、機能を要求したり、コードを改善したりしてください。

アプリケーションが有用であることがわかった場合は、改善を許可するために資金を調達することを検討してください!