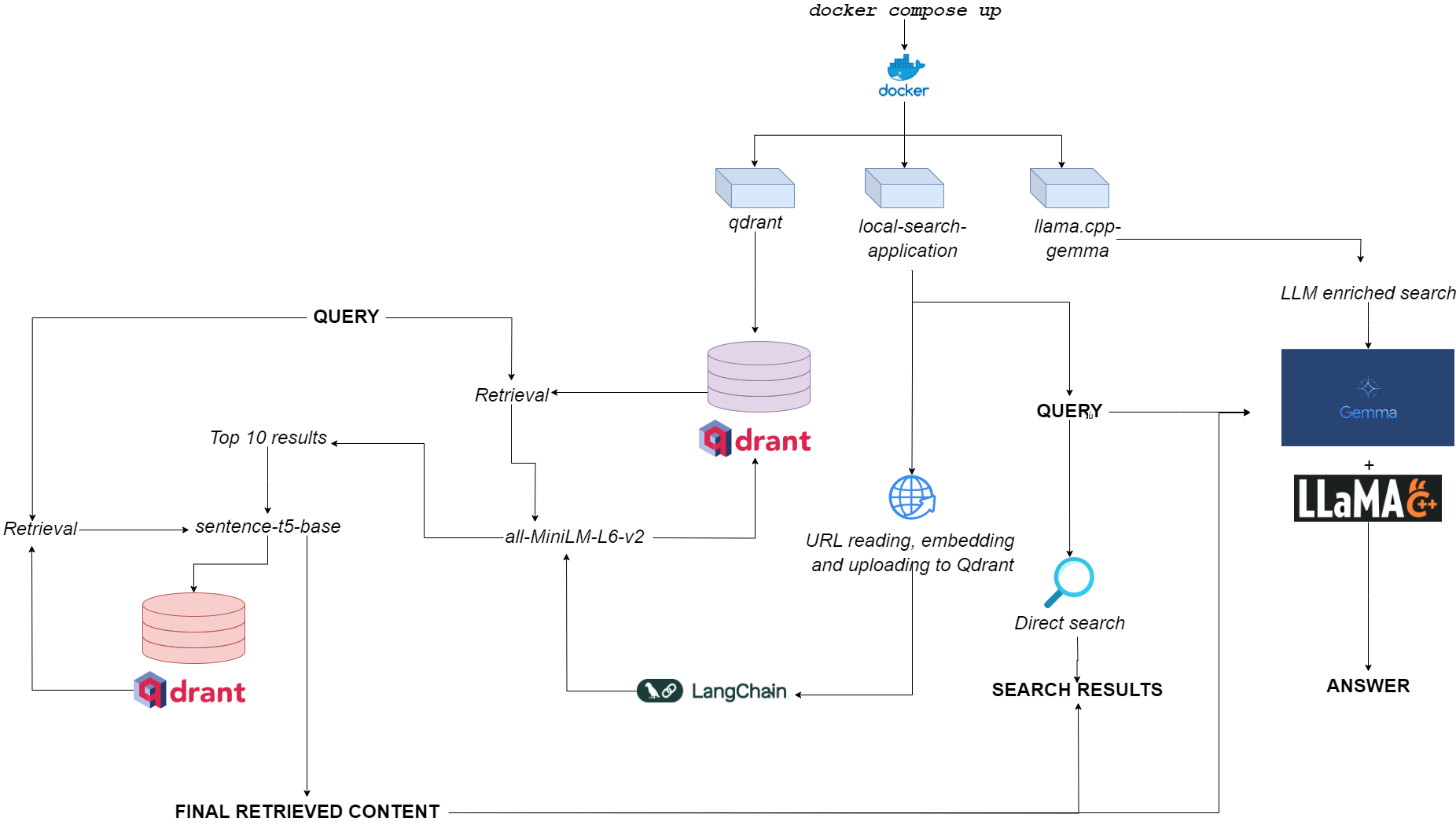

مخطط انسيابي ل qdurllm

Qdurllm ( QD Rant url s و l arge l anguage m odels) هو محرك بحث محلي يتيح لك تحديد محتوى عنوان URL وتحميله إلى قاعدة بيانات متجه: بعد ذلك ، يمكنك البحث والرد والدردشة مع هذا المحتوى.

يتم توفير هذا من خلال تطبيق Docker متعدد اللقاح ، والاستفادة من Qdrant ، و Langchain ، و llama.cpp ، و gemma الكمي والخريجي.

تتجه إلى الفضاء التجريبي على Luggingface؟

الشرط الوحيد هو أن يكون لديك docker و docker-compose .

إذا لم يكن لديكهم ، فتأكد من تثبيتها هنا.

يمكنك تثبيت التطبيق عن طريق استنساخ مستودع github

git clone https://github.com/AstraBert/qdurllm.git

cd qdurllm أو يمكنك ببساطة لصق النص التالي في ملف compose.yaml :

networks :

mynet :

driver : bridge

services :

local-search-application :

image : astrabert/local-search-application

networks :

- mynet

ports :

- " 7860:7860 "

qdrant :

image : qdrant/qdrant

ports :

- " 6333:6333 "

volumes :

- " ./qdrant_storage:/qdrant/storage "

networks :

- mynet

llama_server :

image : astrabert/llama.cpp-gemma

ports :

- " 8000:8000 "

networks :

- mynetوضع الملف في أي دليل تريده في نظام الملفات الخاص بك.

قبل تشغيل التطبيق ، يمكنك اختياريًا سحب جميع الصور المطلوبة من Docker Hub:

docker pull qdrant/qdrant

docker pull astrabert/llama.cpp-gemma

docker pull astrabert/local-search-applicationعند إطلاق (انظر الاستخدام) ، يدير التطبيق ثلاث حاويات:

qdrant (المنفذ 6333): يعمل كمزود قاعدة بيانات متجه لاسترجاع البحث الدلالي للبحثllama.cpp-gemma (المنفذ 8000): هذا تطبيق لنموذج GEMMA الكمي الذي يقدمه LMStudio و Google ، ويقدم مع llama.cpp Server. هذا يعمل مع نطاقات توليد النص ، وإثراء تجربة البحث للمستخدم.local-search-application (المنفذ 7860): واجهة جدوى مع:llama.cpp-gemmaall-MiniLM-L6-v2 (الذي يحدد أفضل 10 مباريات) sentence-t5-base (التي تعيد ترميز أفضل 10 مباريات وتستخرج أفضل نجاح منها)-هذا هو نفس تطبيق RAT بالتواصل مع llama.cpp-gemma . هل تريد أن ترى كيف تؤدي قطعة قماش مزدوجة الطبقة مقارنة بالقطعة ذات الطبقات الواحدة؟ توجه هنا!يعد العبء الحسابي العام خفيفًا بما يكفي لجعل التطبيق يعمل ليس فقط GPULESS ، ولكن أيضًا مع توفر ذاكرة الوصول العشوائي المنخفض (> = 8 جيجابايت ، على الرغم من أنه قد يستغرق ما يصل إلى 10 دقائق حتى تستجيب GEMMA على ذاكرة وصول عشوائي 8 جيجابايت).

يمكنك جعل التطبيق يعمل مع الأمر التالي - بسيط حقًا - يجب تشغيله ضمن نفس الدليل حيث قمت بتخزين ملف compose.yaml :

docker compose up -d إذا كنت قد قمت بالفعل بسحب جميع الصور ، فستجد التطبيق الذي يعمل على http://localhost:7860 أو http://0.0.0.0:7860 في أقل من دقيقة.

إذا لم تكن قد قمت بسحب الصور ، فسيتعين عليك الانتظار في اكتمال التثبيت قبل استخدام التطبيق بالفعل.

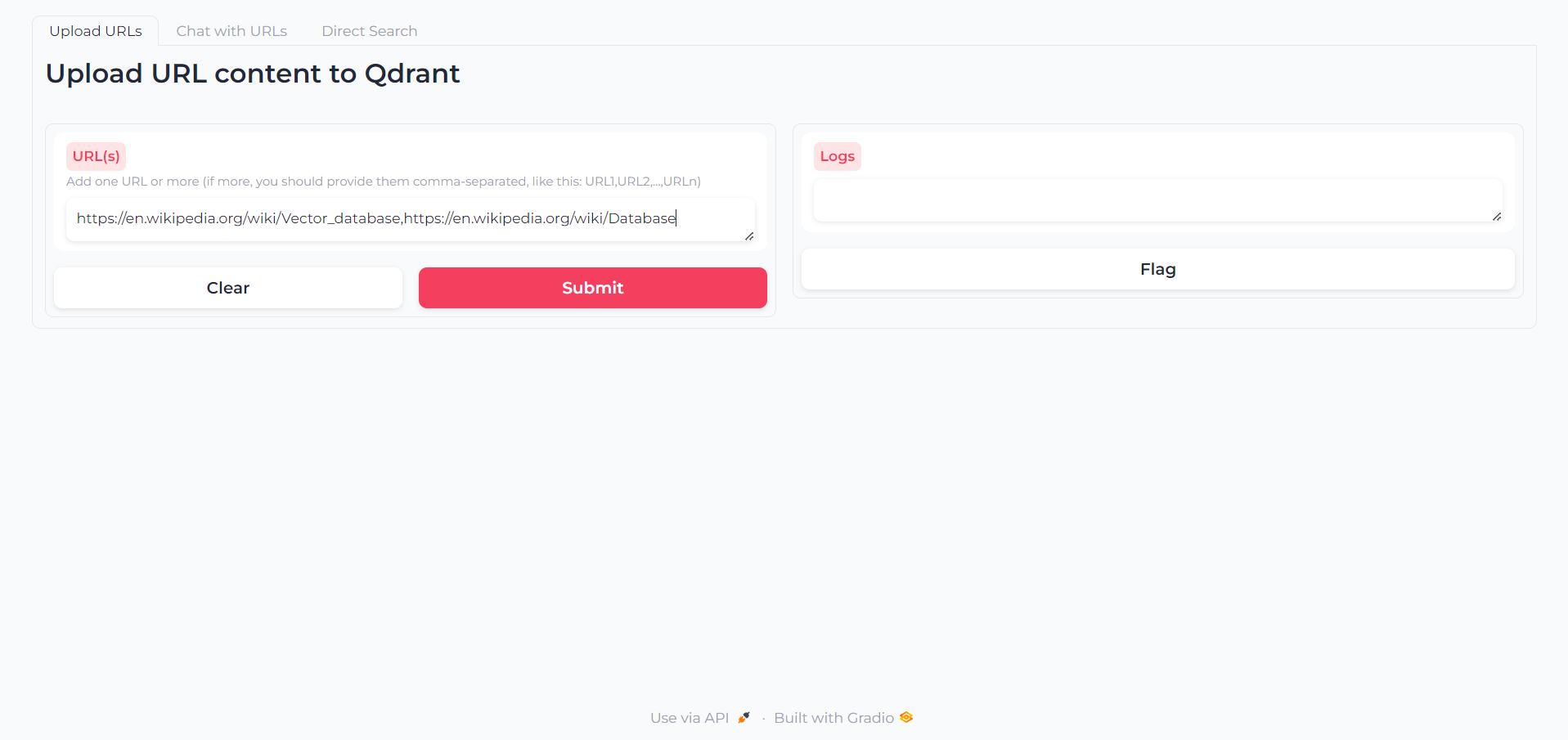

بمجرد تحميل التطبيق ، ستجد علامة تبويب أولى يمكنك من خلالها كتابة عنوان URL الذي تريد التفاعل معه:

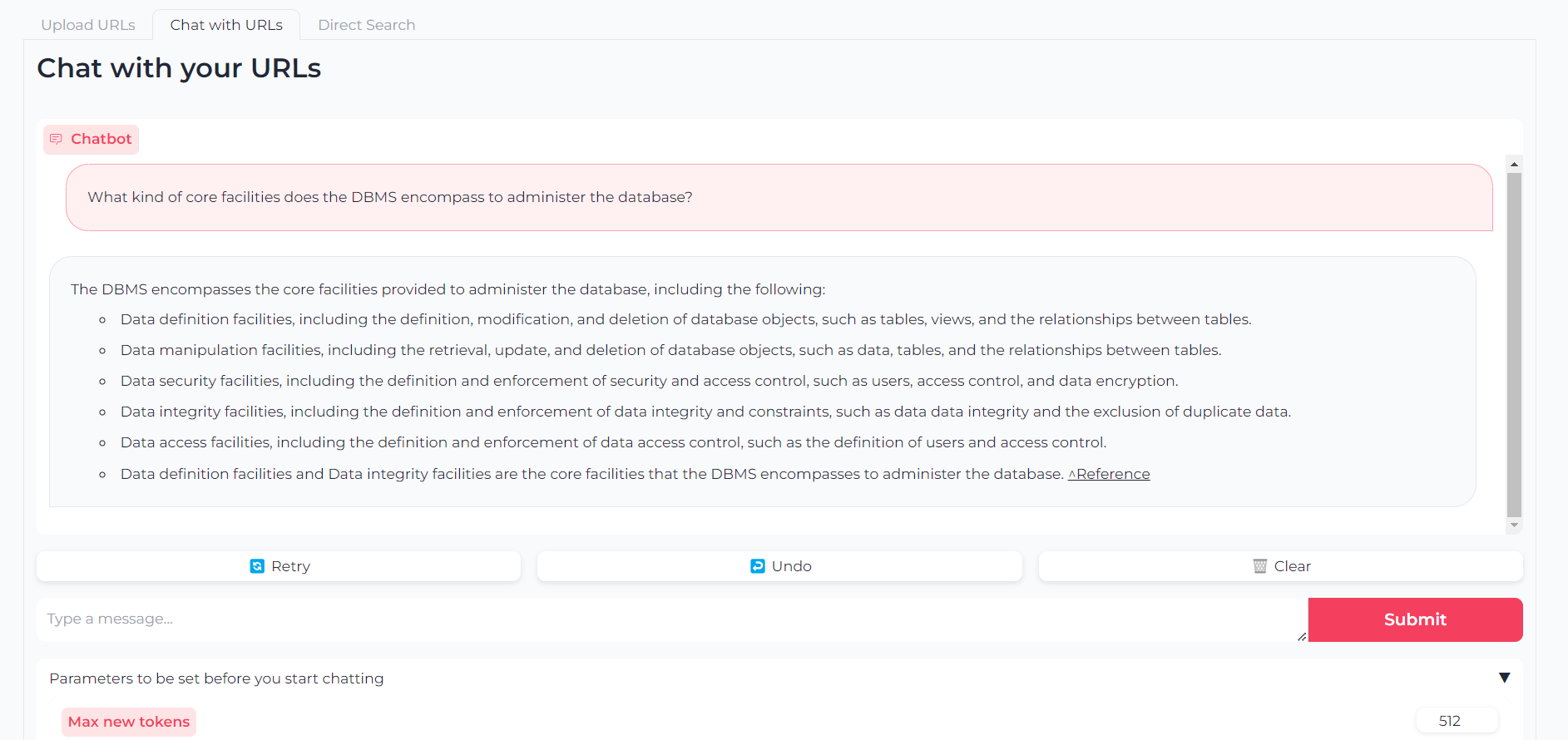

الآن وقد تم تحميل عناوين URL الخاصة بك ، يمكنك إما الدردشة مع محتواها من خلال llama.cpp-gemma :

لاحظ أنه يمكنك أيضًا تعيين معلمات مثل الرموز القصوى للإخراج ودرجة الحرارة وعقوبة التكرار وبذرة التوليد

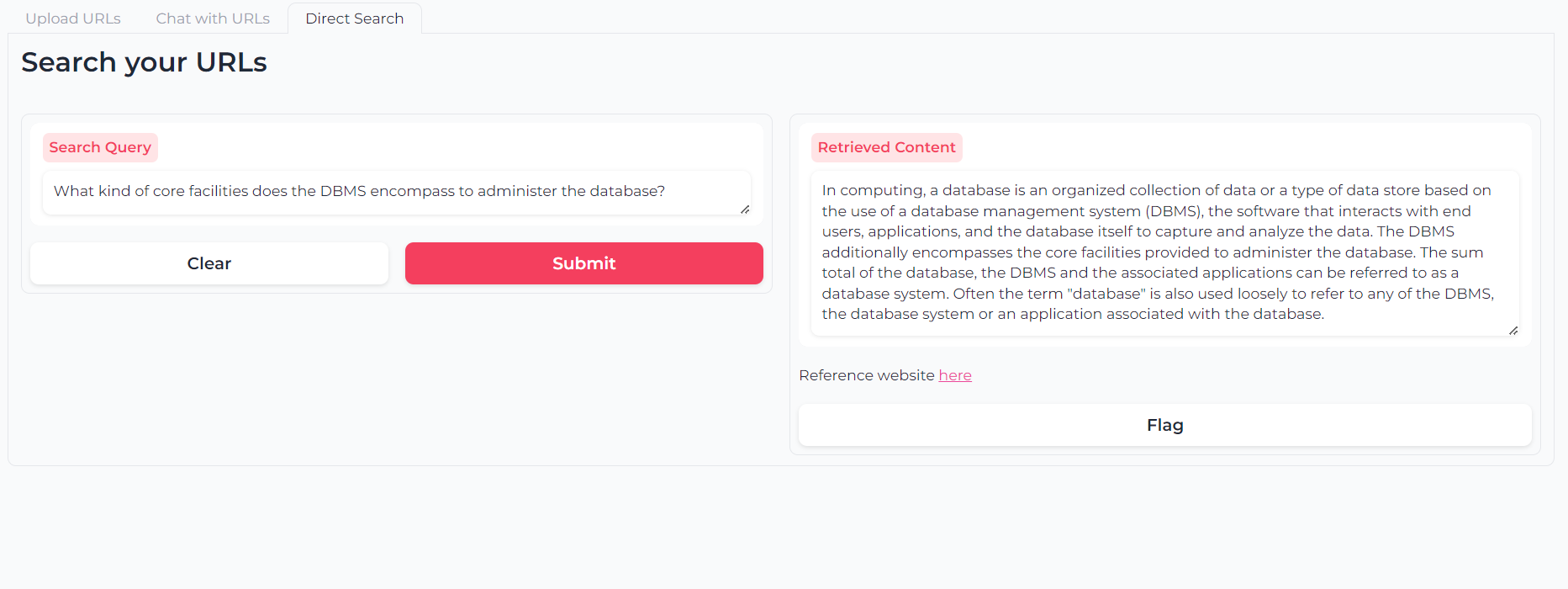

أو يمكنك استخدام البحث الدلالي ذو الطبقات المزدوجة للاستعلام عن محتوى (محتوى) عنوان URL مباشرة:

البرنامج (وسيكون دائمًا) مفتوح المصدر ، متوفر بموجب ترخيص معهد ماساتشوستس للتكنولوجيا.

يمكن لأي شخص استخدام أي جزء منه وتعديله وإعادة توزيعه ، طالما تم الاستشهاد بالمؤلف ، Astra Clelia Bertelli.

المساهمة هي دائما أكثر من موضع ترحيب! لا تتردد في الإشارة إلى المشكلات أو فتح PRS أو الاتصال بالمؤلف لاقتراح أي تغييرات أو طلب ميزات أو تحسين الرمز.

إذا وجدت التطبيق مفيدًا ، فيرجى التفكير في تمويله من أجل السماح بالتحسينات!