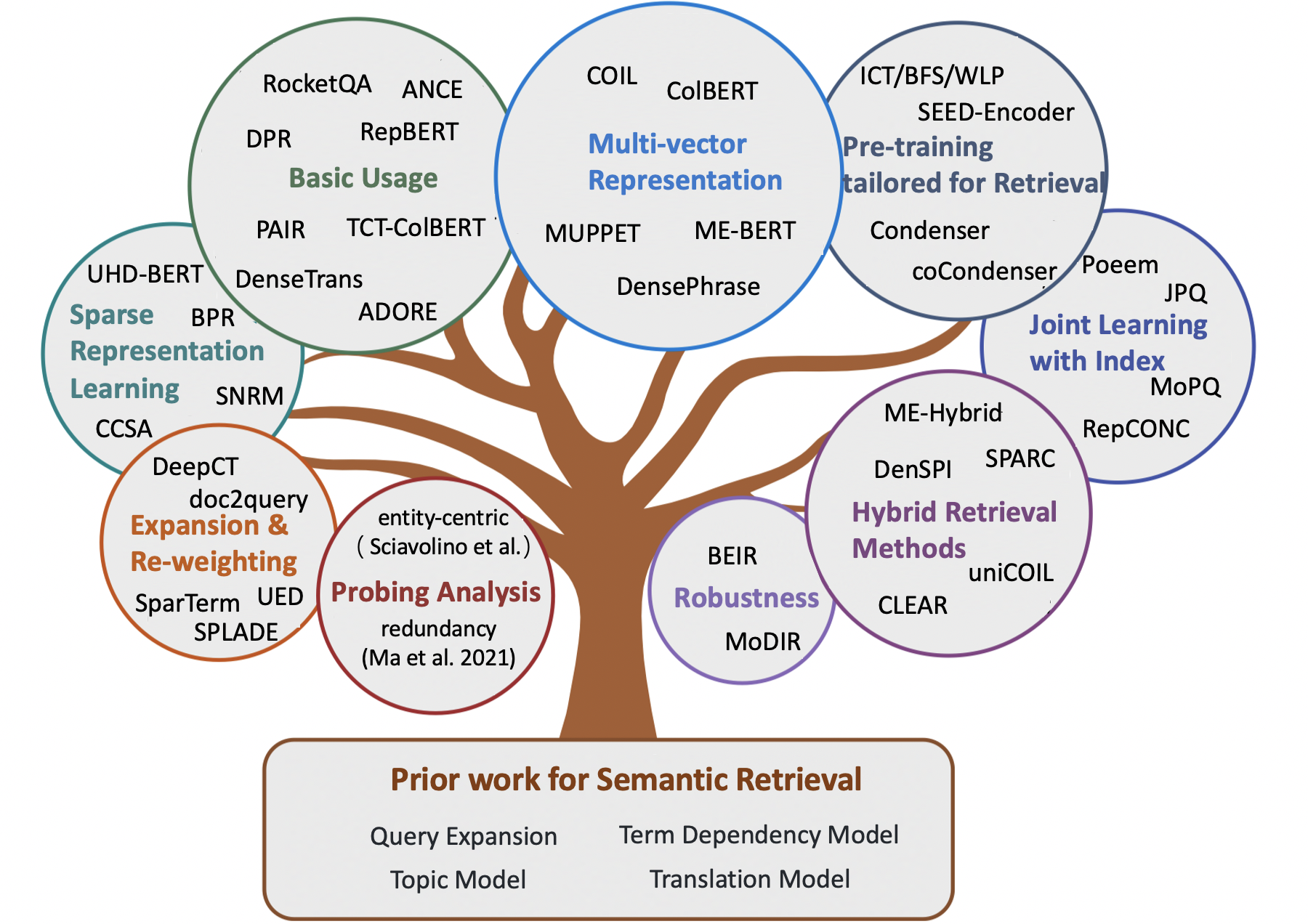

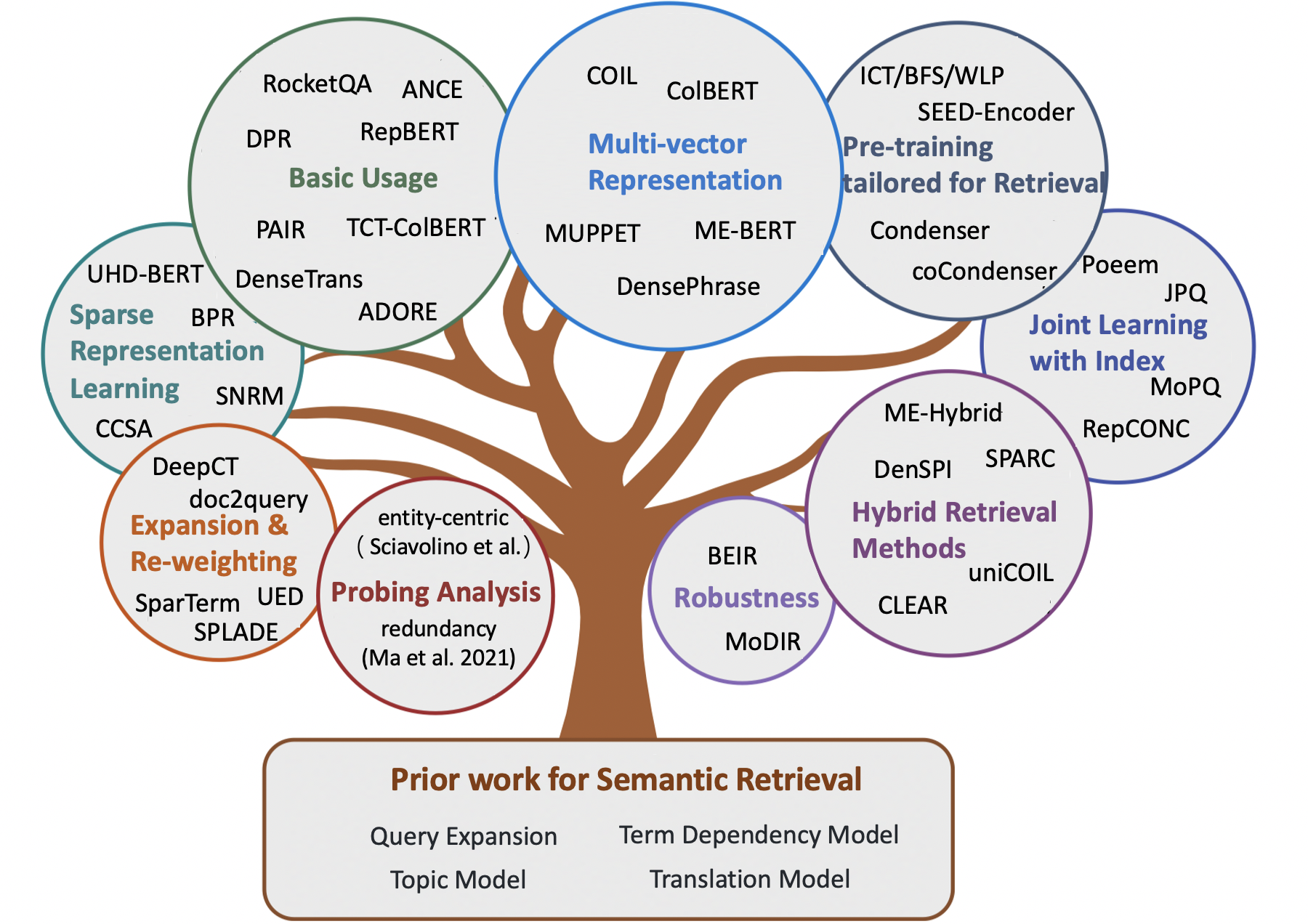

Model semantik yang luar biasa untuk pengambilan tahap pertama

Catatan:

- Daftar makalah yang mengagumkan untuk pengambilan semantik , termasuk beberapa metode awal dan model saraf terbaru untuk tugas pengambilan informasi (misalnya, pengambilan ad-hoc, QA domain terbuka, QA berbasis komunitas, dan percakapan otomatis).

- Untuk para peneliti yang ingin memperoleh model semantik untuk tahapan peringkat ulang, kami merujuk pembaca ke Survei Neuir yang mengagumkan oleh Guo et.al.

- Setiap umpan balik dan kontribusi dipersilakan, buka masalah atau hubungi saya.

Isi

- Kertas survei

- Bab 1: Pengambilan Berbasis Istilah Klasik

- Bab 2: Metode awal untuk pengambilan semantik

- Perluasan permintaan

- Ekspansi dokumen

- Model Ketergantungan Istilah

- Model topik

- Model terjemahan

- Bab 3: Metode saraf untuk pengambilan semantik

- Metode pengambilan yang jarang

- Metode pengambilan yang padat

- Metode pengambilan hibrida

- Bab 4: Sumber Daya Lainnya

- Tugas lain

- Kumpulan data

- Metode pengindeksan

Kertas survei

- Pencocokan semantik dalam pencarian (Li et al., 2014)

- Transformer Pretrained untuk Peringkat Teks: Bert and Beyond (Lin et al., 2021, Arxiv)

- Model Semantik untuk Pengambilan Tahap Pertama: Tinjauan Komprehensif (Guo et al., 2021, Tois)

- Kerangka kerja konseptual yang diusulkan untuk pendekatan representasional untuk pengambilan informasi (Lin et al., 2021, arXiv)

- Metode Pra-Pelatihan dalam Pengambilan Informasi (Fan et al., 2022, Arxiv)

- Pengambilan teks padat berdasarkan model bahasa pretrained: survei (Zhao et al., 2022, arxiv)

- Pengambilan padat sumber daya rendah untuk menjawab pertanyaan domain terbuka: survei komprehensif (Shen et al., 2022, arxiv)

- Catatan Kuliah tentang Pengambilan Informasi Saraf (Tonellotto et al., 2022, Arxiv)

Pengambilan Berbasis Istilah Klasik

- Model Ruang Vektor untuk Pengindeksan Otomatis (1975, VSM )

- Perkembangan dalam Pengambilan Teks Otomatis (1991, TFIDF )

- Pendekatan Term-Weightting dalam Pengambilan Teks Otomatis (1988, TFIDF )

- Bobot Relevansi Istilah Pencarian (1976, BIM )

- Dasar teoritis untuk penggunaan data co-kejadian dalam pengambilan informasi (1997, model ketergantungan pohon )

- Kerangka Relevansi Probabilistik: BM25 dan Beyond (2010, BM25 )

- Pendekatan Pemodelan Bahasa untuk Pengambilan Informasi (1998, QL )

- Model Bahasa Statistik untuk Pengambilan Informasi (2007, LM untuk IR )

- Model Bahasa Hypergeometrik dan Fungsi Penilaian Seperti ZIPF untuk Pengambilan Kesamaan Dokumen Web (2010, LM untuk IR )

- Model probabilistik pengambilan informasi berdasarkan pengukuran divergensi dari keacakan (2002, DFR )

Metode awal untuk pengambilan semantik

Perluasan permintaan

- Model Global

- Asosiasi kata-kata dalam sistem pengambilan dokumen (1969)

- Ekspansi Kueri Berbasis Konsep (1993)

- Ekspansi kueri menggunakan Hubungan Leksikal-Semantik (1994)

- Menggunakan konteks kueri dalam pengambilan informasi (2007)

- Model lokal

- Umpan Balik Relevansi dalam Pengambilan Informasi (1971, Rocchio PRF )

- Umpan balik berbasis model dalam pendekatan pemodelan bahasa untuk pengambilan informasi (2001, model minimalisasi divergensi )

- UMass di TREC 2004: Novelty and Hard (2004, RM3 untuk PRF )

- Memilih istilah ekspansi yang baik untuk umpan balik pseudo-relevansi (2008, prf)

- Studi perbandingan metode untuk memperkirakan model bahasa kueri dengan umpan balik semu (2009)

- Umpan balik pseudo-relevansi berdasarkan faktorisasi matriks (2016)

- Mengurangi risiko ekspansi kueri melalui optimasi terbatas yang kuat (2009 , Masalah drift kueri )

- Perluasan Permintaan Menggunakan Analisis Dokumen Lokal dan Global (2017)

Ekspansi dokumen

- Struktur Corpus, Model Bahasa, dan Pengambilan Informasi Ad Hoc (2004)

- Pengambilan Berbasis Cluster Menggunakan Model Bahasa (2004)

- Pengambilan informasi model bahasa dengan ekspansi dokumen (2006)

- Ekspansi dokumen berdasarkan WordNet untuk IR yang kuat (2010)

- Meningkatkan pengambilan teks pendek melalui ekspansi dokumen (2012)

- Perluasan Dokumen Menggunakan Koleksi Eksternal (2017, Berbasis WordNet )

- Ekspansi dokumen versus ekspansi kueri untuk pengambilan ad-hoc (2005)

Model Ketergantungan Istilah

- Eksperimen dalam pengindeksan frasa otomatis untuk pengambilan dokumen: Perbandingan metode sintaksis dan non-sintaksis (1987, VSM + Ketergantungan Term )

- Pendekatan Istilah-Weightting dalam Pengambilan Teks Otomatis (1988, VSM + Ketergantungan Term )

- Analisis frasa statistik dan sintaksis (1997, VSM + Ketergantungan istilah )

- Model Probabilistik Pengambilan Informasi: Perkembangan dan Eksperimen Komparatif (2000, VSM + Ketergantungan Istilah )

- Peringkat Relevansi Menggunakan Kernel (2010, BM25 + Ketergantungan Term )

- Model Bahasa Umum untuk Pengambilan Informasi (1999, LM + Ketergantungan Istilah )

- Model Bahasa Biterm untuk Pengambilan Dokumen (2002, LM + Ketergantungan Istilah )

- Menangkap Ketergantungan Istilah Menggunakan Model Bahasa Berdasarkan Pohon Kalimat (2002, LM + Ketergantungan Istilah )

- Model Bahasa Ketergantungan untuk Pengambilan Informasi (2004, LM + Ketergantungan Istilah )

- Teori generatif relevansi (2008)

- Model Markov Random Field untuk Ketergantungan Istilah (2005, SDM )

Model topik

- Model ruang vektor umum dalam pengambilan informasi (1985, GVSM )

- Pengindeksan oleh Analisis Semantik Laten (1990, LSI untuk IR )

- Probabilistik Pengindeksan Semantik Laten (2017, PLSA, Combine Linearly )

- Struktur Corpus, Model Bahasa, dan Pengambilan Informasi Ad Hoc (2004, Smoothing )

- Menata skor pengambilan ad hoc (2005, smoothing )

- Model dokumen berbasis LDA untuk pengambilan ad-hoc (2006, LDA untuk IR dan LDA untuk LM Smoothing )

- Sebuah studi perbandingan menggunakan model topik untuk pengambilan informasi (2009, Smoothing )

- Investigasi Kinerja Tugas Model Topik Probabilistik: Studi Empiris PLSA dan LDA (2010)

- Latent Semantic Indexing (LSI) Gagal untuk Koleksi TREC (2011)

Model terjemahan

- Pengambilan informasi sebagai terjemahan statistik (1999)

- Estimasi model terjemahan statistik berdasarkan informasi timbal balik untuk pengambilan informasi ad hoc (2010)

- Model terjemahan berbasis clickthrough untuk pencarian web: dari model kata ke model frasa (2010)

- Analisis aksiomatik model bahasa terjemahan untuk pengambilan informasi (2012)

- Kueri Menulis ulang menggunakan terjemahan mesin statistik monolingual (2010, untuk ekspansi kueri )

- Menuju model terjemahan berbasis konsep menggunakan log pencarian untuk ekspansi kueri (2012, untuk ekspansi kueri )

Metode saraf untuk pengambilan semantik

Metode pengambilan yang jarang

- Istilah re-weighting

- Mempelajari istilah berat kembali dengan representasi terdistribusi (Zheng et al., 2015, Sigir, Deeptr )

- Mengintegrasikan dan mengevaluasi embedding kata saraf dalam pengambilan informasi (Zuccon et al., 2015, ADC, NTLM )

- Istilah Pembelajaran Diskriminasi (FREJ et al, 2020, Sigir, TDV )

- Kalimat Kalimat/Jalannya Kalimat Konteks Estimasi Penting untuk Pengambilan Tahap Pertama (Dai et al., 2019, Arxiv, Deepct )

- Istilah Bobot Istilah Sadar Konteks untuk Pengambilan Saluran Tahap Pertama (Dai et al., 2020, Sigir, Deepct )

- Implikasi Efisiensi Bobot Istilah untuk Pengambilan Passage (Mackenzie et al., 2020, Sigir, Deepct )

- Istilah Dokumen Sehat Konteks Bobot untuk Pencarian Ad-Hoc (Dai et al., 2020, www, HDCT )

- Beberapa catatan singkat tentang deadimpact, coil, dan kerangka kerja konseptual untuk teknik pengambilan informasi (Lin et al., 2021, arxiv, unicoil )

- Ekspansi

- Perluasan Dokumen dengan Prediksi Permintaan (Nogueira et al., 2019, Arxiv, Doc2Query )

- Dari Doc2Query ke DoctttttQuery (Nogueira et al., 2019, Arxiv, DoctttttQuery )

- Kerangka kerja pretraining terpadu untuk peringkat dan ekspansi bagian (yan et al., 2021, aaai, ued )

- Pengambilan Generasi-Agusted untuk menjawab pertanyaan domain terbuka (Mao et al., 2020, acl, gar , ekspansi kueri )

- Ekspansi + istilah re-weight

- Ekspansi melalui prediksi pentingnya dengan kontekstualisasi (Macavaney et al., 2020, Sigir, Epic )

- Sparterm: Representasi jarang berbasis istilah pembelajaran untuk pengambilan teks cepat (Bai et al., 2020, arxiv, sparterm )

- Splade: Model Leksikal dan Ekspansi yang jarang untuk Peringkat Tahap Pertama (Formal et al., 2021, Sigir, Splade )

- Splade V2: Model leksikal dan ekspansi yang jarang untuk pengambilan informasi (Formal et al., 2021, arxiv, spladev2 )

- PEMBELAJARAN PEMBELAJARAN Dampak untuk indeks terbalik (Mallia et al., 2021, Sigir, Deepimapct )

- Tilde: Istilah Model kemungkinan independen untuk peringkat kembali (Zhuang et al., 2021, Sigir, Tilde )

- Peringkat kembali dengan cepat dengan pencocokan istilah yang tepat dan ekspansi bagian yang efisien (Zhuang et al., 2021, arxiv, tildev2 )

- SPADE: Meningkatkan representasi jarang menggunakan encoder dokumen ganda untuk pengambilan tahap pertama (Choi et al., 2022, cikm)

- Pembelajaran Representasi yang jarang

- Hashing semantik (Salakhutdinov et al., 2009)

- Dari peringkat peringkat saraf ke peringkat saraf: mempelajari representasi yang jarang untuk pengindeksan terbalik (Zamani et al., 2018, cikm, snrm )

- UHD-BERT: Representasi jarang dimensi ultra-tinggi ember untuk peringkat penuh (Jang et al., 2021, Arxiv, UHD-Bert )

- Pengambilan bagian yang efisien dengan hashing untuk menjawab pertanyaan domain terbuka (Yamada et al., 2021, ACL, BPR )

- Kode Komposit Autoencoders Jarang untuk Pengambilan Tahap Pertama (Lassance et al., 2021, Sigir, CCSA )

Metode pengambilan yang padat

- Berbasis kata-embedding

- Agregating Kata Berkelanjutan Embeddings untuk Pengambilan Informasi (Clinchant et al., 2013, ACL, FV )

- Model pengambilan informasi monolingual dan lintas-bahasa berdasarkan kata embeddings kata (bilingual) (Vulic et al., 2015, Sigir)

- Kesamaan teks pendek dengan embeddings kata (Kenter et al., 2015, cikm, oob )

- Model ruang embedding ganda untuk peringkat dokumen (Mitra et al., 2016, arxiv, desm )

- Saran Respons Bahasa Alami yang Efisien Untuk Balas Cerdas (Henderson et al., 2017, Arxiv)

- Pengambilan ujung ke ujung dalam ruang kontinu (Gillick et al., 2018, arxiv)

- Frase-indeks pertanyaan menjawab: Tantangan baru untuk pemahaman dokumen yang dapat diskalakan (Seo et al., 2018, EMNLP, PIQA )

- Pengambilan bagian lebat untuk pertanyaan domain terbuka menjawab (Karpukhin et al., 2020, EMNLP, DPR )

- Generasi Pengambilan-Agung untuk Tugas NLP Intensif Pengetahuan (Lewis et al., 2020, NIPS, RAG )

- Repbert: Embeddings teks kontekstual untuk pengambilan tahap pertama (Zhan et al., 2020, arxiv, repbert )

- Cort: Peringkat komplementer dari Transformers (Wrzalik et al., 2020, NAACL, CORT )

- DC-BERT: Decoupling Pertanyaan dan Dokumen untuk Pengkodean Kontekstual Efisien (Nie et al., 2020, Sigir, DC-Bert )

- Pengambilan saraf untuk menjawab pertanyaan dengan augmentasi data yang diawasi silang (Yang et al., 2021, ACL, augmentasi data )

- Perkiraan pembelajaran kontras negatif tetangga terdekat untuk pengambilan teks padat (Xiong et al., 2020, arxiv, ance )

- Belajar mengambil: Cara melatih model pengambilan padat secara efektif dan efisien (Zhan et al., 2020, arxiv, ltre )

- Glow: Global Bobote-Itention Network untuk Web (Shan et al, 2020, Arxiv, Glow )

- Pendekatan pelatihan yang dioptimalkan untuk pengambilan lorong padat untuk menjawab pertanyaan domain terbuka (qu et al., 2021, ACL, Rocketqa )

- Mengajarkan secara efisien retriever padat yang efektif dengan pengambilan sampel topik seimbang (Hofstätter et al., 2021, sigir, tas-seimbang )

- Mengoptimalkan pelatihan model pengambilan padat dengan negatif keras (Zhan et al., 2021, Sigir, Star/Adore )

- Beberapa shot percakapan pengambilan padat (yu et al., 2021, sigir)

- Mempelajari representasi frasa padat pada skala (Lee et al., 2021, ACL, densephrases )

- Pengambilan padat yang lebih kuat dengan pembelajaran ganda kontras (Lee et al., 2021, ictir, tari )

- Pasangan: Memanfaatkan hubungan kesamaan yang berpusat pada bagian-bagian untuk meningkatkan pengambilan lorong padat (ren et al., 2021, ACL, pasangan )

- Pengawasan yang dipandu relevansi untuk OpenQA dengan Colbert (Khattab et al., 2021, TACL, Colbert-Qa )

- Pelatihan ujung ke ujung pembaca multi-dokumen dan retriever untuk menjawab pertanyaan domain terbuka (Sachan et al., 2021, arxiv, emdr^2 )

- Meningkatkan representasi kueri untuk pengambilan padat dengan umpan balik relevansi semu (yu et al, 2021, cikm, ance-prf )

- Umpan balik pseudo-revance untuk beberapa representasi pengambilan padat (Wang et al., 2021, ictir, colbert-prf )

- Ranker semantik diskriminatif untuk pengambilan pertanyaan (Cai et al., 2021, ictir, densetrans )

- Representasi Decoupling untuk pengambilan lintasan domain terbuka (Wu et al., 2021, arxiv)

- RocketQav2: Metode pelatihan bersama untuk pengambilan lorong padat dan peringkat ulang (ren et al., 2021, EMNLP, RocketQav2 )

- Pelatihan efisien dari model pengambilan menggunakan cache negatif (Lindgren et al., 2021, Neurips)

- Pelatihan multi-tahap dengan kontras negatif yang lebih baik untuk pengambilan bagian saraf (Lu et al., 2021, EMNLP)

- Meningkatkan pengambilan skala besar berbasis embedding melalui peningkatan label (Liu et al., 2021, EMNLP)

- Pengambilan hierarkis padat untuk menjawab pertanyaan domain terbuka (Liu et al., 2021, EMNLP)

- Representasi dokumen bi-granular yang dioptimalkan secara progresif untuk pengambilan berbasis embedding yang dapat diskalakan (xiao er al., 2022 , www)

- LED: Retriever padat yang dicerahkan leksikon untuk pengambilan skala besar (Zhang et al., 2023, www)

- Aggretriever: Pendekatan sederhana untuk agregat representasi tekstual untuk pengambilan bagian yang kuat dan lebat (Lin et al., 2022, arxiv)

- Pembelajaran kontras yang sadar kalimat untuk pengambilan lintasan domain terbuka (Wu et al., 2022, ACL)

- Spesialisasi Sadar-Tugas untuk Pengambilan Padat yang Efisien dan Kuat Untuk Pertanyaan Domain Open-Domain (Cheng et al., 2022, Arxiv)

- Distilasi Pengetahuan

- Menyaring representasi padat untuk peringkat menggunakan guru yang dipasangkan erat (Lin et al., 2020, arxiv, tct-colbert )

- Pengetahuan Distilling untuk Bot-Bot Berbasis Pengambilan Cepat (Tahami et al., 2020, Sigir)

- Pengetahuan Distilling dari Pembaca untuk mengambil pertanyaan untuk menjawab pertanyaan (Izacard et al., 2020, arxiv)

- Apakah Retriever hanyalah perkiraan pembaca? (Yang et al., 2020, arxiv)

- Meningkatkan model peringkat dokumen bi-encoder dengan dua peringkat dan distilasi multi-guru (Choi et al., 2021, Sigir, TRMD )

- Meningkatkan model peringkat saraf yang efisien dengan distilasi pengetahuan lintas arsitektur (Hofstätter et al., 2021, arxiv, margin-mse kehilangan )

- Twinbert: Pengetahuan Distilling untuk Model Bert Terkompresi Twin-Struktur untuk Pengambilan Skala Besar (Lu et al., 2022, Arxiv)

- Representasi multi-vektor

- Pengambilan paragraf multi-hop untuk menjawab pertanyaan domain terbuka (Feldman et al., 2019, ACL, Muppet )

- Representasi jarang, padat, dan perhatian untuk pengambilan teks (Luan et al., 2020, TACL, ME-BERT )

- Colbert: Pencarian perikop yang efisien dan efektif melalui interaksi akhir kontekstual atas Bert (Khattab et al., 2020, Sigir, Colbert )

- COIL: Kunjungi kembali kecocokan leksikal yang tepat dalam pengambilan informasi dengan daftar terbalik yang dikontekstualisasikan (Gao et al., 2021, NaCl, koil )

- Meningkatkan representasi dokumen dengan menghasilkan embedding kueri pseudo untuk pengambilan padat (Tang et al., 2021, ACL)

- Frase pengambilan belajar pengambilan bagian, juga (Lee et al., 2021, eMNLP, densephrases )

- Permintaan menanamkan pemangkasan untuk pengambilan padat (Tonellotto et al., 2021, cikm)

- Pembelajaran representasi dokumen multi-view untuk pengambilan padat domain terbuka (Zhang et al., 2022, ACL)

- Colbertv2: Pengambilan yang efektif dan efisien melalui interaksi akhir yang ringan (Santhanam, 2022, NAACL)

- Mempelajari beragam representasi dokumen dengan interaksi kueri yang mendalam untuk pengambilan padat (Li et al., 2022, arxiv)

- Model berbasis representasi teks berbutir topik untuk pengambilan dokumen (du et al., 2022, icann)

- Mempercepat model berbasis interaksi

- Menggabungkan Asumsi Independensi Istilah Kueri untuk Pengambilan dan Peringkat yang Efisien Menggunakan Jaringan Saraf Deep (Mitra et al., 2019, Arxiv)

- Peringkat saraf berbasis interaksi yang efisien dengan hashing sensitif lokalitas (ji et al., 2019, www)

- Poly-encoders: Arsitektur dan strategi pra-pelatihan untuk skor multi-kalimat yang cepat dan akurat (Humeau et al., 2020, ICLR, Poly-Enderers )

- Kerangka Peringkat Berbasis Transfomer Modularisasi (Gao et al., 2020, EMNLP, Mores )

- Dokumen yang efisien peringkat ulang untuk transformator dengan precomputing istilah representasi (Macavaney et al., 2020, Sigir, prettr )

- Deformer: Mengurangi transformator terlatih untuk menjawab pertanyaan yang lebih cepat (Cao et al., 2020, ACL, Deformer )

- Sparta: Pertanyaan domain terbuka yang efisien menjawab melalui pengambilan pencocokan transformator yang jarang (Zhao et al., 2020, Arxiv, Sparta )

- Konformer-Kernel dengan kueri Istilah independensi untuk pengambilan dokumen (Mitra et al., 2020, arxiv)

- Inttower: Generasi berikutnya dari model dua menara untuk sistem pra-peringkat (Li et al., 2022, Cikm)

- Pra-pelatihan

- Pengambilan laten untuk menjawab pertanyaan domain terbuka yang diawasi dengan lemah (Lee et al., 2019, ACL, ORQA )

- Model Bahasa Augmented Retrieval Pra-Pelatihan (Guu et al., 2020, ICML, REALM )

- Tugas pra-pelatihan untuk pengambilan skala besar berbasis embedding (Chang et al., 2020, ICLR, BFS+WLP+MLM )

- Apakah model bahasa Anda siap untuk fine-tuning representasi padat? (Gao et al., 2021, EMNLP, kondensor )

- Corpus Aware Bahasa Model Pra-Pelatihan Tanpa Pengawasan Untuk Pengambilan Jalinan Lebat (Gao et al., 2021, Arxiv, Cocondenser )

- Less is More: Pra-pelatihan Encoder Siam yang kuat menggunakan dekoder lemah (Lu et al., 2021, EMNLP, biji-encoder )

- Model bahasa pra-terlatih untuk pengambilan skala web dalam pencarian baidu (liu et al., 2021, kdd)

- Pra-pelatihan untuk pengambilan ad-hoc: Hyperlink juga Anda membutuhkan (Ma et al., 2021, Cikm, Harp )

- Pra-pelatihan enkoder teks diskriminatif untuk pengambilan padat melalui prediksi rentang kontras (Ma et al., 2022, Sigir)

- TSDAE: Menggunakan Denoising Auto-encoder beruroisasi berbasis transformator untuk kalimat tanpa pengawasan yang menanamkan pembelajaran (Wang et al., 2021, EMNLP)

- Auto-encoder topeng kontekstual untuk pengambilan lorong padat (wu et al., 2022, arxiv)

- SIMLM: Pra-pelatihan dengan kemacetan representasi untuk pengambilan lorong padat (Wang et al., 2022, arxiv)

- Lexmae: pretraining leksikon-bottlenecked untuk pengambilan skala besar (Shen et al., 2022, arxiv)

- Pendekatan pra-pelatihan yang kontras untuk mempelajari autoencoder diskriminatif untuk pengambilan padat (Ma et al., 2022, Cikm)

- Retromae: Model bahasa yang berorientasi pada pra-pelatihan melalui auto-encoder bertopeng (Xiao dan Liu et al., 2022, EMNLP)

- Model bahasa pra-pelatihan masking orientasi pengambilan untuk pengambilan lorong padat (Long et al., 2022, arxiv)

- Laprador: Retriever padat pretrained tanpa pengawasan untuk pengambilan teks nol-shot (Xu et al., 2022, ACL)

- Autoencoders bertopeng sebagai pelajar terpadu untuk representasi kalimat pra-terlatih (Liu et al., 2022, arxiv)

- Master: Autoencoder bertopeng pra-terlatih multi-tugas terlatih lebih baik (Zhou et al., 2023, iclr)

- COT-MAE V2: Kontekstual bertopeng auto-encoder dengan pemodelan multi-view untuk pengambilan bagian (wu et al., 2023, arxiv)

- COT-MOTE: Menjelajahi pra-pelatihan Auto-encoder bertopeng kontekstual dengan pencampur-ekspertasi-tekstual untuk pengambilan bagian (ma et al., 2023, arxiv)

- Pembelajaran bersama dengan indeks

- Pembelajaran bersama model pengambilan dalam dan indeks embedding berbasis kuantisasi produk (Zhang et al., 2021, Sigir, Poeem )

- Onden Optimalisasi Encoder dan Kuantisasi Produk untuk meningkatkan kinerja pengambilan (Zhan et al., 2021, Cikm, JPQ ))) ((((, 2021, JPQ)

- Kuantisasi Produk Berorientasi Pencocokan untuk Pengambilan Ad-Hoc (Xiao et al., 2021, EMNLP, MOPQ )

- Belajar representasi diskrit melalui pengelompokan terbatas untuk pengambilan padat yang efektif dan efisien (Zhan et al, 2022, WSDM, REPCONC )

- Pembelajaran bersama dengan Ranker

- Pelatihan end-to-end dari pengambil saraf untuk menjawab pertanyaan domain terbuka (Sachan et al., 2021, ACL)

- Peringkat retriever appersarial untuk pengambilan teks padat (Zhang et al., 2022, iclr)

- Debias

- Mempelajari model pengambilan padat yang kuat dari label relevansi yang tidak lengkap (Prakash et al., 2021, Sigir, Rance )

- Negatif keras atau negatif palsu: mengoreksi bias pengumpulan dalam pelatihan model peringkat saraf (cai et al., 2022, cikm)

- Simans: Pengambilan sampel negatif ambigu sederhana untuk pengambilan teks padat (Zhou et al., 2022, EMNLP)

- Pembelajaran kontras yang debias dari representasi kalimat tanpa pengawasan (Zhou et al., 2022, ACL)

- Pemulihan emas dari pasir hitam: pengambilan lorong padat multibahasa dengan sampel negatif keras dan palsu (Shen et al., 2022, EMNLP)

- Zero-shot/beberapa-shot

- Pengambilan nol-shot berbasis embedding melalui generasi kueri (Liang et al., 2020, arxiv)

- Pengambilan Neural Passage Zero-Shot melalui Generasi Pertanyaan Sintetis Target Domain (Ma et al., 2020, qgen , arxiv)

- Menuju model pengambilan saraf yang kuat dengan pra-pelatihan sintetis (Reddy et al., 2021, arxiv)

- Beir: tolok ukur heterogen untuk evaluasi zero-shot dari model pengambilan informasi (Thakur et al., 2021, Neurips)

- Pengambilan padat zero-shot dengan momentum representasi invarian domain permusuhan (xin et al., 2021, arxiv, modir )

- Encoder ganda besar adalah generalizable retriever (ni et al., 2022, eMNLP, dtr )

- Semantik out-of-domain untuk menyelamatkan! Model Pengambilan Hibrida Zero-Shot (Chen et al., 2022, ECIR)

- Inpars: augmentasi data untuk pengambilan informasi menggunakan model bahasa besar (Bonifacio et al., 2022, arxiv)

- Menuju pengambilan informasi padat tanpa pengawasan dengan pembelajaran kontras (Izacard et al., 2021, arXiv, contrliever )

- GPL: Pelabelan semu generatif untuk adaptasi domain yang tidak diawasi dari pengambilan padat (Wang et al., 2022, NaaCl)

- Belajar mengambil bagian tanpa pengawasan (Ram et al., 2021, Arxiv, Spider )

- Pemeriksaan menyeluruh pada pengambilan padat zero-shot (ren et al., 2022, arxiv)

- Teks dan kode embeddings dengan pra-pelatihan kontras (neelakantan et al., 2022, arxiv)

- Pemodelan domain dan relevansi yang terpencil untuk pengambilan padat yang dapat disesuaikan (Zhan et al., 2022, arxiv)

- Promptagator: beberapa pengambilan padat beberapa-shot dari 8 contoh (dai et al., 2022, arxiv)

- Pertanyaan adalah semua yang Anda butuhkan untuk melatih bagian lebat retriever (Sachan et al., 2022, tacl)

- Hyper: Pelatihan Hyper-Prompted Multitask memungkinkan generalisasi pengambilan skala besar (Cai et al., 2023, ICLR)

- Coco-DR: Memerangi pergeseran distribusi dalam pengambilan padat nol-shot dengan pembelajaran yang kontras dan kuat secara distribusi (Yu et al., 2022, EMNLP)

- Tantangan dalam Generalisasi dalam Pertanyaan Domain Terbuka Menjawab (Liu et al., 2022, NAACL)

- Ketahanan

- Menuju pengambilan padat yang kuat melalui peringkat peringkat lokal (Chen et al., 2022, ijcai)

- Berurusan dengan kesalahan ketik untuk pengambilan dan peringkat bagian Bert Bert (Zhuang et al., 2021, EMNLP)

- Mengevaluasi ketahanan pipa pengambilan dengan generator variasi kueri (Penha et al., 2022, ecir)

- Menganalisis kekokohan encoder ganda untuk pengambilan padat terhadap kesalahan (Sidiropoulos et al., 2022, Sigir)

- Karakterbert dan pengajaran sendiri untuk meningkatkan ketahanan pengambil yang padat pada pertanyaan dengan kesalahan ketik (Zhuang et al., 2022, Sigir)

- Bert Rankers rapuh: Sebuah studi menggunakan gangguan dokumen permusuhan (Wang et al., 2022, ictir)

- Pesanan-Disorder: Serangan permusuhan imitasi untuk model peringkat neural blackbox (Liu et al., 2022, arxiv)

- Typos-Sadar Bottlenecked pra-pelatihan untuk pengambilan padat yang kuat (Zhuang et al., 2023, arxiv)

- Analisis penyelidikan

- Kutukan pengambilan informasi dimensi rendah yang padat untuk ukuran indeks besar (Reimers et al., 2021, ACL)

- Penghapusan redundansi tanpa pengawasan yang sederhana dan efektif untuk mengompres vektor padat untuk pengambilan bagian (ma et al., EMNLP, 2021, redundansi )

- Beir: tolok ukur heterogen untuk evaluasi zero-shot dari model pengambilan informasi (Thakur et al., 2021, neurips, transferabilitas )

- Frasa penting yang sadar pengambilan padat: dapatkah retriever padat meniru jarang? (Chen et al., 2021, arxiv)

- Pertanyaan Sederhana Entitas-sentris menantang retriever padat (Sciavolino et al., 2021, EMNLP)

- Menafsirkan pengambilan padat sebagai campuran topik (Zhan et al., 2021, arxiv)

- Analisis atribusi encoder untuk retriever bagian-bagian padat dalam menjawab pertanyaan domain terbuka (Li et al., 2022, trustnlp)

- Representasi isotropik dapat meningkatkan pengambilan padat (Jung et al., 2022, arxiv)

- Pembelajaran yang cepat

- Model peringkat saraf bi-encoder semi-simese menggunakan fine-tuning ringan (Jung et al., 2022, www)

- Tersebar atau terhubung? Pendekatan penyetelan parameter-efisien yang dioptimalkan untuk pengambilan informasi (Ma et al., 2022, Cikm)

- DPTDR: Tuning prompt yang dalam untuk pengambilan lorong padat (Tang et al., 2022, arxiv)

- Parameter-efisien penyetelan prompt membuat pengambilan teks saraf umum dan terkalibrasi (Tam et al., 2022, arxiv)

- NIR-Prompt: Kerangka pelatihan pengambilan informasi saraf multi-tugas umum (Xu et al., 2022, arXiv)

- Model bahasa besar untuk pengambilan

- Pengambilan padat nol-shot yang tepat tanpa label relevansi (Gao et al., 2022, arxiv)

- Yang lain

- Hlatr: Tingkatkan pengambilan teks multi-tahap dengan daftar hibrida yang sadar transformator reranking (Zhang et al., 2022, arxiv)

- Asyncval: Toolkit untuk secara tidak sinkron memvalidasi pos pemeriksaan retriever selama pelatihan (Zhuang et al., 2022, Sigir)

Metode pengambilan hibrida

- Berbasis kata-embedding

- Model pengambilan informasi monolingual dan lintas-bahasa berdasarkan kata embeddings kata (bilingual) (Valic et al., 2015, sigir, gabungan linear )

- Model Bahasa Generalisasi Berdasarkan Kata untuk Pengambilan Informasi (Ganguly et al., 2015, Sigir, GLM )

- Mewakili dokumen dan pertanyaan sebagai set vektor tertanam kata untuk pengambilan informasi (roy et al., 2016, sigir, linear combine )

- Model ruang embedding ganda untuk peringkat dokumen (Mitra et al., 2016, www, desm_mixture , kombinasi linear )

- Off the Beaten Path: Mari kita ganti pengambilan berbasis istilah dengan pencarian K-NN (Boytsov et al., 2016, Cikm, BM25+Model Terjemahan )

- Mempelajari representasi hibrida untuk mengambil pertanyaan setara secara semantik (Santos et al., 2015, ACL, Bow-CNN )

- Pertanyaan domain terbuka real-time menjawab dengan indeks frase-sparse padat (seo et al., 2019, acl, denspi )

- Representasi jarang kontekstual untuk pertanyaan domain terbuka real-time (Lee et al., 2020, ACL, SPARC )

- CORT: Peringkat komplementer dari Transformers (Wrzalik et al., 2020, NAACL, CORT_BM25 )

- Representasi jarang, padat, dan perhatian untuk pengambilan teks (Luan et al., 2020, TACL, Me-Hybrid )

- Komplemen Model Pengambilan Leksikal dengan Empantic Residual Embeddings (Gao et al., 2020, ECIR, CLEAR )

- Memanfaatkan pencocokan semantik dan leksikal untuk meningkatkan penarikan sistem pengambilan dokumen: pendekatan hibrida (Kuzi et al., 2020, arxiv, hibrida )

- Beberapa catatan singkat tentang deadimpact, coil, dan kerangka kerja konseptual untuk teknik pengambilan informasi (Lin et al., 2021, arxiv, unicoil )

- Bobot relevansi offline kontekstual untuk pengambilan saraf yang efisien dan efektif (Chen et al., 2021, Sigir)

- Memprediksi efisiensi/efektivitas pertukaran untuk pemilihan strategi pengambilan yang padat vs jarang (Arabzadeh et al., 2021, cikm)

- Indeks maju cepat untuk peringkat dokumen yang efisien (Leonhardt et al., 2021, arxiv)

- Representasi jarang yang memadatkan untuk pengambilan bagian dengan pengiralan representasional (Lin et al., 2021, arxiv)

- Uni fi er: Retriever unifed untuk pengambilan skala besar (Shen et al., 2022, arxiv)

Sumber daya lainnya

Tugas lain

- Pencarian e-commerce

- Jaringan Minat Deep untuk Prediksi Tingkat Klik-Melalui (Zhou et al., 2018, KDD, DIN )

- Dari pengambilan semantik ke peringkat berpasangan: Menerapkan pembelajaran mendalam dalam pencarian e-commerce (Li et al., 2019, Sigir, Jingdong)

- Jaringan multi-minat dengan routing dinamis untuk rekomendasi di Tmall (Li et al., 2019, Cikm, Mind , Tmall)

- Menuju pengambilan yang dipersonalisasi dan semantik: Solusi ujung ke ujung untuk pencarian e-commerce melalui pelajaran embedding (Zhang et al., 2020, Sigir, DPSR , Jingdong)

- Jaringan multi-minat yang dalam untuk prediksi laju klik-tayang (Xiao et al., 2020, Cikm, Dmin )

- Pengambilan dalam: Model struktur yang dapat dipelajari dari ujung ke ujung untuk rekomendasi skala besar (Gao et al., 2020, arxiv)

- Pengambilan produk berbasis embedding dalam pencarian Taobao (Li et al., 2021, KDD, Taobao)

- Merangkul struktur dalam data untuk pencarian produk semantik miliar skala (Lakshman et al., 2021, Arxiv, Amazon)

- Pencarian yang disponsori

- Mobius: Menuju generasi berikutnya dari pencocokan kueri-AD dalam pencarian yang disponsori Baidu (Fan et al., 2019, KDD, Baidu)

- Pengambilan gambar

- Hashing jaringan saraf biner untuk pengambilan gambar (Zhang et al., 2021, sigir, bnnh )

- Hashing adaptif diri yang dalam untuk pengambilan gambar (Lin et al., 2021, cikm, dsah )

- Laporan Lokakarya Hipstir Pertama tentang Masa Depan Pengambilan Informasi (Dietz et al., 2019, Sigir, Workshop)

- Mari kita ukur waktu lari! Memperluas infrastruktur replikasi IR untuk memasukkan aspek kinerja (Hofstätter et al., 2019, Sigir)

- Pengambilan berbasis penyematan dalam pencarian Facebook (Huang et al., 2020, KDD, EBR )

- Belajar K-Way D-dimensi kode diskrit untuk representasi embedding kompak (Chen et al., 2018, ICML)

Kumpulan data

- 【MS Marco】 MS Marco: Dataset pemahaman pembacaan mesin manusia yang dihasilkan manusia

- 【TREC CAR】 TREC Complex Jawaban Jawaban Pengambilan

- 【TREC DL】 Gambaran Umum Lagu Pembelajaran Deep TREC 2019

- 【TREC COVID】 TREC-COVID: Membangun Koleksi Tes Pengambilan Informasi Pandemi

Metode pengindeksan

- Berbasis pohon

- Pohon pencarian biner multidimensi yang digunakan untuk pencarian asosiatif (1975, pohon kd )

- Mengganggu

- Berbasis hashing

- Perkiraan Tetangga terdekat: Menuju Menghapus Kutukan Dimensionalitas (1998, LSH )

- Berbasis kuantisasi

- Kuantisasi Produk untuk Pencarian Tetangga terdekat (2010, PQ )

- Kuantisasi Produk yang Dioptimalkan (2013, OPQ )

- Berbasis grafik

- Navigasi di Dunia Kecil (2000, NSW )

- Perkiraan efisien dan kuat Pencarian tetangga terdekat menggunakan grafik dunia kecil yang dapat dilayari hierarkis (2018, HNSW )

- Toolkit

- FAISS: Perpustakaan untuk Pencarian Kesamaan yang Efisien dan pengelompokan vektor padat

- Sptag: Perpustakaan untuk Perkiraan Cepat Pencarian Tetangga terdekat

- OpenMatch: Paket sumber terbuka untuk pengambilan informasi

- Pyserini: Toolkit Python untuk penelitian pengambilan informasi yang dapat direproduksi dengan representasi yang jarang dan padat

- Elasticsearch