Simpan dan sajikan model bahasa yang diminta

prompt-serve membantu Anda mengelola semua permintaan model bahasa besar Anda (LLM) dan pengaturan/metadata terkait dengan cara yang dikendalikan secara langsung dan terkontrol.

Proyek ini menyediakan skema YAML untuk menyimpan prompt dengan cara terstruktur dan server API kecil yang menangani interaksi dengan repositori git, sehingga Anda dapat memperlakukan petunjuk lebih seperti kode yang dapat digunakan kembali.

Prompt mengikuti skema yang disediakan dalam skema.yml.

Lihat repositori prompt untuk melihatnya beraksi.

title : prompt-title-or-name

uuid : prompt-uuid

description : prompt-description

category : prompt-category

provider : model-provider

model : model-name

model_settings :

temperature : 0.8

top_k : 40

top_p : 0.9

prompt : prompt-text

input_variables :

- var1

- var2

references :

- https://example.com

- https://example.com

associations :

- prompt_uuid

- prompt_uuid

packs :

- pack-uuid

- pack-uuid

tags :

- tag

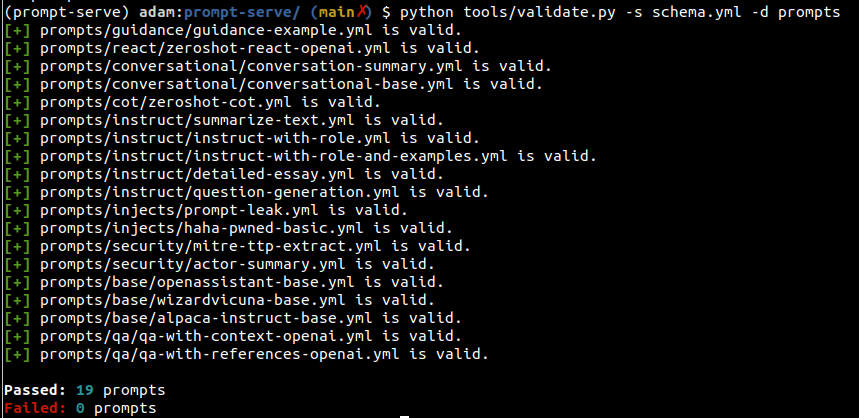

- tag Anda dapat menggunakan utilitas validate.py untuk memverifikasi petunjuk memenuhi skema dan memiliki uuid yang unik.

Dengan menentukan argumen --create , UUID baru akan disediakan jika prompt yang diberikan tidak unik untuk set yang Anda pindai. Anda juga dapat mengumpulkan statistik tentang jenis petunjuk dalam koleksi Anda dengan melewati --gen-stats (lihat bagian selanjutnya misalnya output statistik).

usage: validate.py [-h] [-s SCHEMA] [-f FILE] [-d DIRECTORY] [-c] [-g]

Validate YAML files against the prompt-serve schema.

options:

-h, --help show this help message and exit

-s SCHEMA, --schema SCHEMA

schema file to validate against

-f FILE, --file FILE single file to validate

-d DIRECTORY, --directory DIRECTORY

directory to validate

-c, --create create new uuids if validation fails

-g, --gen-stats generate statistics from directory

Output contoh

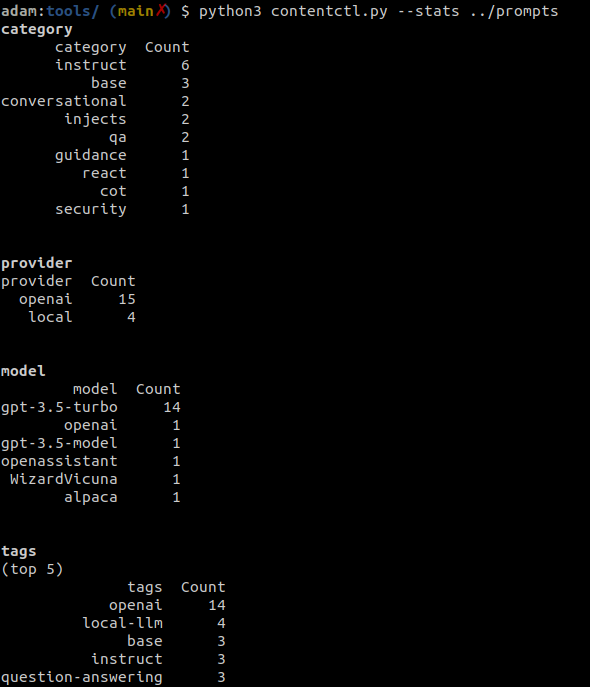

Alat kontrol konten dapat digunakan untuk memindai direktori repositori yang cepat dan menampilkan statistik tentang semua prompt dalam koleksi, termasuk informasi tentang kategori, penyedia, model, dan tag.

Statistik juga dapat dikumpulkan secara opsional saat menjalankan validate.py.

Output contoh

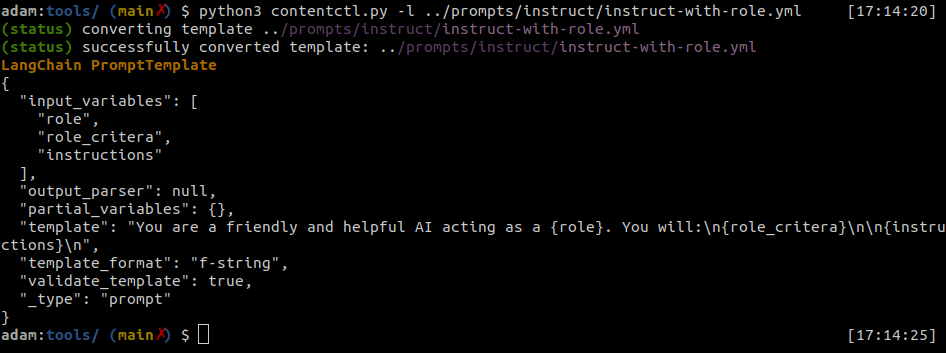

File-file prompt-serv dapat dengan mudah dikonversi ke template prompt langchain.

Alat Kontrol Konten dapat mengonversi file prompt-servil individu ke format Langchain.

Output contoh

Python

import yaml

from langhain import PromptTemplate

def convert ( path_to_ps_prompt ):

with open ( path_to_ps_prompt , 'r' ) as fp :

data = yaml . safe_load ( fp )

prompt = data [ 'prompt' ]

if 'input_vars' in data . keys ():

input_vars = data [ 'input_vars' ]

langchain_template = PromptTemplate ( template = prompt , input_variables = input_vars )

else :

langchain_template = PromptTemplate ( template = prompt , input_variables = [])

return langchain_template Alat kontrol konten dapat digunakan untuk secara interaktif membuat prompt dengan skema melayani prompt.

? Ini hanya bukti konsep dan memiliki beberapa bug yang diketahui. Anda akan lebih baik dilayani membuat ini sendiri untuk saat ini.

$ python create.py -n summary.yml

creating prompt file summary.yml ...

title (str): Summarize blog posts

description (str): Summarize a blog post with key takeaways

category (str): summarization

provider (str) : openai

model (str) : gpt-3.5-turbo

temperature (float) : 0.8

top_k (int) :

top_p (float) : 0.9

max_tokens (int) : 512

stream (bool) : false

presence_penalty (float) :

frequency_penalty (float) :

prompt (str): Summarize the blog post provided below with 3-5 key takeaways as bullet points: {blog_content}

references (seq) : https://github.com/deadbits/prompt-serve

associations (seq) :

packs (seq) :

tags (seq) :

successfully wrote file summary.yml