Ncert Books Rag System

Ce projet met en œuvre un système de génération (RAG) (RAG) de récupération pour les livres NCERT en utilisant Olllama pour l'intégration de texte et la base de données vectorielle, et API GROQ pour la réponse du modèle de langue.

Caractéristiques

- Utilise un modèle d'intégration de texte nomique via Olllama pour créer des intérêts vectoriels

- Magasins intégrés dans ChromAdb

- Utilise API Groq avec le modèle LLAMA 3 8B pour générer des réponses

- Fournit un backend FastAPI et rationaliser le frontage pour l'interaction utilisateur

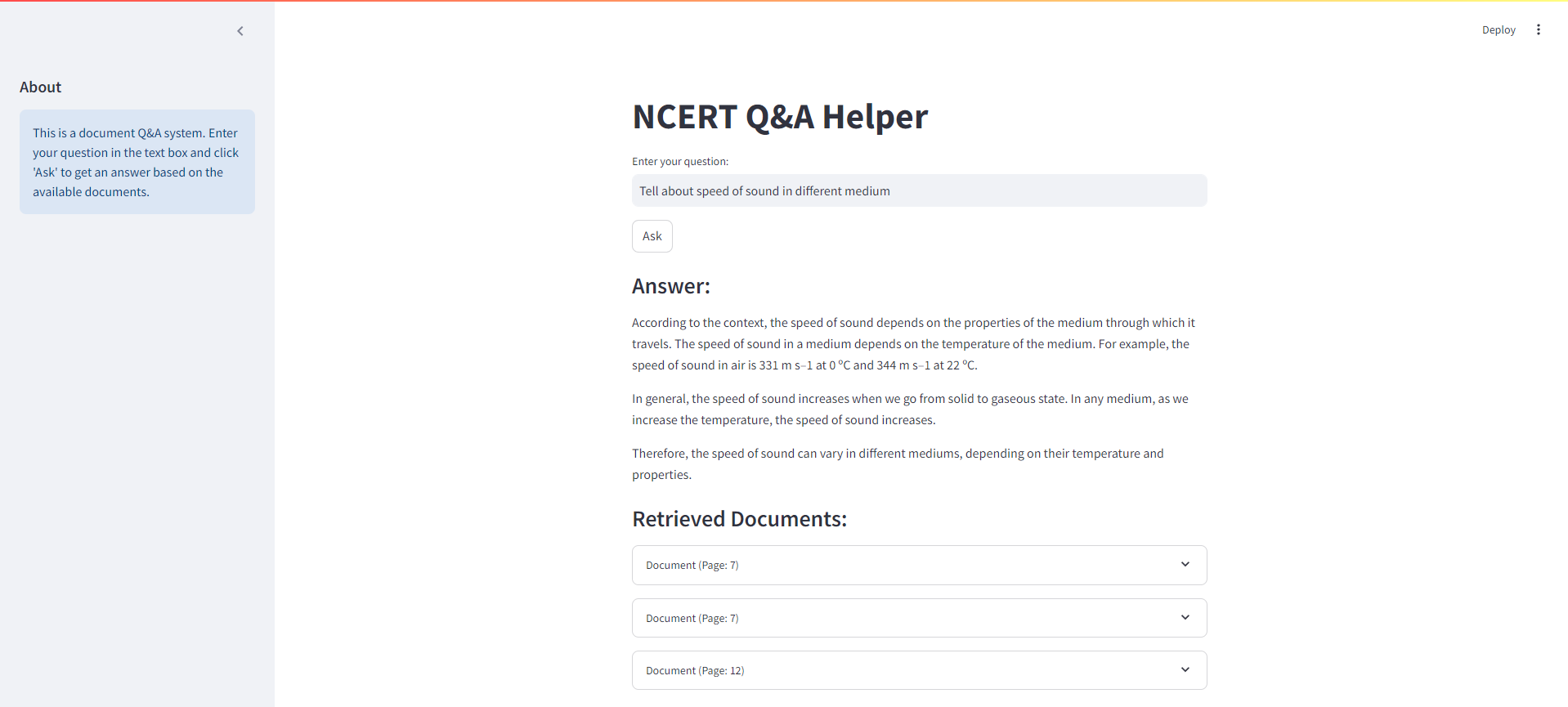

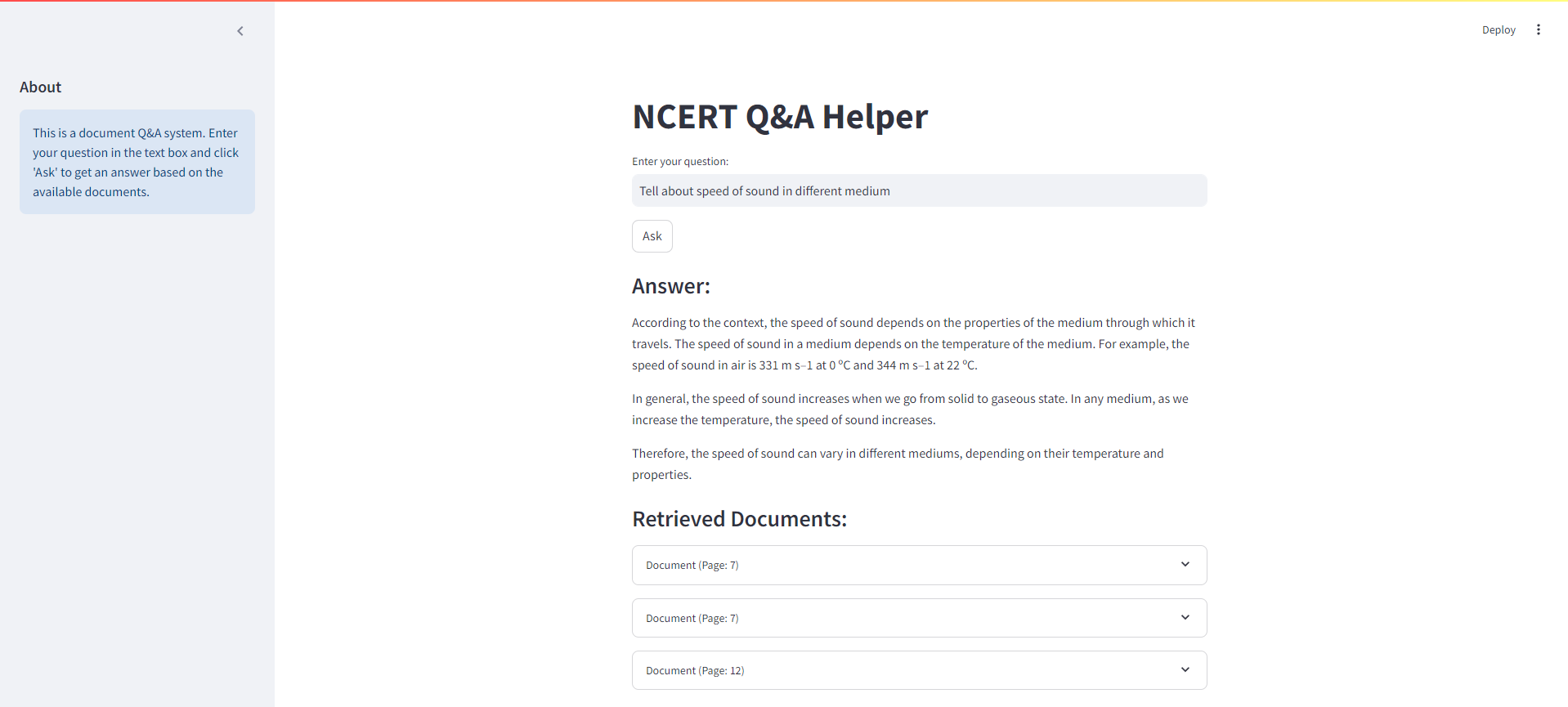

Interface rationalisée

Vous trouverez ci-dessous une capture d'écran de l'interface rationalisée pour notre système de chiffon NCERT Books:

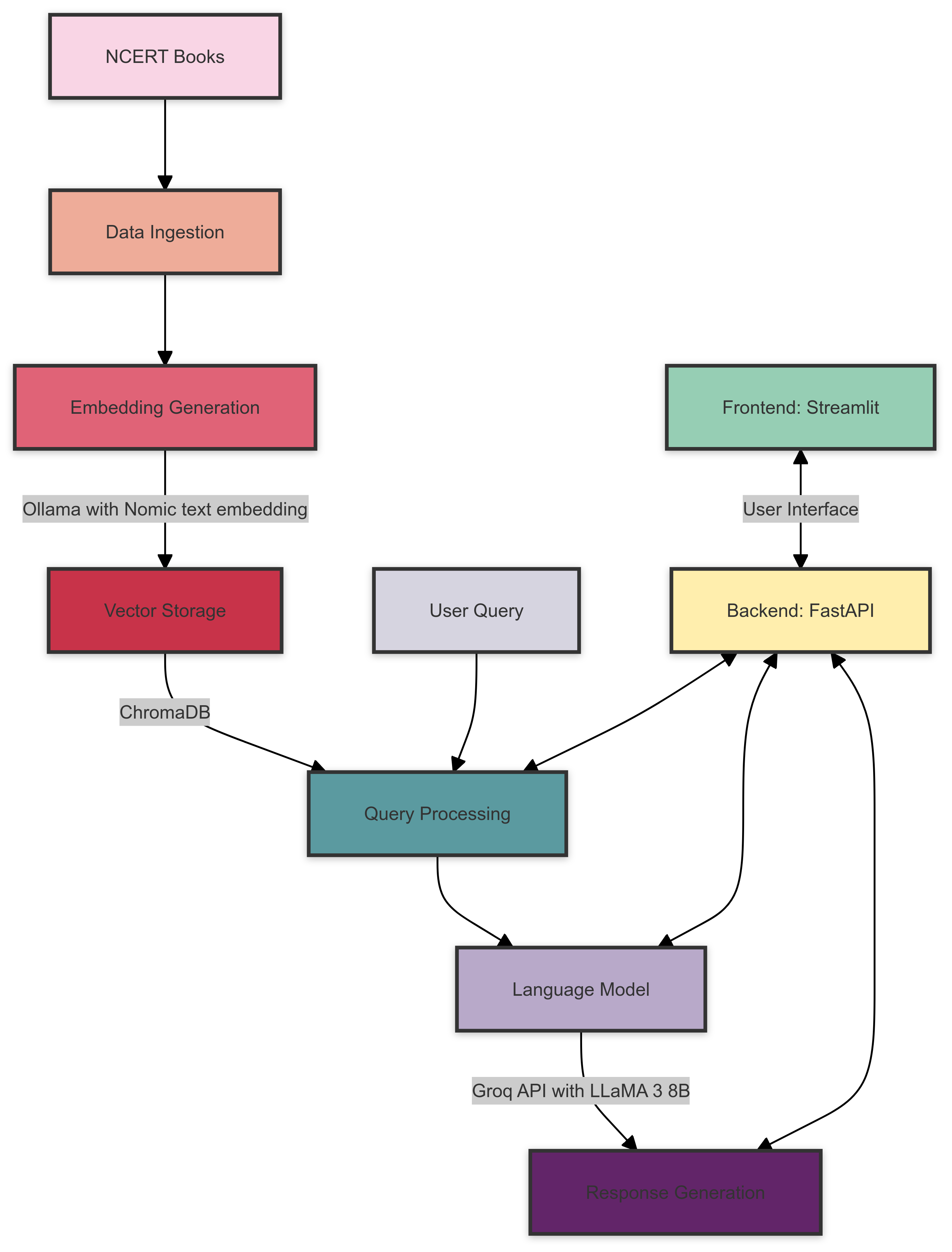

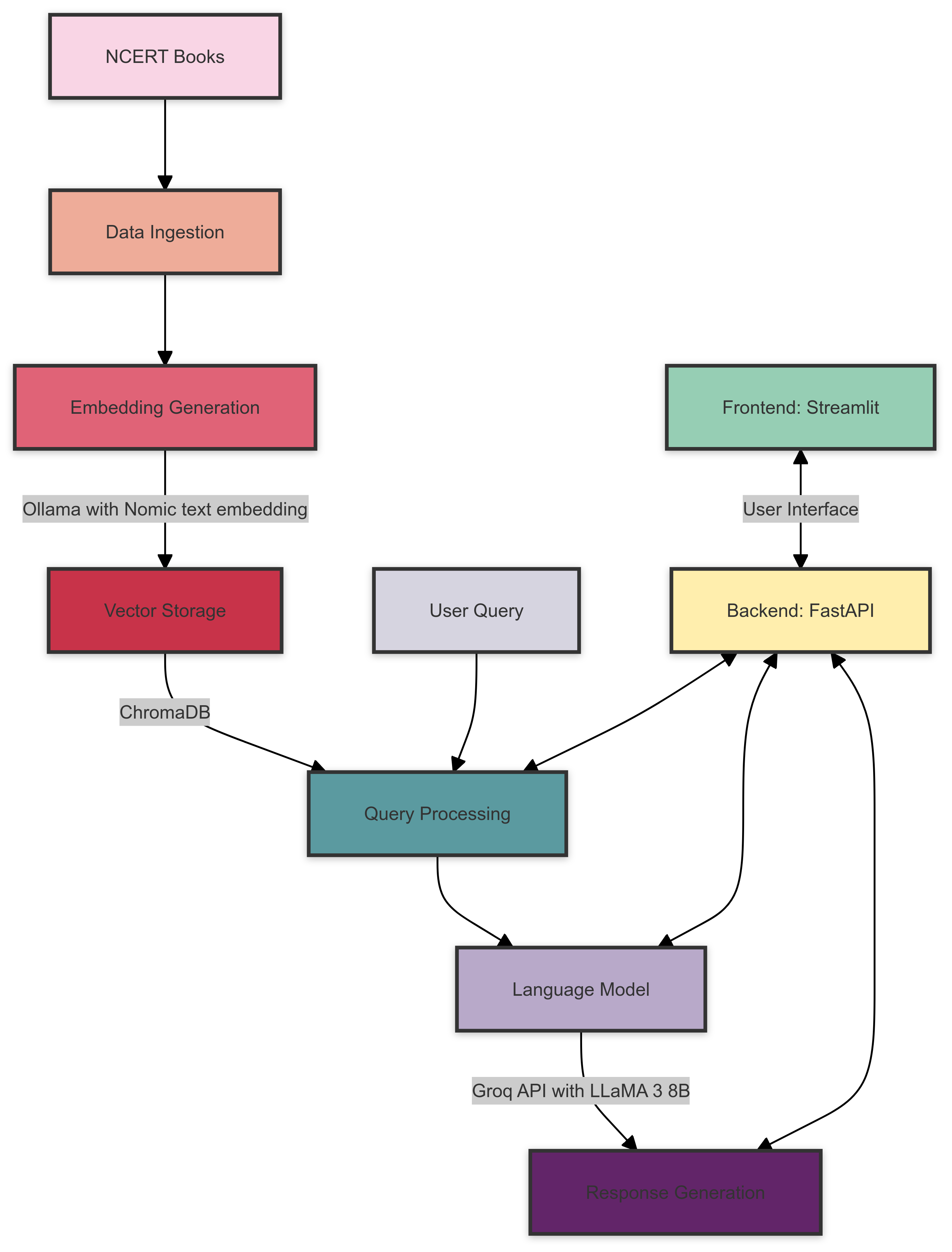

Architecture du système

Voici un aperçu de l'architecture du système de chiffon NCERT Books:

L'architecture du système se compose des composants suivants:

- Ingestion de données : les livres NCERT sont traités et préparés à l'intégration.

- Génération d'intégration : Olllama avec le modèle Nomic Text Imbedding Crée des incorporations vectorielles pour le texte traité.

- Stockage vectoriel : ChromAdB stocke les intérêts générés pour une récupération efficace.

- Traitement des requêtes : les requêtes utilisateur sont traitées et les intégres pertinents sont récupérés de ChromAdB.

- Modèle linguistique : API GROQ avec le modèle LLAMA 3 8B génère des réponses basées sur le contexte récupéré et la requête utilisateur.

- Backend : Fastapi gère la communication entre le frontend et les différents composants du système.

- Frontend : Streamlit fournit une interface utilisateur interactive pour interroger le système et afficher les résultats.

Condition préalable

Avant de commencer, assurez-vous d'avoir satisfait aux exigences suivantes:

- Python 3.7+

- Olllama installé et installé

- Compte API GROQ et clé API

Installation

Clone le référentiel:

git clone https://github.com/yourusername/ncert-rag-system.git

cd ncert-rag-system

Installez les dépendances requises:

pip install -r requirements.txt

Télécharger et configurer Olllama:

- Suivez les instructions sur le site officiel d'Olllama pour installer Olllama

- Téléchargez le modèle d'intégration du texte nomique:

ollama pull nomic-embed-text

Configurez votre clé API Groq:

- Créer un fichier

.env dans la racine du projet - Ajoutez votre clé API Groq:

GROQ_API_KEY=your_api_key_here

Usage

Commencez le backend Fastapi:

uvicorn main:app --reload

Lancez l'interface utilisateur rationalisée:

streamlit run streamlit_app.py

Ouvrez votre navigateur Web et accédez à l'URL de l'application Streamlit (généralement http://localhost:8501 )

Utilisez l'interface pour interagir avec le système de chiffon NCERT Books

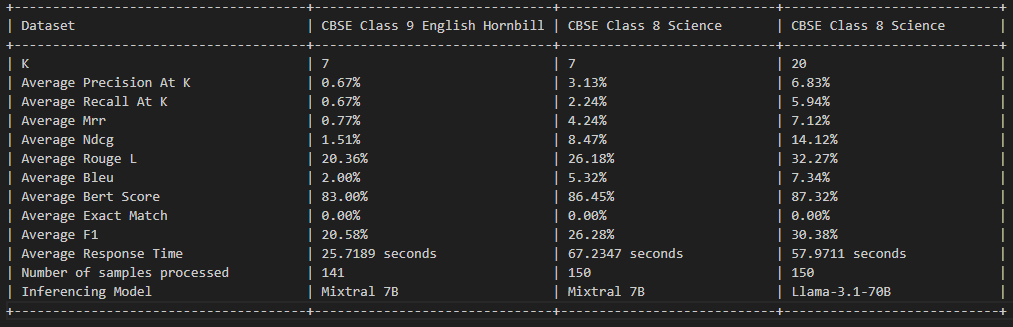

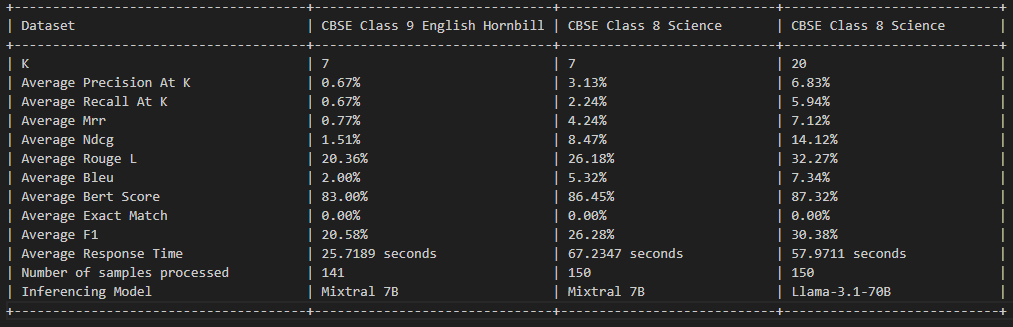

Évaluation des chiffons

Licence

Ce projet est autorisé en vertu de la licence MIT - voir le fichier de licence pour plus de détails.

Contributif

Les contributions sont les bienvenues! N'hésitez pas à soumettre une demande de traction.

Remerciements

- Olllama pour avoir fourni le modèle d'incorporation

- Groq pour leur API LLM

- Fastapi et rationalisation pour les cadres backend et frontal