Chien mécanique

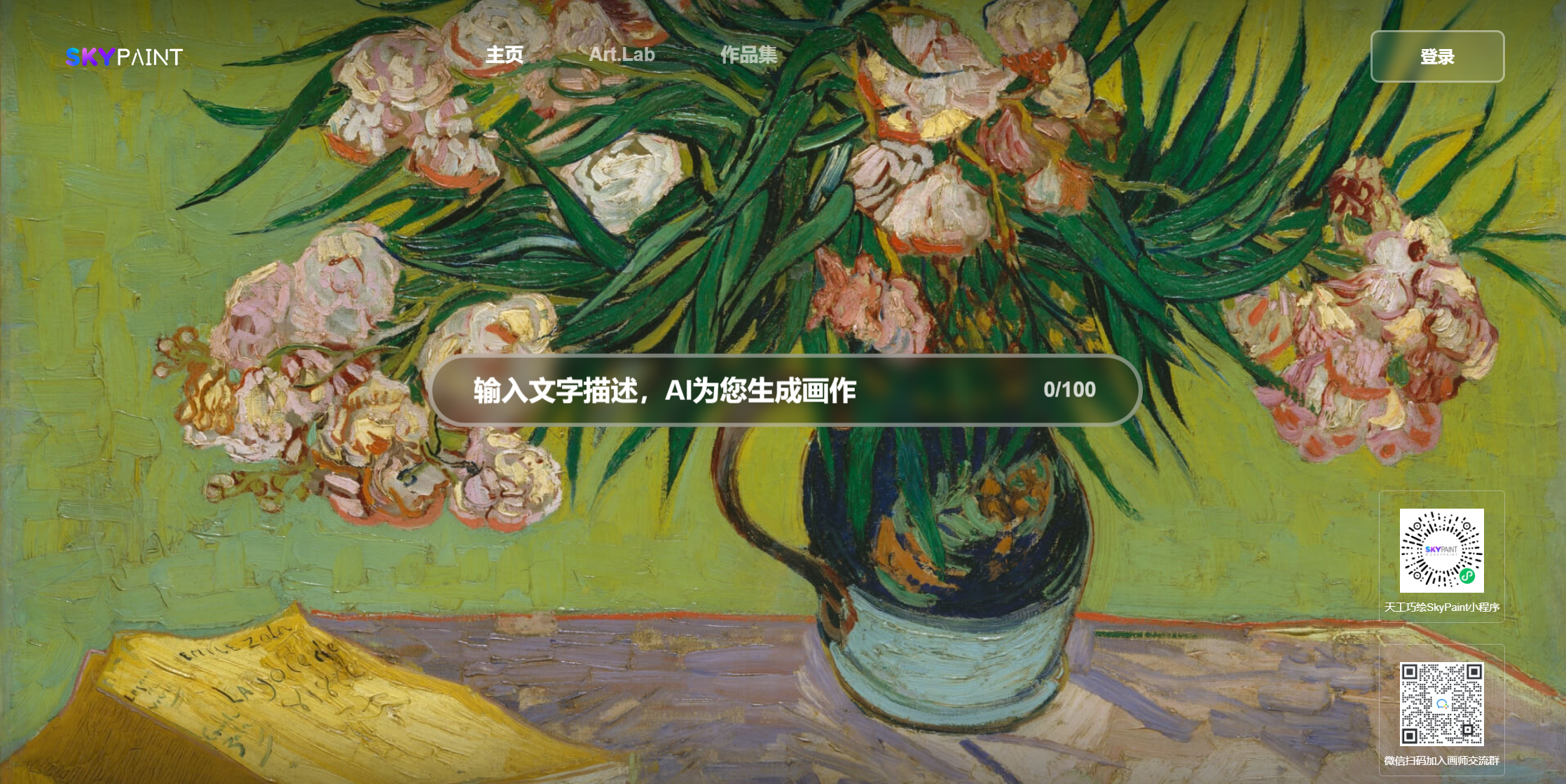

Castle Sea Sunset Miyazaki Animation

Combien de fleurs tombent

Demi-poulet et demi un homme, fort

Poulet, tu es si belle

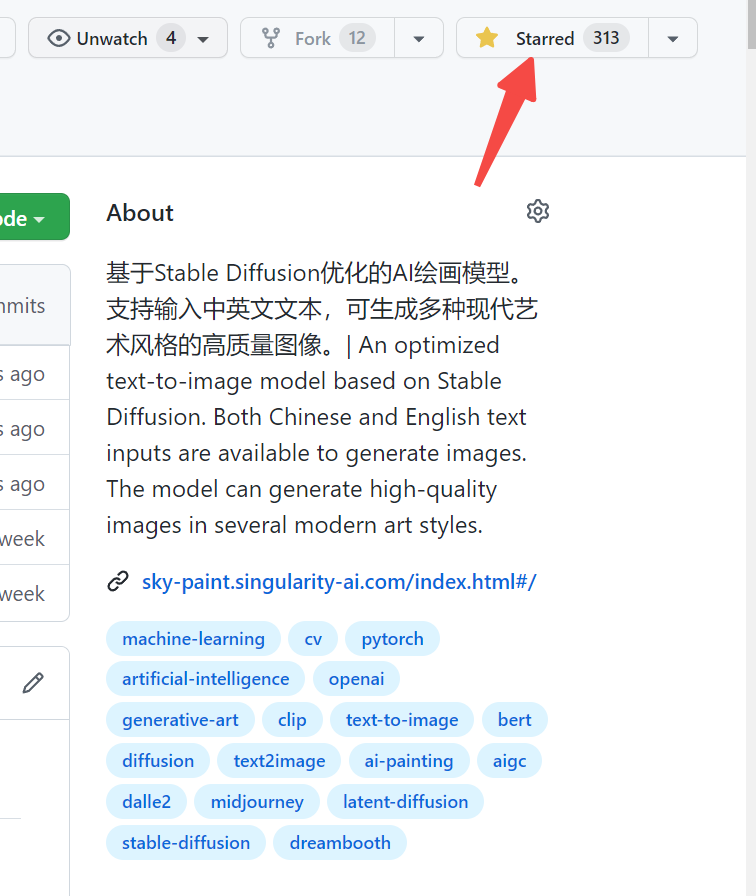

Veuillez visiter Skypaint, Skypaint

Vous pouvez également scanner le code QR sur WeChat et le vivre dans le programme MINI:

Le modèle d'image de génération de texte de SkyPaint se compose principalement de deux parties, à savoir le modèle de codeur de texte mot rapide et le modèle de diffusion. Par conséquent, notre optimisation est également divisée en deux étapes: d'abord, sur la base d'OpenAI-CLIP, le modèle de codeur de texte mot rapide est optimisé pour permettre à SkyPaint d'avoir des capacités de reconnaissance chinois et anglaise, puis, le modèle de diffusion est optimisé, de sorte que Skypaint a des capacités artistiques modernes pour produire des images de haute qualité.

Adresse de téléchargement du modèle skypaint-v1.0

from diffusers import StableDiffusionPipeline

device = 'cuda'

pipe = StableDiffusionPipeline . from_pretrained ( "path_to_our_model" ). to ( device )

prompts = [

'机械狗' ,

'城堡 大海 夕阳 宫崎骏动画' ,

'花落知多少' ,

'鸡你太美' ,

]

for prompt in prompts :

prompt = 'sai-v1 art, ' + prompt

image = pipe ( prompt ). images [ 0 ]

image . save ( "%s.jpg" % prompt )————————————————————————————————————————————————————————

Skyclip est un modèle de clip obtenu par nous en utilisant une méthode efficace de formation de modèles de clips bilingues chinois et anglais. Cette méthode ne modifie que l'encodeur de texte d'OpenAI-CLIP et peut être utilisé pour réaliser la fonction de récupération d'image et de texte à l'aide d'OpenAI-CLIP.

Le Text_Encoder d'Openai-CLIP est utilisé comme modèle d'enseignant et les paramètres sont figés. 1, L2, les distances COS sont utilisées pour faire progressivement les chinois et l'anglais Hidden_State du modèle étudiant approchent progressivement le Hidden_State du modèle de professeur. Étant donné que les chinois et l'anglais du corpus parallèle ont des propriétés d'inégalité naturelles, afin de rendre le chinois et l'anglais parallèles aussi près que possible, nous avons également ajouté un décodeur chinois pendant le processus de formation, en utilisant le chinois et l'anglais Hidden_State du modèle étudiant comme entrée chinoise et anglais par le décodeur et aidant à la réalisation de l'alignement de la chinoise et de l'anglais par les tass de traduction.

À l'heure actuelle, nous avons principalement évalué les performances zéro de Skyclip dans Flickr30k-CN, et comparées principalement plusieurs modèles open source pertinents avec des capacités chinoises.

FLICKR30K-CN RETROYAGE :

| Tâche | Texte à l'image | Image à texte | M | ||||

|---|---|---|---|---|---|---|---|

| Installation | Zéro | Zéro | |||||

| Métrique | R @ 1 | R @ 5 | R @ 10 | R @ 1 | R @ 5 | R @ 10 | |

| Taiyi-326m | 53.8 | 79.9 | 86.6 | 64.0 | 90.4 | 96.1 | 78.47 |

| Altclip | 50.7 | 75.4 | 83.1 | 73.4 | 92.8 | 96.9 | 78,72 |

| Wukong | 51.9 | 78.6 | 85.9 | 75 | 94.4 | 97.7 | 80.57 |

| R2d2 | 42.6 | 69.5 | 78.6 | 63.0 | 90.1 | 96.4 | 73.37 |

| CN-CLIP | 68.1 | 89.7 | 94.5 | 80.2 | 96.6 | 98.2 | 87.87 |

| Skyclip | 58.8 | 82.6 | 89.6 | 78.8 | 96.1 | 98.3 | 84.04 |

from PIL import Image

import requests

import clip

import torch

from transformers import BertTokenizer

from transformers import CLIPProcessor , CLIPModel , CLIPTextModel

import numpy as np

query_texts = [ '一个人' , '一辆汽车' , '两个男人' , '两个女人' ] # 这里是输入提示词,可以随意替换。

# 加载SkyCLIP 中英文双语 text_encoder

text_tokenizer = BertTokenizer . from_pretrained ( "./tokenizer" )

text_encoder = CLIPTextModel . from_pretrained ( "./text_encoder" ). eval ()

text = text_tokenizer ( query_texts , return_tensors = 'pt' , padding = True )[ 'input_ids' ]

url = "http://images.cocodataset.org/val2017/000000040083.jpg" #这里可以换成任意图片的url

# 加载CLIP的image encoder

clip_model = CLIPModel . from_pretrained ( "openai/clip-vit-large-patch14" )

clip_text_proj = clip_model . text_projection

processor = CLIPProcessor . from_pretrained ( "openai/clip-vit-large-patch14" )

image = processor ( images = Image . open ( requests . get ( url , stream = True ). raw ), return_tensors = "pt" )

with torch . no_grad ():

image_features = clip_model . get_image_features ( ** image )

text_features = text_encoder ( text )[ 0 ]

# sep_token对应于openai-clip的eot_token

sep_index = torch . nonzero ( text == student_tokenizer . sep_token_id )

text_features = text_features [ torch . arange ( text . shape [ 0 ]), sep_index [:, 1 ]]

# 乘text投影矩阵

text_features = clip_text_proj ( text_features )

image_features = image_features / image_features . norm ( dim = 1 , keepdim = True )

text_features = text_features / text_features . norm ( dim = 1 , keepdim = True )

# 计算余弦相似度 logit_scale是尺度系数

logit_scale = clip_model . logit_scale . exp ()

logits_per_image = logit_scale * image_features @ text_features . t ()

logits_per_text = logits_per_image . t ()

probs = logits_per_image . softmax ( dim = - 1 ). cpu (). numpy ()

print ( np . around ( probs , 3 ))Nos données utilisent l'ensemble de données LAION filtré comme données de formation, et le texte est précédé de «l'art SAI-V1» comme tag pour permettre au modèle d'apprendre le style et la qualité que nous voulons plus rapidement. Le modèle pré-formé utilise un diffusion stable-V1-5 comme pré-formation, et 16 A100 ont été utilisés pendant 50 heures. À l'heure actuelle, le modèle est toujours optimisé en continu, et il y aura plus de mises à jour de modèle stables à l'avenir.