Perro mecánico

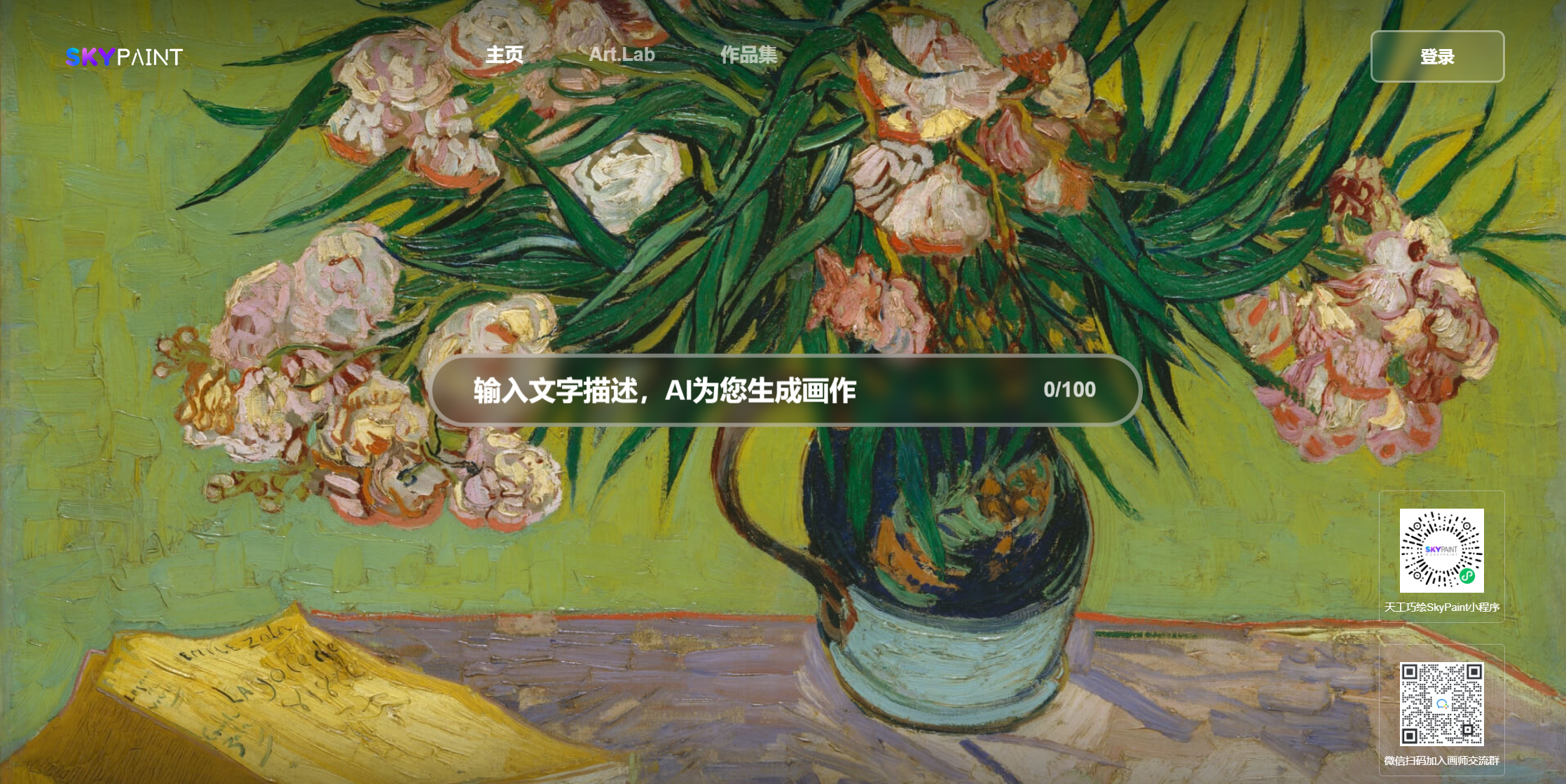

Castle Sea Sunset Miyazaki Animación

Cuantas flores caen

Medio pollo y medio hombre, fuerte

Pollo, eres tan hermosa

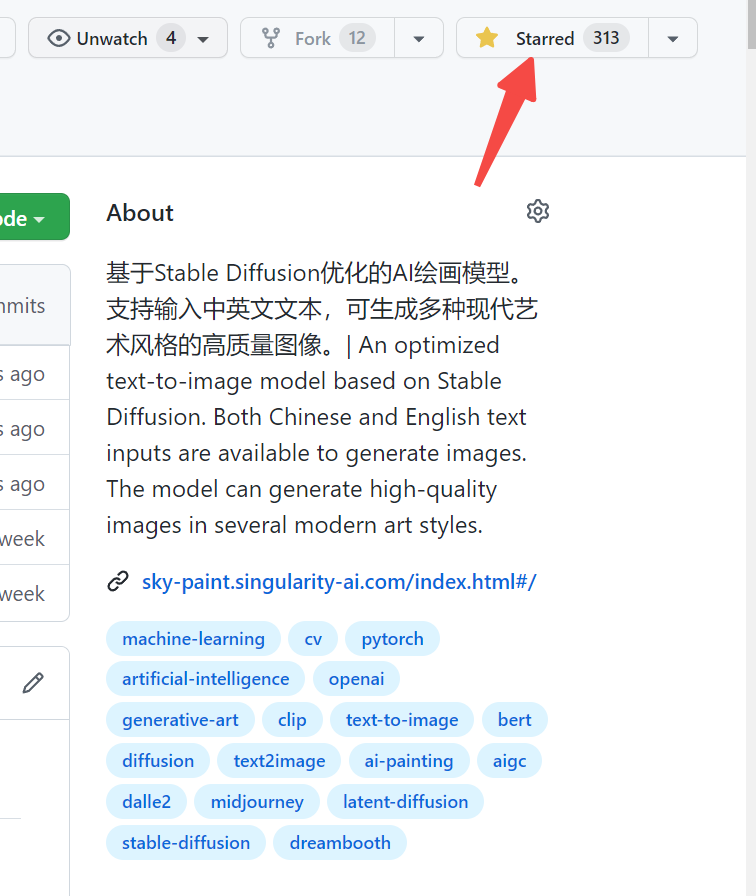

Visite SkyPaint, SkyPaint

También puede escanear el código QR en WeChat y experimentarlo en el programa MINI:

El modelo de imagen de generación de texto de SkyPaint consta principalmente de dos partes, a saber, el modelo de codificador de texto de palabras de inmediato y el modelo de difusión. Por lo tanto, nuestra optimización también se divide en dos pasos: primero, basado en el clip de OpenAI, el modelo de codificador de texto de palabras de inmediato está optimizado para permitir que SkyPaint tenga capacidades de reconocimiento chino e inglés, y luego, el modelo de difusión está optimizado, de modo que SkyPaint tiene capacidades de arte modernas para producir imágenes de alta calidad.

Dirección de descarga del modelo SkyPaint-V1.0

from diffusers import StableDiffusionPipeline

device = 'cuda'

pipe = StableDiffusionPipeline . from_pretrained ( "path_to_our_model" ). to ( device )

prompts = [

'机械狗' ,

'城堡 大海 夕阳 宫崎骏动画' ,

'花落知多少' ,

'鸡你太美' ,

]

for prompt in prompts :

prompt = 'sai-v1 art, ' + prompt

image = pipe ( prompt ). images [ 0 ]

image . save ( "%s.jpg" % prompt )——————————————————————————————————————————————————————————————————————————————————————-

SkyClip es un modelo de clip obtenido por nosotros utilizando un método eficiente de capacitación de modelos de clip bilingües chinos e inglés. Este método solo cambia el codificador de texto de OpenAI-Clip, y puede usarse para realizar la función de recuperación de imagen y texto utilizando OpenAI-Clip.

El Text_Encoder de OpenAI se usa como modelo de maestro y los parámetros están congelados. Como L1, L2, las distancias COS se utilizan para que el chino e inglés se oculte del modelo de estudiante se acerque gradualmente al Hidden_State del modelo de maestro. Debido a que los chinos e inglés del corpus paralelo tienen propiedades de desigualdad natural, para que el chino paralelo e inglés lo sea lo más cerca posible, también agregamos un decodificador chino durante el proceso de capacitación, utilizando el estado Hidden_State de China e Inglés de la Modelo de los Estudiantes como la entrada Hidden_state de la decodificadora y ayudando a lograr la alineación de los chinos e inglés a través de las tareas de traducción.

En la actualidad, evaluamos principalmente el rendimiento de disparo cero de SkyClip en FlickR30K-CN, y comparamos principalmente varios modelos de código abierto relevantes con capacidades chinas para garantizar la equidad de la comparación, todos seleccionamos los modelos basados en los tamaños de Vit-L/14 de OpenAI-Clip para múltiples tamaños de modelos.

Recuperación de Flickr30K-CN :

| Tarea | Texto a imagen | Imagen a texto | SEÑOR | ||||

|---|---|---|---|---|---|---|---|

| Configuración | Cero | Cero | |||||

| Métrico | R@1 | R@5 | R@10 | R@1 | R@5 | R@10 | |

| Taiyi-326m | 53.8 | 79.9 | 86.6 | 64.0 | 90.4 | 96.1 | 78.47 |

| Altclip | 50.7 | 75.4 | 83.1 | 73.4 | 92.8 | 96.9 | 78.72 |

| Wukong | 51.9 | 78.6 | 85.9 | 75 | 94.4 | 97.7 | 80.57 |

| R2D2 | 42.6 | 69.5 | 78.6 | 63.0 | 90.1 | 96.4 | 73.37 |

| Clip de CN | 68.1 | 89.7 | 94.5 | 80.2 | 96.6 | 98.2 | 87.87 |

| Clip de cielo | 58.8 | 82.6 | 89.6 | 78.8 | 96.1 | 98.3 | 84.04 |

from PIL import Image

import requests

import clip

import torch

from transformers import BertTokenizer

from transformers import CLIPProcessor , CLIPModel , CLIPTextModel

import numpy as np

query_texts = [ '一个人' , '一辆汽车' , '两个男人' , '两个女人' ] # 这里是输入提示词,可以随意替换。

# 加载SkyCLIP 中英文双语 text_encoder

text_tokenizer = BertTokenizer . from_pretrained ( "./tokenizer" )

text_encoder = CLIPTextModel . from_pretrained ( "./text_encoder" ). eval ()

text = text_tokenizer ( query_texts , return_tensors = 'pt' , padding = True )[ 'input_ids' ]

url = "http://images.cocodataset.org/val2017/000000040083.jpg" #这里可以换成任意图片的url

# 加载CLIP的image encoder

clip_model = CLIPModel . from_pretrained ( "openai/clip-vit-large-patch14" )

clip_text_proj = clip_model . text_projection

processor = CLIPProcessor . from_pretrained ( "openai/clip-vit-large-patch14" )

image = processor ( images = Image . open ( requests . get ( url , stream = True ). raw ), return_tensors = "pt" )

with torch . no_grad ():

image_features = clip_model . get_image_features ( ** image )

text_features = text_encoder ( text )[ 0 ]

# sep_token对应于openai-clip的eot_token

sep_index = torch . nonzero ( text == student_tokenizer . sep_token_id )

text_features = text_features [ torch . arange ( text . shape [ 0 ]), sep_index [:, 1 ]]

# 乘text投影矩阵

text_features = clip_text_proj ( text_features )

image_features = image_features / image_features . norm ( dim = 1 , keepdim = True )

text_features = text_features / text_features . norm ( dim = 1 , keepdim = True )

# 计算余弦相似度 logit_scale是尺度系数

logit_scale = clip_model . logit_scale . exp ()

logits_per_image = logit_scale * image_features @ text_features . t ()

logits_per_text = logits_per_image . t ()

probs = logits_per_image . softmax ( dim = - 1 ). cpu (). numpy ()

print ( np . around ( probs , 3 ))Nuestros datos utilizan el conjunto de datos de Laion filtrado como datos de capacitación, y el texto está precedido por 'SAI-V1 Art' como la etiqueta para permitir que el modelo aprenda el estilo y la calidad que queremos más rápidamente. El modelo previamente capacitado utiliza la difusión estable-V1-5 como pre-entrenamiento, y 16 A100 se usaron durante 50 horas. En la actualidad, el modelo todavía se está optimizando continuamente, y habrá más actualizaciones de modelos estables en el futuro.