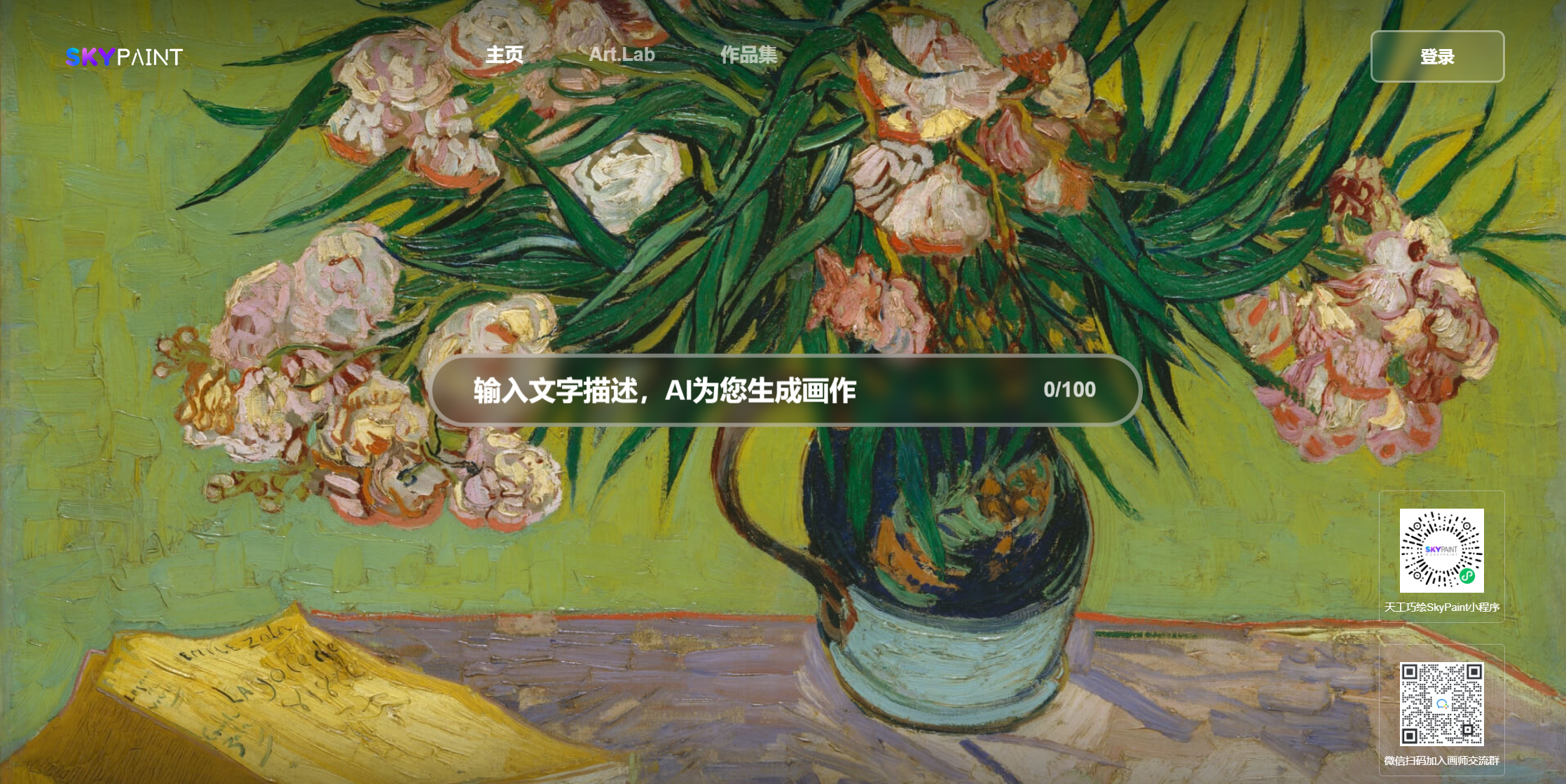

Cão mecânico

Castle Sea Sunset Miyazaki Animação

Quantas flores caem

Meio frango e meio homem, forte

Frango, você é tão linda

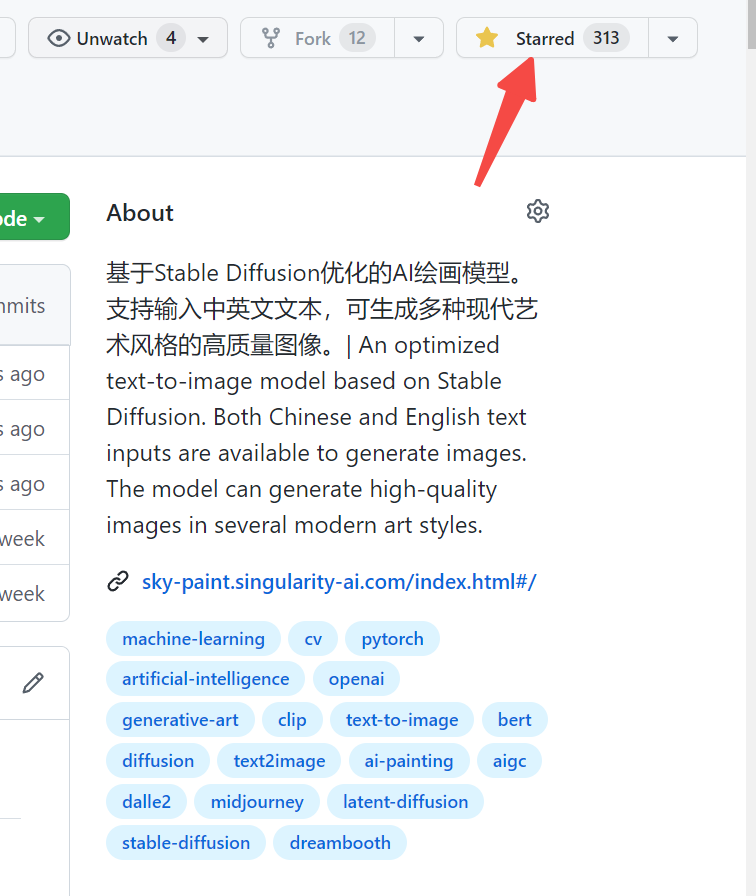

Visite Skypaint, Skypaint

Você também pode digitalizar o código QR no WeChat e experimentá -lo no mini -programa:

O modelo de imagem de geração de texto Skypaint consiste principalmente em duas partes, a saber, o modelo de codificador de texto rápido e o modelo de difusão. Portanto, nossa otimização também é dividida em duas etapas: primeiro, com base no OpenIl-clip, o modelo de codificador de texto imediato é otimizado para permitir que a Skypaint tenha recursos de reconhecimento chinês e inglês e, em seguida, o modelo de difusão é otimizado, de modo que a Skypaint possui recursos artísticos modernos para produzir imagens de alta qualidade.

Download de modelo Endereço Skypaint-V1.0

from diffusers import StableDiffusionPipeline

device = 'cuda'

pipe = StableDiffusionPipeline . from_pretrained ( "path_to_our_model" ). to ( device )

prompts = [

'机械狗' ,

'城堡 大海 夕阳 宫崎骏动画' ,

'花落知多少' ,

'鸡你太美' ,

]

for prompt in prompts :

prompt = 'sai-v1 art, ' + prompt

image = pipe ( prompt ). images [ 0 ]

image . save ( "%s.jpg" % prompt )———————————————————————————————————————————————————

O Skyclip é um modelo de clipe obtido por nós, usando um método eficiente de treinamento em modelos bilíngues chineses e ingleses. Este método altera apenas o codificador de texto do OpenAI-Clip e pode ser usado para realizar a função de recuperação de imagem e texto usando o OpenAI-Clip.

O text_encoder de clipe Open é usado como modelo de professor e os parâmetros são congelados. As distâncias de L1, L2, COS são usadas para fazer gradualmente fazer com que os chineses e os ingleses Hidden; Como o chinês e o inglês do corpus paralelo possuem propriedades naturais de desigualdade, para tornar o chinês e o inglês paralelos o mais perto possível, também adicionamos um decodificador chinês durante o processo de treinamento, usando o estadual chinês e inglês Hidden_state do modelo do aluno como o Hidden_State entradas do decodificador e ajudando a alinhamento do chinês e do inglês através de tradução.

Atualmente, avaliamos principalmente o desempenho zero do Skyclip no Flickr30k-CN e comparamos principalmente vários modelos de código aberto relevantes com as capacidades chinesas.

Recuperação Flickr30k-CN :

| Tarefa | Texto para imagem | Imagem para texto | SENHOR | ||||

|---|---|---|---|---|---|---|---|

| Configurar | Zero-shot | Zero-shot | |||||

| Métrica | R@1 | R@5 | R@10 | R@1 | R@5 | R@10 | |

| Taiyi-326m | 53.8 | 79.9 | 86.6 | 64.0 | 90.4 | 96.1 | 78.47 |

| Altclip | 50.7 | 75.4 | 83.1 | 73.4 | 92.8 | 96.9 | 78.72 |

| Wukong | 51.9 | 78.6 | 85.9 | 75 | 94.4 | 97.7 | 80.57 |

| R2d2 | 42.6 | 69.5 | 78.6 | 63.0 | 90.1 | 96.4 | 73.37 |

| CN-clip | 68.1 | 89.7 | 94.5 | 80.2 | 96.6 | 98.2 | 87,87 |

| Skyclip | 58.8 | 82.6 | 89.6 | 78.8 | 96.1 | 98.3 | 84.04 |

from PIL import Image

import requests

import clip

import torch

from transformers import BertTokenizer

from transformers import CLIPProcessor , CLIPModel , CLIPTextModel

import numpy as np

query_texts = [ '一个人' , '一辆汽车' , '两个男人' , '两个女人' ] # 这里是输入提示词,可以随意替换。

# 加载SkyCLIP 中英文双语 text_encoder

text_tokenizer = BertTokenizer . from_pretrained ( "./tokenizer" )

text_encoder = CLIPTextModel . from_pretrained ( "./text_encoder" ). eval ()

text = text_tokenizer ( query_texts , return_tensors = 'pt' , padding = True )[ 'input_ids' ]

url = "http://images.cocodataset.org/val2017/000000040083.jpg" #这里可以换成任意图片的url

# 加载CLIP的image encoder

clip_model = CLIPModel . from_pretrained ( "openai/clip-vit-large-patch14" )

clip_text_proj = clip_model . text_projection

processor = CLIPProcessor . from_pretrained ( "openai/clip-vit-large-patch14" )

image = processor ( images = Image . open ( requests . get ( url , stream = True ). raw ), return_tensors = "pt" )

with torch . no_grad ():

image_features = clip_model . get_image_features ( ** image )

text_features = text_encoder ( text )[ 0 ]

# sep_token对应于openai-clip的eot_token

sep_index = torch . nonzero ( text == student_tokenizer . sep_token_id )

text_features = text_features [ torch . arange ( text . shape [ 0 ]), sep_index [:, 1 ]]

# 乘text投影矩阵

text_features = clip_text_proj ( text_features )

image_features = image_features / image_features . norm ( dim = 1 , keepdim = True )

text_features = text_features / text_features . norm ( dim = 1 , keepdim = True )

# 计算余弦相似度 logit_scale是尺度系数

logit_scale = clip_model . logit_scale . exp ()

logits_per_image = logit_scale * image_features @ text_features . t ()

logits_per_text = logits_per_image . t ()

probs = logits_per_image . softmax ( dim = - 1 ). cpu (). numpy ()

print ( np . around ( probs , 3 ))Nossos dados usam o conjunto de dados de Laion filtrado como dados de treinamento, e o texto é precedido por 'SAI-V1 ART' como a tag para permitir que o modelo aprenda o estilo e a qualidade que queremos mais rapidamente. O modelo pré-treinado usa a difusão estável-V1-5 como pré-treinamento e 16 A100s foram usados por 50 horas. Atualmente, o modelo ainda está sendo otimizado continuamente e haverá atualizações de modelo mais estáveis no futuro.