Mechanischer Hund

Castle Sea Sunset Miyazaki Animation

Wie viele Blumen fallen

Ein halbes Huhn und ein halber Mann, stark

Huhn, du bist so schön

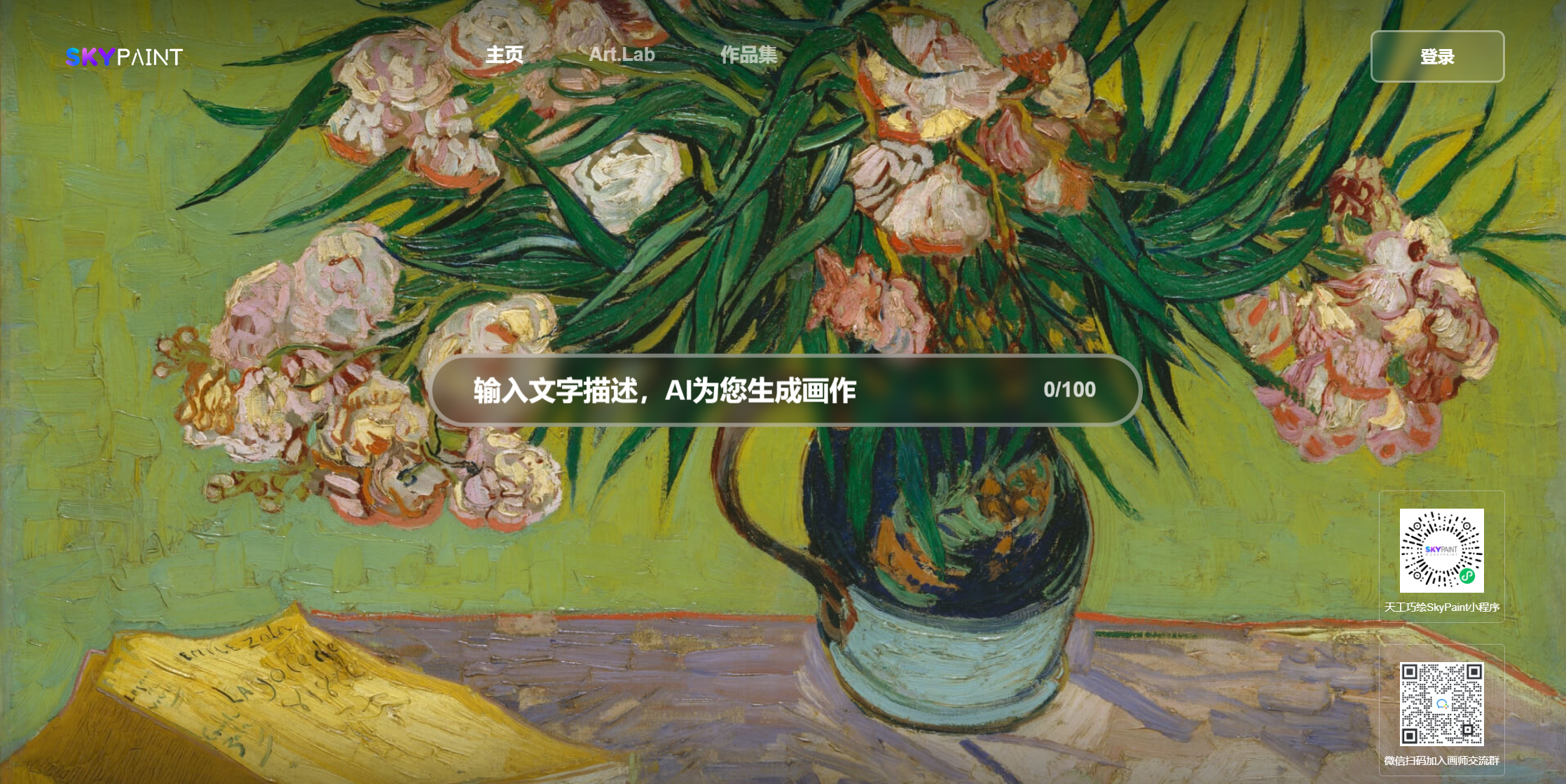

Bitte besuchen Sie Skypaint, Skypaint

Sie können den QR -Code auch auf WeChat scannen und ihn im Mini -Programm erleben:

Das Bildgenerierungsbildmodell von SkyPaint Text besteht hauptsächlich aus zwei Teilen, nämlich dem Modell -Encodermodell und dem Diffusionsmodell. Daher ist unsere Optimierung auch in zwei Schritte unterteilt: Erstens auf OpenAI-Clip ist das Modell des schnellen Worttext-Encoders optimiert, damit SkyPaint chinesische und englische Erkennungsfunktionen verfügen, und dann ist das Diffusionsmodell optimiert, so dass Skypaint moderne künstlerische Fähigkeiten verfügt, um qualitativ hochwertige Bilder zu produzieren.

Modell Download Adresse Skypaint-V1.0

from diffusers import StableDiffusionPipeline

device = 'cuda'

pipe = StableDiffusionPipeline . from_pretrained ( "path_to_our_model" ). to ( device )

prompts = [

'机械狗' ,

'城堡 大海 夕阳 宫崎骏动画' ,

'花落知多少' ,

'鸡你太美' ,

]

for prompt in prompts :

prompt = 'sai-v1 art, ' + prompt

image = pipe ( prompt ). images [ 0 ]

image . save ( "%s.jpg" % prompt )————————————————————————————————————————————————————————————————————————————————

Skyclip ist ein Clip-Modell, das von uns eine effiziente Methode zur Schulung chinesischer und englischer Clip-Modelle erfolgt. Diese Methode ändert nur den Textcodierer von OpenAI-Clip und kann verwendet werden, um die Bild- und Text-Abruffunktion mithilfe von OpenAI-Clip zu realisieren.

Der textheilige OpenAi-Clip wird als Lehrermodell verwendet, und die Parameter werden während des Schulungsmodells ein mehrsprachiger Bert-Modell angewendet. L1, L2, COS -Entfernungen werden verwendet, um das chinesische und englische Hidden_State des Schülermodells nach und nach dem Hidden_state des Lehrermodells zu machen. Da die chinesischen und englischen Parallelkorpus natürliche Ungleichheitseigenschaften aufweisen, haben wir während des Trainingsprozesses auch einen chinesischen Decoder für den chinesischen und englischen Hidden_State des Schülermodells als Hidden_state -Input des Decoders und der Unterstützung bei der Erhöhung des Alignments von Chinesischen und englischen Durchsetzungen durch die Hidden_state -Input durch die chinesischen und englischen Einrichtung auf dem Laufenden.

Gegenwärtig bewerteten wir die Null-Shot-Leistung von Skyclip in FlickR30K-CN und verglichen hauptsächlich mehrere relevante Open-Source-Modelle mit chinesischen Funktionen, um die Fairness des Vergleichs zu gewährleisten, und wir haben alle auf der Basis von OpenAI-Clip-Vit-L/14-Größen für mehrere Modellgrößen ausgewählt.

Flickr30K-CN-Abruf :

| Aufgabe | Text-to-Image | Bild-zu-Text | HERR | ||||

|---|---|---|---|---|---|---|---|

| Aufstellen | Null-Shot | Null-Shot | |||||

| Metrisch | R@1 | R@5 | R@10 | R@1 | R@5 | R@10 | |

| Taiyi-326m | 53,8 | 79,9 | 86.6 | 64.0 | 90.4 | 96.1 | 78,47 |

| Altclip | 50.7 | 75,4 | 83.1 | 73.4 | 92.8 | 96,9 | 78,72 |

| Wukong | 51.9 | 78,6 | 85,9 | 75 | 94.4 | 97.7 | 80.57 |

| R2D2 | 42.6 | 69,5 | 78,6 | 63.0 | 90.1 | 96,4 | 73,37 |

| CN-Clip | 68.1 | 89.7 | 94.5 | 80.2 | 96.6 | 98.2 | 87.87 |

| Skyclip | 58,8 | 82.6 | 89,6 | 78,8 | 96.1 | 98.3 | 84.04 |

from PIL import Image

import requests

import clip

import torch

from transformers import BertTokenizer

from transformers import CLIPProcessor , CLIPModel , CLIPTextModel

import numpy as np

query_texts = [ '一个人' , '一辆汽车' , '两个男人' , '两个女人' ] # 这里是输入提示词,可以随意替换。

# 加载SkyCLIP 中英文双语 text_encoder

text_tokenizer = BertTokenizer . from_pretrained ( "./tokenizer" )

text_encoder = CLIPTextModel . from_pretrained ( "./text_encoder" ). eval ()

text = text_tokenizer ( query_texts , return_tensors = 'pt' , padding = True )[ 'input_ids' ]

url = "http://images.cocodataset.org/val2017/000000040083.jpg" #这里可以换成任意图片的url

# 加载CLIP的image encoder

clip_model = CLIPModel . from_pretrained ( "openai/clip-vit-large-patch14" )

clip_text_proj = clip_model . text_projection

processor = CLIPProcessor . from_pretrained ( "openai/clip-vit-large-patch14" )

image = processor ( images = Image . open ( requests . get ( url , stream = True ). raw ), return_tensors = "pt" )

with torch . no_grad ():

image_features = clip_model . get_image_features ( ** image )

text_features = text_encoder ( text )[ 0 ]

# sep_token对应于openai-clip的eot_token

sep_index = torch . nonzero ( text == student_tokenizer . sep_token_id )

text_features = text_features [ torch . arange ( text . shape [ 0 ]), sep_index [:, 1 ]]

# 乘text投影矩阵

text_features = clip_text_proj ( text_features )

image_features = image_features / image_features . norm ( dim = 1 , keepdim = True )

text_features = text_features / text_features . norm ( dim = 1 , keepdim = True )

# 计算余弦相似度 logit_scale是尺度系数

logit_scale = clip_model . logit_scale . exp ()

logits_per_image = logit_scale * image_features @ text_features . t ()

logits_per_text = logits_per_image . t ()

probs = logits_per_image . softmax ( dim = - 1 ). cpu (). numpy ()

print ( np . around ( probs , 3 ))Unsere Daten verwenden den gefilterten Laion-Datensatz als Trainingsdaten, und dem Text wird „SAI-V1-Kunst“ als Tag vorangegangen, damit das Modell den Stil und die Qualität, die wir schneller wollen, lernen können. Das vorgebreitete Modell verwendet Stabil-Diffusion-V1-5 als Vorausbildung, und 16 A100s wurden 50 Stunden lang verwendet. Derzeit wird das Modell immer noch kontinuierlich optimiert, und es wird in Zukunft stabilere Modellaktualisierungen geben.