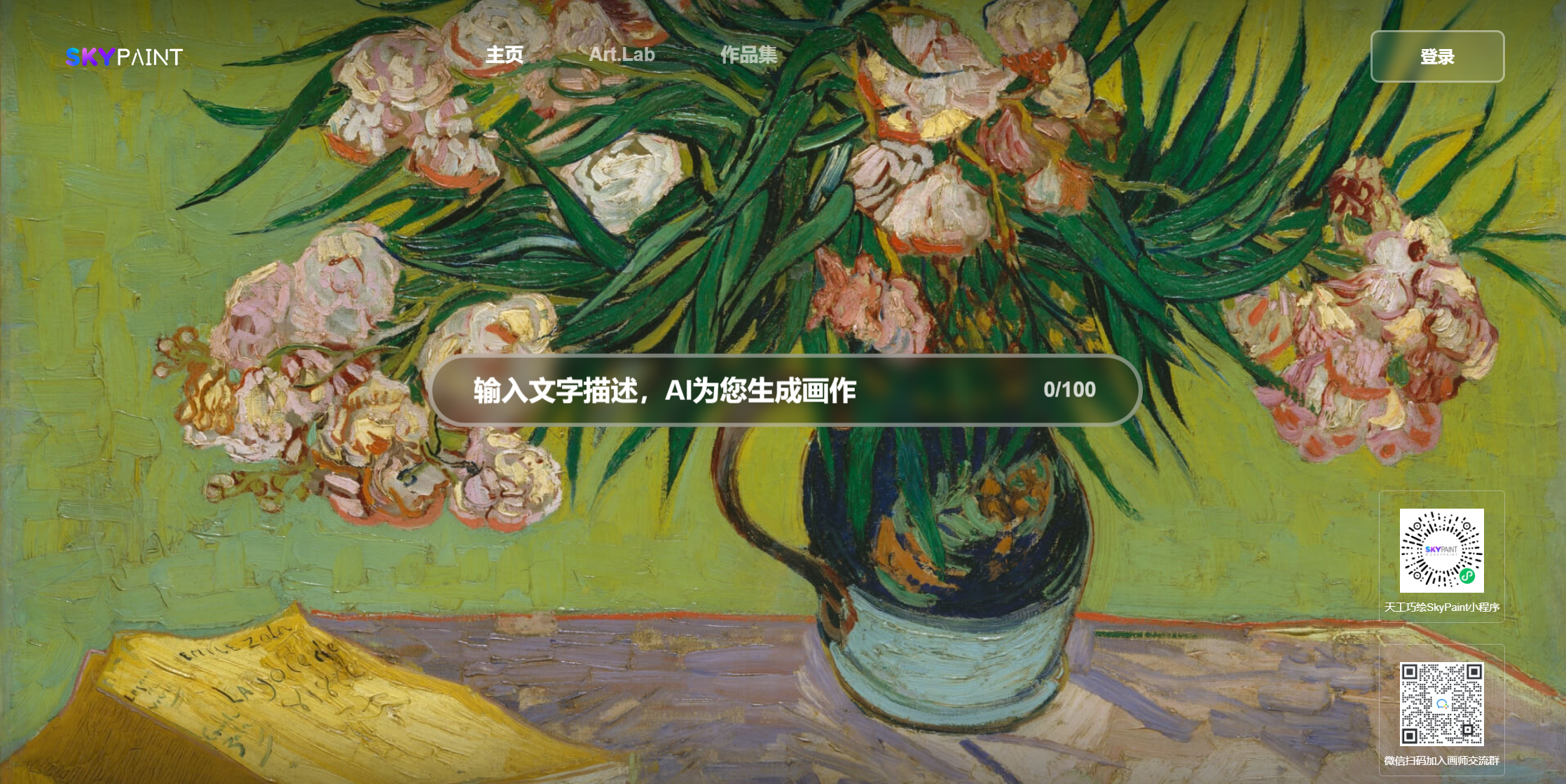

كلب ميكانيكي

قلعة البحر غروب الشمس ميازاكي الرسوم المتحركة

كم عدد الزهور تسقط

نصف دجاج ونصف رجل ، قوي

الدجاج ، أنت جميل جدا

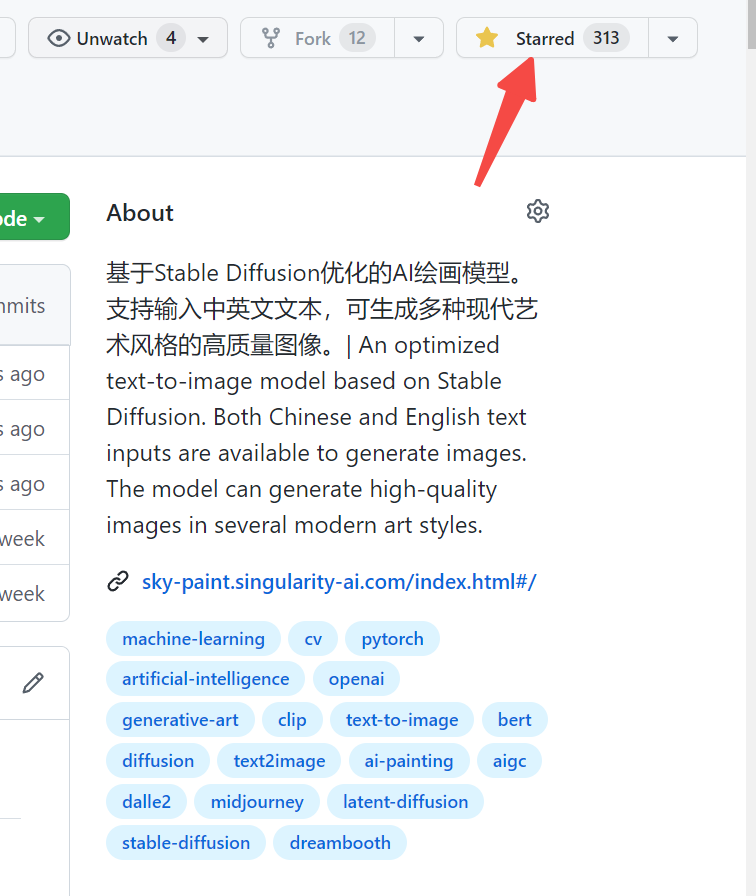

يرجى زيارة Skypaint ، Skypaint

يمكنك أيضًا مسح رمز الاستجابة السريعة على WeChat وتجربته على برنامج Mini:

يتكون نموذج صورة توليد النص Skypaint بشكل أساسي من جزأين ، وهما نموذج تشفير نص كلمة المطالبة ونموذج الانتشار. لذلك ، ينقسم التحسين لدينا أيضًا إلى خطوتين: أولاً ، استنادًا إلى Openai-Clip ، تم تحسين نموذج تشفير نص Word Word لتمكين Skypaint من الحصول على قدرات التعرف على الصينية والإنجليزية ، وبعد ذلك ، يتم تحسين نموذج الانتشار ، بحيث يتمتع Skypaint بقدرات فنية حديثة لإنتاج صور عالية الجودة.

نموذج تنزيل عنوان Skypaint-V1.0

from diffusers import StableDiffusionPipeline

device = 'cuda'

pipe = StableDiffusionPipeline . from_pretrained ( "path_to_our_model" ). to ( device )

prompts = [

'机械狗' ,

'城堡 大海 夕阳 宫崎骏动画' ,

'花落知多少' ,

'鸡你太美' ,

]

for prompt in prompts :

prompt = 'sai-v1 art, ' + prompt

image = pipe ( prompt ). images [ 0 ]

image . save ( "%s.jpg" % prompt )——————————————————————————————————————————————————————————————————————————————————————————————————————–

SkyClip هو نموذج مقطع تم الحصول عليه من خلال طريقة فعالة لتدريب نماذج المقطع الصيني والإنجليزية. تقوم هذه الطريقة بتغيير مشفر النص فقط لـ Openai-Clip ، ويمكن استخدامها لتحقيق وظيفة استرجاع الصورة والنص باستخدام Openai-Clip.

يتم استخدام Text_encoder من النماذج Openai كنموذج للمعلم. ، L2 ، يتم استخدام مسافات COS لجعل تدريجيا Hidden_State الصينية والإنجليزية من نموذج الطالب يقترب تدريجياً من نموذج Hidden_State لنموذج المعلم. نظرًا لأن الصينيين والإنجليزية من Corpus المتوازي لديهم خصائص عدم المساواة الطبيعية ، من أجل جعل الصينية والإنجليزية متوازية في أقرب وقت ممكن ، أضفنا أيضًا وحدة فك ترميز صينية أثناء عملية التدريب ، وذلك باستخدام Hidden_State الصيني والإنجليزية من نموذج الطالب من خلال مدخلات Hidden_State للمدخلات ، والمساعدة في تحقيق توافق الصينيين والإنجليزية من خلال محور الترجمة.

في الوقت الحالي ، قمنا بتقييم أداء SkyClip صفراً في Flickr30K-CN ، وقارنهم بشكل أساسي العديد من النماذج المفتوحة ذات الصلة مع القدرات الصينية.

استرجاع Flickr30K-CN :

| مهمة | نص إلى صورة | صورة إلى نص | السيد | ||||

|---|---|---|---|---|---|---|---|

| يثبت | صفر | صفر | |||||

| متري | ص@1 | ص@5 | ص@10 | ص@1 | ص@5 | ص@10 | |

| Taiyi-326m | 53.8 | 79.9 | 86.6 | 64.0 | 90.4 | 96.1 | 78.47 |

| altclip | 50.7 | 75.4 | 83.1 | 73.4 | 92.8 | 96.9 | 78.72 |

| ووكونغ | 51.9 | 78.6 | 85.9 | 75 | 94.4 | 97.7 | 80.57 |

| R2D2 | 42.6 | 69.5 | 78.6 | 63.0 | 90.1 | 96.4 | 73.37 |

| CN-CLIP | 68.1 | 89.7 | 94.5 | 80.2 | 96.6 | 98.2 | 87.87 |

| Skyclip | 58.8 | 82.6 | 89.6 | 78.8 | 96.1 | 98.3 | 84.04 |

from PIL import Image

import requests

import clip

import torch

from transformers import BertTokenizer

from transformers import CLIPProcessor , CLIPModel , CLIPTextModel

import numpy as np

query_texts = [ '一个人' , '一辆汽车' , '两个男人' , '两个女人' ] # 这里是输入提示词,可以随意替换。

# 加载SkyCLIP 中英文双语 text_encoder

text_tokenizer = BertTokenizer . from_pretrained ( "./tokenizer" )

text_encoder = CLIPTextModel . from_pretrained ( "./text_encoder" ). eval ()

text = text_tokenizer ( query_texts , return_tensors = 'pt' , padding = True )[ 'input_ids' ]

url = "http://images.cocodataset.org/val2017/000000040083.jpg" #这里可以换成任意图片的url

# 加载CLIP的image encoder

clip_model = CLIPModel . from_pretrained ( "openai/clip-vit-large-patch14" )

clip_text_proj = clip_model . text_projection

processor = CLIPProcessor . from_pretrained ( "openai/clip-vit-large-patch14" )

image = processor ( images = Image . open ( requests . get ( url , stream = True ). raw ), return_tensors = "pt" )

with torch . no_grad ():

image_features = clip_model . get_image_features ( ** image )

text_features = text_encoder ( text )[ 0 ]

# sep_token对应于openai-clip的eot_token

sep_index = torch . nonzero ( text == student_tokenizer . sep_token_id )

text_features = text_features [ torch . arange ( text . shape [ 0 ]), sep_index [:, 1 ]]

# 乘text投影矩阵

text_features = clip_text_proj ( text_features )

image_features = image_features / image_features . norm ( dim = 1 , keepdim = True )

text_features = text_features / text_features . norm ( dim = 1 , keepdim = True )

# 计算余弦相似度 logit_scale是尺度系数

logit_scale = clip_model . logit_scale . exp ()

logits_per_image = logit_scale * image_features @ text_features . t ()

logits_per_text = logits_per_image . t ()

probs = logits_per_image . softmax ( dim = - 1 ). cpu (). numpy ()

print ( np . around ( probs , 3 ))تستخدم بياناتنا مجموعة بيانات Laion المصفاة كبيانات التدريب ، ويسبق النص "SAI-V1 Art" كعلامة لتمكين النموذج من تعلم النمط والجودة التي نريدها بسرعة أكبر. يستخدم النموذج الذي تم تدريبه مسبقًا الانتشار المستقر-V1-5 كمدربة مسبقة ، وتم استخدام 16 A100 لمدة 50 ساعة. في الوقت الحاضر ، لا يزال النموذج هو الأمثل بشكل مستمر ، وسيكون هناك تحديثات طراز أكثر استقرارًا في المستقبل.