Podfai

Esta aplicación permite al usuario crear contenido en el estilo de podcasts basado en los archivos proporcionados. Algunos ejemplos serían proporcionar un documento, conferencia, descripción del proyecto, currículum personal o muchos otros.

También escribí una publicación de blog para hablar sobre este proyecto, asegúrese de verificar " cómo usar la IA generativa para crear contenido de estilo podcast a partir de cualquier entrada ".

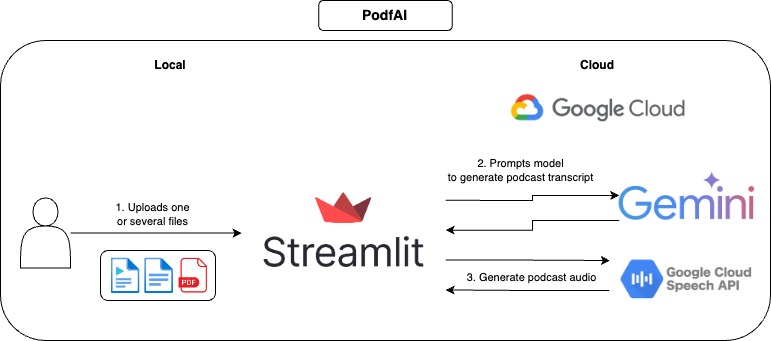

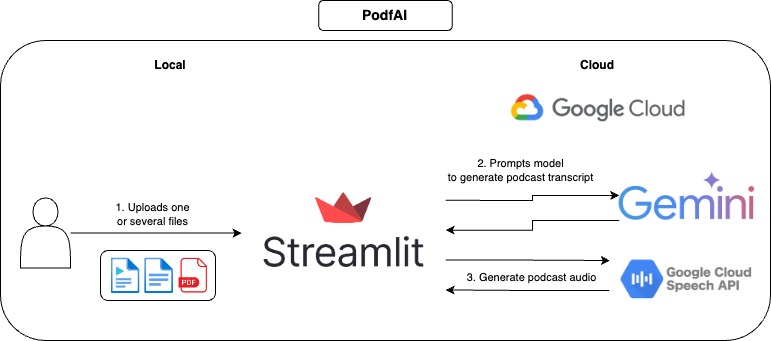

Cómo funciona

Cómo usar

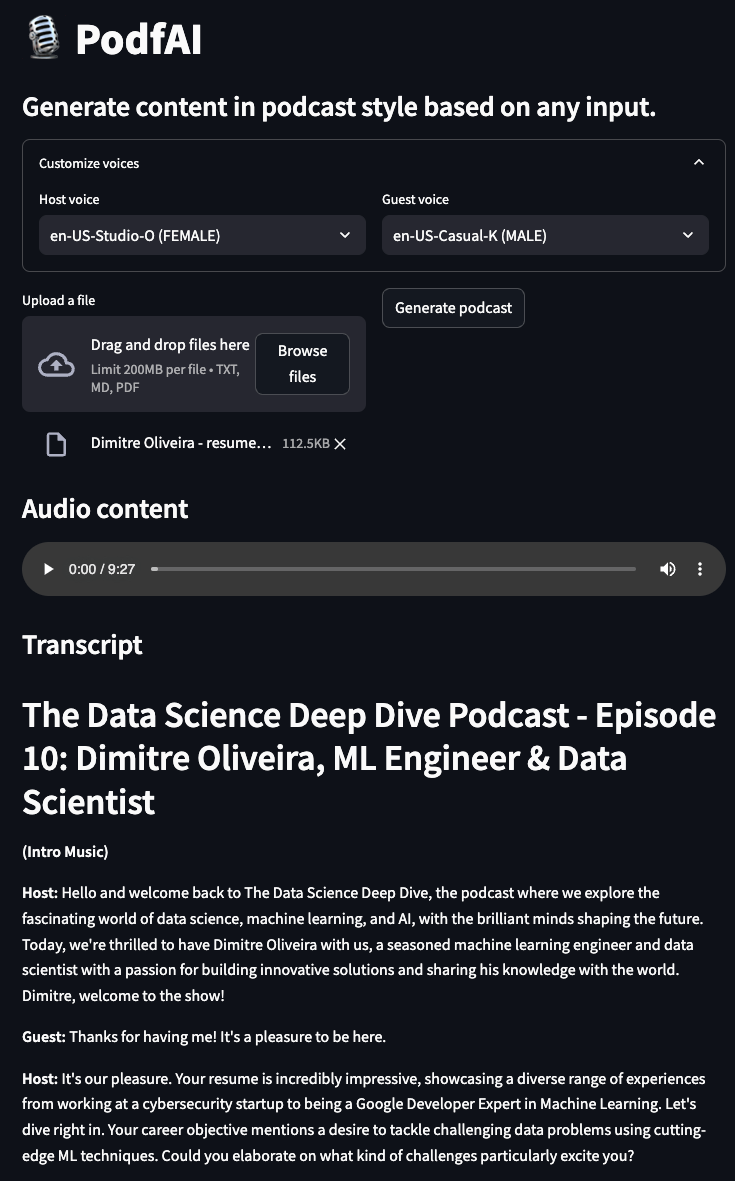

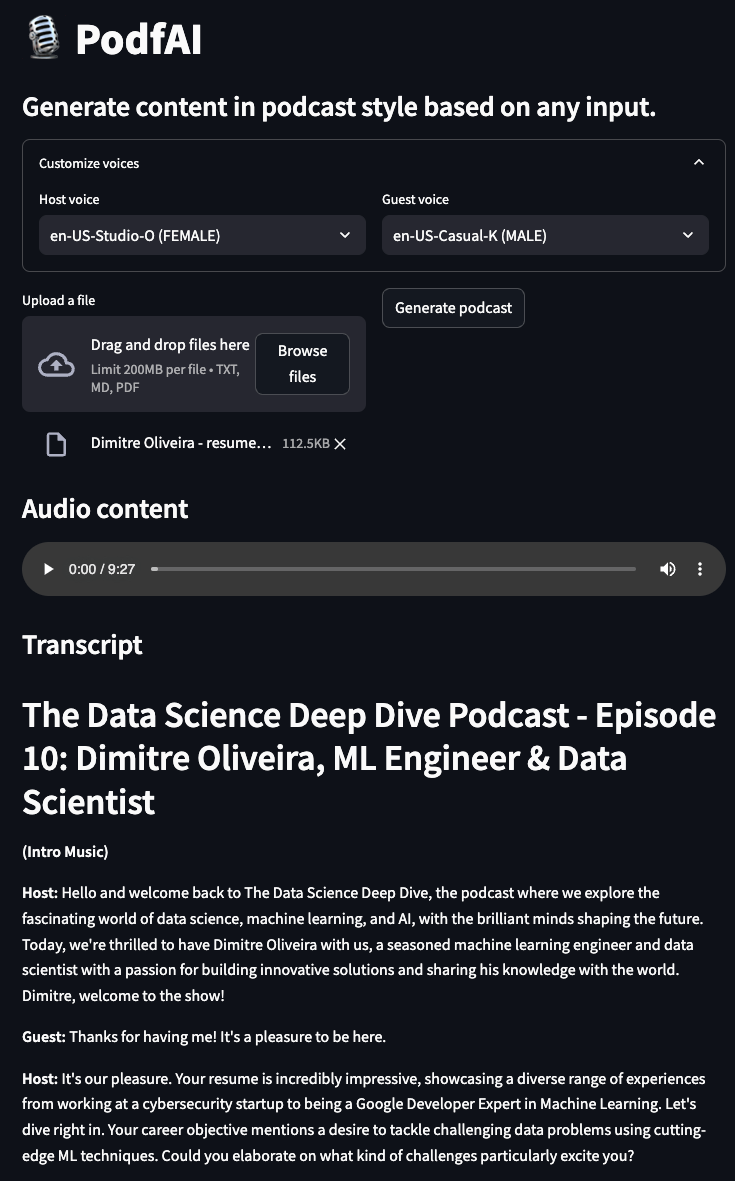

- Proporcione uno o más archivos.

- Opcionalmente, personalice las voces del invitado y el anfitrión, puede consultar las muestras de voz aquí.

- Haga clic en "Generar podcast" y esperar unos momentos.

- Reproduzca el audio y no dude en seguir la transcripción textual.

Ejemplos

El podcast genera de mi otro proyecto "AI Beats"

podcast-ai_beast.mp4

El podcast genera a partir de mi otro proyecto "Trailer AI"

podcast-ai_trailer.mp4

El podcast genera la descripción de la "rutina de la mañana óptima" de Andrew Huberman

podcast-andrew_hubermans.mp4

Podcast generado por un currículum personal

podcast-resume.mp4

Uso local

Configuración

- Clon el repositorio de Github

https://github.com/dimitreOliveira/PodfAI.git

cd PodfAI

- Crea un nuevo Venv

python -m venv .venvs/podfai

- Activar el venv

source .venvs/podfai/bin/activate

- Instalar los requisitos

Alternativamente, también puede ejecutar con pip

pip install -r requirements

- Configurar las dependencias de la API de Google

- Siga esta guía o esta otra.

Ejecutando la aplicación

Para iniciar la aplicación, ejecute el comando Make a continuación

Alternativamente, también puedes ejecutar usando Python simple

streamlit run src / app . py

Configuraciones

No dude en cambiar las configuraciones predeterminadas para cambiar el comportamiento de la aplicación o ajustar a sus necesidades.

vertex:

project: {VERTEX_AI_PROJECT}

location: {VERTEX_AI_LOCATION}

transcript:

model_id: gemini-1.5-pro-002

transcript_len: 5000

max_output_tokens: 8192

temperature: 1

top_p: 0.95

top_k: 32

- vértice

- Proyecto: Nombre del proyecto utilizado por Vertex AI.

- Ubicación: Ubicación del proyecto Ubicación utilizada por Vertex AI.

- transcripción

- Model_id: Modelo utilizado para crear la transcripción de podcast.

- Transcript_len: longitud de transcripción sugerida.

- max_output_tokens: número máximo de tokens generados por el modelo.

- Temperatura: la temperatura controla el grado de aleatoriedad en la selección de tokens. Las temperaturas más bajas son buenas para las indicaciones que esperan una respuesta verdadera o correcta, mientras que las temperaturas más altas pueden conducir a resultados más diversos o inesperados. Con una temperatura de 0, siempre se selecciona el token de mayor probabilidad

- TOP_P: TOP-P cambia cómo el modelo selecciona tokens para la salida. Los tokens se seleccionan de la mayoría de los más probables a menos hasta que la suma de sus probabilidades sea igual al valor de TOP-P. Por ejemplo, si las fichas A, B y C tienen una probabilidad de .3, .2 y .1 y el valor superior-P es .5, entonces el modelo seleccionará A o B como el siguiente token (usando temperatura)

- Top_k: Top-K cambia cómo el modelo selecciona tokens para la salida. Un top-k de 1 significa que el token seleccionado es el más probable entre todos los tokens en el vocabulario del modelo (también llamado decodificación codiciosa), mientras que un top-k de 3 significa que el siguiente token se selecciona entre las 3 tokens más probables (usando temperatura)

HACER

- Apoyo a la clonación de voz

- Apoyar otros idiomas

- Admite otros tipos de entrada (imágenes, videos, URL de YouTube)

- Agregar un cuaderno de ejemplo para ejecutar en Colab

- Reproducir el flujo de trabajo con modelos de código abierto

- Experimentar con flujos de trabajo de agente para mejorar la transcripción de podcast

Referencias

- Google Cloud: bibliotecas de clientes de texto a voz

- Configurar Google Cloud TTS localmente

- Lista de voz de Google Cloud TTS

Que contribuye

Si está interesado en contribuir a este proyecto, ¡muchas gracias! Antes de crear su PR, asegúrese de vincular su código, ejecutando el comando a continuación:

Expresiones de gratitud

- Se proporcionan créditos en la nube de Google para este proyecto. Este proyecto fue posible gracias al apoyo del equipo de programas de desarrolladores de ML de Google.

- Este proyecto se basó en el cuaderno de Google, que, aparte del contenido de estilo podcast, tiene muchas otras características, asegúrese de verlo.