Podfai

Mit dieser App kann der Benutzer Inhalte im Stil von Podcasts basierend auf den bereitgestellten Dateien erstellen. Einige Beispiele würden darin bestehen, ein Papier, eine Vorlesung, eine Projektbeschreibung, einen persönlichen Lebenslauf oder viele andere zu liefern.

Ich habe auch einen Blog-Beitrag geschrieben, um über dieses Projekt zu sprechen. Überprüfen Sie , ob Sie "generative KI verwenden, um Inhalte im Podcast-Stil aus jeder Eingabe zu erstellen ".

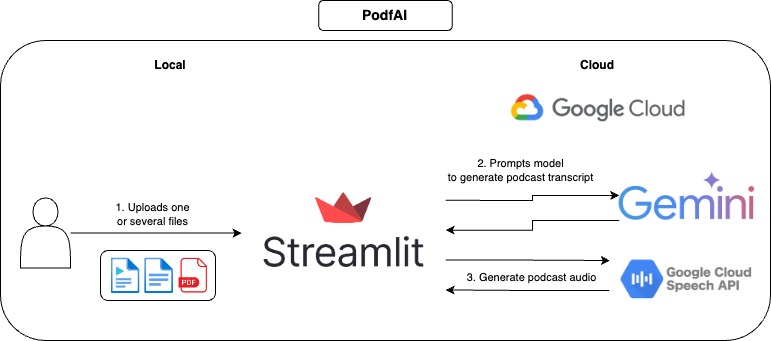

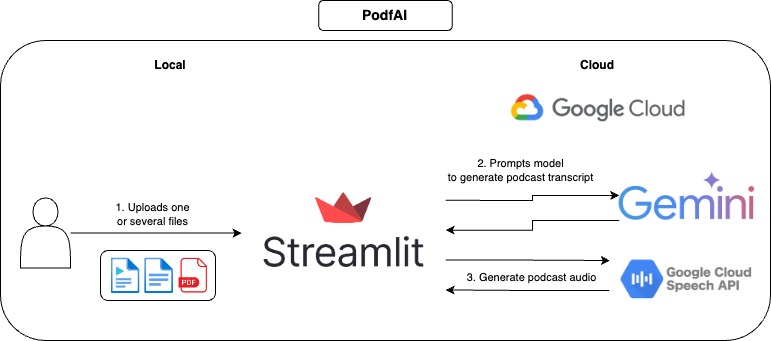

Wie es funktioniert

Wie man benutzt

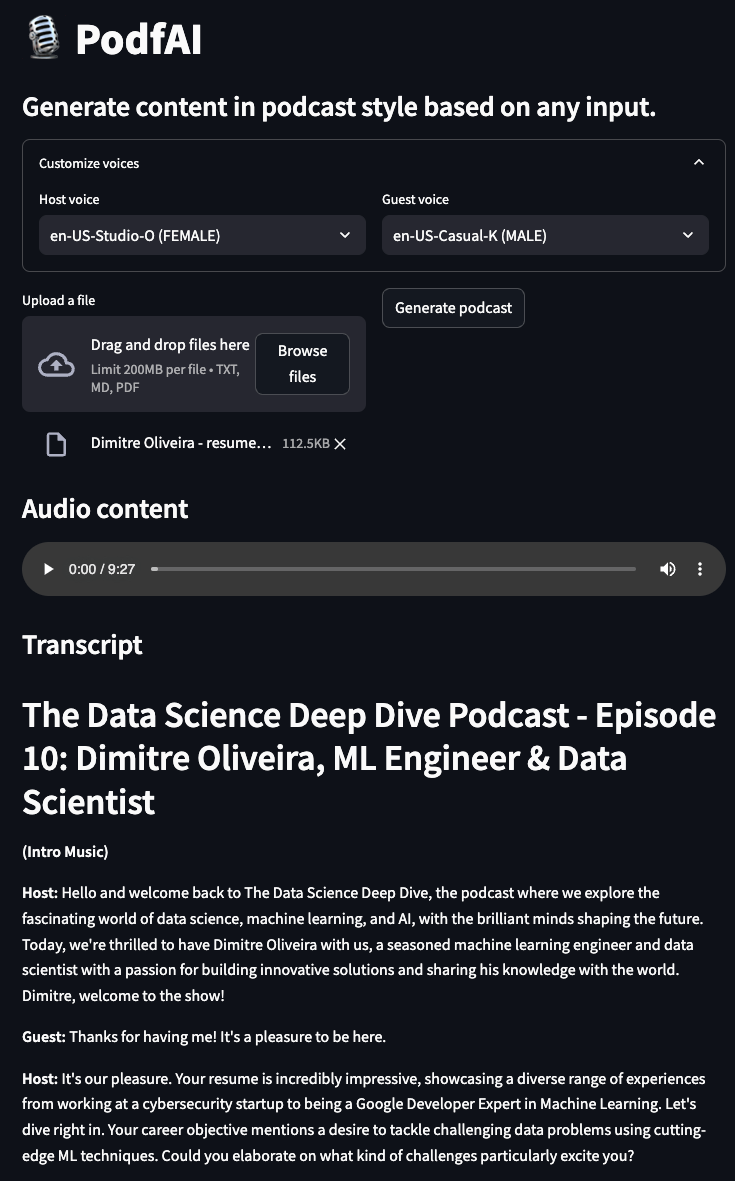

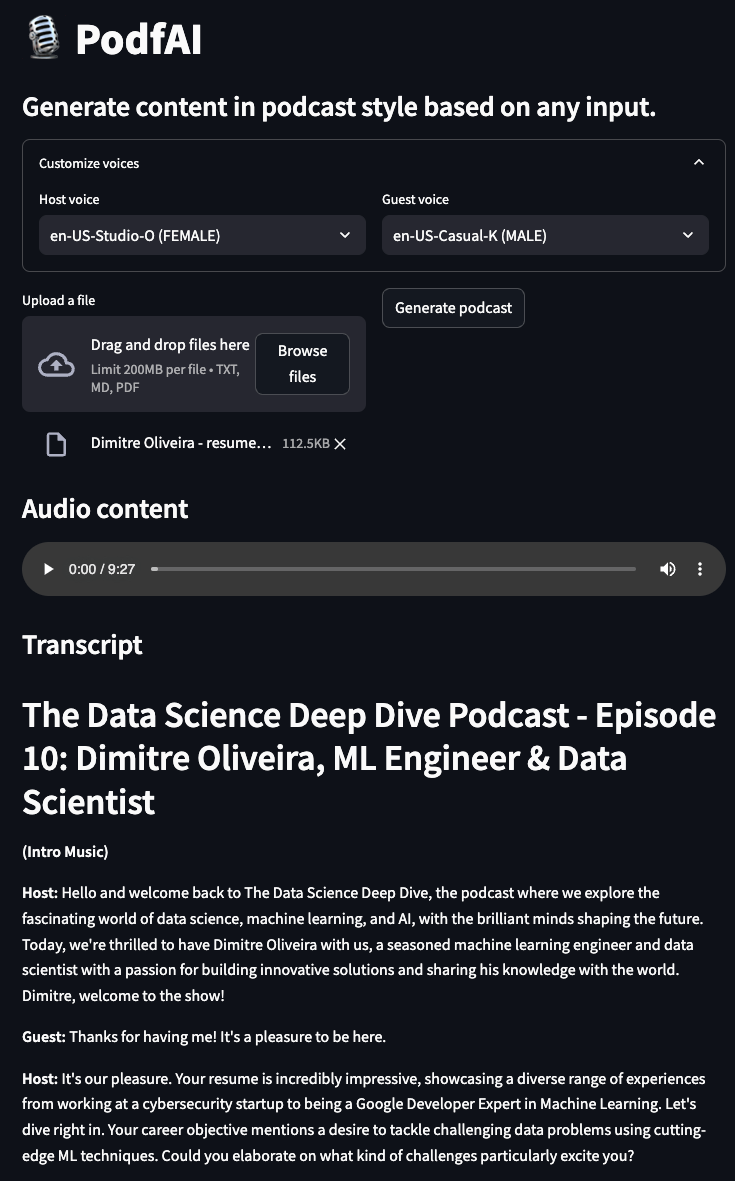

- Geben Sie eine oder mehrere Dateien an.

- Optional passen Sie die Stimmen des Gastes und des Hosts an, und Sie können sich die Sprachmuster hier ansehen.

- Klicken Sie auf "Podcast generieren" und warten Sie einige Momente.

- Spielen Sie das Audio und folgen Sie dem Text -Transkript.

Beispiele

Podcast erzeugt aus meinem anderen Projekt "AI Beats"

podcast-ai_beast.mp4

Podcast erzeugt aus meinem anderen Projekt "AI Trailer"

podcast-ai_trailer.mp4

Podcast erzeugt aus Andrew Hubermans "optimaler Morgenroutine" Beschreibung

Podcast-Andrew_Hubermans.mp4

Podcast erzeugt durch einen persönlichen Lebenslauf

podcast-resume.mp4

Lokale Nutzung

Aufstellen

- Klonen Sie das Github -Repository

https://github.com/dimitreOliveira/PodfAI.git

cd PodfAI

- Erstellen Sie ein neues Gebiet

python -m venv .venvs/podfai

- Aktivieren Sie das Gebiet

source .venvs/podfai/bin/activate

- Installieren Sie die Anforderungen

Alternativ können Sie auch mit pip laufen

pip install -r requirements

- Richten Sie die Google API -Abhängigkeiten ein

- Folgen Sie diesem einen oder diesem anderen Leitfaden.

Ausführen der App

Führen Sie den folgenden Befehl zum Starten der App aus

Alternativ können Sie auch mit einfachem Python laufen

streamlit run src / app . py

Konfigurationen

Ändern Sie die Standardkonfigurationen, um das App -Verhalten zu ändern oder an Ihre Anforderungen anzupassen.

vertex:

project: {VERTEX_AI_PROJECT}

location: {VERTEX_AI_LOCATION}

transcript:

model_id: gemini-1.5-pro-002

transcript_len: 5000

max_output_tokens: 8192

temperature: 1

top_p: 0.95

top_k: 32

- Scheitel

- Projekt: Projektname, der von Vertex AI verwendet wird.

- Ort: Projektort, der von Vertex AI verwendet wird.

- Transkript

- model_id: Modell zum Erstellen des Podcast -Transkripts.

- Transcript_len: Vorgeschlagene Transkriptlänge.

- max_output_tokens: Maximale Anzahl der vom Modell generierten Token.

- Temperatur: Temperatur steuert den Zufälligkeitsgrad in der Token -Auswahl. Niedrigere Temperaturen eignen sich gut für Aufforderungen, die eine echte oder korrekte Reaktion erwarten, während höhere Temperaturen zu vielfältigeren oder unerwarteten Ergebnissen führen können. Mit einer Temperatur von 0 wird immer die höchste Wahrscheinlichkeits -Token ausgewählt

- TOP_P: Top-P ändert die Auswahl des Modells für die Ausgabe. Token werden von höchstem Wahrscheinlichkeit bis zumindest ausgewählt, bis die Summe ihrer Wahrscheinlichkeiten dem Top-P-Wert entspricht. Wenn die Token A, B und C beispielsweise eine Wahrscheinlichkeit von 0,3, .2 und .1 haben und der Top-P-Wert 0,5 beträgt, wählt das Modell entweder A oder B als nächstes Token aus (unter Verwendung der Temperatur).

- TOP_K: Top-K ändert die Auswahl des Modells für die Ausgabe. Ein Top-K von 1 bedeutet, dass das ausgewählte Token unter allen Token im Wortschatz des Modells (auch als gierige Dekodierung bezeichnet) am wahrscheinlichsten ist, während ein Top-K von 3 bedeutet, dass das nächste Token unter den drei wahrscheinlichsten Token (mit Temperatur) ausgewählt wird (unter Verwendung der Temperatur) ausgewählt wird (mit Temperatur) ausgewählt wird

Todo

- Unterstützungsstimmklone

- Unterstützen Sie andere Sprachen

- Unterstützen Sie andere Eingabetypen (Bilder, Videos, YouTube -URLs)

- Fügen Sie ein Beispiel Notebook hinzu, um in Colab auszuführen

- Reproduzieren Workflow mit Open-Source-Modellen

- Experimentieren Sie mit Agenten -Workflows, um das Podcast -Transkript zu verbessern

Referenzen

- Google Cloud-Text-to-Speech-Clientbibliotheken

- Setzen Sie Google Cloud TTS lokal ein

- Google Cloud TTS -Sprachliste

Beitragen

Wenn Sie daran interessiert sind, zu diesem Projekt beizutragen, vielen Dank! Stellen Sie vor dem Erstellen Ihrer PR Ihren Code ab und führen Sie den folgenden Befehl aus:

Anerkennung

- Für dieses Projekt werden Google Cloud -Credits bereitgestellt. Dieses Projekt war dank der Unterstützung des ML Developer Programs -Teams von Google möglich.

- Dieses Projekt basiert auf Googles NotebookLM, das neben dem Inhalt im Podcast-Stil viele andere Funktionen aufweist, überprüfen Sie es sicher, dass Sie es sich ansehen.