AI -Assistent

Es ist ein Versuch zu lernen, wie man LLM ausnutzt und ein besseres Produkt kreiert.

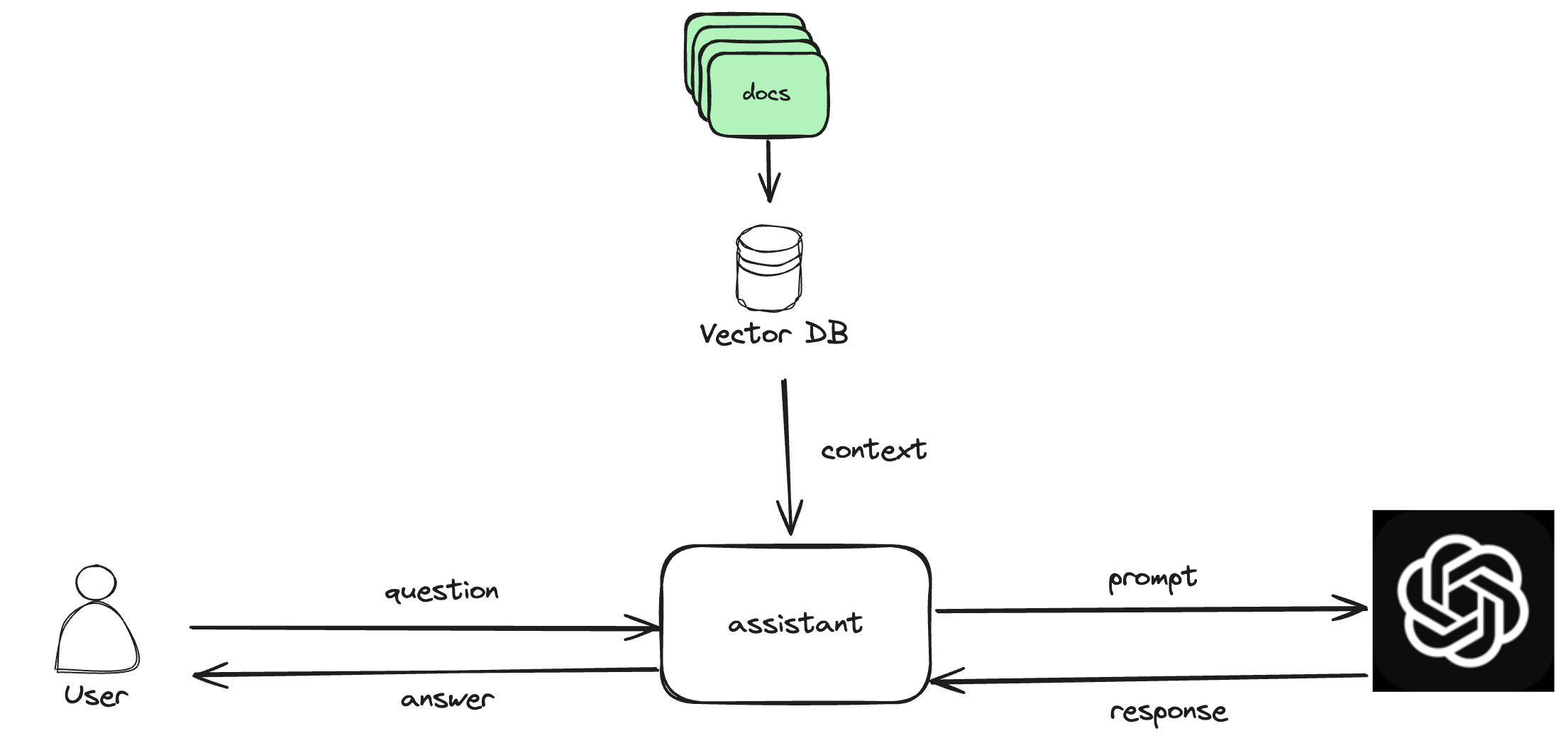

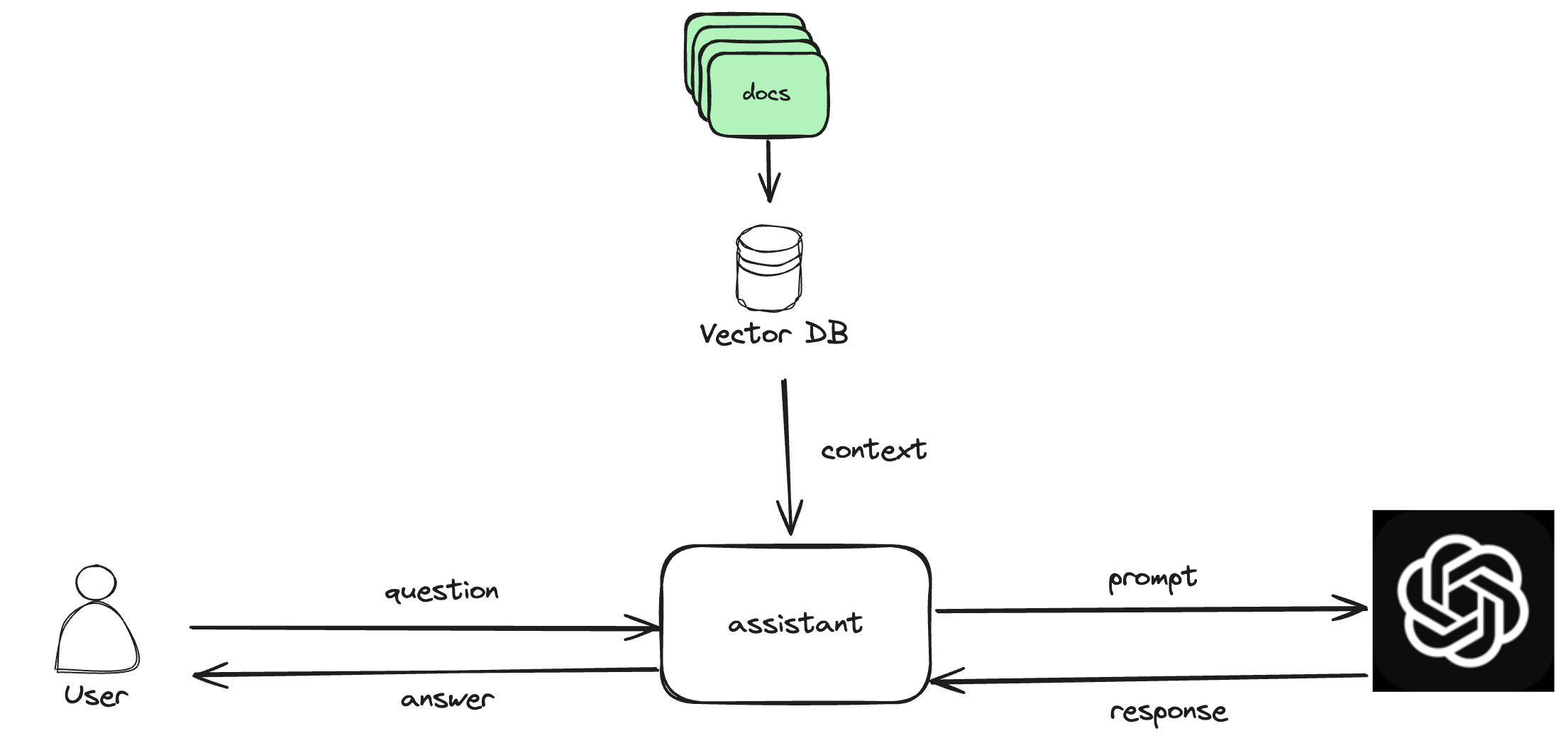

- DOC Summariizer (Fertig) Benutzer laden das Dokument hoch oder präsentiert seine Dokumente, die in der Vektor -Datenbank gespeichert werden. Wenn der Benutzer nun befragt, übergeben Sie diese Abfrage zunächst an Vector DB, was den Kontext mithilfe der Ähnlichkeitssuche zurückgibt. Übergeben Sie Frage und Kontext an LLM mit der Eingabeaufforderung, die die Antwort nur aus dem bereitgestellten Kontext zurückgibt. Halten Sie auch Unterstützung für den Chat -Verlauf, sodass eine bestimmte Sitzung für den Benutzer relevant wird.

- Sprachassistent (Todo)

- Suchmaschine (Todo)

Installation

Befolgen Sie die folgenden Schritte, um den AI -Assistenten einzurichten:

- Installieren Sie die erforderlichen Abhängigkeiten:

pip install -r requirements.txt

- Rufen Sie einen API -Schlüssel bei Google und kopieren Sie in .Env -Datei

- Sie können vorhandene Dokumente auch lokal konvertieren, ohne das Hochladen mithilfe zu verwenden

- Starten Sie die Anwendung:

TechStack

- Langchain

- Chromadb

- Straffung

- LLM - Google Gemini

Sterngeschichte