"李太白少时 , 梦所用之笔头上生花后天才赡逸 , 名闻天下。" —— 王仁裕《开元天宝遗事 · 梦笔头生花》

Textbox 2.0: مكتبة لتوليد النصوص مع نماذج لغة مدربة مسبقًا

Textbox 2.0 هي مكتبة توليد نص محدثة تستند إلى Python و Pytorch تركز على بناء خط أنابيب موحد وموحد لتطبيق نماذج اللغة التي تم تدريبها مسبقًا على توليد النص:

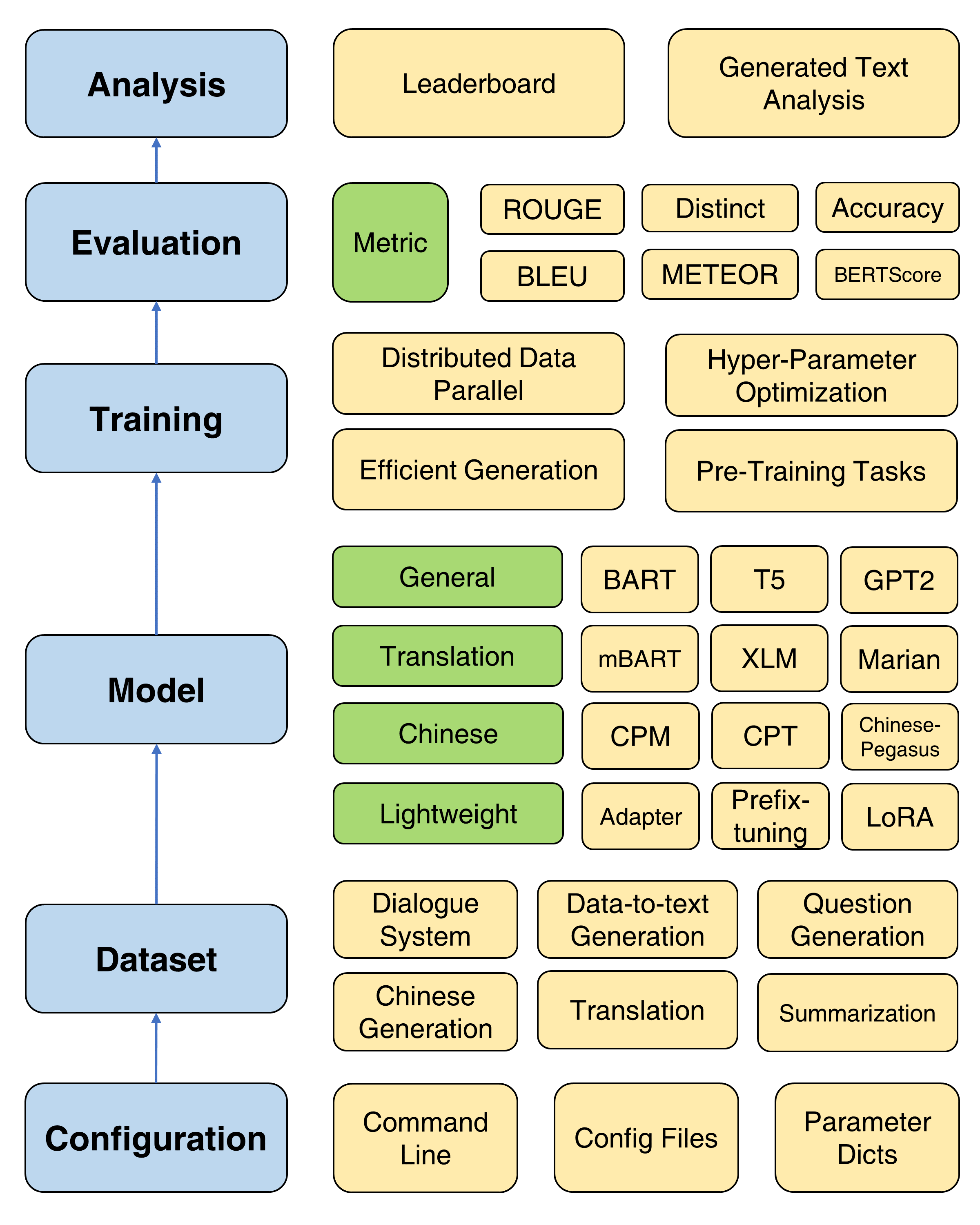

بالمقارنة مع الإصدار السابق من TextBox ، يركز هذا الامتداد بشكل أساسي على بناء إطار عمل موحد ومرن وموحد لنماذج توليد النص المستندة إلى PLM بشكل أفضل. هناك ثلاث مزايا من Textbox 2.0:

الإطار العام لمربع النص 2.0

بالنظر إلى أنه سيتم تثبيت نسخة معدلة من المحولات ، يوصى بإنشاء بيئة جديدة للكوندا:

conda create -n TextBox python=3.8بعد ذلك ، يمكنك استنساخ مستودعنا وتثبيته بنقرة واحدة.

git clone https://github.com/RUCAIBox/TextBox.git && cd TextBox

bash install.sh إذا واجهت مشكلة ROUGE-1.5.5.pl - XML::Parser dependency error عند تثبيت files2rouge ، يمكنك الرجوع إلى هذه المشكلة.

هذا قالب نصوص لتشغيل Textbox 2.0 في خط أنابيب من طرف إلى طرف:

python run_textbox.py --model= < model-name > --dataset= < dataset-name > --model_path= < hf-or-local-path > Substulate --model=<xxx> و --dataset=<xxx> و --model_path=<xxx> مع اختياراتك.

يمكن العثور على خيارات model و model_path في النموذج. نحن نقدم التعليمات التفصيلية لكل نموذج في تلك الصفحة.

يمكن العثور على خيارات dataset في مجموعة البيانات. يجب عليك تنزيل مجموعة البيانات على https://huggingface.co/Rucaibox ووضع مجموعة البيانات التي تم تنزيلها تحت مجلد dataset تمامًا مثل Samsum. إذا كنت ترغب في استخدام مجموعة البيانات الخاصة بك ، فيرجى الرجوع إلى هنا.

سيقوم البرنامج النصي أدناه بتشغيل طراز Facebook BART-base على مجموعة بيانات samsum :

python run_textbox.py --model=BART --dataset=samsum --model_path=facebook/bart-baseللتدريب الأساسي ، نقدم برنامجًا تعليميًا مفصلاً (هنا) لإعداد المعلمات شائعة الاستخدام مثل المحسن ، والمجدول ، وتردد التحقق من الصحة ، والتوقف المبكر ، وما إلى ذلك.

يوفر Textbox 2.0 أربعة أهداف قبل التدريب لمساعدة المستخدمين قبل تدريب نموذج من نقطة الصفر ، بما في ذلك نمذجة اللغة ، ونمذجة التسلسل المقنعة إلى التسلسل ، وترميز التلقائي التلقائي ، والتنبؤ بالمسافة المقنعة. انظر المستند قبل التدريب للحصول على تعليمي مفصل.

يتم توفير أربع طرق تدريب مفيدة لتحسين تحسين PLMs: البيانات الموزعة الموازية ، فك التشفير الفعال ، تحسين المعلمة المفرطة ، والتجارب المتكررة. يتم توفير تعليمات مفصلة هنا.

لدعم التقدم السريع لـ PLMS على توليد النص ، يتضمن Textbox 2.0 47 طرازًا/وحدات ، تغطي فئات النماذج العامة والترجمة والتصنيع والحوار ، والتحكم ، والمقطرة ، والمطالبة ، وخفيفة الوزن (الوحدات النمطية). راجع مستند النموذج للحصول على معلومات حول تعليمات الاستخدام التفصيلية لكل نموذج ، ومعلمات النماذج التي تم تدريبها مسبقًا ، ومعلمات التوليد.

نحن الآن ندعم 13 مهمة توليد (على سبيل المثال ، الترجمة وتوليد القصة) ومجموعات البيانات 83 المقابلة. نحن نقدم أيضًا الوصف والإحصاءات الأساسية وعينات التدريب/التحقق/الاختبار ، ومتصدرين لكل مجموعة بيانات. انظر المزيد من التفاصيل هنا.

يدعم Textbox 2.0 17 مقاييسًا تلقائية لـ 4 فئات وعدة أدوات تصور لاستكشاف وتحليل النصوص التي تم إنشاؤها بأبعاد مختلفة. للحصول على تفاصيل التقييم ، راجع مستند التقييم.

| الإصدارات | تاريخ | سمات |

|---|---|---|

| v2.0.1 | 24/12/2022 | Textbox 2.0 |

| v2.0.0 | 20/08/2022 | Textbox 2.0 بيتا |

| v0.2.1 | 15/04/2021 | مربع النص |

| v0.1.5 | 01/11/2021 | مربع النص الأساسي |

يرجى إعلامنا إذا واجهت خطأ أو لديك أي اقتراحات من خلال تقديم مشكلة.

نرحب بجميع المساهمات من إصلاحات الأخطاء في الميزات والامتدادات الجديدة.

نتوقع مناقشة جميع المساهمات التي تمت مناقشتها في تعقب القضية والمرور من خلال PRS.

نشكر @lucastsui0725 للمساهمة النموذج Hred والعديد من مقاييس التقييم.

نشكر wxdai على المساهمة Pointernet وأكثر من 20 نموذج لغة في API Transformers.

تم تطوير مربع النص وصيانته بواسطة مربع الذكاء الاصطناعي.

يستخدم TextBox ترخيص MIT.

إذا وجدت Textbox 2.0 مفيدًا للبحث أو التطوير ، فيرجى الاستشهاد بالأوراق التالية:

@inproceedings{tang-etal-2022-textbox,

title = "{T}ext{B}ox 2.0: A Text Generation Library with Pre-trained Language Models",

author = "Tang, Tianyi and Li, Junyi and Chen, Zhipeng and Hu, Yiwen and Yu, Zhuohao and Dai, Wenxun and Zhao, Wayne Xin and Nie, Jian-yun and Wen, Ji-rong",

booktitle = "Proceedings of the The 2022 Conference on Empirical Methods in Natural Language Processing: System Demonstrations",

month = dec,

year = "2022",

address = "Abu Dhabi, UAE",

publisher = "Association for Computational Linguistics",

url = "https://aclanthology.org/2022.emnlp-demos.42",

pages = "435--444",

}

@inproceedings{textbox,

title = "{T}ext{B}ox: A Unified, Modularized, and Extensible Framework for Text Generation",

author = "Li, Junyi and Tang, Tianyi and He, Gaole and Jiang, Jinhao and Hu, Xiaoxuan and Xie, Puzhao and Chen, Zhipeng and Yu, Zhuohao and Zhao, Wayne Xin and Wen, Ji-Rong",

booktitle = "Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing: System Demonstrations",

month = aug,

year = "2021",

address = "Online",

publisher = "Association for Computational Linguistics",

url = "https://aclanthology.org/2021.acl-demo.4",

doi = "10.18653/v1/2021.acl-demo.4",

pages = "30--39",

}