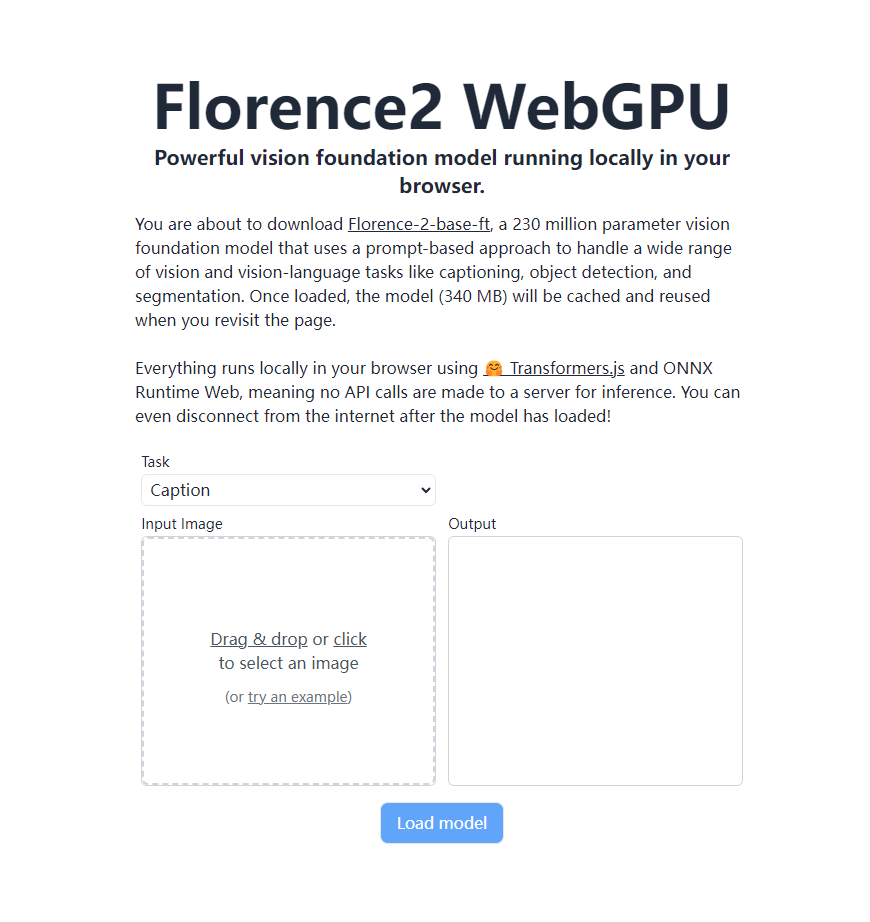

微軟最新視覺基礎模型Florence-2實現了重大突破,它可以完全在支援WebGPU的瀏覽器中本地運行,無需依賴遠端伺服器。這得歸功於Transformers.js和ONNX Runtime Web技術,使得強大的視覺識別功能直接在使用者瀏覽器中實現,徹底改變了AI視覺應用的運作方式。 Florence-2-base-ft擁有2.3億參數,基於提示的方法處理各種視覺和視覺語言任務,包括影像描述產生、OCR、物件偵測和影像分割等功能,且僅佔用340MB儲存空間。 即使在離線狀態下,也能繼續使用已載入的模型。

近日,微軟推出的最新視覺基礎模型Florence-2取得重大突破,借助Transformers.js技術,該模型現已能夠在支援WebGPU的瀏覽器中100%本地運行。這項突破為AI視覺應用帶來了革命性的變化,使得強大的視覺識別功能可以直接在用戶的瀏覽器中實現,無需依賴遠端伺服器。

Florence-2-base-ft是一個擁有2.3億參數的視覺基礎模型,採用基於提示的方法來處理廣泛的視覺和視覺語言任務。此模型支援多種功能,包括但不限於:

影像描述產生光學字元辨識(OCR)物體偵測影像分割

這個強大的模型僅佔用340MB儲存空間,一旦加載完成,就會被緩存在瀏覽器中,用戶再次訪問頁面時可以直接調用,無需重新下載。最令人驚嘆的是,整個過程完全在用戶的瀏覽器中本地進行,不需要向伺服器發送任何API呼叫。這意味著,在模型加載完成後,即使斷開互聯網連接,用戶仍然可以使用所有功能。

Florence-2的在地化運作得益於Transformers.js和ONNX Runtime Web技術的支援。這項突破不僅提高了用戶隱私保護水平,也大大降低了使用成本,為AI視覺技術的普及應用鋪平了道路。

對於開發者和技術愛好者來說,Florence-2的ONNX模型已經在Hugging Face平台上開放取用。有興趣的朋友可以上https://huggingface.co/models?library=transformers.js&other=florence2查看更多詳情。此外,專案的原始碼也已在GitHub上公開,開發者可以透過https://github.com/xenova/transformers.js/tree/v3/examples/florence2-webgpu 取得並進行進一步的探索和開發。

Florence-2的這項突破無疑將推動AI視覺應用的快速發展和廣泛普及。我們可以期待在不久的將來,更多基於瀏覽器的智慧視覺應用將改變我們的日常生活和工作方式。

Florence-2的在地運作能力,提升了使用者隱私和便利性,降低了使用門檻,為AI視覺應用的未來發展帶來了無限可能。 其開源的模型和程式碼也為開發者提供了豐富的資源,期待更多創新應用的出現。