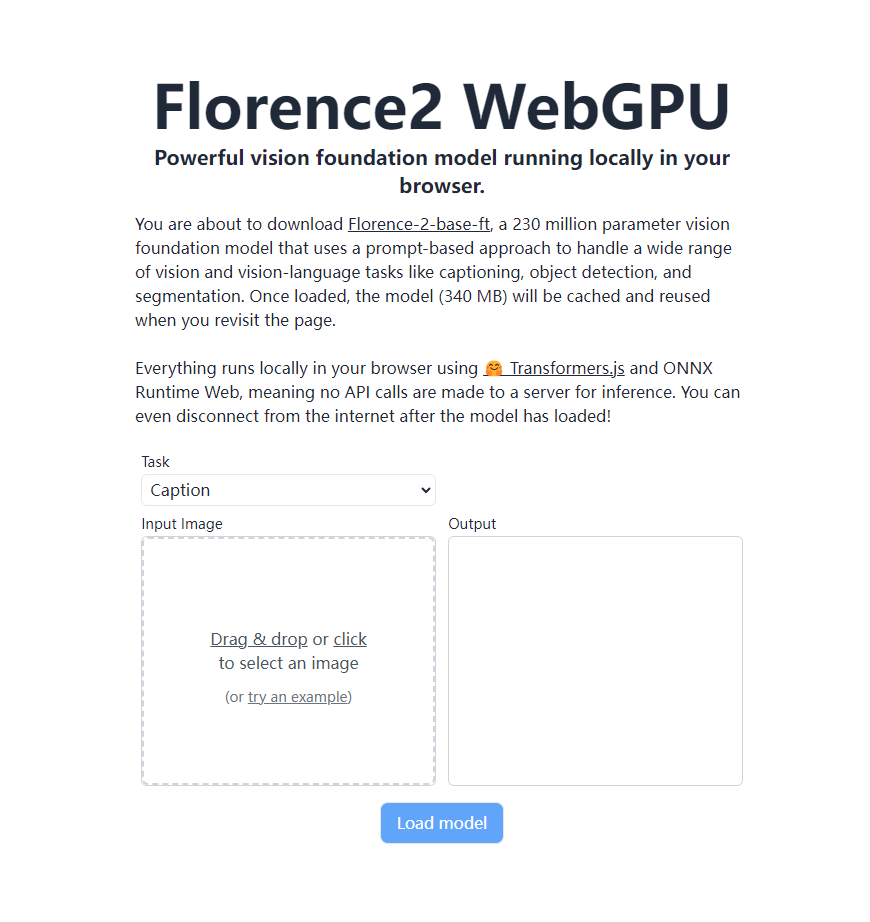

Microsofts neuestes visuelles Basismodell Florence-2 hat einen großen Durchbruch erzielt. Es kann vollständig lokal in einem Browser ausgeführt werden, der WebGPU unterstützt, ohne auf einen Remote-Server angewiesen zu sein. Dies ist der Transformers.js- und ONNX Runtime Web-Technologie zu verdanken, die die Implementierung leistungsstarker visueller Erkennungsfunktionen direkt im Browser des Benutzers ermöglicht und die Art und Weise, wie KI-Vision-Anwendungen ausgeführt werden, völlig verändert. Florence-2-base-ft verfügt über 230 Millionen Parameter und verwendet einen auf Hinweisen basierenden Ansatz, um eine Vielzahl visueller und visueller Sprachaufgaben zu bewältigen, einschließlich Bildbeschreibungsgenerierung, OCR, Objekterkennung und Bildsegmentierung, und belegt dabei nur 340 MB Speicherplatz. Arbeiten Sie auch offline mit geladenen Modellen weiter.

Vor kurzem hat das neueste visuelle Basismodell Florence-2 von Microsoft einen großen Durchbruch erzielt. Mit der Transformers.js-Technologie kann das Modell nun zu 100 % nativ in Browsern ausgeführt werden, die WebGPU unterstützen. Dieser Durchbruch hat revolutionäre Veränderungen bei KI-Vision-Anwendungen mit sich gebracht und ermöglicht die Implementierung leistungsstarker visueller Erkennungsfunktionen direkt im Browser des Benutzers, ohne auf Remote-Server angewiesen zu sein.

Florence-2-base-ft ist ein Vision-Basismodell mit 230 Millionen Parametern, das einen Cue-basierten Ansatz verwendet, um ein breites Spektrum an Vision- und visuellen Sprachaufgaben zu bewältigen. Das Modell unterstützt eine Vielzahl von Funktionen, darunter unter anderem:

Bildbeschreibungserzeugung, optische Zeichenerkennung (OCR), Objekterkennung, Bildsegmentierung

Dieses leistungsstarke Modell benötigt nur 340 MB Speicherplatz. Nach dem Laden wird es im Browser zwischengespeichert und kann direkt aufgerufen werden, wenn der Benutzer die Seite erneut besucht, ohne es erneut herunterzuladen. Das Erstaunlichste ist, dass der gesamte Vorgang vollständig lokal im Browser des Benutzers abläuft, ohne dass API-Aufrufe an den Server gesendet werden. Dies bedeutet, dass Benutzer nach dem Laden des Modells auch dann alle Funktionen nutzen können, wenn sie die Verbindung zum Internet trennen.

Der lokalisierte Betrieb von Florence-2 profitiert von der Unterstützung von Transformers.js und der ONNX Runtime Web-Technologie. Dieser Durchbruch verbessert nicht nur den Schutz der Privatsphäre der Benutzer, sondern senkt auch die Nutzungskosten erheblich und ebnet so den Weg für die Popularisierung und Anwendung der KI-Vision-Technologie.

Für Entwickler und Technologiebegeisterte ist das ONNX-Modell von Florence-2 jetzt auf der Hugging Face-Plattform frei zugänglich. Interessierte Freunde können https://huggingface.co/models?library=transformers.js&other=florence2 für weitere Details besuchen. Darüber hinaus wurde der Quellcode des Projekts auch auf GitHub veröffentlicht, und Entwickler können ihn über https://github.com/xenova/transformers.js/tree/v3/examples/florence2-webgpu zur weiteren Erkundung erhalten Entwicklung.

Dieser Durchbruch von Florence-2 wird zweifellos die schnelle Entwicklung und weit verbreitete Popularisierung von KI-Vision-Anwendungen fördern. Wir können davon ausgehen, dass in naher Zukunft weitere browserbasierte Smart-Vision-Anwendungen unser tägliches Leben und unsere Arbeitsweise verändern werden.

Die lokale Betriebsfähigkeit von Florence-2 verbessert die Privatsphäre und den Komfort der Benutzer, senkt die Nutzungsschwelle und bietet unbegrenzte Möglichkeiten für die zukünftige Entwicklung von KI-Vision-Anwendungen. Seine Open-Source-Modelle und -Codes stellen Entwicklern außerdem umfangreiche Ressourcen zur Verfügung, und wir freuen uns auf die Entstehung weiterer innovativer Anwendungen.