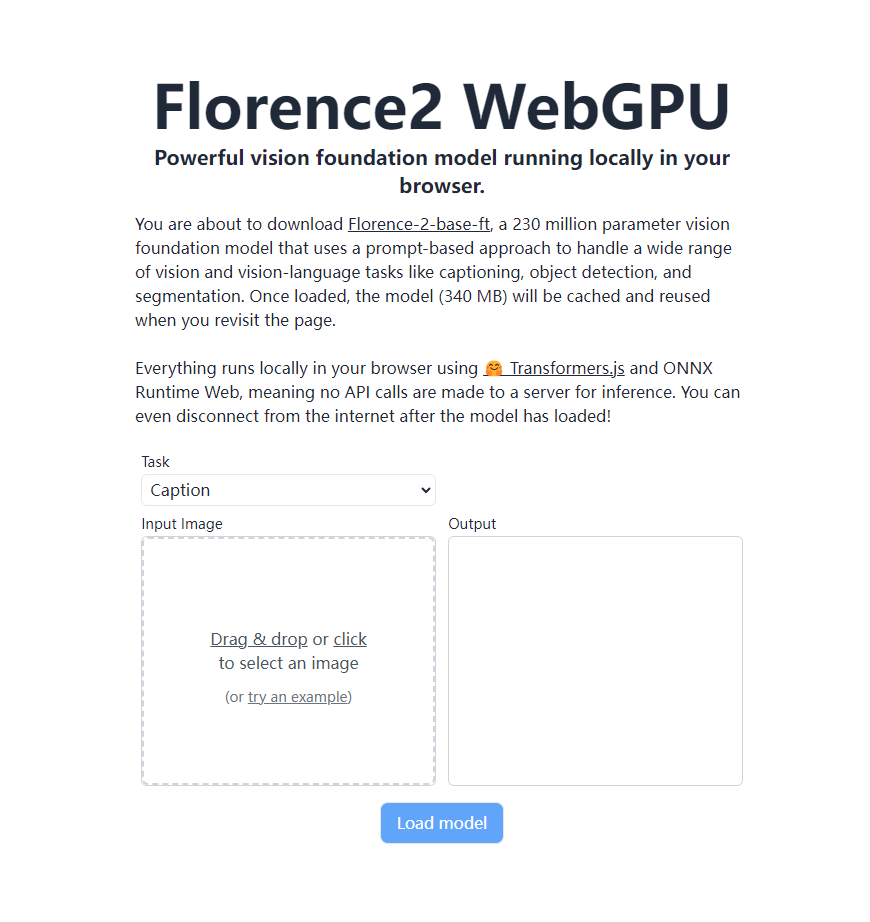

Microsoft의 최신 시각적 기본 모델인 Florence-2는 원격 서버에 의존하지 않고도 WebGPU를 지원하는 브라우저에서 완전히 로컬로 실행될 수 있다는 점에서 획기적인 발전을 이루었습니다. 이는 강력한 시각적 인식 기능을 사용자 브라우저에서 직접 구현하여 AI 비전 애플리케이션이 실행되는 방식을 완전히 바꾸는 Transformers.js 및 ONNX 런타임 웹 기술 덕분입니다. Florence-2-base-ft는 2억 3천만 개의 매개변수를 가지고 있으며 힌트 기반 접근 방식을 사용하여 이미지 설명 생성, OCR, 개체 감지 및 이미지 분할을 포함한 다양한 시각적 및 시각적 언어 작업을 처리하는 동시에 340MB의 저장 공간만 차지합니다. 오프라인 상태에서도 로드된 모델로 계속 작업할 수 있습니다.

최근 Microsoft에서 출시한 최신 시각적 기본 모델인 Florence-2는 Transformers.js 기술을 통해 이제 WebGPU를 지원하는 브라우저에서 기본적으로 모델을 100% 실행할 수 있게 되었습니다. 이 획기적인 변화는 AI 비전 애플리케이션에 혁신적인 변화를 가져와 원격 서버에 의존하지 않고도 강력한 시각적 인식 기능을 사용자 브라우저에서 직접 구현할 수 있게 해줍니다.

Florence-2-base-ft는 큐 기반 접근 방식을 사용하여 광범위한 비전 및 시각적 언어 작업을 처리하는 2억 3천만 개의 매개변수 비전 기본 모델입니다. 이 모델은 다음을 포함하되 이에 국한되지 않는 다양한 기능을 지원합니다.

이미지 설명 생성 광학 문자 인식(OCR) 개체 감지 이미지 분할

이 강력한 모델은 340MB의 저장 공간만 차지하며, 일단 로드되면 브라우저에 캐시되며 사용자가 다시 다운로드하지 않고도 페이지를 다시 방문할 때 직접 호출할 수 있습니다. 가장 놀라운 점은 서버에 API 호출을 보내지 않고 전체 프로세스가 사용자 브라우저에서 완전히 로컬로 발생한다는 것입니다. 이는 모델이 로드된 후에도 사용자가 인터넷 연결이 끊긴 경우에도 모든 기능을 계속 사용할 수 있음을 의미합니다.

Florence-2의 현지화된 운영은 Transformers.js 및 ONNX 런타임 웹 기술의 지원을 통해 이점을 얻습니다. 이러한 획기적인 발전은 사용자 개인 정보 보호 수준을 향상시킬 뿐만 아니라 사용 비용을 크게 줄여 AI 비전 기술의 대중화 및 적용을 위한 기반을 마련했습니다.

개발자와 기술 애호가를 위해 Florence-2의 ONNX 모델은 이제 Hugging Face 플랫폼에서 공개적으로 액세스할 수 있습니다. 관심 있는 친구들은 https://huggingface.co/models?library=transformers.js&other=florence2를 방문하여 자세한 내용을 확인할 수 있습니다. 또한 프로젝트의 소스 코드도 GitHub에 공개되었으며 개발자는 https://github.com/xenova/transformers.js/tree/v3/examples/florence2-webgpu를 통해 이를 얻을 수 있습니다. 개발.

Florence-2의 이러한 획기적인 발전은 의심할 여지 없이 AI 비전 애플리케이션의 빠른 개발과 광범위한 대중화를 촉진할 것입니다. 가까운 미래에는 더 많은 브라우저 기반 스마트 비전 애플리케이션이 우리의 일상 생활과 일하는 방식을 변화시킬 것으로 예상됩니다.

Florence-2의 로컬 작동 기능은 사용자 개인 정보 보호와 편의성을 향상시키고 사용 임계값을 낮추며 AI 비전 애플리케이션의 향후 개발에 무한한 가능성을 제공합니다. 오픈 소스 모델과 코드도 개발자에게 풍부한 리소스를 제공하며, 더욱 혁신적인 애플리케이션의 출현을 기대합니다.