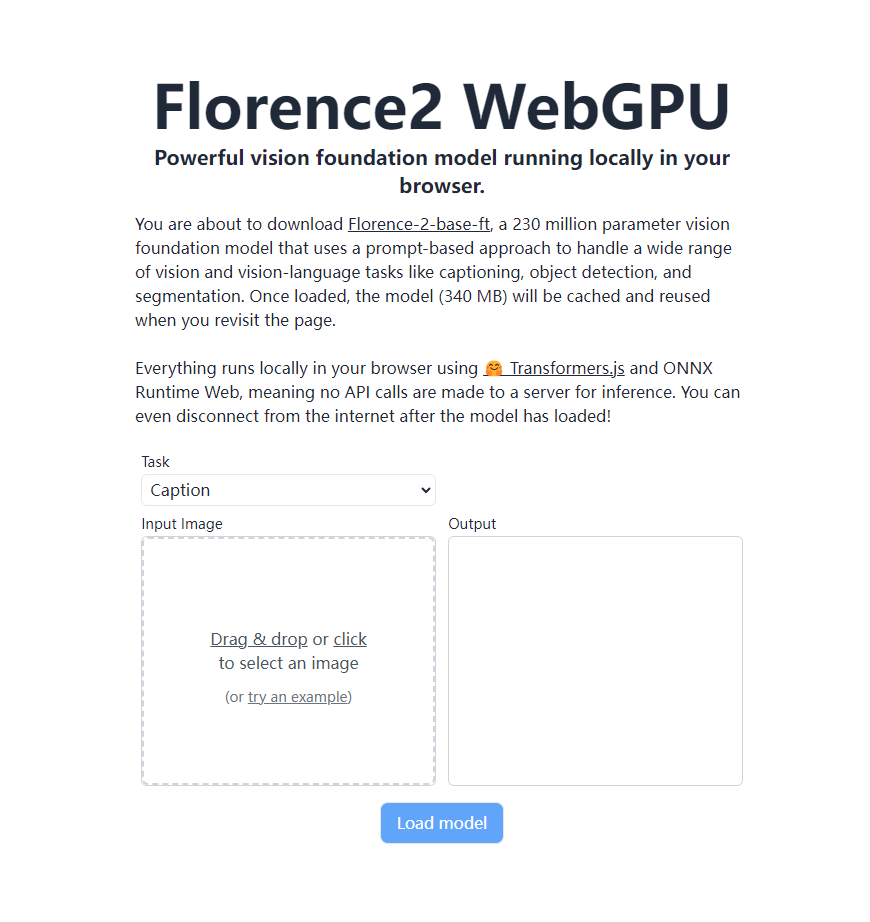

El último modelo visual básico de Microsoft, Florence-2, ha logrado un gran avance. Puede ejecutarse completamente localmente en navegadores que admiten WebGPU sin depender de servidores remotos. Esto es gracias a Transformers.js y la tecnología ONNX Runtime Web, que permite implementar potentes funciones de reconocimiento visual directamente en el navegador del usuario, cambiando por completo la forma en que se ejecutan las aplicaciones de visión de IA. Florence-2-base-ft tiene 230 millones de parámetros y utiliza un enfoque basado en sugerencias para manejar una variedad de tareas de lenguaje visual y visual, incluida la generación de descripciones de imágenes, OCR, detección de objetos y segmentación de imágenes, mientras ocupa solo 340 MB de espacio de almacenamiento. Continúe trabajando con modelos cargados incluso sin conexión.

Recientemente, Florence-2, el último modelo visual básico lanzado por Microsoft, ha logrado un gran avance. Con la tecnología Transformers.js, el modelo ahora puede ejecutarse de forma 100% nativa en navegadores compatibles con WebGPU. Este avance trae cambios revolucionarios a las aplicaciones de visión de IA, permitiendo implementar potentes funciones de reconocimiento visual directamente en el navegador del usuario sin depender de un servidor remoto.

Florence-2-base-ft es un modelo base de visión de 230 millones de parámetros que utiliza un enfoque basado en señales para manejar una amplia gama de tareas de visión y lenguaje visual. El modelo admite una variedad de funciones, que incluyen, entre otras:

Generación de descripción de imágenes Reconocimiento óptico de caracteres (OCR) Detección de objetos Segmentación de imágenes

Este potente modelo solo ocupa 340 MB de espacio de almacenamiento. Una vez cargado, se almacenará en caché en el navegador y se podrá llamar directamente cuando el usuario vuelva a visitar la página sin volver a descargarlo. Lo más sorprendente es que todo el proceso ocurre completamente localmente en el navegador del usuario sin enviar ninguna llamada API al servidor. Esto significa que después de cargar el modelo, los usuarios aún pueden usar todas las funciones incluso si se desconectan de Internet.

La operación localizada de Florence-2 se beneficia del soporte de Transformers.js y la tecnología ONNX Runtime Web. Este avance no solo mejora el nivel de protección de la privacidad del usuario, sino que también reduce en gran medida el costo de uso, allanando el camino para la popularización y aplicación de la tecnología de visión de IA.

Para desarrolladores y entusiastas de la tecnología, el modelo ONNX de Florence-2 ahora es de acceso abierto en la plataforma Hugging Face. Los amigos interesados pueden visitar https://huggingface.co/models?library=transformers.js&other=florence2 para obtener más detalles. Además, el código fuente del proyecto también se ha hecho público en GitHub, y los desarrolladores pueden obtenerlo a través de https://github.com/xenova/transformers.js/tree/v3/examples/florence2-webgpu para una mayor exploración y desarrollo.

Este avance de Florence-2 sin duda promoverá el rápido desarrollo y la popularización generalizada de las aplicaciones de visión de IA. Podemos esperar que más aplicaciones de visión inteligente basadas en navegador cambien nuestra vida diaria y la forma en que trabajamos en el futuro cercano.

La capacidad de operación local de Florence-2 mejora la privacidad y la conveniencia del usuario, reduce el umbral de uso y brinda posibilidades ilimitadas para el desarrollo futuro de aplicaciones de visión de IA. Sus modelos y códigos de código abierto también brindan a los desarrolladores abundantes recursos y esperamos que surjan aplicaciones más innovadoras.