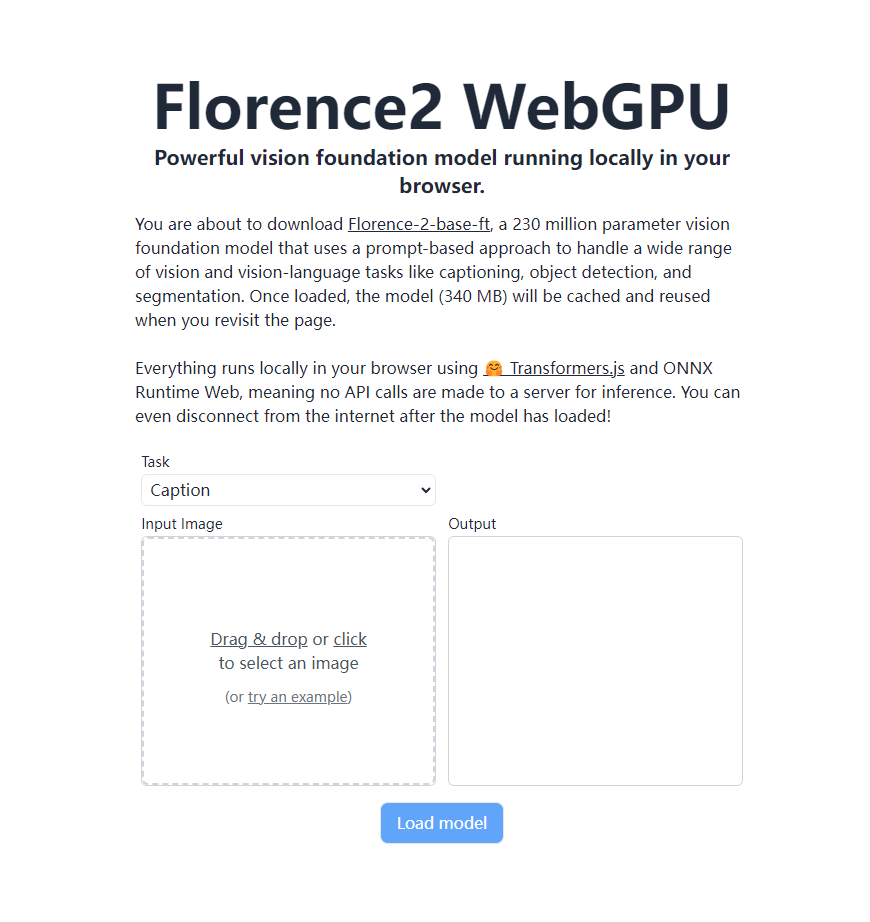

Microsoft の最新のビジュアル ベーシック モデル Florence-2 は、リモート サーバーに依存せず、WebGPU をサポートするブラウザで完全にローカルで実行できるという大きな進歩を遂げました。これは、Transformers.js と ONNX Runtime Web テクノロジーのおかげで、強力な視覚認識機能をユーザーのブラウザーに直接実装できるようになり、AI ビジョン アプリケーションの実行方法が完全に変わります。 Florence-2-base-ft には 2 億 3,000 万のパラメータがあり、ヒントベースのアプローチを使用して、画像記述の生成、OCR、オブジェクト検出、画像のセグメンテーションなどのさまざまな視覚的および視覚的言語タスクを処理しながら、占有容量はわずか 340 MB です。 オフラインでもロードされたモデルで作業を続けます。

最近、Microsoft が発表した最新のビジュアル ベーシック モデルである Florence-2 は、Transformers.js テクノロジによって大きな進歩を遂げ、WebGPU をサポートするブラウザで 100% ネイティブに実行できるようになりました。このブレークスルーは AI ビジョン アプリケーションに革命的な変化をもたらし、強力な視覚認識機能をリモート サーバーに依存せずにユーザーのブラウザに直接実装できるようになります。

Florence-2-base-ft は、2 億 3,000 万パラメータの視覚ベース モデルであり、キューベースのアプローチを使用して、広範囲の視覚および視覚言語タスクを処理します。このモデルは、次のようなさまざまな機能をサポートしていますが、これらに限定されません。

画像説明の生成 光学式文字認識 (OCR) オブジェクト検出 画像セグメンテーション

この強力なモデルは 340 MB のストレージ容量しか必要とせず、ロードされるとブラウザにキャッシュされ、ユーザーが再度ページにアクセスしたときに再ダウンロードすることなく直接呼び出すことができます。最も驚くべきことは、サーバーに API 呼び出しを送信することなく、プロセス全体がユーザーのブラウザ内で完全にローカルに実行されることです。これは、モデルがロードされた後、ユーザーがインターネットから切断した場合でも、すべての機能を引き続き使用できることを意味します。

Florence-2 のローカライズされた操作は、Transformers.js および ONNX ランタイム Web テクノロジーのサポートの恩恵を受けます。この画期的な進歩により、ユーザーのプライバシー保護レベルが向上するだけでなく、使用コストも大幅に削減され、AI ビジョン技術の普及と応用への道が開かれます。

開発者やテクノロジー愛好家向けに、Florence-2 の ONNX モデルが Hugging Face プラットフォームでオープンアクセスになりました。興味のある方は https://huggingface.co/models?library=transformers.js&other=florence2 にアクセスして詳細をご覧ください。さらに、プロジェクトのソース コードも GitHub で公開されており、開発者は https://github.com/xenova/transformers.js/tree/v3/examples/florence2-webgpu を通じて入手して、さらに調査したり、発達。

Florence-2 のこの画期的な進歩により、間違いなく AI ビジョン アプリケーションの急速な開発と広範な普及が促進されるでしょう。近い将来、より多くのブラウザベースのスマート ビジョン アプリケーションが私たちの日常生活や働き方を変えることが予想されます。

Florence-2 のローカル操作機能は、ユーザーのプライバシーと利便性を向上させ、使用の敷居を下げ、将来の AI ビジョン アプリケーションの開発に無限の可能性をもたらします。 そのオープンソース モデルとコードは開発者に豊富なリソースも提供しており、より革新的なアプリケーションの出現が期待されています。