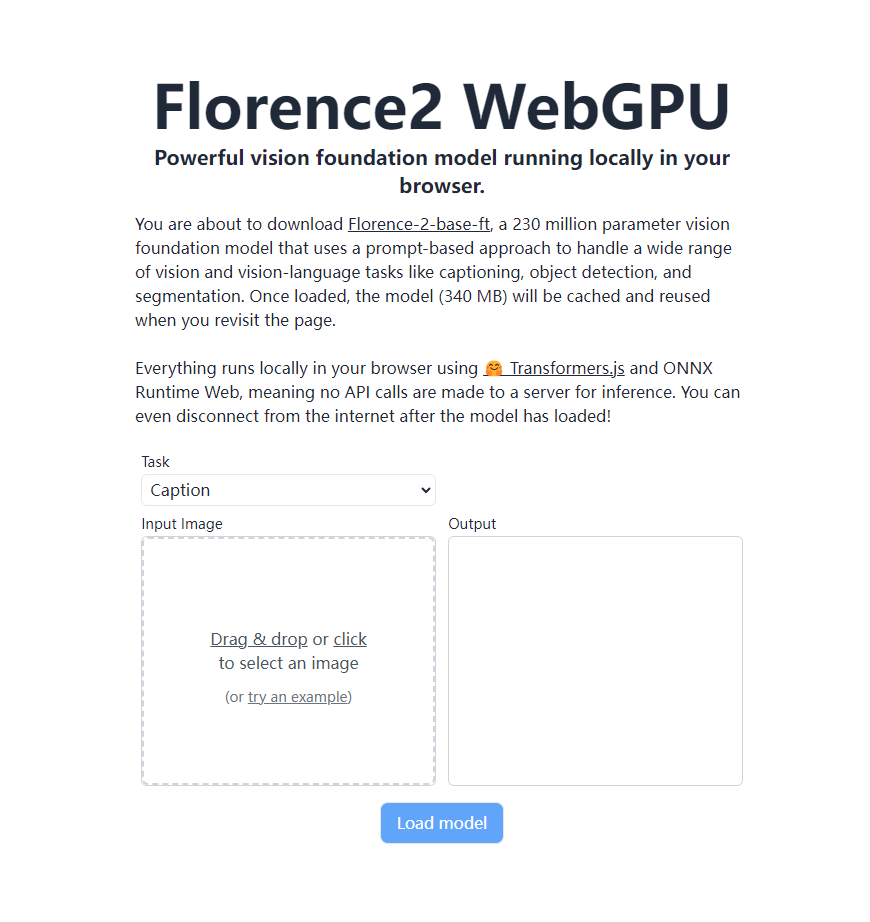

Le dernier modèle Visual Basic de Microsoft, Florence-2, a réalisé une avancée majeure. Il peut s'exécuter entièrement localement dans un navigateur prenant en charge WebGPU sans recourir à un serveur distant. Cela est dû à Transformers.js et à la technologie ONNX Runtime Web, qui permet d'implémenter de puissantes fonctions de reconnaissance visuelle directement dans le navigateur de l'utilisateur, changeant complètement la façon dont les applications de vision IA s'exécutent. Florence-2-base-ft possède 230 millions de paramètres et utilise une approche basée sur des indices pour gérer une variété de tâches visuelles et de langage visuel, notamment la génération de descriptions d'images, l'OCR, la détection d'objets et la segmentation d'images, tout en occupant seulement 340 Mo d'espace de stockage. Continuez à travailler avec les modèles chargés même hors ligne.

Récemment, le dernier modèle Visual Basic Florence-2 lancé par Microsoft a réalisé une avancée majeure. Grâce à la technologie Transformers.js, le modèle peut désormais fonctionner à 100 % de manière native dans les navigateurs prenant en charge WebGPU. Cette percée a apporté des changements révolutionnaires aux applications de vision IA, permettant d'implémenter de puissantes fonctions de reconnaissance visuelle directement dans le navigateur de l'utilisateur sans recourir à des serveurs distants.

Florence-2-base-ft est un modèle de base de vision de 230 millions de paramètres qui utilise une approche basée sur des signaux pour gérer un large éventail de tâches de vision et de langage visuel. Le modèle prend en charge une variété de fonctionnalités, notamment :

Description de l'image Génération Reconnaissance optique de caractères (OCR) Détection d'objets Segmentation d'image

Ce modèle puissant n'occupe que 340 Mo d'espace de stockage. Une fois chargé, il sera mis en cache dans le navigateur et pourra être appelé directement lorsque l'utilisateur visitera à nouveau la page sans retélécharger. La chose la plus étonnante est que l'ensemble du processus se déroule entièrement localement dans le navigateur de l'utilisateur sans envoyer d'appels API au serveur. Cela signifie qu'une fois le modèle chargé, les utilisateurs peuvent toujours utiliser toutes les fonctions même s'ils se déconnectent d'Internet.

Le fonctionnement localisé de Florence-2 bénéficie du support de Transformers.js et de la technologie ONNX Runtime Web. Cette avancée améliore non seulement le niveau de protection de la vie privée des utilisateurs, mais réduit également considérablement le coût d'utilisation, ouvrant la voie à la vulgarisation et à l'application de la technologie de vision IA.

Pour les développeurs et les passionnés de technologie, le modèle ONNX de Florence-2 est désormais en libre accès sur la plateforme Hugging Face. Les amis intéressés peuvent visiter https://huggingface.co/models?library=transformers.js&other=florence2 pour plus de détails. De plus, le code source du projet a également été rendu public sur GitHub, et les développeurs peuvent l'obtenir via https://github.com/xenova/transformers.js/tree/v3/examples/florence2-webgpu pour une exploration plus approfondie et développement.

Cette percée de Florence-2 favorisera sans aucun doute le développement rapide et la vulgarisation généralisée des applications de vision de l’IA. Nous pouvons nous attendre à ce que davantage d’applications de vision intelligente basées sur navigateur changent notre vie quotidienne et notre façon de travailler dans un avenir proche.

La capacité d’exploitation locale de Florence-2 améliore la confidentialité et la commodité des utilisateurs, abaisse le seuil d’utilisation et offre des possibilités illimitées pour le développement futur d’applications de vision IA. Ses modèles et codes open source fournissent également aux développeurs de riches ressources, et nous attendons avec impatience l’émergence d’applications plus innovantes.