大型語言模型(LLM)的訓練需要大量高品質數據,而取得這些數據卻是一個巨大的挑戰。傳統的網路爬蟲工具效率低且難以處理非結構化數據,限制了LLM的訓練和發展。 Downcodes小編將為大家介紹一個強大的開源工具——Crawl4AI,它可以有效地收集和清洗網絡數據,並將其格式化為LLM友好的格式,如JSON、HTML和Markdown。

在驅動的人工智慧時代,大型語言模型(LLM)如GPT-3和BERT 對高品質數據的需求日益增加。然而,從網路上手動整理這些數據不僅費時費力,而且常常難以擴展。

這給開發者帶來了不小的挑戰,尤其是在需要大量數據的時候。傳統的網路爬蟲和資料抓取工具在提取結構化資料方面的能力有限,雖然它們可以收集網頁數據,但往往無法將數據格式化為適合LLM 處理的樣式。

為了回應這個難題,Crawl4AI 作為一個開源工具應運而生。它不僅能夠從網站上收集數據,還能將其處理和清洗成適合LLM 使用的格式,如JSON、乾淨的HTML 和Markdown。 Crawl4AI 的創新之處在於其高效和可擴展性,能夠同時處理多個URL,非常適合大規模資料收集。

這個工具還具備用戶代理自訂、JavaScript 執行和代理支援等功能,可以有效繞過網路限制,從而增強了其適用性。這樣的客製化功能使得Crawl4AI 能夠適應各種資料類型和網頁結構,讓使用者能夠以結構化的方式收集文字、圖片、元資料等內容,大大促進了LLM 的訓練。

Crawl4AI 的工作流程也相當明確。首先,使用者可以輸入一系列種子URL 或定義特定的爬取標準。接著,工具會抓取網頁,遵循網站政策,例如robots.txt。資料抓取後,Crawl4AI 會運用XPath 和正規表示式等進階資料擷取技術,擷取相關的文字、圖片和元資料。此外,它還支援JavaScript 執行,能夠抓取動態載入的內容,彌補傳統爬蟲的不足。

值得一提的是,Crawl4AI 支援並行處理,能讓多個網頁同時被抓取和處理,減少了大規模資料收集所需的時間。同時,它也具備錯誤處理機制和重試策略,確保即使在頁面載入失敗或網路出現問題時,資料的完整性依然得到保障。使用者可以根據特定需求,自訂爬取深度、頻率和提取規則,進一步提升了工具的靈活性。

Crawl4AI 為自動化收集適合LLM 訓練的網頁資料提供了高效且可自訂的解決方案。它解決了傳統網路爬蟲的局限性,並提供了LLM 最佳化的輸出格式,使得資料收集變得簡單且高效,適用於多種LLM 驅動的應用場景。對於那些希望簡化機器學習和人工智慧專案資料獲取流程的研究人員和開發者來說,Crawl4AI 無疑是一個極具價值的工具。

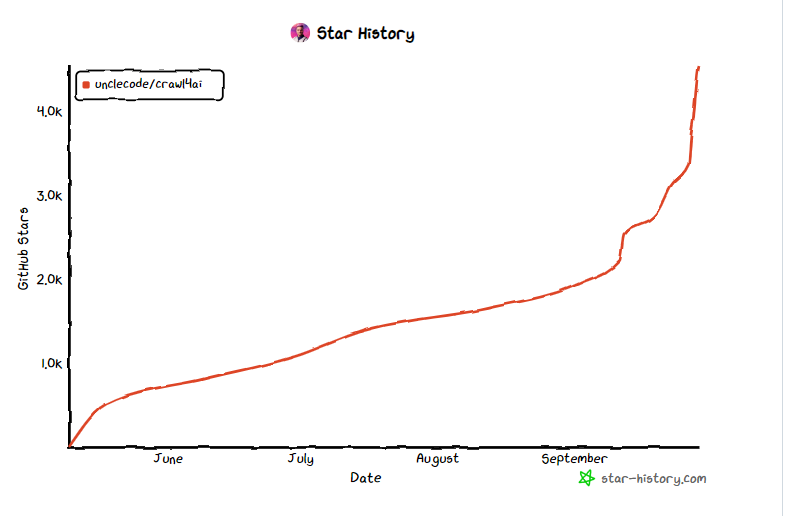

專案入口:https://github.com/unclecode/crawl4ai

劃重點:

- Crawl4AI 是一個開源工具,旨在簡化和優化LLM 訓練所需的資料收集過程。

- ? 此工具支援平行處理和動態內容抓取,增強了資料收集的效率和靈活性。

- ? Crawl4AI 輸出的資料格式如JSON 和Markdown,以便於後續處理和應用。

總而言之,Crawl4AI 作為一款高效、靈活且易於使用的開源工具,為LLM訓練的資料獲取提供了強有力的支持,值得廣大開發者和研究人員嘗試和使用。它簡化了資料收集流程,提高了效率,為人工智慧領域的進步貢獻力量。