La formation de grands modèles de langage (LLM) nécessite de grandes quantités de données de haute qualité, et l'obtention de ces données constitue un défi de taille. Les outils de robots d'exploration Web traditionnels sont inefficaces et difficiles à traiter les données non structurées, ce qui limite la formation et le développement de LLM. L'éditeur de Downcodes vous présentera un puissant outil open source - Crawl4AI, qui peut collecter et nettoyer efficacement les données réseau et les formater dans des formats compatibles LLM, tels que JSON, HTML et Markdown.

À l'ère de l'intelligence artificielle pilotée, les grands modèles de langage (LLM) tels que GPT-3 et BERT ont une demande croissante de données de haute qualité. Cependant, la conservation manuelle de ces données à partir du Web prend du temps et est souvent difficile à mettre à l'échelle.

Cela représente un véritable défi pour les développeurs, en particulier lorsque de grandes quantités de données sont nécessaires. Les robots d'exploration Web et les outils de récupération de données traditionnels ont des capacités limitées pour extraire des données structurées. Bien qu'ils puissent collecter des données de pages Web, ils ne peuvent souvent pas formater les données dans un style adapté au traitement LLM.

Pour résoudre ce problème, Crawl4AI est apparu comme un outil open source. Il collecte non seulement les données des sites Web, mais les traite et les nettoie également dans des formats adaptés à une utilisation LLM, tels que JSON, Clean HTML et Markdown. L'innovation de Crawl4AI réside dans son efficacité et son évolutivité, ainsi que dans sa capacité à traiter plusieurs URL simultanément, ce qui le rend idéal pour la collecte de données à grande échelle.

Cet outil propose également la personnalisation de l'agent utilisateur, l'exécution de JavaScript et la prise en charge de proxy pour contourner efficacement les restrictions réseau, améliorant ainsi son adéquation. De telles fonctions personnalisées permettent à Crawl4AI de s'adapter à différents types de données et structures de pages Web, permettant aux utilisateurs de collecter du texte, des images, des métadonnées et d'autres contenus de manière structurée, ce qui facilite grandement la formation LLM.

Le flux de travail de Crawl4AI est également assez clair. Tout d’abord, les utilisateurs peuvent saisir une série d’URL de départ ou définir des critères d’exploration spécifiques. L'outil explore ensuite la page Web et suit les politiques du site, telles que robots.txt. Une fois les données capturées, Crawl4AI utilisera des technologies avancées d'extraction de données telles que XPath et des expressions régulières pour extraire le texte, les images et les métadonnées pertinentes. En outre, il prend également en charge l'exécution de JavaScript et peut explorer le contenu chargé dynamiquement pour compenser les lacunes des robots d'exploration traditionnels.

Il convient de mentionner que Crawl4AI prend en charge le traitement parallèle, permettant d'explorer et de traiter plusieurs pages Web en même temps, réduisant ainsi le temps nécessaire à la collecte de données à grande échelle. Dans le même temps, il dispose également d'un mécanisme de gestion des erreurs et d'une stratégie de nouvelle tentative pour garantir que l'intégrité des données est toujours garantie même en cas d'échec de chargement de la page ou en cas de problème de réseau. Les utilisateurs peuvent personnaliser la profondeur d'exploration, la fréquence et les règles d'extraction en fonction de besoins spécifiques, améliorant ainsi la flexibilité de l'outil.

Crawl4AI fournit une solution efficace et personnalisable pour collecter automatiquement les données de pages Web adaptées à la formation LLM. Il résout les limites des robots d'exploration Web traditionnels et fournit un format de sortie optimisé pour LLM, rendant la collecte de données simple et efficace, et convient à une variété de scénarios d'application pilotés par LLM. Crawl4AI est un outil précieux pour les chercheurs et les développeurs cherchant à rationaliser le processus d'acquisition de données pour les projets d'apprentissage automatique et d'intelligence artificielle.

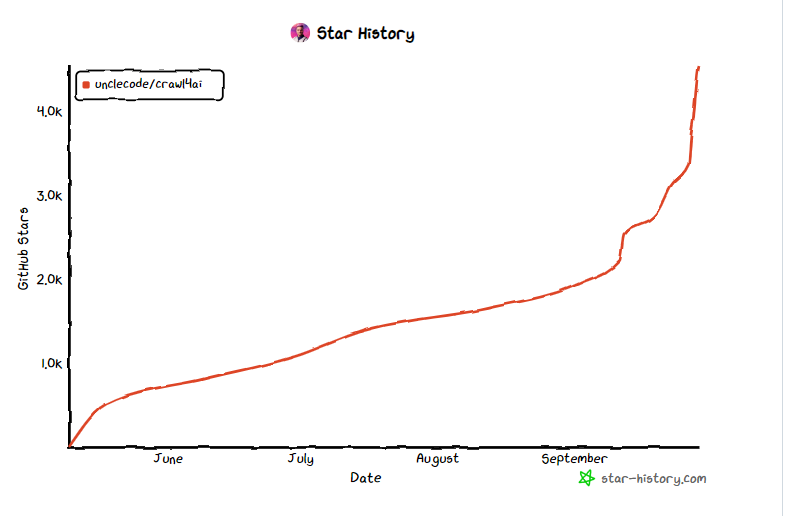

Entrée du projet : https://github.com/unclecode/crawl4ai

Souligner:

- Crawl4AI est un outil open source conçu pour simplifier et optimiser le processus de collecte de données requis pour la formation LLM.

- ? L'outil prend en charge le traitement parallèle et la capture de contenu dynamique, améliorant ainsi l'efficacité et la flexibilité de la collecte de données.

- ? Crawl4AI génère des formats de données tels que JSON et Markdown, ce qui facilite le traitement et l'application ultérieurs.

En bref, Crawl4AI, en tant qu'outil open source efficace, flexible et facile à utiliser, fournit un support solide pour l'acquisition de données pour la formation LLM et mérite d'être essayé et utilisé par les développeurs et les chercheurs. Il simplifie le processus de collecte de données, améliore l'efficacité et contribue aux progrès dans le domaine de l'intelligence artificielle.