Das Training großer Sprachmodelle (LLM) erfordert große Mengen hochwertiger Daten, und die Beschaffung dieser Daten ist eine große Herausforderung. Herkömmliche Webcrawler-Tools sind ineffizient und es ist schwierig, unstrukturierte Daten zu verarbeiten, was die Schulung und Entwicklung von LLM einschränkt. Der Herausgeber von Downcodes stellt Ihnen ein leistungsstarkes Open-Source-Tool vor – Crawl4AI, das Netzwerkdaten effizient sammeln und bereinigen und in LLM-freundliche Formate wie JSON, HTML und Markdown formatieren kann.

Im Zeitalter der angetriebenen künstlichen Intelligenz besteht bei großen Sprachmodellen (LLM) wie GPT-3 und BERT ein zunehmender Bedarf an qualitativ hochwertigen Daten. Das manuelle Kuratieren dieser Daten aus dem Internet ist jedoch zeitaufwändig und oft schwer zu skalieren.

Dies stellt Entwickler vor eine große Herausforderung, insbesondere wenn große Datenmengen benötigt werden. Herkömmliche Webcrawler und Data-Scraping-Tools verfügen nur über begrenzte Möglichkeiten zum Extrahieren strukturierter Daten. Obwohl sie Webseitendaten sammeln können, können sie die Daten oft nicht in einem für die LLM-Verarbeitung geeigneten Stil formatieren.

Um dieses Problem zu lösen, ist Crawl4AI als Open-Source-Tool entstanden. Es sammelt nicht nur Daten von Websites, sondern verarbeitet und bereinigt sie auch in für die LLM-Nutzung geeignete Formate wie JSON, Clean HTML und Markdown. Die Innovation von Crawl4AI liegt in seiner Effizienz und Skalierbarkeit sowie seiner Fähigkeit, mehrere URLs gleichzeitig zu verarbeiten, was es ideal für die Datenerfassung in großem Maßstab macht.

Dieses Tool bietet außerdem Benutzeragentenanpassung, JavaScript-Ausführung und Proxy-Unterstützung, um Netzwerkbeschränkungen effektiv zu umgehen und so seine Eignung zu verbessern. Durch solche benutzerdefinierten Funktionen kann sich Crawl4AI an verschiedene Datentypen und Webseitenstrukturen anpassen, sodass Benutzer Texte, Bilder, Metadaten und andere Inhalte strukturiert sammeln können, was das LLM-Training erheblich erleichtert.

Auch der Workflow von Crawl4AI ist recht klar. Zunächst können Benutzer eine Reihe von Seed-URLs eingeben oder bestimmte Crawling-Kriterien definieren. Das Tool crawlt dann die Webseite und befolgt die Richtlinien der Website, z. B. robots.txt. Nachdem die Daten erfasst wurden, nutzt Crawl4AI fortschrittliche Datenextraktionstechnologien wie XPath und reguläre Ausdrücke, um relevante Texte, Bilder und Metadaten zu extrahieren. Darüber hinaus unterstützt es auch die Ausführung von JavaScript und kann dynamisch geladene Inhalte crawlen, um die Mängel herkömmlicher Crawler auszugleichen.

Erwähnenswert ist, dass Crawl4AI die Parallelverarbeitung unterstützt, sodass mehrere Webseiten gleichzeitig gecrawlt und verarbeitet werden können, wodurch der Zeitaufwand für die Datenerfassung in großem Maßstab verkürzt wird. Gleichzeitig verfügt es über einen Fehlerbehandlungsmechanismus und eine Wiederholungsstrategie, um sicherzustellen, dass die Datenintegrität auch dann gewährleistet ist, wenn die Seite nicht geladen werden kann oder ein Netzwerkproblem vorliegt. Benutzer können die Crawling-Tiefe, die Häufigkeit und die Extraktionsregeln an ihre spezifischen Bedürfnisse anpassen und so die Flexibilität des Tools weiter verbessern.

Crawl4AI bietet eine effiziente und anpassbare Lösung zum automatischen Sammeln von Webseitendaten, die für das LLM-Training geeignet sind. Es löst die Einschränkungen herkömmlicher Webcrawler und bietet ein LLM-optimiertes Ausgabeformat, das die Datenerfassung einfach und effizient macht und für eine Vielzahl von LLM-gesteuerten Anwendungsszenarien geeignet ist. Crawl4AI ist ein wertvolles Tool für Forscher und Entwickler, die den Prozess der Datenerfassung für Projekte im Bereich maschinelles Lernen und künstliche Intelligenz optimieren möchten.

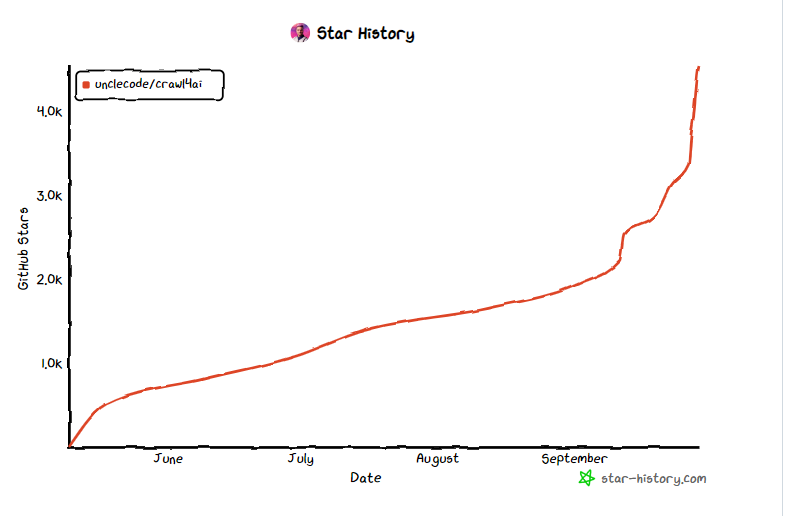

Projekteingang: https://github.com/unclecode/crawl4ai

Highlight:

- Crawl4AI ist ein Open-Source-Tool zur Vereinfachung und Optimierung des für die LLM-Schulung erforderlichen Datenerfassungsprozesses.

- ? Das Tool unterstützt die parallele Verarbeitung und dynamische Inhaltserfassung und erhöht so die Effizienz und Flexibilität der Datenerfassung.

- ? Crawl4AI gibt Datenformate wie JSON und Markdown aus, was die spätere Verarbeitung und Anwendung erleichtert.

Kurz gesagt: Crawl4AI bietet als effizientes, flexibles und benutzerfreundliches Open-Source-Tool starke Unterstützung für die Datenerfassung für die LLM-Ausbildung und ist für Entwickler und Forscher einen Versuch und die Nutzung wert. Es vereinfacht den Datenerfassungsprozess, verbessert die Effizienz und trägt zu Fortschritten im Bereich der künstlichen Intelligenz bei.