El entrenamiento de modelos de lenguaje grandes (LLM) requiere grandes cantidades de datos de alta calidad y obtener estos datos es un gran desafío. Las herramientas tradicionales de rastreo web son ineficientes y difíciles de procesar datos no estructurados, lo que limita la capacitación y el desarrollo de LLM. El editor de Downcodes le presentará una poderosa herramienta de código abierto: Crawl4AI, que puede recopilar y limpiar datos de red de manera eficiente y formatearlos en formatos compatibles con LLM, como JSON, HTML y Markdown.

En la era de la inteligencia artificial impulsada, los grandes modelos de lenguaje (LLM) como GPT-3 y BERT tienen una demanda cada vez mayor de datos de alta calidad. Sin embargo, seleccionar manualmente estos datos de la web lleva mucho tiempo y, a menudo, es difícil de escalar.

Esto plantea un gran desafío para los desarrolladores, especialmente cuando se requieren grandes cantidades de datos. Los rastreadores web y las herramientas de extracción de datos tradicionales tienen capacidades limitadas para extraer datos estructurados. Aunque pueden recopilar datos de páginas web, a menudo no pueden formatear los datos en un estilo adecuado para el procesamiento de LLM.

Para abordar este problema, Crawl4AI surgió como una herramienta de código abierto. No solo recopila datos de sitios web, sino que también los procesa y limpia en formatos adecuados para el uso de LLM, como JSON, HTML limpio y Markdown. La innovación de Crawl4AI radica en su eficiencia y escalabilidad, y en su capacidad para procesar múltiples URL simultáneamente, lo que lo hace ideal para la recopilación de datos a gran escala.

Esta herramienta también incluye personalización del agente de usuario, ejecución de JavaScript y soporte de proxy para evitar de manera efectiva las restricciones de la red, mejorando así su idoneidad. Estas funciones personalizadas permiten a Crawl4AI adaptarse a varios tipos de datos y estructuras de páginas web, lo que permite a los usuarios recopilar texto, imágenes, metadatos y otros contenidos de forma estructurada, lo que facilita enormemente la formación de LLM.

El flujo de trabajo de Crawl4AI también es bastante claro. Primero, los usuarios pueden ingresar una serie de URL iniciales o definir criterios de rastreo específicos. Luego, la herramienta rastrea la página web y sigue las políticas del sitio, como robots.txt. Una vez capturados los datos, Crawl4AI utilizará tecnologías avanzadas de extracción de datos, como XPath y expresiones regulares, para extraer texto, imágenes y metadatos relevantes. Además, también admite la ejecución de JavaScript y puede rastrear contenido cargado dinámicamente para compensar las deficiencias de los rastreadores tradicionales.

Vale la pena mencionar que Crawl4AI admite el procesamiento paralelo, lo que permite rastrear y procesar varias páginas web al mismo tiempo, lo que reduce el tiempo necesario para la recopilación de datos a gran escala. Al mismo tiempo, también tiene un mecanismo de manejo de errores y una estrategia de reintento para garantizar que la integridad de los datos aún esté garantizada incluso cuando la página no se carga o hay un problema de red. Los usuarios pueden personalizar la profundidad de rastreo, la frecuencia y las reglas de extracción según necesidades específicas, mejorando aún más la flexibilidad de la herramienta.

Crawl4AI proporciona una solución eficiente y personalizable para recopilar automáticamente datos de páginas web adecuados para la formación LLM. Resuelve las limitaciones de los rastreadores web tradicionales y proporciona un formato de salida optimizado para LLM, lo que hace que la recopilación de datos sea simple y eficiente, y es adecuado para una variedad de escenarios de aplicaciones basadas en LLM. Crawl4AI es una herramienta valiosa para investigadores y desarrolladores que buscan agilizar el proceso de adquisición de datos para proyectos de aprendizaje automático e inteligencia artificial.

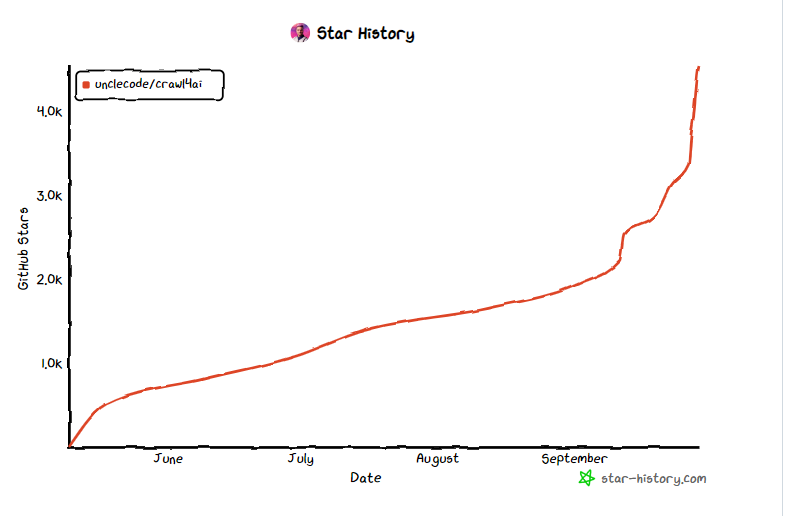

Entrada del proyecto: https://github.com/unclecode/crawl4ai

Destacar:

- Crawl4AI es una herramienta de código abierto diseñada para simplificar y optimizar el proceso de recopilación de datos necesario para la formación LLM.

- ? La herramienta admite el procesamiento paralelo y la captura de contenido dinámico, mejorando la eficiencia y flexibilidad de la recopilación de datos.

- ? Crawl4AI genera formatos de datos como JSON y Markdown, lo que facilita el procesamiento y la aplicación posteriores.

En resumen, Crawl4AI, como herramienta de código abierto eficiente, flexible y fácil de usar, brinda un fuerte soporte para la adquisición de datos para la capacitación LLM y vale la pena probarla y utilizarla por parte de desarrolladores e investigadores. Simplifica el proceso de recopilación de datos, mejora la eficiencia y contribuye a los avances en el campo de la inteligencia artificial.