يتطلب تدريب نماذج اللغات الكبيرة (LLM) كميات كبيرة من البيانات عالية الجودة، ويشكل الحصول على هذه البيانات تحديًا كبيرًا. أدوات زاحف الويب التقليدية غير فعالة ويصعب معالجة البيانات غير المنظمة، مما يحد من تدريب وتطوير LLM. سيقدم لك محرر Downcodes أداة قوية مفتوحة المصدر - Crawl4AI، والتي يمكنها جمع بيانات الشبكة وتنظيفها بكفاءة وتنسيقها في تنسيقات متوافقة مع LLM، مثل JSON وHTML وMarkdown.

في عصر الذكاء الاصطناعي المدفوع، تشهد نماذج اللغات الكبيرة (LLM) مثل GPT-3 وBERT طلبًا متزايدًا على البيانات عالية الجودة. ومع ذلك، فإن تنظيم هذه البيانات يدويًا من الويب يستغرق وقتًا طويلاً وغالبًا ما يصعب توسيع نطاقه.

وهذا يشكل تحديًا كبيرًا للمطورين، خاصة عندما تكون هناك حاجة إلى كميات كبيرة من البيانات. تتمتع برامج زحف الويب التقليدية وأدوات جمع البيانات بقدرات محدودة في استخراج البيانات المنظمة. على الرغم من قدرتها على جمع بيانات صفحة الويب، إلا أنها غالبًا لا تستطيع تنسيق البيانات بأسلوب مناسب لمعالجة LLM.

للتعامل مع هذه المشكلة، ظهرت Crawl4AI كأداة مفتوحة المصدر. فهو لا يجمع البيانات من مواقع الويب فحسب، بل يقوم أيضًا بمعالجتها وتنظيفها بتنسيقات مناسبة لاستخدام LLM، مثل JSON وHTML النظيف وMarkdown. يكمن ابتكار Crawl4AI في كفاءته وقابليته للتوسع، وقدرته على معالجة عناوين URL متعددة في وقت واحد، مما يجعله مثاليًا لجمع البيانات على نطاق واسع.

تتميز هذه الأداة أيضًا بتخصيص وكيل المستخدم وتنفيذ JavaScript ودعم الوكيل لتجاوز قيود الشبكة بشكل فعال، وبالتالي تعزيز ملاءمتها. تتيح هذه الوظائف المخصصة لـ Crawl4AI التكيف مع أنواع البيانات المختلفة وهياكل صفحات الويب، مما يسمح للمستخدمين بجمع النصوص والصور والبيانات الوصفية والمحتويات الأخرى بطريقة منظمة، مما يسهل تدريب LLM إلى حد كبير.

كما أن سير عمل Crawl4AI واضح إلى حد ما. أولاً، يمكن للمستخدمين إدخال سلسلة من عناوين URL الأولية أو تحديد معايير زحف محددة. تقوم الأداة بعد ذلك بالزحف إلى صفحة الويب وتتبع سياسات الموقع، مثل ملف robots.txt. بعد التقاط البيانات، سيستخدم Crawl4AI تقنيات متقدمة لاستخراج البيانات مثل XPath والتعبيرات العادية لاستخراج النصوص والصور والبيانات الوصفية ذات الصلة. بالإضافة إلى ذلك، فهو يدعم أيضًا تنفيذ JavaScript ويمكنه الزحف إلى المحتوى الذي تم تحميله ديناميكيًا لتعويض أوجه القصور في برامج الزحف التقليدية.

ومن الجدير بالذكر أن Crawl4AI يدعم المعالجة المتوازية، مما يسمح بالزحف إلى صفحات ويب متعددة ومعالجتها في نفس الوقت، مما يقلل الوقت اللازم لجمع البيانات على نطاق واسع. وفي الوقت نفسه، يحتوي أيضًا على آلية معالجة الأخطاء واستراتيجية إعادة المحاولة لضمان ضمان سلامة البيانات حتى في حالة فشل تحميل الصفحة أو وجود مشكلة في الشبكة. يمكن للمستخدمين تخصيص قواعد عمق الزحف والتكرار والاستخراج وفقًا للاحتياجات المحددة، مما يزيد من مرونة الأداة.

يوفر Crawl4AI حلاً فعالاً وقابلاً للتخصيص لجمع بيانات صفحة الويب المناسبة لتدريب LLM تلقائيًا. إنه يحل القيود المفروضة على برامج زحف الويب التقليدية ويوفر تنسيق مخرجات محسّنًا لـ LLM، مما يجعل جمع البيانات بسيطًا وفعالاً، وهو مناسب لمجموعة متنوعة من سيناريوهات التطبيقات التي تعتمد على LLM. تعد Crawl4AI أداة قيمة للباحثين والمطورين الذين يتطلعون إلى تبسيط عملية الحصول على البيانات لمشاريع التعلم الآلي والذكاء الاصطناعي.

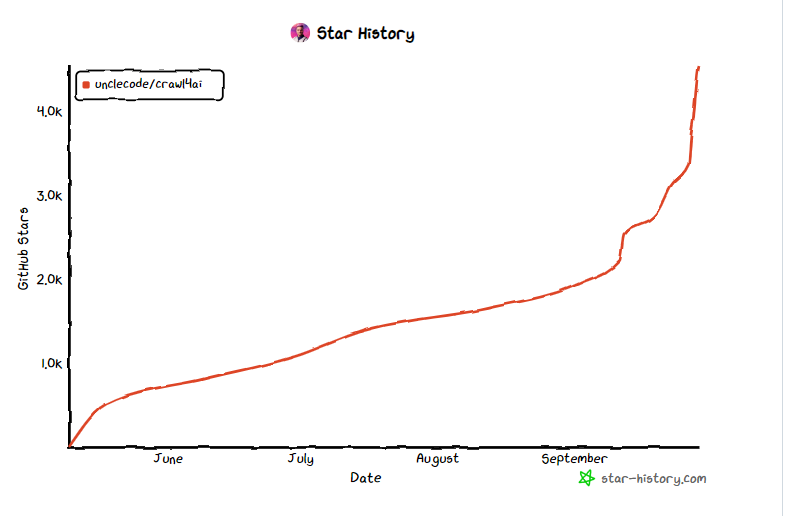

مدخل المشروع: https://github.com/unclecode/crawl4ai

تسليط الضوء على:

- Crawl4AI هي أداة مفتوحة المصدر مصممة لتبسيط وتحسين عملية جمع البيانات المطلوبة لتدريب LLM.

- تدعم الأداة المعالجة المتوازية والتقاط المحتوى الديناميكي، مما يعزز كفاءة ومرونة جمع البيانات.

- يقوم Crawl4AI بإخراج تنسيقات البيانات مثل JSON وMarkdown، مما يسهل المعالجة والتطبيق اللاحقين.

باختصار، Crawl4AI، باعتبارها أداة مفتوحة المصدر فعالة ومرنة وسهلة الاستخدام، توفر دعمًا قويًا للحصول على البيانات للتدريب على LLM وتستحق المحاولة والاستخدام من قبل المطورين والباحثين. إنه يبسط عملية جمع البيانات ويحسن الكفاءة ويساهم في التقدم في مجال الذكاء الاصطناعي.