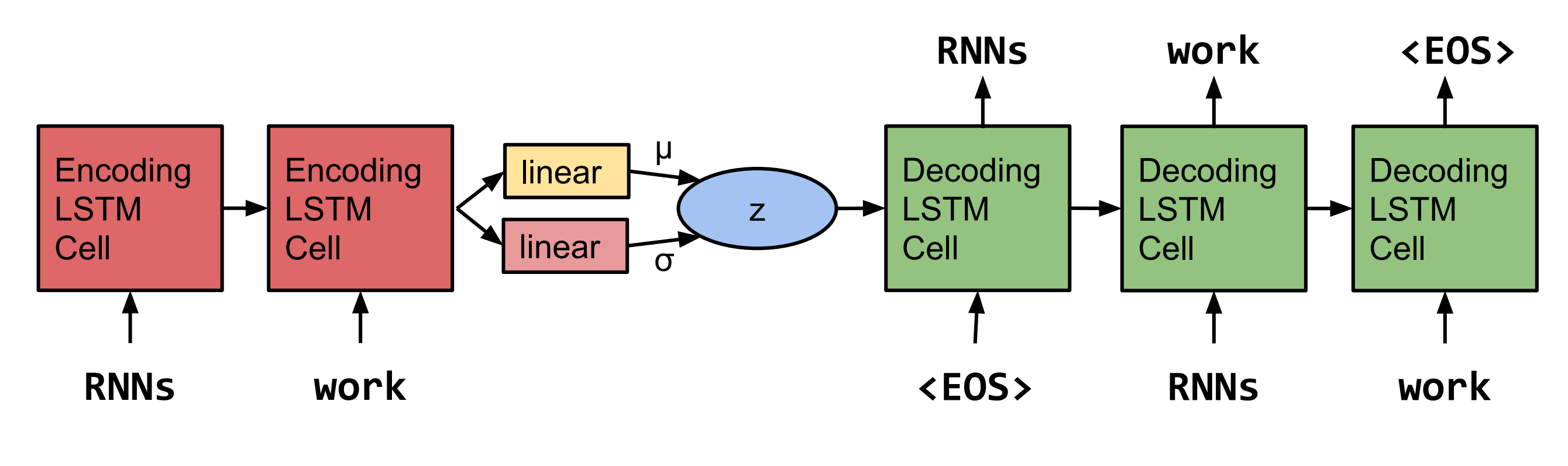

Bowman等人的Pytorch重新實現了從連續空間產生句子的成就。 2015。  注意:此實現目前不支持LSTM,而是RNN和GRU的。

注意:此實現目前不支持LSTM,而是RNN和GRU的。

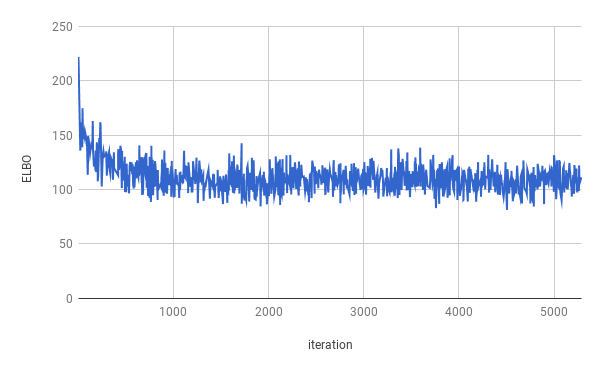

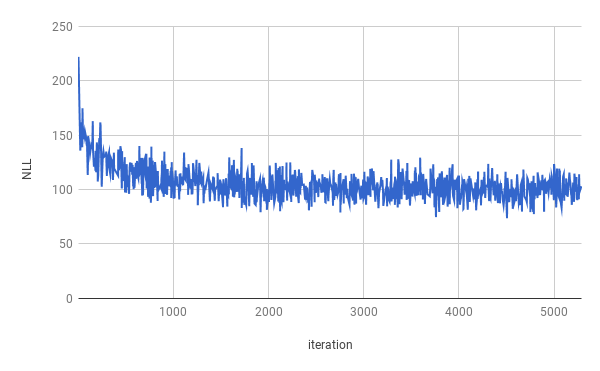

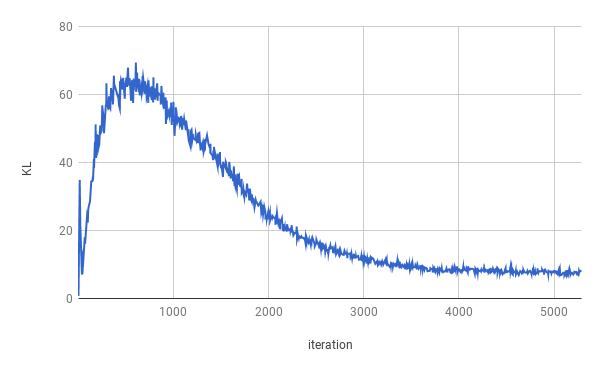

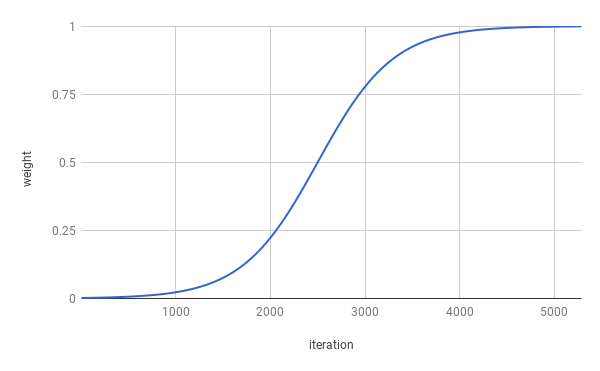

4個時代後停止了訓練。 True Elbo已針對大約1個時代進行了優化(如上圖所示,可以參見上圖)。結果在整個拆分中平均。

| 分裂 | nll | KL |

|---|---|---|

| 火車 | 99.821 | 7.944 |

| 驗證 | 103.220 | 7.346 |

| 測試 | 103.967 | 7.269 |

從Z〜N(0,i)採樣後獲得了哨兵。

先生 。 n與自己的員工和Nnnnn不是N

在u的n的n中。 s。公司不可能發表評論

當他們在n中n時,然後他們是南安(Nann)

但是該公司表示,到NN和NN結束時將是N

但是該公司表示將是U的NN。 s。經濟

從z〜n(0,i)採樣兩次並插值兩個樣品後,已獲得了哨兵。

該公司表示,除了公司外,它將是n

但是該公司表示,除了公司發行股份以外,這將是n

但是該公司表示該公司的SNN和NN

但是該公司在過去兩年前的SNN

但是該公司在過去兩年前的SNN

但是在過去的幾年前,該公司的SNN

但是在過去的幾年前,他們沒有被披露

但是在過去的幾年前,他們沒有被披露

但是在一份聲明中,他們不知道過去幾週的$ n百萬美元

但是在過去幾週結束時沒有付款的聲明中

要運行培訓,請先下載Penn Tree Bank數據(從Tomas Mikolov的網頁下載)。該代碼期望在指定的數據目錄中至少找到ptb.train.txt和ptb.valid.txt 。數據也可以使用dowloaddata.sh腳本進行。

然後可以使用以下命令執行培訓:

python3 train.py

以下參數可用:

--data_dir將存儲PTB數據的目錄的路徑,並將存儲輔助數據文件。

--create_data如果提供,將創建新的輔助數據文件,形成源數據。

--max_sequence_length指定切斷長句子的切斷。

--min_occ如果一個單詞的出現小於語料庫中的“ min_occ”時間,則將被令牌代替。

--test如果提供,則還將在測試集上測量性能。

-ep , --epochs

-bs , --batch_size

-lr , --learning_rate

-eb , --embedding_size

-rnn , --rnn_type “ rnn'或'gru'。

-hs , --hidden_size

-nl , --num_layers

-bi , --bidirectional

-ls , --latent_size

-wd , --word_dropout Word摘要應用於<unk>器的輸入,這意味著單詞將被word_dropout的概率替換為。

-ed , --embedding_dropout Word嵌入液位應用於解碼器的輸入。

-af , --anneal_function “ logistic”或“ lineare”。

-k , --k邏輯退火功能的陡度。

-x0 , --x0用於“ logistic”,這是中點(即重量為0.5時);對於“線性”,這是分母。

-v , --print_every

-tb , --tensorboard_logging如果提供,則用張板監視培訓進度。

-log , --logdir目錄的張量板的日誌文件。

-bin , --save_model_path目錄在哪裡存儲模型檢查點。

為了獲得樣品和在發件人之間的插值,可以使用推理。 py。

python3 inference.py -c $CHECKPOINT -n $NUM_SAMPLES