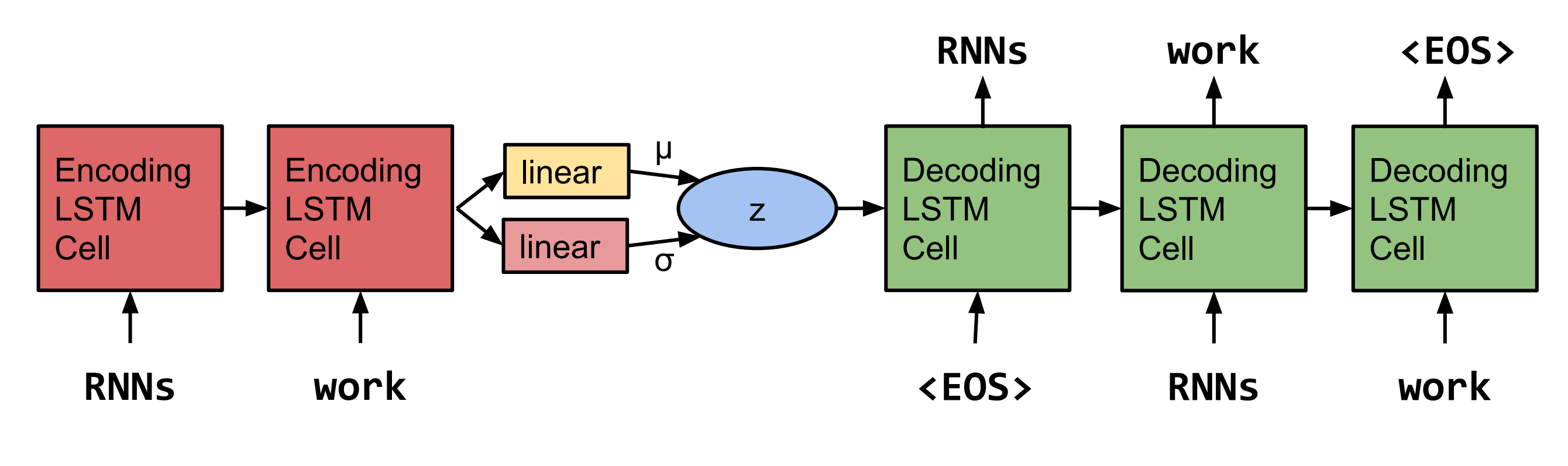

Réimplémentation pytorch des phrases de génération à partir d'un espace continu par Bowman et al. 2015.  Remarque: Cette implémentation ne prend pas en charge les LSTM en ce moment, mais les RNN et les GRU.

Remarque: Cette implémentation ne prend pas en charge les LSTM en ce moment, mais les RNN et les GRU.

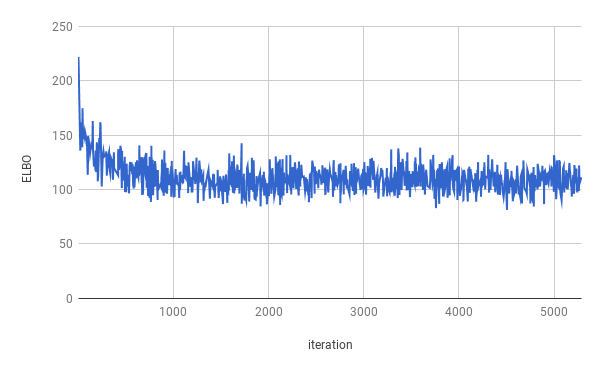

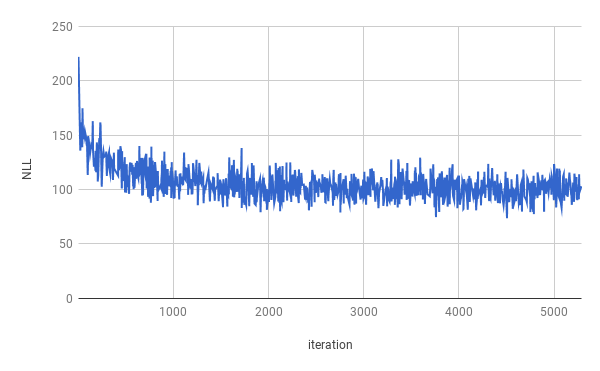

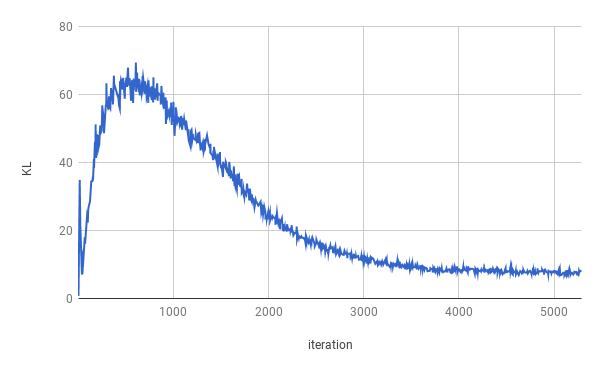

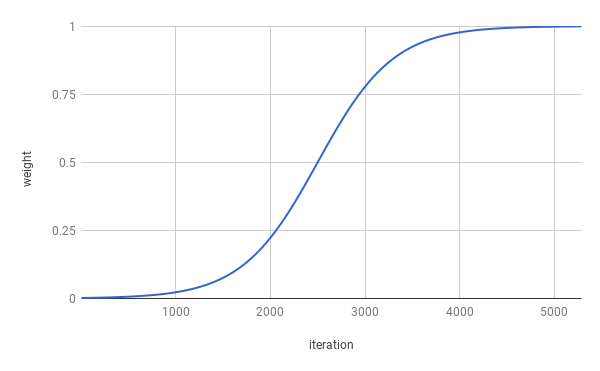

La formation a été arrêtée après 4 époques. Le véritable Elbo a été optimisé pour environ 1 époque (comme on peut le voir dans le graphique ci-dessus). Les résultats sont moyennés sur toute la scission.

| Diviser | Nll | Kl |

|---|---|---|

| Former | 99.821 | 7.944 |

| Validation | 103.220 | 7.346 |

| Test | 103.967 | 7.269 |

Des sentes ont été obtenues après échantillonnage de z ~ n (0, i).

M . N qui n'était pas avec son propre personnel et le nnnnn

dans le n du n du u. s. Les entreprises ne sont pas susceptibles d'être contactées pour commenter

Quand ils étaient n dans le n et puis ils étaient nannaux

Mais la société a déclaré qu'elle serait n à la fin du NN et du NN

Mais la société a déclaré qu'elle serait nn de l'U. s. économie

Des sentes ont été obtenues après échantillonnage deux fois à partir de z ~ n (0, i) et l'interpolation des deux échantillons.

La société a déclaré qu'elle serait n à l'exception de l'entreprise

Mais la société a déclaré qu'elle serait à l'exception des actions de la société en circulation

Mais la société a déclaré que la société SNN et NN

Mais l'entreprise 'SNN au cours des deux dernières années

Mais l'entreprise 'SNN au cours des deux dernières années

Mais au cours des dernières années, la société «SNN

Mais au cours des dernières années, ils n'ont pas été divulgués

Mais au cours des dernières années, ils n'ont pas été divulgués

Mais dans un communiqué qu'ils n'étaient pas au courant des millions de dollars au cours des dernières semaines

Mais dans un communiqué qu'ils n'ont pas été payés d'ici la fin des dernières semaines

Pour exécuter la formation, veuillez d'abord télécharger les données de Penn Tree Bank (télécharger depuis la page Web de Tomas Mikolov). Le code prévoit de trouver au moins ptb.train.txt et ptb.valid.txt dans le répertoire de données spécifié. Les données peuvent également être téléchargées avec le script dowloaddata.sh .

Ensuite, la formation peut être exécutée avec la commande suivante:

python3 train.py

Les arguments suivants sont disponibles:

--data_dir Le chemin d'accès au répertoire où les données PTB sont stockées et les fichiers de données auxiliaires seront stockés.

--create_data Si prévu, de nouveaux fichiers de données auxiliaires seront créés pour former les données source.

--max_sequence_length spécifie la coupe de phrases longues.

--min_occ Si un mot se produit moins que "min_occ" dans le corpus, il sera remplacé par le jeton.

--test Si fourni, les performances seront également mesurées sur l'ensemble de tests.

-ep , --epochs

-bs , --batch_size

-lr , --learning_rate

-eb , --embedding_size

-rnn , --rnn_type soit 'rnn' ou 'gru'.

-hs , --hidden_size

-nl , --num_layers

-bi , --bidirectional

-ls , --latent_size

-wd , --word_dropout Word dropout applied to the input of the Decoder, which means words will be replaced by <unk> with a probability of word_dropout .

-ed , --embedding_dropout mot incorpore de dépôt appliqué à l'entrée du décodeur.

-af , --anneal_function soit «logistique» ou «linéaire».

-k , --k Kecheur de la fonction de recuit logistique.

-x0 , --x0 pour «logistique», c'est le point médian (c'est-à-dire lorsque le poids est de 0,5); Pour «linéaire», c'est le dénominateur.

-v , --print_every

-tb , --tensorboard_logging Si fourni, la progression de la formation est surveillée avec Tensorboard.

-log , --logdir répertoire-logdir des fichiers journaux pour Tensorboard.

-bin , --save_model_path Directory où stocker les points de contrôle du modèle.

Pour obtenir des échantillons et l'interpolation entre SENDES, INFERGE.PY peut être utilisé.

python3 inference.py -c $CHECKPOINT -n $NUM_SAMPLES