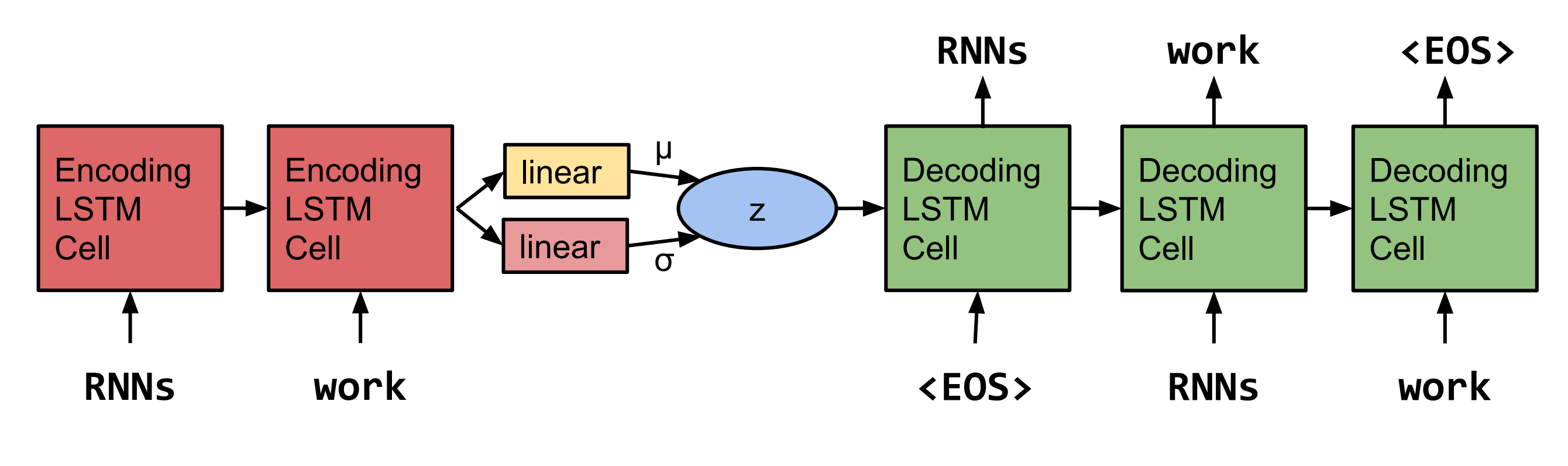

Pytorch-Neuauflagen von Sätzen aus einem kontinuierlichen Raum von Bowman et al. 2015.  Hinweis: Diese Implementierung unterstützt im Moment keine LSTMs, sondern RNNs und Gru's.

Hinweis: Diese Implementierung unterstützt im Moment keine LSTMs, sondern RNNs und Gru's.

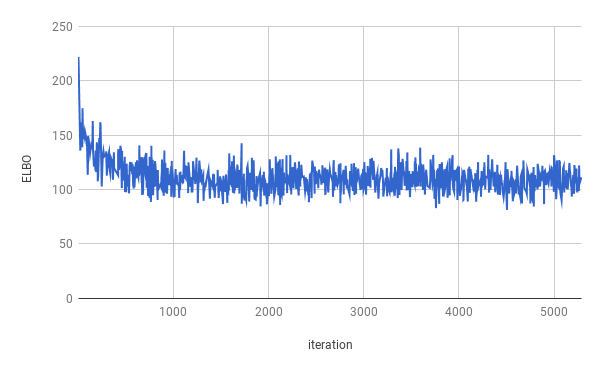

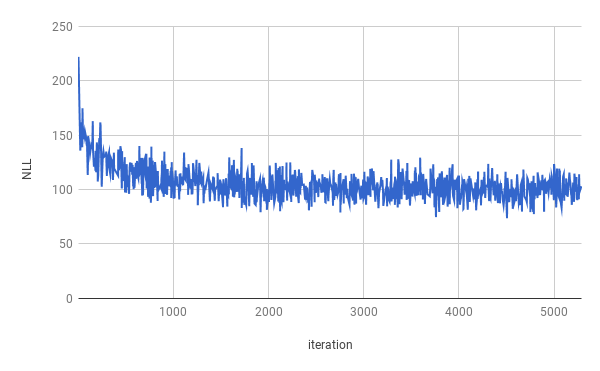

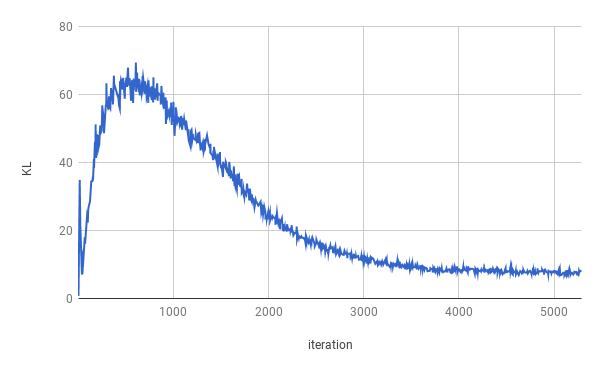

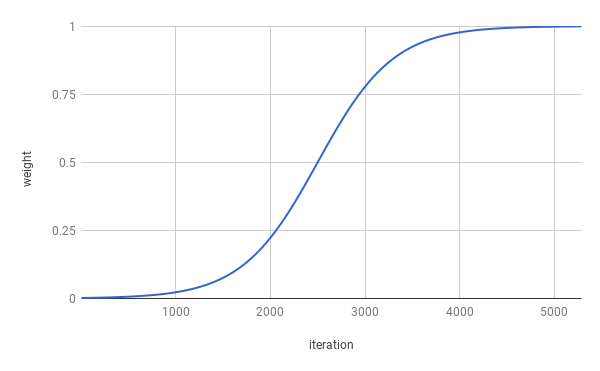

Das Training wurde nach 4 Epochen gestoppt. Das wahre Elbo wurde für ungefähr 1 Epoche optimiert (wie Biene in der obigen Grafik sehen kann). Die Ergebnisse werden über den gesamten Split gemittelt.

| Teilt | Nll | KL |

|---|---|---|

| Zug | 99,821 | 7.944 |

| Validierung | 103.220 | 7.346 |

| Prüfen | 103.967 | 7.269 |

Nach der Probenahme von z ~ n (0, i) wurden Sachen erhalten.

Herr . n, der nicht mit seinem eigenen Personal und dem nnnnn war

im n des n des u. S . Unternehmen werden wahrscheinlich nicht für einen Kommentar erreicht

Als sie N im N waren und dann waren sie Nann

Aber das Unternehmen sagte, es werde am Ende des NN und NN N sein

Aber das Unternehmen sagte, dass es nn der u sein wird. S . Wirtschaft

Sendern wurden nach zweimaler Probenahme von Z ~ n (0, I) und der Interpolation der beiden Proben erhalten.

Das Unternehmen sagte, es werde N mit Ausnahme des Unternehmens sein

Das Unternehmen sagte jedoch, es werde N mit Ausnahme der ausstehenden Aktien des Unternehmens sein

Aber das Unternehmen sagte, dass das Unternehmen 'SNN und NN'

Aber das Unternehmen 'SNN in den letzten zwei Jahren

Aber das Unternehmen 'SNN in den letzten zwei Jahren

aber vor einigen Jahren, dass das Unternehmen SNN 'SNN

Aber in den letzten Jahren wurden sie nicht bekannt gegeben

Aber in den letzten Jahren wurden sie nicht bekannt gegeben

Aber in einer Erklärung, dass sie sich der Nio. USD in den letzten Wochen nicht bewusst waren

aber in einer Erklärung, dass sie bis zum Ende der letzten Wochen nicht bezahlt wurden

Um das Training auszuführen, laden Sie bitte zuerst die Penn Tree Bank -Daten herunter (herunterladen von Tomas Mikolovs Webseite). Der Code erwartet im angegebenen Datenverzeichnis mindestens ptb.train.txt und ptb.valid.txt . Die Daten können auch mit dem Skript dowloaddata.sh -Skript nicht geführt werden.

Dann kann das Training mit dem folgenden Befehl ausgeführt werden:

python3 train.py

Die folgenden Argumente sind verfügbar:

--data_dir Der Pfad zum Verzeichnis, in dem PTB-Daten gespeichert werden, und Hilfsdatendateien werden gespeichert.

--create_data Wenn angegeben, werden neue Hilfsdatendateien erstellt, Formular mit den Quelldaten.

--max_sequence_length gibt den Abschnitt langer Sätze an.

--min_occ Wenn ein Wort weniger als "min_occ" im Korpus auftritt, wird es durch das Token ersetzt.

--test Sie bei der Bereitstellung der Tests bereitgestellt werden, wird die Leistung auch am Testsatz gemessen.

-ep , --epochs

-bs , --batch_size

-lr , --learning_rate

-eb , --embedding_size

-rnn , --rnn_type entweder 'rnn' oder 'Gru'.

-hs , --hidden_size

-nl , --num_layers

-bi , --bidirectional

-ls , --latent_size

-wd , --word_dropout Word dropout applied to the input of the Decoder, which means words will be replaced by <unk> with a probability of word_dropout .

-ed , --embedding_dropout word, um einen auf die Eingabe des Decoders angewendeten Dropouts einzubetten.

-af , --anneal_function entweder 'logistisch' oder 'linear'.

-k , --k der logistischen Annealing -Funktion.

-x0 , --x0 für 'logistic', dies ist der Mittelpunkt (dh wenn das Gewicht 0,5 beträgt); Für 'linear' ist dies der Nenner.

-v , --print_every

-tb , --tensorboard_logging Wenn erteilt wird, wird der Trainingsfortschritt mit Tensorboard überwacht.

-log , --logdir -Verzeichnis von Protokolldateien für Tensorboard.

-bin , --save_model_path -Verzeichnis, wo Modellkontrollpunkte gespeichert werden sollen.

Zum Erhalten von Proben und Interpolieren zwischen Senteces kann inference.py verwendet werden.

python3 inference.py -c $CHECKPOINT -n $NUM_SAMPLES