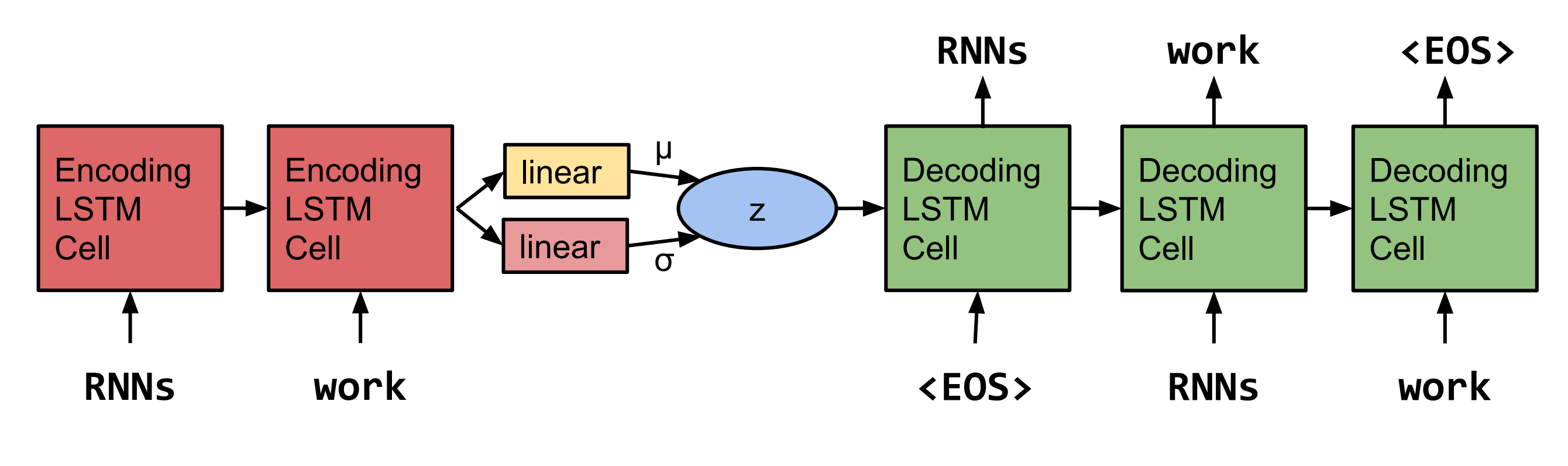

Pytorch reimplementación de generar oraciones desde un espacio continuo de Bowman et al. 2015.  Nota: Esta implementación no admite LSTM en este momento, sino de RNN y Gru.

Nota: Esta implementación no admite LSTM en este momento, sino de RNN y Gru.

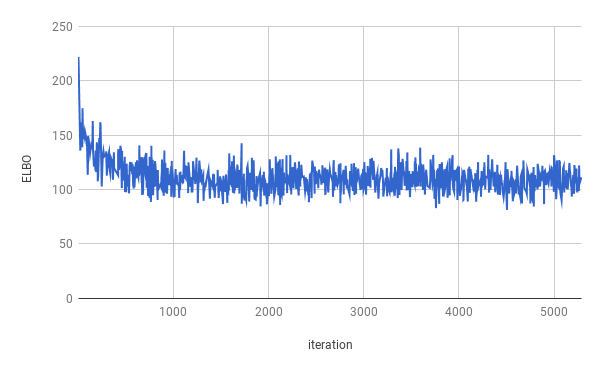

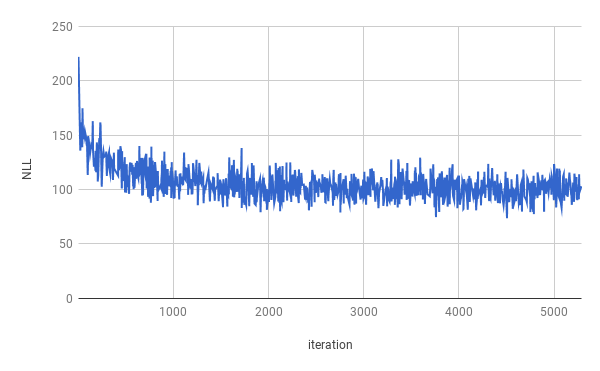

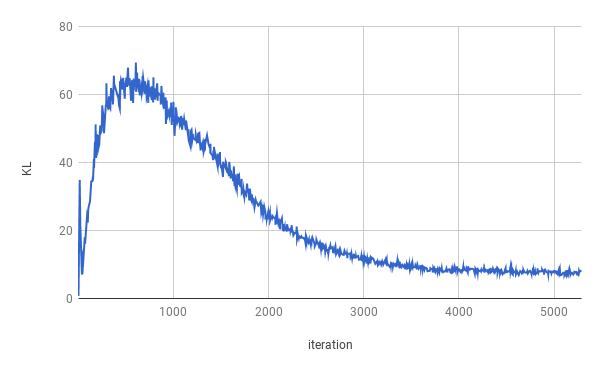

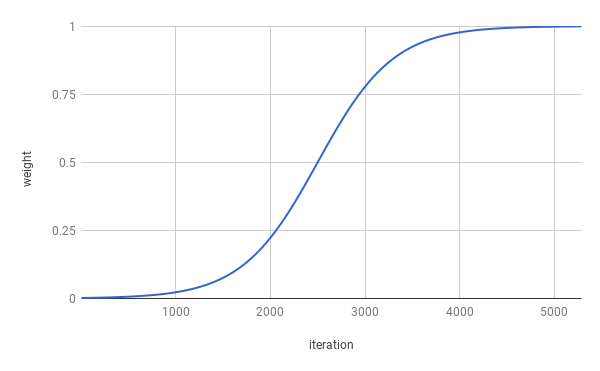

El entrenamiento se detuvo después de 4 épocas. El verdadero Elbo fue optimizado para aproximadamente 1 época (como se puede ver en el gráfico anterior). Los resultados se promedian durante toda la división.

| Dividir | NLL | KL |

|---|---|---|

| Tren | 99.821 | 7.944 |

| Validación | 103.220 | 7.346 |

| Prueba | 103.967 | 7.269 |

Se han obtenido los sentimientos después del muestreo de z ~ n (0, i).

señor . n que no estaba con su propio personal y el nnnnn

En la n de la n de la u. s . No es probable que las empresas sean contactadas para hacer comentarios

Cuando estaban en el n y luego eran nann

Pero la compañía dijo que será n al final de NN y NN

Pero la compañía dijo que será de la U. s . economía

Se han obtenido los sentenes después de muestrear dos veces de z ~ n (0, i) y la interpolación de las dos muestras.

La compañía dijo que será n con la excepción de la compañía.

Pero la compañía dijo que será n con la excepción de las acciones de la compañía en circulación

Pero la compañía dijo que la compañía 'SNN y NN

Pero la compañía 'Snn en los últimos dos años

Pero la compañía 'Snn en los últimos dos años

pero en los últimos años hace que la empresa snn

pero en los últimos años hace que no se les revelara

pero en los últimos años hace que no se les revelara

Pero en una declaración de que no estaban al tanto de los $ N millones en las últimas semanas

pero en una declaración de que no se les pagó al final de las últimas semanas

Para ejecutar la capacitación, descargue primero los datos de Penn Tree Bank (descargue desde la página web de Tomas Mikolov). El código espera encontrar al menos ptb.train.txt y ptb.valid.txt en el directorio de datos especificado. Los datos también se pueden descargar con el script dowloaddata.sh .

Entonces la capacitación se puede ejecutar con el siguiente comando:

python3 train.py

Los siguientes argumentos están disponibles:

--data_dir La ruta al directorio donde se almacenan los datos de PTB y se almacenarán los archivos de datos auxiliares.

--create_data Si se proporciona, se crearán nuevos archivos de datos auxiliares de los datos de origen.

--max_sequence_length Especifica el corte de oraciones largas.

--min_occ Si una palabra ocurre menos que las veces "min_Occ" en el corpus, será reemplazada por el token.

--test si se proporciona, el rendimiento también se medirá en el conjunto de pruebas.

-ep , --epochs

-bs , --batch_size

-lr , --learning_rate

-eb , --embedding_size

-rnn , --rnn_type , ya sea 'rnn' o 'gru'.

-hs , --hidden_size

-nl , --num_layers

-bi , --bidirectional

-ls , --latent_size

-wd , --word_dropout Word Deckout aplicado a la entrada del decodificador, lo que significa word_dropout <unk>

-ed , --embedding_dropout Word Insquitir la caída aplicada a la entrada del decodificador.

-af , --anneal_function ya sea 'logístico' o 'lineal'.

-k , --k inclinación de la función de recocido logístico.

-x0 , --x0 para 'logística', este es el punto medio (es decir, cuando el peso es 0.5); Para 'lineal' este es el denominador.

-v , --print_every

-tb , --tensorboard_logging Si se proporciona, el progreso de la capacitación se monitorea con TensorBoard.

-log , --logdir Directorio de archivos de registro para TensorBoard.

-bin , --save_model_path Directorio donde almacenar puntos de control del modelo.

Para obtener muestras e interpolar entre Senteces, se puede usar Inferencias Inferencias.

python3 inference.py -c $CHECKPOINT -n $NUM_SAMPLES