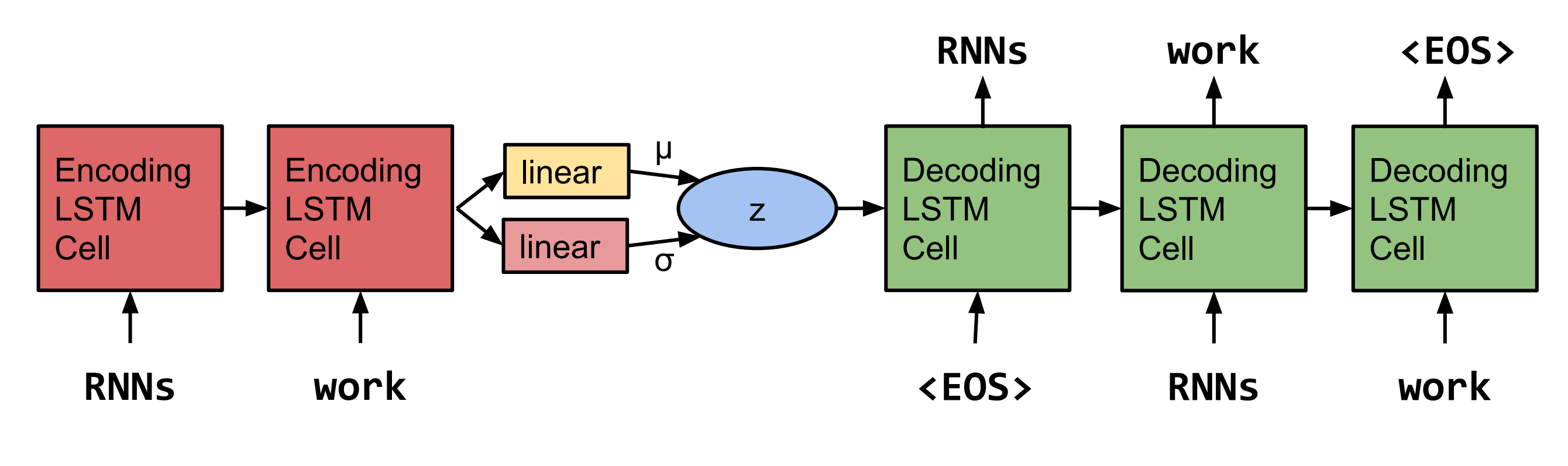

Pytorch mengimplementasikan ulang kalimat dari ruang kontinu oleh Bowman et al. 2015.  Catatan: Implementasi ini tidak mendukung LSTM saat ini, tetapi RNN dan Gru.

Catatan: Implementasi ini tidak mendukung LSTM saat ini, tetapi RNN dan Gru.

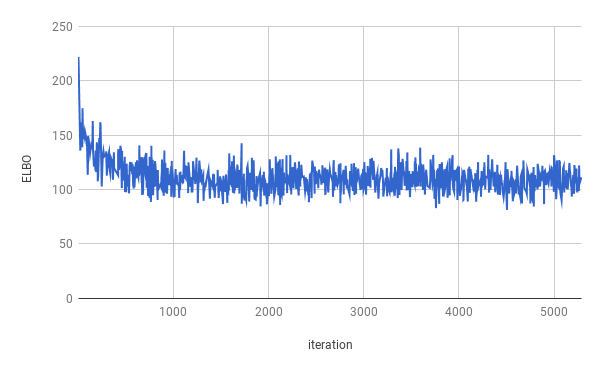

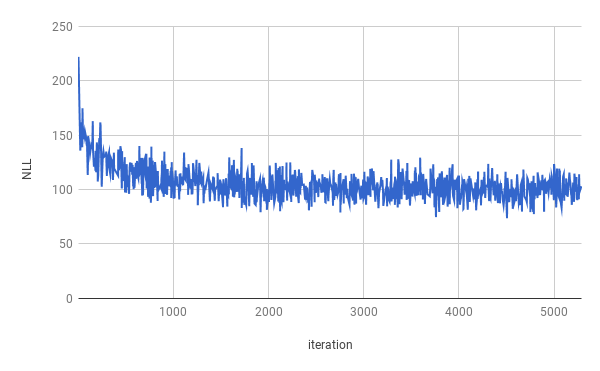

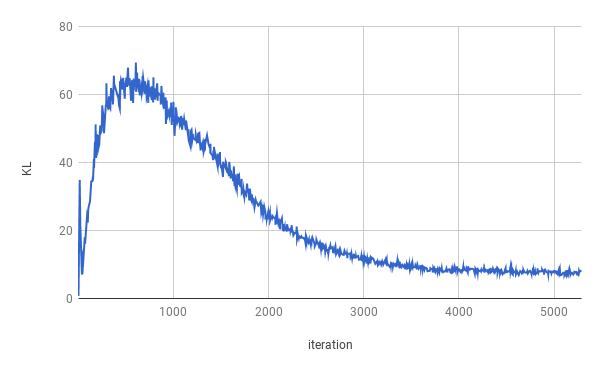

Pelatihan dihentikan setelah 4 zaman. Elbo sejati dioptimalkan untuk sekitar 1 zaman (seperti yang bisa dilihat lebah dalam grafik di atas). Hasil dirata -rata di seluruh perpecahan.

| Membelah | Nll | KL |

|---|---|---|

| Kereta | 99.821 | 7.944 |

| Validasi | 103.220 | 7.346 |

| Tes | 103.967 | 7.269 |

Sentena telah diperoleh setelah pengambilan sampel dari z ~ n (0, i).

Tn . n yang tidak dengan stafnya sendiri dan nnnnn

di N dari n u. S . Perusahaan tidak mungkin dihubungi untuk memberikan komentar

Ketika mereka berada di N dan kemudian mereka adalah Nann

Namun perusahaan mengatakan itu akan menjadi N pada akhir NN dan NN

Tetapi perusahaan mengatakan bahwa itu akan menjadi NN dari U. S . ekonomi

Sentena telah diperoleh setelah pengambilan sampel dua kali dari z ~ n (0, i) dan interpolasi kedua sampel.

Perusahaan mengatakan itu akan dikecuali dengan pengecualian perusahaan

Tetapi perusahaan mengatakan itu akan menjadi pengecualian dari saham perusahaan yang beredar

Tetapi perusahaan mengatakan bahwa perusahaan 'snn dan nn

Tapi perusahaan 'Snn dalam dua tahun lalu

Tapi perusahaan 'Snn dalam dua tahun lalu

Tapi dalam beberapa tahun lalu yang lalu perusahaan 'Snn

tetapi dalam beberapa tahun terakhir yang lalu bahwa mereka tidak diungkapkan

tetapi dalam beberapa tahun terakhir yang lalu bahwa mereka tidak diungkapkan

Tetapi dalam sebuah pernyataan bahwa mereka tidak mengetahui $ n juta dalam beberapa minggu terakhir

tetapi dalam sebuah pernyataan bahwa mereka tidak dibayar pada akhir beberapa minggu terakhir

Untuk menjalankan pelatihan, silakan unduh Data Bank Tree terlebih dahulu (unduh dari halaman web Tomas Mikolov). Kode mengharapkan untuk menemukan setidaknya ptb.train.txt dan ptb.valid.txt di direktori data yang ditentukan. Data juga dapat dikerjakan dengan skrip dowloaddata.sh .

Kemudian pelatihan dapat dieksekusi dengan perintah berikut:

python3 train.py

Argumen berikut tersedia:

--data_dir Path ke direktori tempat data PTB disimpan, dan file data tambahan akan disimpan.

--create_data jika disediakan, file data tambahan baru akan dibuat membentuk data sumber.

--max_sequence_length Menentukan pemotongan kalimat panjang.

--min_occ Jika sebuah kata terjadi kurang dari "min_occ" dalam korpus, itu akan digantikan oleh token.

--test jika disediakan, kinerja juga akan diukur pada set tes.

-ep , --epochs

-bs , --batch_size

-lr , --learning_rate

-eb , --embedding_size

-rnn , --rnn_type baik 'rnn' atau 'gru'.

-hs , --hidden_size

-nl , --num_layers

-bi , --bidirectional

-ls , --latent_size

-wd , --word_dropout Word Dropout diterapkan pada input decoder, yang berarti kata -kata akan digantikan oleh <unk> dengan probabilitas word_dropout .

-ed , --embedding_dropout Word Evedding Dropout diterapkan pada input decoder.

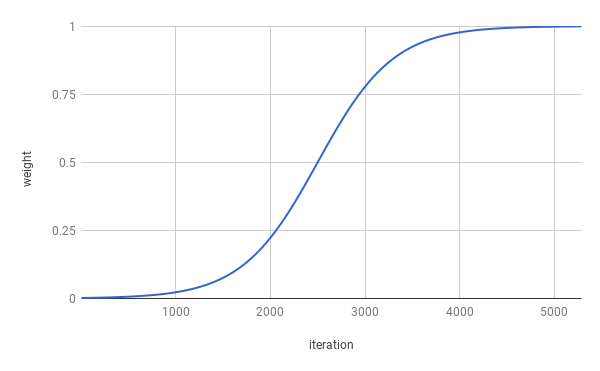

-af , --anneal_function baik 'logistik' atau 'linier'.

-k , --k FUNGSI LOGISTIK OLANG LOGISTIK.

-x0 , --x0 untuk 'logistik', ini adalah titik tengah (yaitu saat beratnya 0,5); Untuk 'linear' ini adalah penyebut.

-v , --print_every

-tb , --tensorboard_logging jika disediakan, kemajuan pelatihan dipantau dengan Tensorboard.

-log , -Direktori --logdir file log untuk Tensorboard.

-bin , --save_model_path Directory di mana untuk menyimpan pos pemeriksaan model.

Untuk mendapatkan sampel dan interpolasi antar senja, inferensi.py dapat digunakan.

python3 inference.py -c $CHECKPOINT -n $NUM_SAMPLES